使用深度特征进行自适应跟踪时的学习策略

原论文:Huang, Chen, S. Lucey, and D. Ramanan. "Learning Policies for Adaptive Tracking with Deep Feature Cascades." ICCV (2017). 点击文章末尾“原文链接”获取原论文。

1.摘要

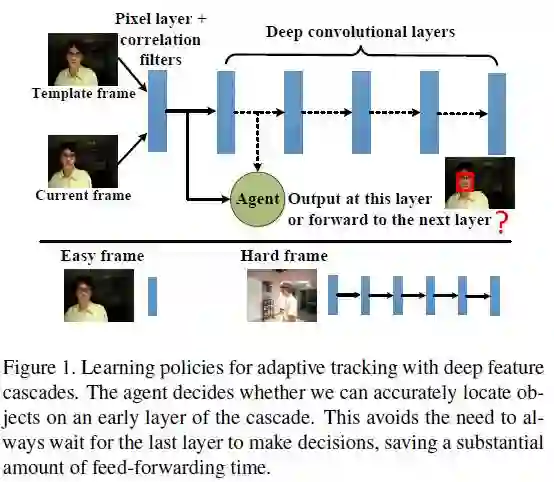

视觉目标跟踪是一个基本并且对时间要求苛刻的视觉任务。近几天提出的很多方法要么是利用浅层特征基于KCF的高速方法,要么是需要高性能GPU的利用深度特征的方法。本文就提出了一种不损失精度的同时提高跟踪速度的方法。本文的重点是提出一个自适应的方法,利用这个自适应的方法,处理简单的帧时利用简单特征(如像素值),处理富有挑战性的帧时使用深度特征。这个自适应问题其实就是一个决策问题,即让学习出来的agent决定:目前是已经可以以较高的置信度定位目标,还是仍需继续计算神经网络接下来各个层的特征来进一步寻找目标位置?使用了本文方法后,跟踪的速度快了、开销少了、精度还没大损失。agent是用离线的强化学习方法学习到的。基本上,50%的时间里本文方法的速度都是比一般方法快了100多倍。

2.引入

视觉目标跟踪是视觉领域里一个基本问题。虽说跟踪方法最近取得了巨大的进步,但是仍然存在一个鱼和熊掌不可兼得的矛盾。那就是设计一个兼顾精度和速度的跟踪器仍然是一个有巨大挑战的问题。像TLD和相关滤波这种低层特征的实时跟踪方法,遇到复杂背景和模糊目标时描述能力就显得不足。其他的方法在提升相关滤波的精度时都以降低跟踪速度为代价。目前来讲,即使使用最高端的GPU,这类跟踪器的速度基本也都是1 fps。

有两个最近提出的深度跟踪器(L. Bertinetto, J. Valmadre, J. F. Henriques, A. Vedaldi, and P. H. S. Torr. Fully-convolutional siamese networks for object tracking. In ECCV, 2016和D. Held, S. Thrun, and S. Savarese. Learning to track at 100 fps with deep regression networks. In ECCV, 2016.)利用GPU大大提高了速度。然而,在使用现代cpu,或者智能手机上面处理这样的运算时,运算速度仍然是每秒几帧,远远低于一般的视频帧率30fps。

本文提出既提高跟踪精度又提高深度跟踪速度的自适应方法建立在一个基本观察上,那就是跟踪任务的复杂度随着视频帧的不同而不同。也就是说,对于复杂的目标和背景,我们可以使用神经网络的最后一层来确定目标位置,但是对于那些简单的背景,甚至几乎目标没有变化的帧,我们用浅层特征就已经足够定位目标。更极端的情况下,我们甚至只使用第0层特征,也就是图片原始像素就足够确定目标了。

这样一个自适应策略基本上就是一个决策问题:使用当前层的特征就已经够了?还是得继续计算目标在神经网络里的下一层的特征?我们通过强化学习的方法,学习到这么一个agent来帮助我们完成这样的决策。注意,这和一般的基于特征层选择的方法是完全不同的,因为一般的特征选择方法是在神经网络的传递全部结束之后才开始选择自己要使用的特征。而本文的方法是一个即时的过程,假如神经网络的传递还未结束时,已经可以定位目标的位置,那么本文方法会提前停止(early stopping)神经网络的传递。这也是本文方法名字的由来“EArly-Stopping Tracker(EAST)”这样的agent是用深度增强学习方法在训练阶段学习到的,在测试阶段直接使用。

3.本文方法

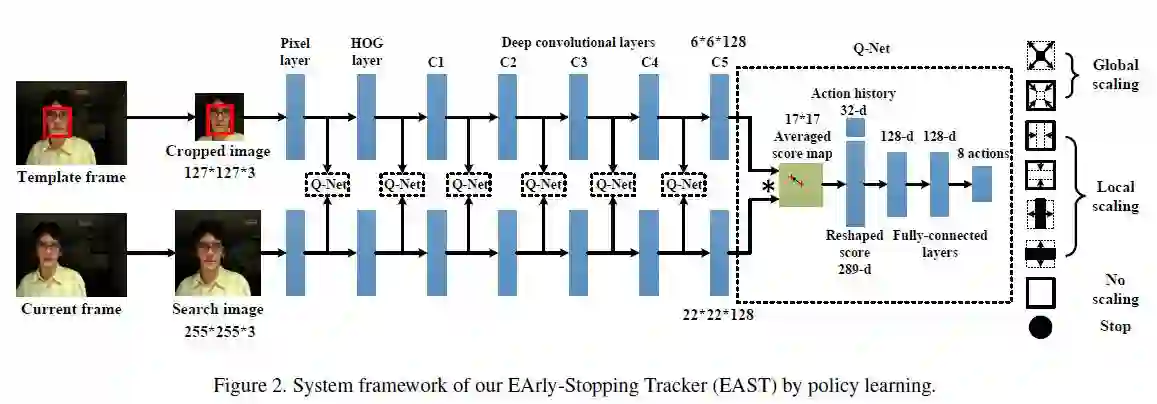

本文方法框架如下,由一个双胞胎网络和一个Q-net网络(即通过深度增强学习学习到的Q函数)组成。

3.1双胞胎网络

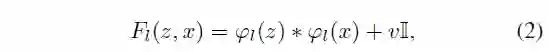

首先回顾一下双胞胎网络。双胞胎网络是离线训练的,用来在255*255的图片x中定位127*127的模板图片z。一个相似度函数用来比较模板z和图片x中的候选区域,最后得出一张得分图,是目标的区域得分高,不是目标的区域得分低。具体来讲,本文用下面的方法来作为相似度评估函数:

本文的方法,就是在双胞胎网络的基础上, 学习一个提前停止的策略,既能定位目标位置,又不需要计算完5个特征层。

3.2使用增强学习的学习策略

本文使用增强学习,学习出一个agent,让它来告诉我们是停是继续。

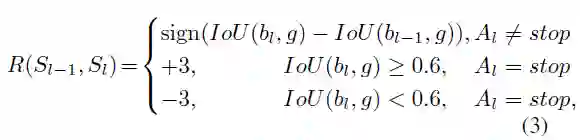

我们用A表示agent要采取的行动(actions),7个目标框变化形式,以及一个“停止”动作。7个变化如下,一目了然。

状态集由

奖励函数由下面公式确定

增强学习方法具体使用deep q-learning方法(Human-level control through deep reinforcement learning. Nature,518(7540):529–533, 2015)来学习到一个行动值函数

4.实验

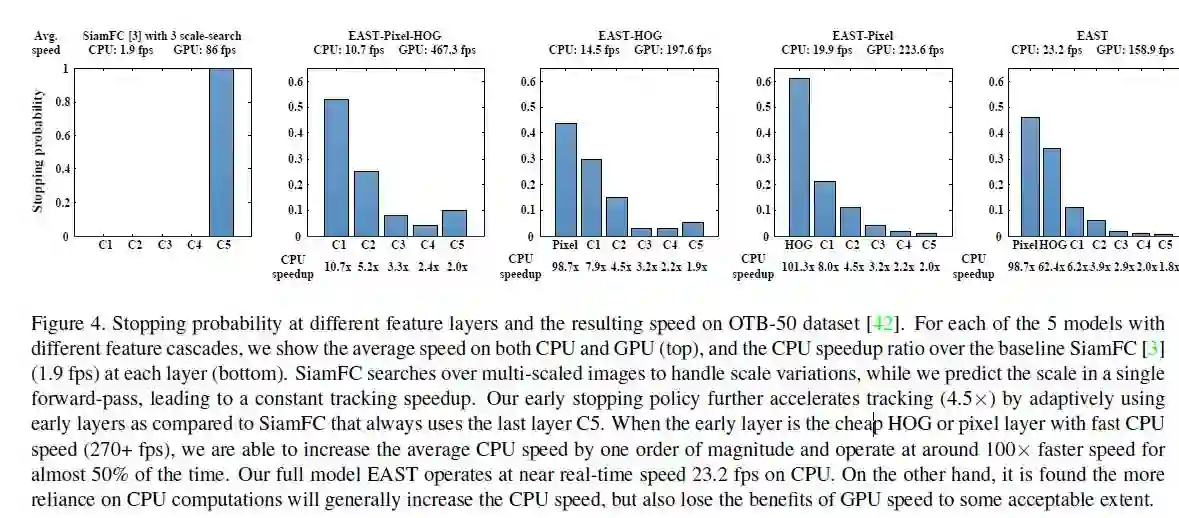

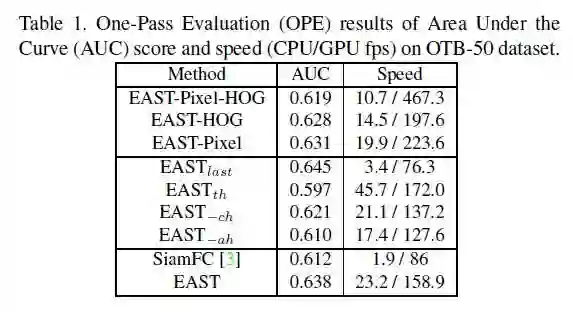

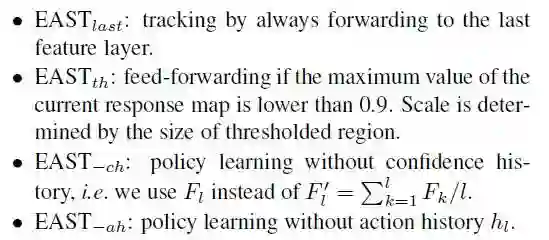

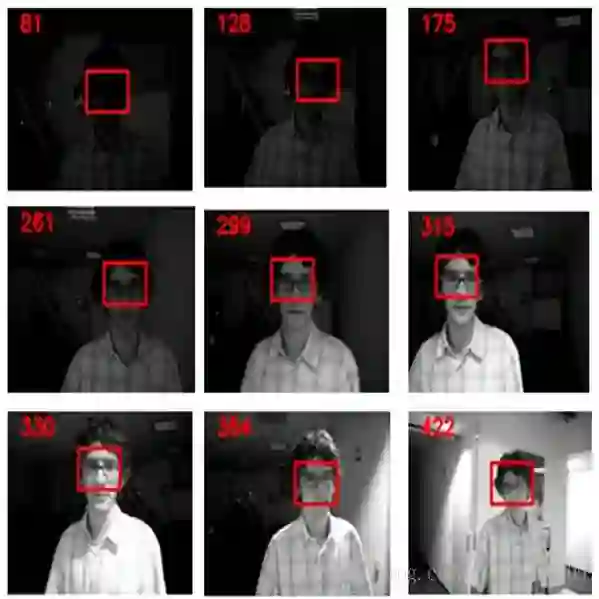

作者首先和自身变体做了一些对比,有EAST-Pixel-HOG(就是EAST减去pixe特征和HOG特征,以下同理), EAST-HOG,EAST-Pixel, SiamFC。 下图显示了本文方法停止到各个层的统计

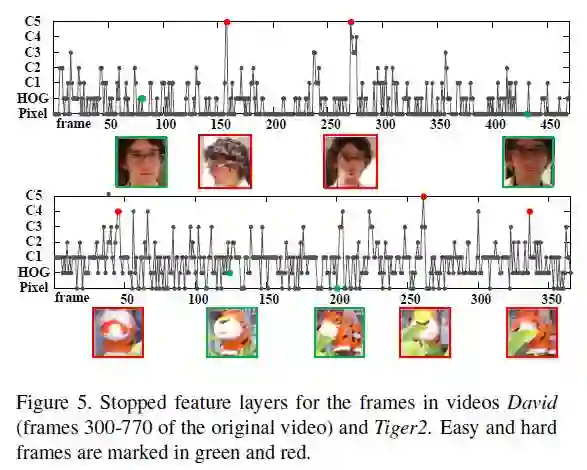

可以发现,EAST方法中70%的情况下都是提前停止。下图显示了具体的每一帧的停止位置

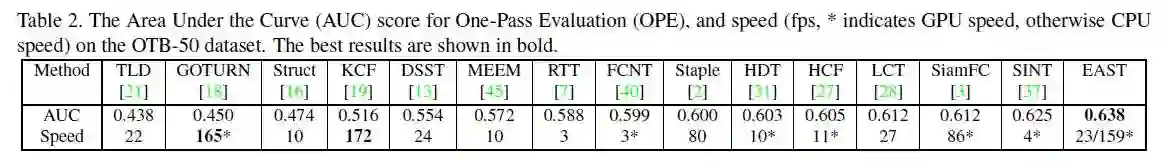

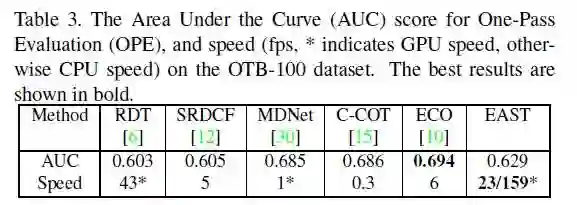

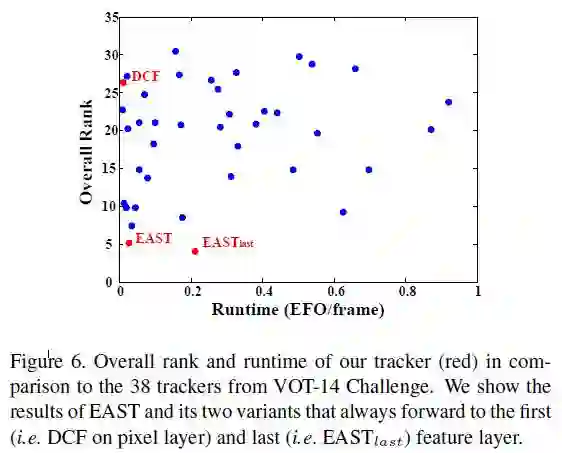

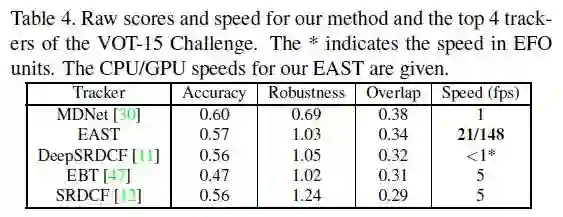

接下来是在标准数据集OTB-50,OTB-100,VOT-14,VOT-15上和其他算法的对比结果。