神经网络的损失函数为什么是非凸的?

加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

作者:覃含章

https://www.zhihu.com/question/265516791/answer/769005628

来源:知乎,已获作者授权转载,禁止二次转载。

简单说下这个问题吧。

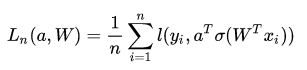

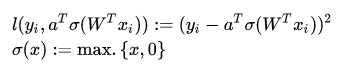

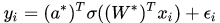

考虑最简单的一类神经网络,只有一个隐层、和输入输出层的网络。也就是说给定

注意到虽然像取平方,ReLU激活函数

怎么判断一个优化问题是凸优化还是非凸优化?

(文章链接:https://www.zhihu.com/question/334515180/answer/748981244)

为了方便说明

一个(高维)函数是凸的,当且仅当把这个函数限制到任意直线上它在定义域上仍然是凸的。这是凸分析里很基本的一个定理,不熟悉的同学不妨尝试用定义来证明它。

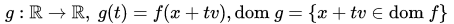

更正式的来说,

引理:

反过来也就是说,只要我们找到一点

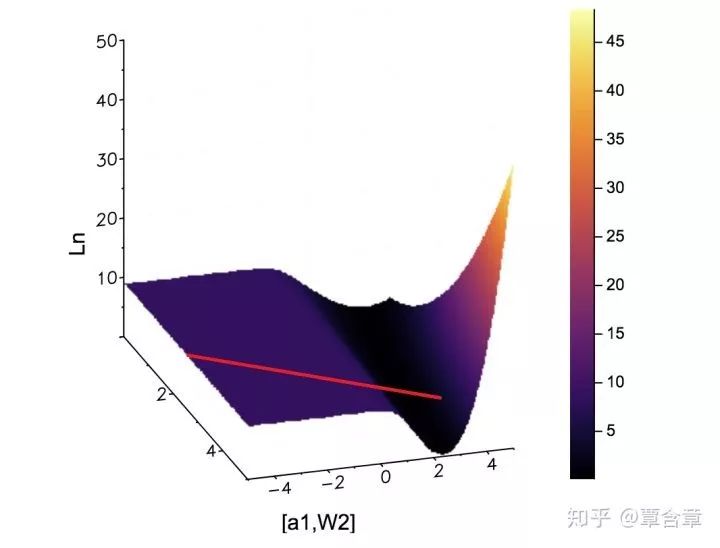

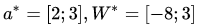

最后就是轻松愉快的画图举反例环节。这边为了说明方便,取参数空间为四维的

这里我们取真实的

是[0,0.5]的均匀随机数(这样图像看起来会比较规整)。我们固定住

如上红线,我们可以很轻松的找到一条使

这个本质上就是 @陈泰红 (https://www.zhihu.com/people/chenhong007/activities)答案中提到Goodfellow在Quora说的思路:“plot a cross-section of the function and look at it”,而它的正确性就是这边的引理所保证的。注意到这边如果你要用求导大法是不太容易的,因为隐层套的是ReLU激活函数,只能求次微分,看起来会稍微麻烦一些。

-End-

*延伸阅读

添加极市小助手微信(ID : cv-mart),备注:研究方向-姓名-学校/公司-城市(如:目标检测-小极-北大-深圳),即可申请加入目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、图像分割等极市技术交流群,更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

△长按添加极市小助手

△长按关注极市平台

觉得有用麻烦给个在看啦~