论文浅尝 | 用于视觉推理的显式知识集成

论文笔记整理:刘克欣,天津大学硕士

链接:https://openaccess.thecvf.com/content/CVPR2021/papers/Zhang_Explicit_Knowledge_Incorporation_for_Visual_Reasoning_CVPR_2021_paper.pdf

动机

现有的可解释的和显式的视觉推理方法仅执行基于视觉证据的推理,而不考虑视觉场景之外的知识。为了解决视觉推理方法和真实世界图像语义复杂性之间的知识鸿沟,文章提出了第一个显式视觉推理方法,该方法结合了外部知识并对高阶关系注意进行建模,以提高视觉推理的泛化性和可解释性。

亮点

文章的亮点主要包括:

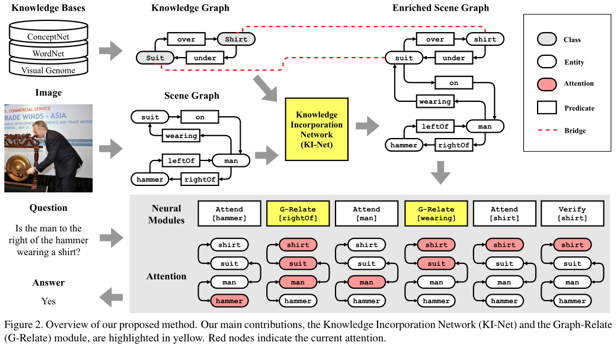

1.首次提出利用外部知识和神经模块来实现可泛化性和可解释性的显示视觉推理模型;2.设计了一个新颖的知识集成网络(Knowledge Incorporation Network, KINet),将外部知识作为额外的节点和边显式地集成到场景图中,为推理提供丰富的语义;3.设计了一个基于场景图拓扑和语义实现高阶关系关注的图相关(Graph-Relate)模块。

概念及模型

文章提出的方法利用场景图、外部知识和神经模块这三部分实现可解释的、显式视觉推理。首先通过显式地结合外部知识来创建丰富的场景图,然后执行由问题生成的神经模块程序。

文章的方法主要包括两部分:

•知识集成网络(Knowledge Incorporation Network , KI-Net):将外部知识图中的实体和谓词显式地合并到场景图中。•图关联(Graph-Relate, G-Relate)模块:基于强化的场景图学习高阶知识。

模型整体框架如下:

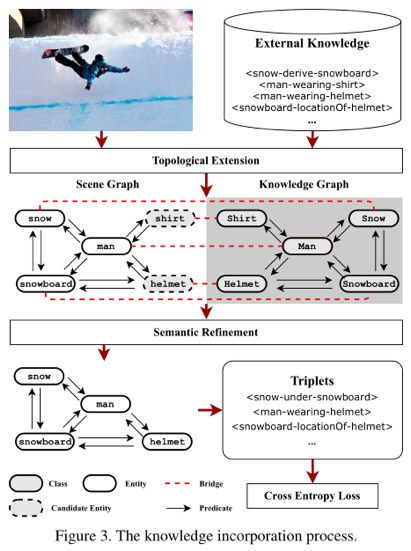

•知识集成网络

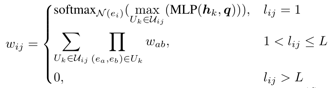

知识集成网络将外部知识作为节点引入场景图中:首先,基于外部知识图的拓扑,执行拓扑扩展(topological extension),以将外部关系合并到场景图中(例如,上图中,通过显式地在场景图中添加shirt和helmet节点,增加了man-wearing-shirt和man-wearing-helmet)。然后,考虑视觉和语义特征,执行语义细化(semantic refinement)以选择性地丢弃与视觉相关性低的候选实体(例如上图中的shirt)。知识集成网络产生一个增强的场景图,允许神经模块对集成的语义进行显式推理。它由使用交叉熵损失的基本真实场景图注释来监督。拓扑扩展时,首先利用场景图和知识图谱中语义相同的节点e,在两个图谱之间搭建桥梁。用d(., .)表示两个节点之间的关系,则知识图谱中与节点e相邻的节点e’和边p’如果满足下式,就会被添加到场景图中:

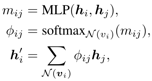

语义细化时,文章计算一个相关性矩阵M来衡量不同实体之间的特征相关性。M中的元素mij的更新方式如下:

其中,hi和hj是图谱中两个相邻节点vi和vj的特征,N(vi)表示vi的邻域。

•神经模块推理

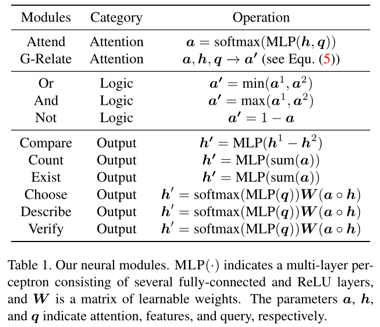

神经推理模块引入图关联(G-Relate)模块,通过计算非相邻图节点的注意力获取高阶关系。作者设计了三种类型的神经网络:注意力(attention)、逻辑(logic)和输出(output)。注意力在推理过程中计算不同图像内容(例如,图像特征或场景图节点)的相对重要性。基于注意模块,逻辑模块(也就是,And,Or和Not)基于注意权重执行逻辑操作,输出模块(也就是,Compare,Count,Exist,Choose,Describe和Verify)根据不同的问题类型计算输出特征。特定的神经模块及其实现如下表所示。

这三类神经模块组成一个程序,对丰富的场景图进行推理。

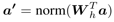

其中的G-Relate模块可以在强化的场景图上推断高阶关系,因此注意可以通过关联路径被转换以到达远距离实体。给定注意a,G-Relate模块计算转换矩阵Wh以在场景图中传播注意。通过转换矩阵,图注意的更新方式为:

其中norm(.)表示使用softmax函数对所有实体节点的注意权重进行规范化。实体ei和实体ej之间的转换权重wij的计算方式如下:

理论分析

实验

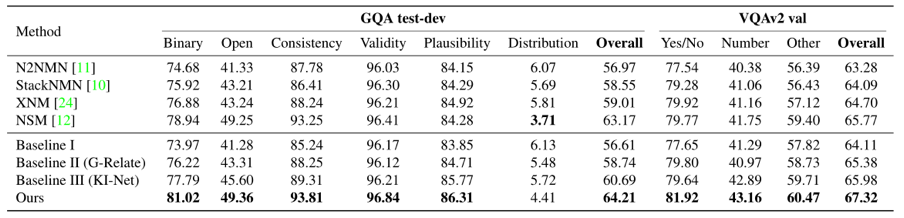

作者采用了2个公开数据集进行实验,分别是:GQA和VQAv2。首先是有效性实验,模型的评价指标为准确率。

文章所提的方法在GQA测试数据集上获得了64.21%的总体准确性,在VQAv2验证数据集上获得了67.32%的总体准确性,在两个数据集上都优于最先进的神经模块模型。

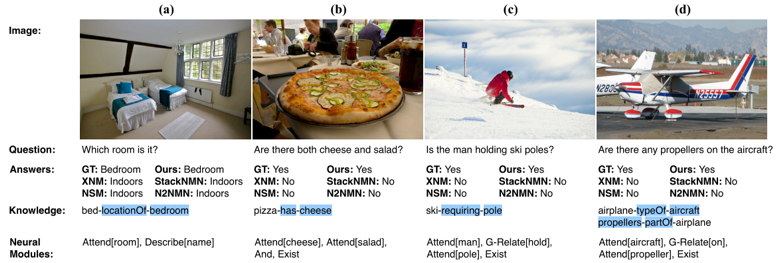

此外,文章中展示了定性实例以及帮助预测的从外部知识中集成的关键关系。在多源外部知识的帮助下,文章的方法对具有域外知识的问题更具普适性,对开放性问题(见下图a)和二元性问题(见下图b-d)的回答更具体、更正确。

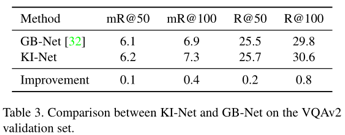

同时,作者在VQAv2验证数据集上将所提的KI-Net与最先进的场景图生成模型GB-Net进行了比较。

实验显示了相关实体和谓词的显式合并允许KI-Net在所有度量上生成更好的场景图。

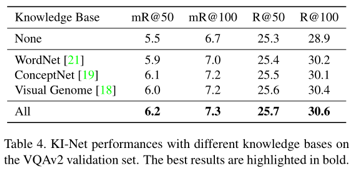

为了证明KI-Net在包含多个知识源以生成丰富场景图方面的能力,文章比较了WordNet、ConceptNet、Visual Genome或所有三者的组合的有效性。

实验表明,即使只有一个外部知识库,KI-Net也能显著提高场景图的质量。

总结

文章通过引入一种强调外部知识和高阶关系注意的显式集成的可解释和显式视觉推理方法来解决视觉推理的可概括性和可解释性。它由一个知识集成网络(KI-Net)和一个图关联(G-Relate)模块组成,知识集成网络显式地集成了新的实体和谓词来丰富场景图的语义,图关联(G-Relate)模块用来推断高阶关系。文章的方法可以回答关于真实世界图像的一般性问题,同时具有普遍性和可解释性。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。