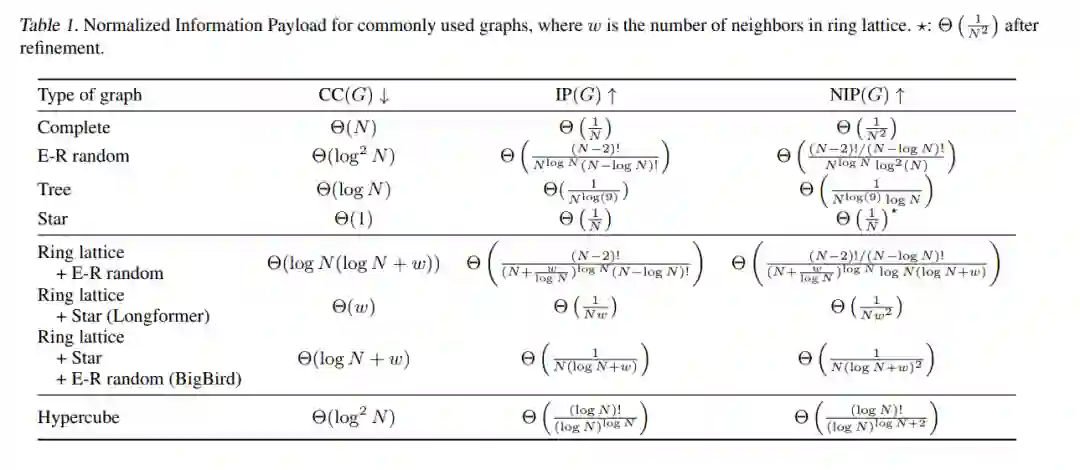

【ICML2022】超立方Transformers:你需要什么样的密集图来集中自注意力?

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“STRN” 就可以获取《【ICML2022】超立方Transformers:你需要什么样的密集图来集中自注意力?》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年7月28日

Arxiv

12+阅读 · 2021年12月30日

Arxiv

13+阅读 · 2021年4月7日