目标跟踪40年,什么才是未来?

点击上方“CVer”,选择加"星标"或“置顶”

重磅干货,第一时间送达

《中国图象图形学报》2019年第12期封面故事聚焦目标跟踪,对基于深度学习的目标跟踪算法进行系统的梳理。该成果是中国图象图形学学会机器视觉专委会牵头组织,浙江大学李玺教授、厦门大学王菡子教授等八位老师联名撰写的图像图形学科年度发展报告。

题目:深度学习的目标跟踪算法综述

作者:李玺, 查宇飞, 张天柱, 崔振, 左旺孟, 侯志强, 卢湖川, 王菡子.

关键词:视觉目标跟踪; 深度神经网络; 相关滤波器; 深度孪生网络; 强化学习; 生成对抗网络

引用格式:李玺, 查宇飞, 张天柱, 崔振, 左旺孟, 侯志强, 卢湖川, 王菡子. 2019. 深度学习的目标跟踪算法综述. 中国图象图形学报, 24(12): 2057-2080. [DOI: 10.11834/jig.190372]

http://www.cjig.cn/html/jig/2019/12/weixin/20191201.htm

该综述28页,160+参考文献,关注 CVer 微信公众号

后台回复:20200110,即可获得本综述的PDF

阐述了目标跟踪的基本研究框架,从深度判别模型、深度生成式模型等方面介绍了适用于目标跟踪的深度学习方法。

深入分析了网络结构、功能划分和网络训练等不同类别的深度目标跟踪方法。

简要阐述了适用于深度学习目标跟踪的视频数据库和评测方法。

介绍了目标跟踪的最新具体应用情况。

分析了深度学习方法在目标跟踪中存在的训练数据不足、实时跟踪和长程跟踪等问题。

对深度学习的目标跟踪方法的未来发展进行展望。

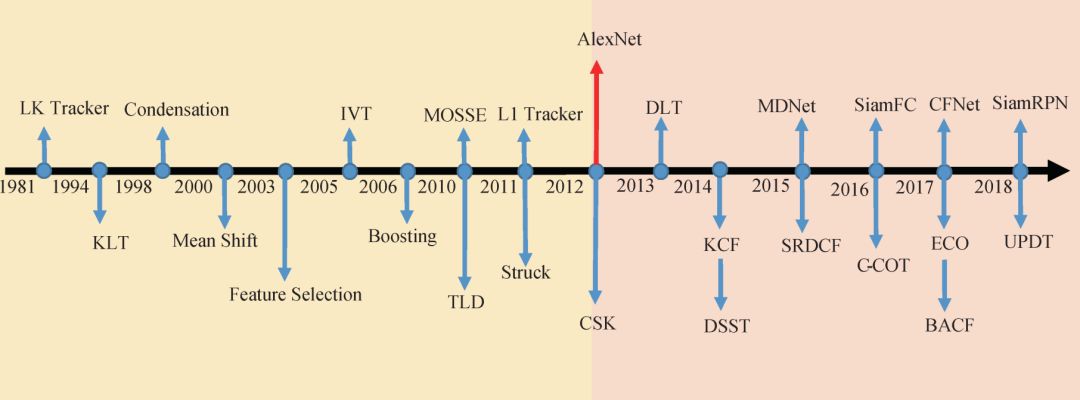

1981:LK Tracker[1]

假定目标灰度在短时间内保持不变,同时目标邻域内的速度向量场变化缓慢

KLT[2]

KLT(Kanade Lucas Tomasi tracking method)通过匹配角点实现对目标的跟踪

Condensation[3]

采用原始的外观作为主要特征来描述目标

Mean Shift[4]

均值漂移成为当时常用的视觉跟踪系统的搜索策略

Feature Selection[5]

利用线性判别分析自适应地选择对当前背景和目标最具鉴别性的颜色特征,从而分离出目标

IVT[6]

在线更新特征空间的基,直接将以前检测到的目标作为样本在线学习而无需大量的标注样本

Boosting[7]

结合Haar特征和在线Boosting算法对目标进行跟踪

TLD[8]

TLD(tracking learning detection)利用在线的Ferns检测目标,同时利用在线随机森林算法跟踪目标

L1 Tracker[9]

L1跟踪器把跟踪看做一个稀疏近似问题,通过求解L1范数最小化问题,实现对目标的跟踪

AlexNet[10]

以AlexNet网络为代表的深度学习方法在图像识别等领域获得了巨大成功,迅速被引入到目标跟踪领域中

CSK[11]

CSK(circulant structure of tracking by detection with kernels)算法,也称为核相关滤波算法,采用循环移位进行密集采样,并通过核函数将低维线性空间映射到高维空间,提高了相关滤波器的鲁棒性

DLT[12]

直接利用ImageNet数据上的预训练模型提取深度特征

DSST[13]

DSST(accurate scale estimation for robustvisual tracking)则将目标跟踪看成位置变化和尺度变化两个独立问题,首先训练位置平移相关滤波器以检测目标中心平移,然后训练尺度相关滤波器来检测目标的尺度变化

MDNet[14]

MDNet跟踪算法设计一个轻量级的小型网络学习卷积特征表示目标,利用SoftMax对采样样本分类,其性能表现非常优异,但速度只有1帧/s

SRDCF[15]

SRDCF(learning spatially regularized correlation filters for visual tracking)采用了大的检测区域,在滤波器系数上加入权重约束,越靠近边缘权重越大,越靠近中心权重越小,从而使得滤波器系数主要集中在中心区域,有效地缓解了边界效应

SiamFC[16]

SiamFC算法利用孪生网络(Siamese network),在视频序列ILSVRC2015离线训练一个相似性度量函数,在跟踪过程中利用该模型,选择与模板最相似的候选作为跟踪结果

C-COT[17]

C-COT(continuous convolution operators for visual tracking)将浅层表观信息和深层语义信息结合起来,根据不同空间分辨率的响应,在频域进行插值得到连续空间分辨率的响应图,通过迭代求解最佳位置和尺度

Struck[18]

Struck利用结构化的支持向量机(SVM)直接输出跟踪结果,避免中间分类环节,取得了优异的性能

CFNet[19]

CFNet将相关滤波改写成可微分的神经网络层,将特征提取网络整合到一起以实现端到端优化,训练与相关滤波器相匹配的卷积特征

ECO[20]

为了解决C-COT速度慢的问题,高效卷积算子ECO(efficient convolution operators)通过卷积因式分解操作、样本分组和更新策略对其改进,在不影响算法精确度的同时,算法速度提高了一个数量级

BACF[21]

BACF(background-aware correlation filters)通过补零操作获取更大搜索域的样本,进行循环采样时保证了真实的负样本

SiamRPN[22]

SiamRPN将目标跟踪构造成单样本检测任务,其网络结构分为特征提取Siamese子网络和候选目标区域生成RPN子网络。RPN子网络又包含分类和回归两条分支。SiamRPN可以利用ILSVRC和YouTube-BB大量的标注数据进行离线端到端训练,从而取得了较好的性能和跟踪速度

UPDT[23]

UPDT(unveiling the power of deep tracking)区别对待深度特征和浅层特征,利用数据增强和差异响应函数提高鲁棒性和准确性,同时利用提出的质量评估方法自适应融合响应图,得到最优的目标跟踪结果

SiamMask[24]

SiamMask是SiamRPN的后续之作。相比SiamRPN,SiamMask的网络结构增加了预测目标分割掩码的分支,从而给出了视觉目标跟踪(VOT)和视频目标分割(VOS)统一框架。SiamMask很好地实现了目标跟踪和目标分割任务之间的互相补充,不仅可以得到目标更精准的包围框,还可以得到目标的像素级标注

DiMP[25]

DiMP针对Siamese跟踪系列对于背景和目标区分性不足的问题,设计了一种鲁棒的判别能力较强的Loss,并通过端到端的训练学习Loss重点的关键参数。同时结合提出的权重预测模块对网络进行良好的初始化,最终DiMP在速度和准确性上都有所提高

UpdateNet[26]

UpdateNet旨在解决Siamese跟踪系列一直存在的模板更新难题,提出了用学习更新模板的方式来替代手工更新模板的方式。UpdateNet使用一个卷积神经网络根据初始帧模板、当前帧模板以及上次计算出的模板直接生成下一帧可用的最优模板,通过学习这样一个网络函数来实现模板更新功能

现阶段,基于深度学习的目标跟踪方法仍主要停留在基于ImageNet预训练的特征应用层面。随着TrackingNet等大规模数据集的出现,使得基于海量跟踪视频端对端地学习深度特征成为可能,有望进一步推进深度学习在视觉目标跟踪中取得突破性进展。

相对而言,标注长程跟踪视频和构建大规模数据集的难度更大,如何根据长程跟踪任务的特点及其与短期跟踪任务的联系,结合迁移学习和深度学习构建合适的长期目标跟踪模型,也是未来视觉目标跟踪研究值得关注的一个重要方向。

该综述28页,160+参考文献,关注 CVer 微信公众号

后台回复:20200110,即可获得本综述的PDF

参考文献

[1]Horn B K P, Schunck B G. 1981. Determining optical flow. Artificial Intelligence, 17(1-3): 185-203 [DOI:10.1016/0004-3702(81)90024-2]

[2]Shi J B and Tomasi C. 1994. Good features to track//Proceedings of 1994 IEEE Conference on Computer Vision and Pattern Recognition. Seattle, WA, USA: IEEE, 593-600[DOI:10.1109/CVPR.1994.323794]

[3]Isard M, Blake A. 1998. CONDENSATION-conditional density propagation for visual tracking. International Journal of Computer Vision, 29(1): 5-28 [DOI:10.1023/A:1008078328650]

[4]Comaniciu D, Meer P. 2002. Mean shift:a robust approach toward feature space analysis. IEEE Transactions on Pattern Analysis and Machine Intelligence, 24(5): 603-619 [DOI:10.1109/34.1000236]

[5]Collins R T, Liu Y X. 2003. On-line selection of discriminative tracking features//Proceedings of the 9th IEEE International Conference on Computer Vision. Nice, France. IEEE: 346-352 [DOI:10.1109/iccv.2003.1238365]

[6]Ross D A, Lim J, Lin R S, Yang M H. 2008. Incremental learning for robust visual tracking. International Journal of Computer Vision, 77(1-3): 125-141 [DOI:10.1007/s11263-007-0075-7]

[7]Grabner H, Leistner C and Bischof H. 2008. Semi-supervised on-line boosting for robust tracking//Proceedings of the 10th European Conference on Computer Vision. Marseille, France: Springer, 234-247[DOI:10.1007/978-3-540-88682-2_19]

[8]Kalal Z, Mikolajczyk K, Matas J. 2012. Tracking-learning-detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, 34(7): 1409-1422 [DOI:10.1109/TPAMI.2011.239]

[9]Mei X, Ling H. 2011. Robust visual tracking and vehicle classification via sparse representation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 33(11): 2259-2272 [DOI:10.1109/TPAMI.2011.66]

[10]Krizhevsky A, Sutskever I and Hinton G E. 2012. ImageNet classification with deep convolutional neural networks//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, Nevada: Curran Associates Inc, 1097-1105

[11]Henriques J F, Rui C, Martins P Vineet V, Cheng M, Hicks S L and Torr P H S. 2012. Exploiting the circulant structure of tracking-by-detection with kernels//Proceedings of the 12th European Conference on Computer Vision. Florence, Italy: Springer, 702-715[DOI:10.1007/978-3-642-33765-9_50]

[12]Wang N Y and Yeung D Y. 2013. Learning a deep compact image representation for visual tracking//Proceedings of the 26th International Conference on Neural Information Processing Systems. Lake Tahoe, Nevada: ACM, 809-817

[13]Danelljan M, Häger G, Khan F S, Felsberg M. 2014. Accurate scale estimation for robust visual tracking//Proceedings of the British Machine Vision Conference. Nottingham, UK: BMVA Press [DOI:10.5244/C.28.65]

[14]Nam H and Han B. 2016. Learning multi-domain convolutional neural networks for visual tracking//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 4293-4302[DOI:10.1109/CVPR.2016.465]

[15]Danelljan M, Häger G, Khan F S and Felsberg M. 2015a. Learning spatially regularized correlation filters for visual tracking//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile: IEEE, 4310-4318[DOI: 10.1109/ICCV.2015.490]

[16]Bertinetto L, Valmadre J, Henriques J F, Vedaldi A and Torr P H S. 2016b, Fully-convolutional siamese networks for object tracking//Proceedings of the European Conference on Computer Vision. Amsterdam, The Netherlands: Springer, 850-865[DOI:10.1007/978-3-319-48881-3_56]

[17]Danelljan M, Robinson A, Khan F S and Felsberg M. 2016. Beyond correlation filters: learning continuous convolution operators for visual tracking//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, The Netherlands: Springer, 472-488[DOI:10.1007/978-3-319-46454-1_29]

[18]Hare S, Golodetz S, Saffari A, Vineet V, Cheng M M, Hicks S L, Torr P H S. 2016. Struck:structured output tracking with kernels. IEEE Transactions on Pattern Analysis and Machine Intelligence, 38(10): 2096-2109 [DOI:10.1109/TPAMI.2015.2509974]

[19]Valmadre J, Bertinetto L, Henriques J, Vedaldi A and Torr P H. 2017. End-to-end representation learning for correlation filter based tracking//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 5000-5008[DOI:10.1109/CVPR.2017.531]

[20]Danelljan M, Bhat G, Khan F S, Felsberg M. 2017. Eco:efficient convolution operators for tracking//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE: 6931-6939 [DOI:10.1109/CVPR.2017.733]

[21]Galoogahi H K, Fagg A and Lucey S. 2017. Learning background-aware correlation filters for visual tracking//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy: IEEE, 1144-1152[DOI:10.1109/ICCV.2017.129]

[22]Li B, Yan J J, Wu W, Zhu Z and Hu X. 2018a. High performance visual tracking with siamese region proposal network//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 8971-8980[DOI: 10.1109/CVPR.2018.00935]

[23]Bhat G, Johnander J, Danelljan M, Khan F S, Felsberg M. 2018. Unveiling the power of deep tracking//Proceedings of the 15th European Conference on Computer Vision. Munich, Germany: Springer: 493-509 [DOI:10.1007/978-3-030-01216-8_30]

[24]Qiang Wang, Li Zhang, Luca Bertinetto, Weiming Hu, Philip H.S. Torr "Fast online object tracking and segmentation: A unifying approach." CVPR. 2019. https://arxiv.org/abs/1812.05050

[25]Goutam Bhat, et al. "Learning Discriminative Model Prediction for Tracking." ICCV. 2019. https://arxiv.org/pdf/1904.07220.pdf

[26]Zhang, Lichao, et al. "Learning the Model Update for Siamese Trackers." ICCV. 2019. https://arxiv.org/abs/1908.00855?context=cs

作者介绍

李玺,第一作者,教授,主要研究方向为计算机视觉、模式识别以及深度学习等。

E-mail: xilizju@zju.edu.cn

王菡子,通信作者,教授,主要研究方向为计算机视觉和模式识别。

E-mail: Hanzi.Wang@xmu.edu.cn

查宇飞,副教授,研究方向为视频目标跟踪。

E-mail: zhayufei@126.com

张天柱,教授,研究方向为模式识别与智能系统。

E-mail: tzzhang@ustc.edu.cn

崔振,教授,研究方向为计算机视觉与模式识别。

E-mail: zhen.cui@njust.edu.cn

左旺孟,教授,研究领域包括计算机视觉和深度学习。

E-mail: cswmzuo@gmail.com

侯志强,教授,研究方向为图像处理、计算机视觉和信息融合。

E-mail: hzq@xupt.edu.cn

卢湖川,教授,研究方向为计算机视觉,模式识别,图像处理。

E-mail: lhchuan@dlut.edu.cn

推荐阅读

张博, 江沸菠, 刘刚. 利用感知模型的长期目标跟踪[J]. 中国图象图形学报, 2019, 24(11): 1906-1917.

孟琭, 李诚新. 近年目标跟踪算法短评——相关滤波与深度学习[J]. 中国图象图形学报, 2019, 24(7): 1011-1016.

朱建章, 王栋, 卢湖川. 背景与时间感知的相关滤波实时视觉跟踪[J]. 中国图象图形学报, 2019, 24(4): 536-549.

刘万军, 张壮, 姜文涛, 张晟翀. 遮挡判别下的多尺度相关滤波跟踪算法[J]. 中国图象图形学报, 2018, 23(12): 1789-1800.

葛宝义, 左宪章, 胡永江. 视觉目标跟踪方法研究综述[J]. 中国图象图形学报, 2018, 23(8): 1091-1107.

编辑:韩小荷 指导:梧桐君

审校:夏薇薇 总编辑:肖 亮

重磅!CVer-目标跟踪交流群已成立

扫码可添加CVer助手,可申请加入CVer大群和细分方向群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索等群。

一定要备注:研究方向+地点+学校/公司+昵称(如目标跟踪+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加群

▲长按关注我们

麻烦给我一个在看!