![]()

本文约5503字,建议阅读10分钟

本文介绍了新鲜出炉的ICCV 2021最佳论文、最佳学生论文、最佳论文荣誉提名,PAMI-TC奖全公布。其中,中国学者数量几乎占据半壁江山

![]()

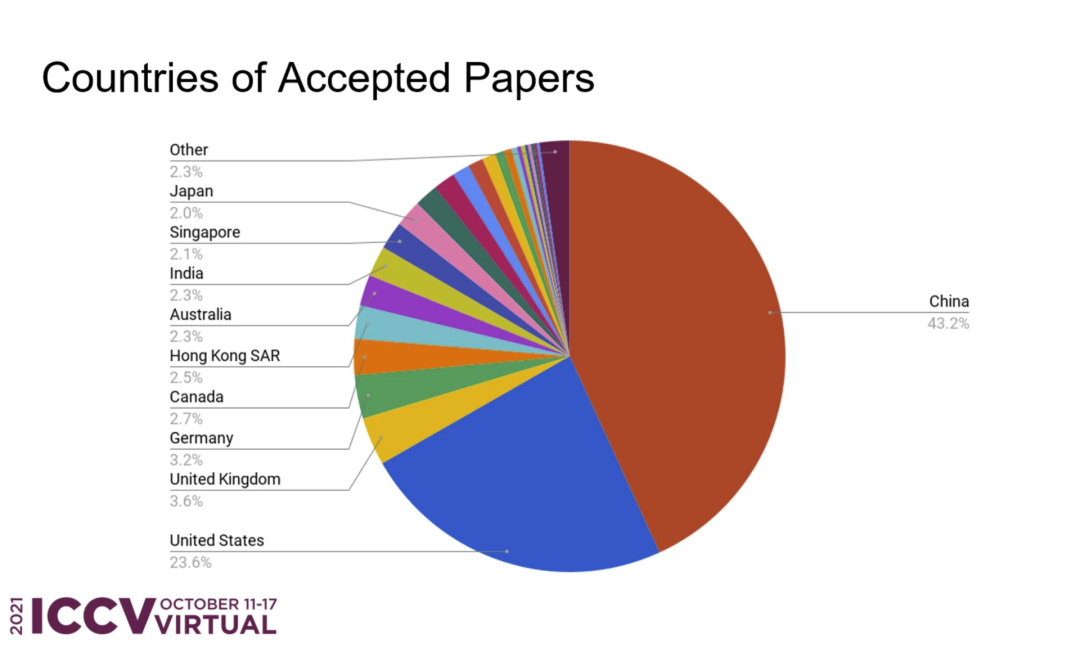

【导读】ICCV 2021最佳论文新鲜出炉!微软亚洲研究院团队拔得头筹,获得了最佳论文奖。还有最佳学生论文,最佳论文荣誉提名,PAMI-TC奖全公布。其中,中国学者数量几乎占据半壁江山,超过美国近一半。

ICCV 最佳论文来了!

今年ICCV 2021公布了最佳论文奖(马尔奖),最佳学生论文奖,最佳论文荣誉提名,PAMI-TC奖多个奖项。

其中,微软亚洲研究院团队拔得头筹,获得了最佳论文奖,论文一作为中科大刘泽。苏黎世联邦理工大学和微软研究人员共同摘得最佳学生论文奖。

还有4篇最佳论文荣誉提名,PAMI-TC奖分设的4个奖项颁给了过往杰出研究的学者。

![]()

作为计算机视觉领域三大会议之一的 ICCV(IEEE International Conference on Computer Vision)每年都会吸引众多 AI 研究人员参会。

不同于在美国每年召开一次的CVPR和只在欧洲召开的ECCV,ICCV在世界范围内每2年召开一次。

获奖论文一览:微软亚洲院摘桂冠

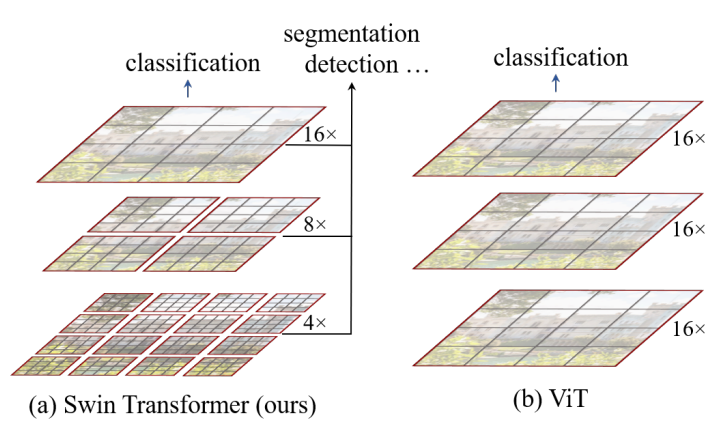

Swin Transformer: Hierarchical Vision Transformer Using Shifted Windows

论文地址:https://arxiv.org/pdf/2103.14030.pdf

这篇文章介绍了一种新的、可以应用于计算机视觉里的Transformer,Swin Transformer。

Transformer解决计算机视觉问题的挑战主要来自两个领域:图像的比例差异很大,而且图像具有很高的分辨率,在有些视觉任务和如语义分割中,像素级的密集预测对于Transformer来说是难以处理的,因为其self-attention的计算复杂度与图像大小成二次关系。

为了克服这些问题,Swin Transformer构建了分层Transformer特征图,并采用移位窗口计算。移位窗口方案通过将self-attention计算限制在不重叠的局部窗口(用红色标出),同时还允许跨窗口连接,带来了更高的效率。

Swin Transformer通过从小尺寸的面片(用灰色勾勒)开始,并逐渐合并更深的Transformer层中的相邻面片来构建分层表示。这种分层体系结构可以灵活地在各种尺度上建模,并且在图像大小方面具有线性计算复杂度。线性计算复杂度是通过在分割图像的非重叠窗口(用红色标出)内局部计算自我注意来实现的。 每个窗口中的面片数量是固定的,因此复杂度与图像大小成线性关系。

Swin Transformer在图像分类、目标检测和语义分割等识别任务上取得了很好的性能,在三个任务中,Swin Transformer的时间延迟与ViT,DeiT和ResNeXt模型相似,但性能却得到了大幅提升:COCO test-dev 58.7 box AP和51.1 mask AP,力压之前的最先进结果2.7 box AP和2.6 mask AP。 在ADE20K语义分割任务中,Swin Transformer在验证集上获得了53.5 mIoU,比以前的最先进水平(SETR)提高了3.2 mIoU。 在ImageNet-1K图像分类中,它也达到了87.3%的最高精度,充分展现Transformer模型作为新视觉backbone的潜力。

该论文一作刘泽是中科大的学生,在微软亚洲研究院实习。他于2019年获中国科技大学学士学位,并以最高荣誉获得郭沫若奖学金。

个人主页介绍,其2篇论文和1篇Oral被ICCV2021接收。

个人主页:https://zeliu98.github.io/

Pixel-Perfect Structure-From-Motion With Featuremetric Refinement

论文地址:https://arxiv.org/pdf/2108.08291.pdf

找到跨多个视图可重复的局部特征是稀疏三维重建的基石。经典的图像匹配范例一劳永逸地检测每个图像的关键点,这可能产生定位不良的特征,并将大的误差传播到最终的几何图形。

这篇文章通过直接对齐来自多个视图的低级图像信息来细化SfM(Structure-from-Motion),先在任何几何估计之前调整初始关键点位置,然后细化点和相机姿势作为后处理。

本文认为精确的大规模SfM(Structure-from-Motion)方法是使用稀疏的特征执行初始粗略估计,然后使用局部精确的密集特征进行细化。这种改进对于大的检测噪声和外观变化是鲁棒的,因为它基于神经网络预测的密集特征来优化特征度量误差。这显著提高了各种关键点检测器的相机姿态和场景几何的准确性。

论文1: Mip-NeRF: A Multiscale Representation for Anti-Aliasing Neural Radiance Fields

论文地址:https://arxiv.org/pdf/2103.13415.pdf

谷歌和UC伯克利研人员在本文提出了一种名为「mip-NeRF」的扩展解决方案。

就NeRF来说,每条光线的像素渲染都需要查询多层感知器上百次。而mip-NeRF的视线以连续值的比例表示场景,通过高效渲染消除反锯齿圆锥锥体取代光线。

研究结果表明,mip NeRF减少了混叠瑕疵,将NeRF表示精细细节的能力显著提高,在速度上比NeRF快7%,大小仅为NeRF的一半。 此外,mip NeRF在数据集上降低了17%的平均错误率,在多尺度变体上降低了60%的平均错误率。

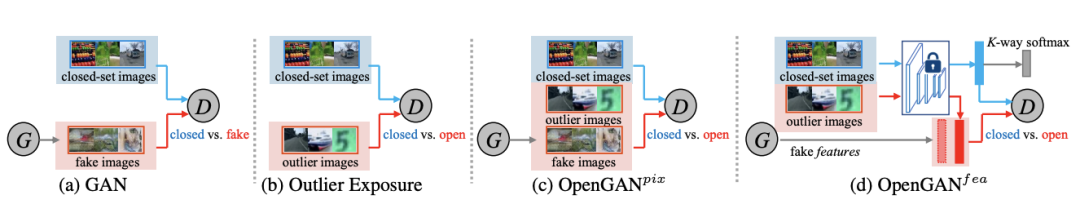

论文2: OpenGAN: Open-Set Recognition via Open Data Generation

论文地址:https://arxiv.org/pdf/2104.02939.pdf

机器学习过程中需要分析与训练数据不同的测试数据。为了和K闭集数据集区分,这通常在K-way分类中被表述为开集识别。

一般来说,开集识别有2种处理方案。然而,由于过度拟合训练离散值,这2种方案一种不能很好地推广到不同的开放测试数据,而另一种由于GAN训练不稳定导致效果不好。

来自卡内基梅隆大学的论文一作Shu Kong在本文中基于上述问题,提出了全新解决方案OpenGAN,它在三个方面不同于其他使用GAN的开集方法:通过学习一个鲁棒的开集-闭集鉴别器充当开集似然函数;用假数据(由生成器合成)和真实的开集训练示例训练鉴别器;用OTS特征而不是RGB像素来训练GAN。

OpenGAN在包括图像分类和像素分割在内的各种任务中,在开放集识别方面的性能明显优于先前的工作,证明了OpenGAN可以提高其他基于GAN的开集方法的准确性。

华人学者Shu Kong现在是卡内基梅隆大学在读计算机博士后。他的研究兴趣包括计算机视觉、机器学习、以及其在现实世界中的应用和整合。

目前的研究重点为「visual perception and learning in an open world」,并在自己的书对这个内容中简要地进行了扩展。

个人主页:https://www.cs.cmu.edu/~shuk/

论文3: Viewing Graph Solvability via Cycle Consistency

https://openaccess.thecvf.com/content/ICCV2021/papers/Arrigoni_Viewing_Graph_Solvability_via_Cycle_Consistency_ICCV_2021_paper.pdf

在SfM(Structure from Motion)中,观察图的顶点对应摄像机,边代表基本矩阵。已知的理论要么不能完全表征所有观察图的可解性,要么非常难以计算,因为它们需要求解一个含有大量未知数的多项式方程组。

本文提供了一种新的公式和算法来确定观察图是否可解,即它唯一地确定一组投影摄像机。主要方式是利用循环一致性来减少未知量。

这种算法分为三步走,第一步要分类九个节点内的所有极小图;第二步将实际的可解性测试扩展到具有90个节点的最小图;最后,证明有限可解性并不意味着可解来回答一个开放的研究问题。

论文4: Common Objects in 3D: Large-Scale Learning and Evaluation of Real-Life 3D Category Reconstruction

论文地址:https://arxiv.org/pdf/2109.00512.pdf

由于真实的以类别为中心的三维标注的数据不好获取,如果要学习三维对象的类别,传统方法主要在合成数据集上进行训练和评估。

这项工作的主要贡献是收集了一个与现有合成数据相似的大规模真实数据集,名为Common Objects in 3D,包含用相机姿态和地面真实3D点云来标注对象类别的真实多视图图像。该数据集总共包含来自近19000个视频的150万帧,对应50个MS-COCO类别的对象。

利用这个新数据集对几种新的视图合成和以类别为中心的三维重建方法进行了第一次大规模的评估。论文还贡献了NerFormer,一种新颖的神经渲染方法,利用强大的Transformer在给定少量视图的情况下重建对象。

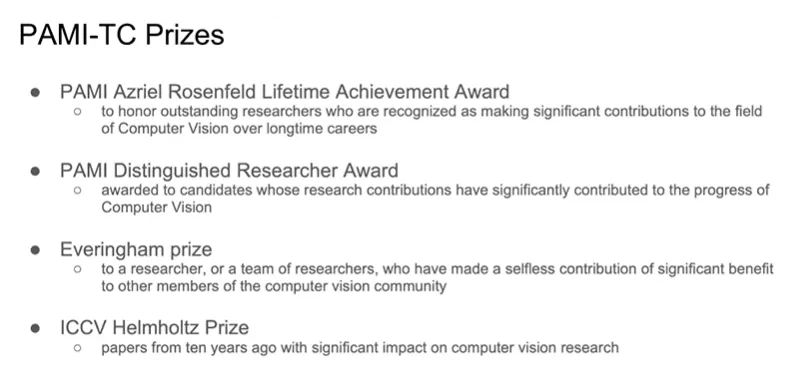

和往年一样,ICCV 21 还颁布了过往杰出研究类奖项 PAMI-TC 奖,其中包括4个奖项:Azriel Rosenfeld终身成就奖、杰出学者奖,Everingham 奖和ICCV Helmholtz 奖。

Azriel Rosenfeld终身成就奖

颁发给了加州大学Berkeley 分校电气工程与计算机科学系教授 RUzena Bajcsy,以表彰其长期以来在计算机视觉领域所作出的重大贡献。

RUzena Bajcsy是美国的工程师和计算机科学家,任职加州大学伯克利分校。2001 年,她获得了 ACM/人工智能促进协会 Allen Newell 奖,并在 2002 年 11 月的《探索》杂志上被评为科学界最重要的 50 位女性之一。

由于她在机器人和自动化领域的贡献,她获得了本杰明富兰克林计算机和认知科学奖章(2009 年)和 IEEE 机器人和自动化奖(2013 年)。

杰出学者奖

项颁给了两位研究者,加州理工学院教授Pietro Perona和法国国家信息与自动化研究所研究员Cordelia Schmid。

还有

Everingham奖

颁发给了KITTI 视觉基准团队和Detectron对象检测和分割软件团队。

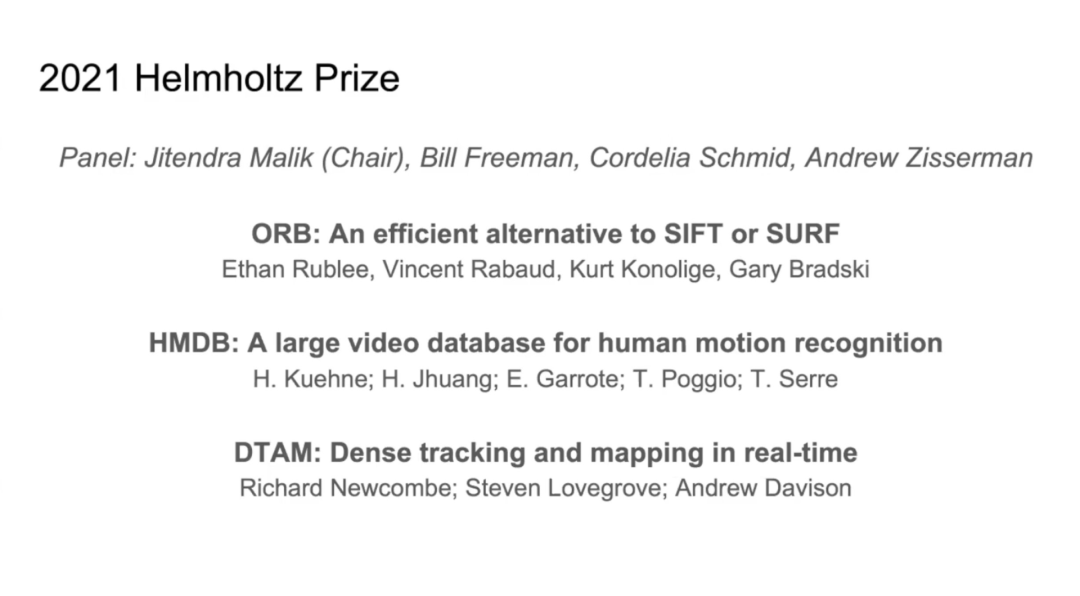

今年ICCV Helmholtz 奖颁给了十年前对计算机视觉领域产生重大影响的三篇论文,以奖励对计算机视觉领域做出重要贡献的工作。

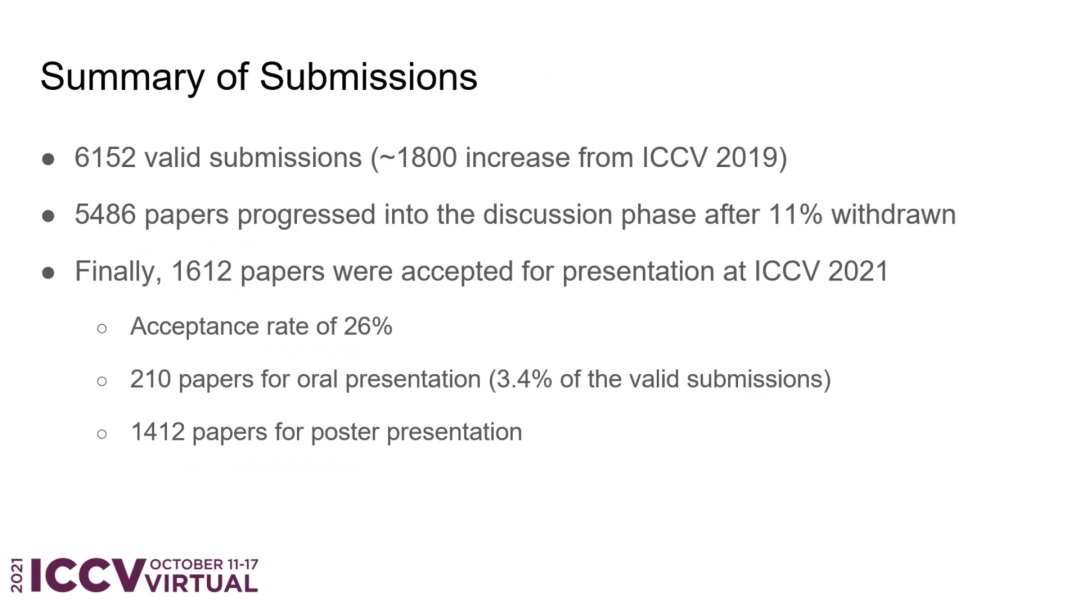

一直以来,ICCV论文录用率非常低,却是三大会议中公认级别最高的。

今年在论文收稿和入围数量方面,ICCV 21共收到论文投稿6236篇,最终入围1617篇,接收率约为 25.9%,较上届的25%有所上升。

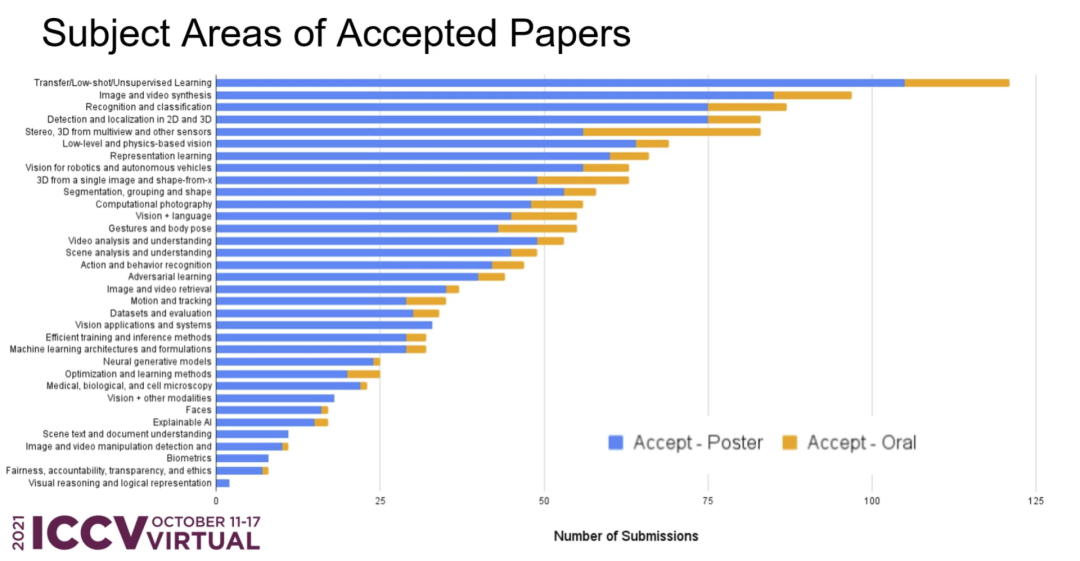

就接收论文分布领域而言,接收数量都超过了80篇的领域有:迁移/小样本/无监督学习(Transfer/low-shot/unsupervised learning)、图像视频合成(image and video synthesis)、识别和分类(detection and localization in 2D and 3D) ,位列前三。

还有一些新领域,比如关于可解释性AI、公平、道德等相关主题论文数量也较往年有所上涨。

就机构组织来说,今年ICCV 上,谷歌近66篇论文入选,实力霸榜。

国内,商汤科技及联合实验室共计50篇论文入选ICCV 2021,同时在MFR、LPCV等多项重要竞赛中夺冠。

放眼全球,中国论文数量几乎占据了「半壁江山」(45.7%),赶超美国(23.6%)。

据Aminer统计,起源人工智能研究院的邵岭教授,以及罗彻斯特大学助理教授Chenliang Xu,还有南京大学计算机科学与技术系王利民共入选3篇,位列华人榜首。

https://www.aminer.cn/conf/iccv2021/roster

https://twitter.com/CSProfKGD

![]()