2018年你读到最好的机器学习论文是什么?RL,BERT,GAN?Why?【Reddit】

【导读】2018年即将过去,对于人工智能机器学习是一个收获颇丰的年度。在reddit机器学习版块新出一个热点问题“What is the best ML paper you read in 2018 and why?”,引起很多网友的回答,各位给出了自己认为做好的ML论文以及原因。在这里专知整理了一些答案供阅览,也欢迎各位专知读者在文章末尾留言,说出你认为2018年最好的机器学习论文,并说说为啥!排名前10位赠送专知《深度学习:算法到实战》优惠码,最高100!

【年度最佳论文打包下载】

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知)

后台回复“MLB2018” 就可以获取2018年度最佳论文的下载链接~

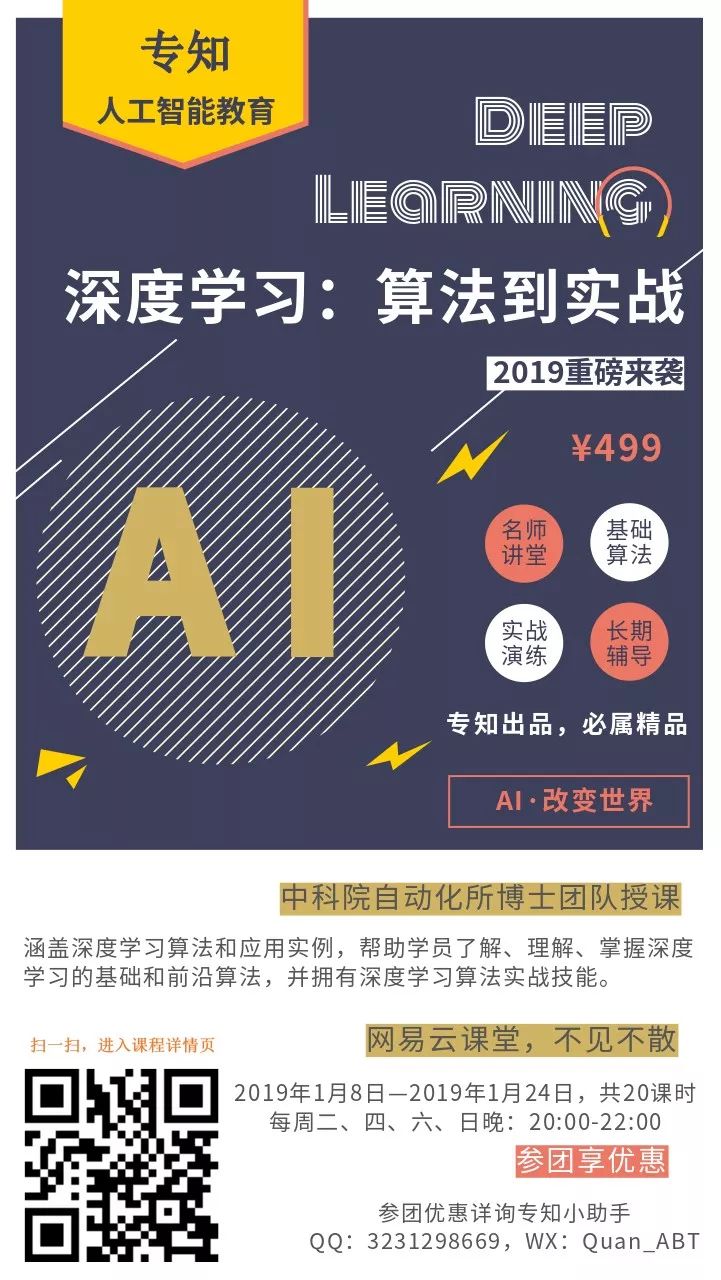

专知2019年1月将开设一门《深度学习:算法到实战》讲述相关ML2018论文,欢迎关注报名!

专知开课啦!《深度学习: 算法到实战》, 中科院博士为你讲授!

What is the best ML paper you read in 2018 and why?

网址:

https://www.reddit.com/r/MachineLearning/comments/a6cbzm/d_what_is_the_best_ml_paper_you_read_in_2018_and/

#beezlebub33#回答,51 Points

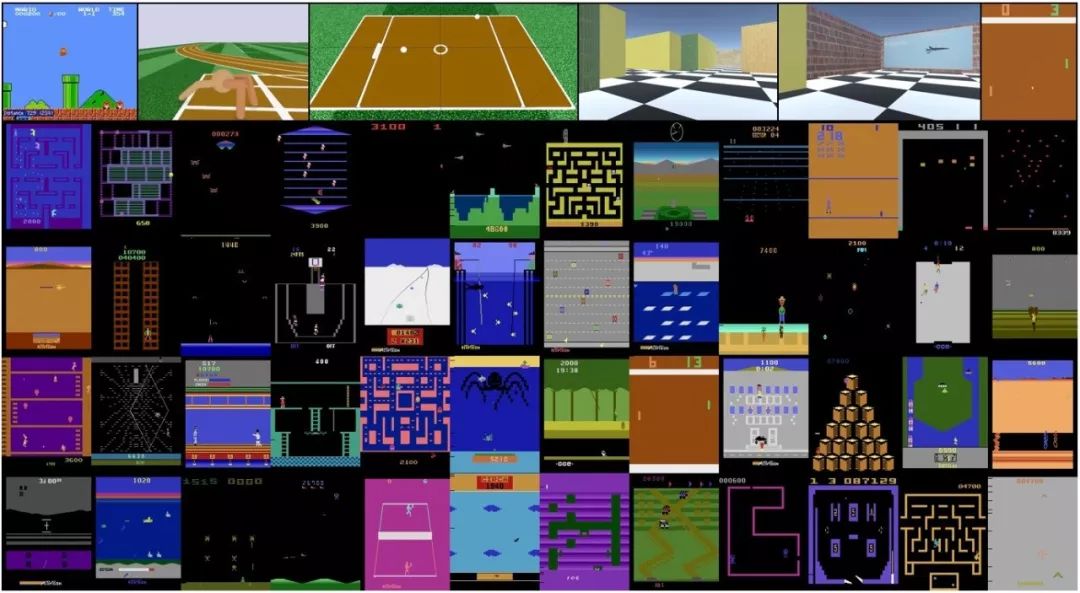

Large-Scale Study of Curiosity-Driven Learning

https://pathak22.github.io/large-scale-curiosity/

http://www.zhuanzhi.ai/paper/e5748eb66ea3f082f8b94916774ef374

这篇论文的重要性在于它在没有明确奖励的情况下在各种游戏中取得了良好的表现。它通过做预测、识别违反预期的行为,以及探索自己不知道的领域,学会了如何玩游戏。这就引出了人工智能需要走的方向:自我监督、未标记的数据、预测、好奇心、内在动机等。在这个世界上,人类没有足够的时间来产生受监督的训练集,并在这些数据集上定义度量标准。相反,如果你向人工智能提供来自系统(或自然界)的原始数据,并且它可以学习该系统时空演化的内部表示,那么你就可以定义一个目标,人工智能就能够实现它。

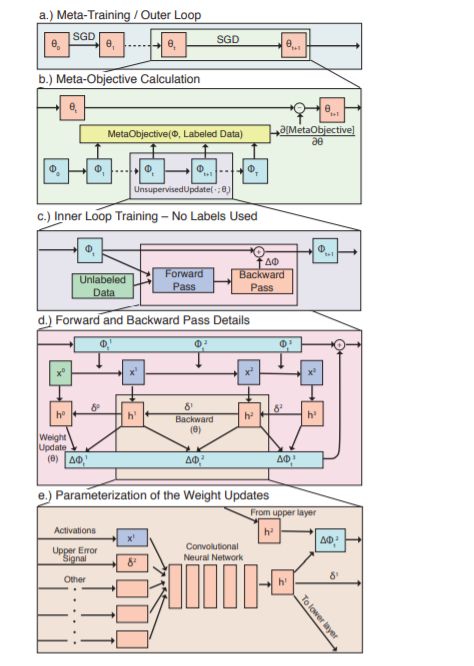

Learning Unsupervised Learning Rules

http://www.zhuanzhi.ai/paper/dd00419fa76c032b7df6e7bb6035bfd0

再者,这都是关于使用无监督学习来学习有用的东西,但更好的是,它是学习如何学习。元学习是一个关键领域,学习学习规则可以让人工智能了解自己,并最终提高自己。如果你能教电脑如何学习,它如何探索如何学习,那么我们就有机会起飞了。

#anterak13#回答,20 points

Rethinking statistical learning theory: learning with statistical invariants

https://link.springer.com/article/10.1007/s10994-018-5742-0

https://www.youtube.com/watch?v=rNd7PDdhl4c

#SupportVectorMachine# 回答

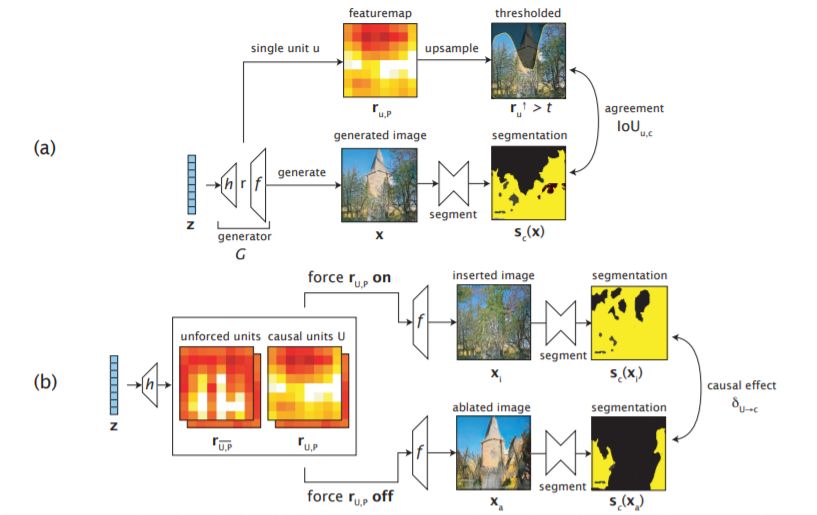

GAN Dissection: Visualizing and Understanding Generative Adversarial Networks

http://www.zhuanzhi.ai/paper/eeb3f9ff30551ef554265907f24cf278

今年已经有了一些很好的结果,NVIDIA关于逐渐增长的GANs(包括他们最新论文中令人难以置信的好结果)所做的工作给我留下了特别深刻的印象。但我最喜欢的可能是《GAN解剖:可视化和理解生成性对抗网络》(GAN Dissection: Visualizing and Understanding generate Adversarial Networks),这是我一段时间以来看到的写得最好、插图最丰富的论文之一(这是一篇全面、实际上是可理解的论文)。

#kartayyar#回答

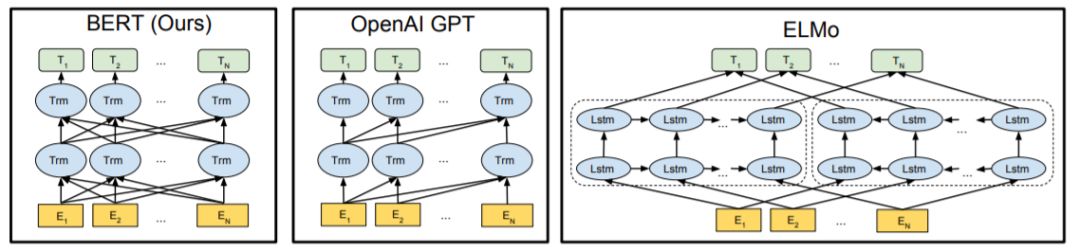

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

http://www.zhuanzhi.ai/paper/49f897ff4de3ea0e5bb0326078a7dab9

https://github.com/google-research/bert

好的创意,他们使用的掩蔽是很有创意的。他们用简单的语言很好地描述了他们的核心思想。在Github上有可复制结果的代码。他们处理了多项不同的任务。

#lmericle# 回答

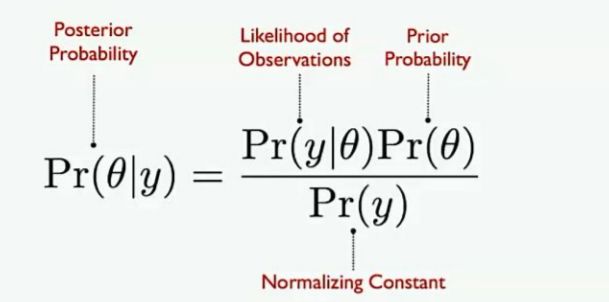

Bayesian Neural Networks

https://arxiv.org/abs/1801.07710

我发现最初的贝叶斯神经网络论文很好的解释了概率编程,而且它不需要整个教科书来理解!当然,这篇文章会更全面和详细。

#breadwithlice#回答,

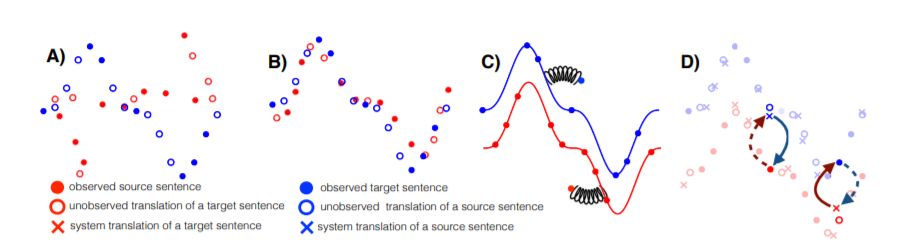

Phrase-Based & Neural Unsupervised Machine Translation

http://www.zhuanzhi.ai/paper/484ce1c1064cd372ba6e9eec459d2e0f

将一种语言翻译成另一种语言,不使用任何映射、字典或并行数据,只使用单语语料库。他们使用了一种叫做反向翻译的技巧,通过把A翻译成B,然后把B翻译成A,然后试着重新站起来,再把A和B调换一下,极大地提高了译者的水平。

更多请上,

https://www.reddit.com/r/MachineLearning/comments/a6cbzm/d_what_is_the_best_ml_paper_you_read_in_2018_and/

-END-

专 · 知

专知开课啦!《深度学习: 算法到实战》, 中科院博士为你讲授!

请加专知小助手微信(扫一扫如下二维码添加),咨询《深度学习:算法到实战》参团限时优惠报名~

欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程