自动化所胡包钢研究员最新从广义约束探讨—深度学习模型可解释性教程

【导读】今天,专知很荣幸邀请到中科院自动化研究所胡包钢研究员分享他最近在法国巴黎萨克雷大学(Université Paris-Saclay)数学与计算机科学交叉实验室 (Mathematics in Interaction with Computer Science,MICS)学术交流的讲稿。该实验室前身来自于巴黎工程师大学应用数学实验室。

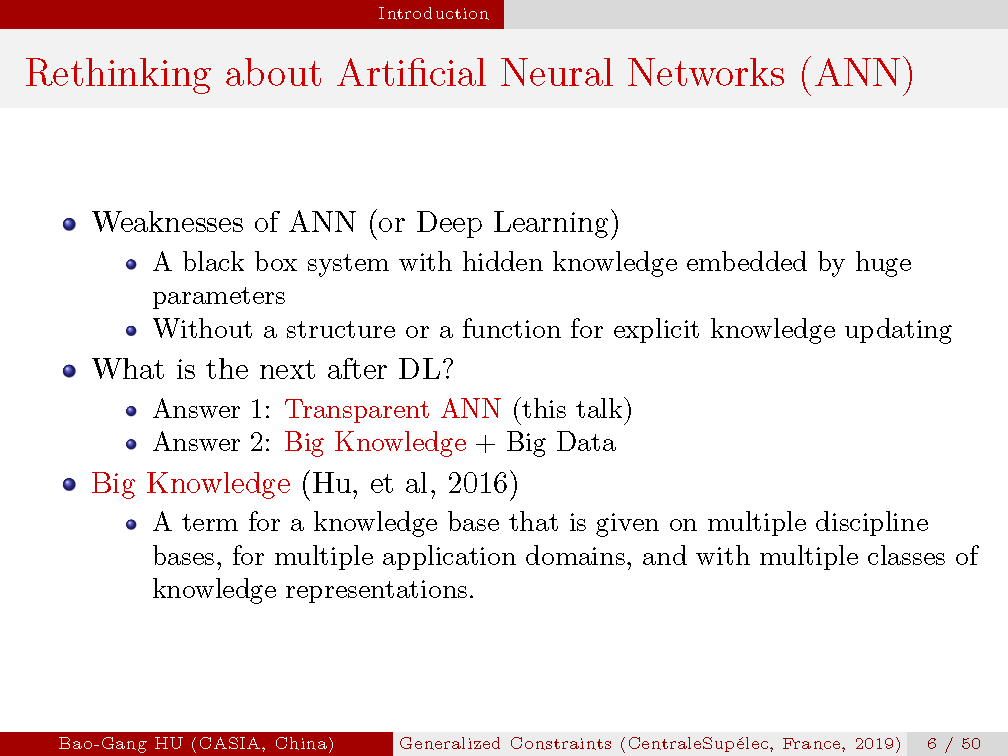

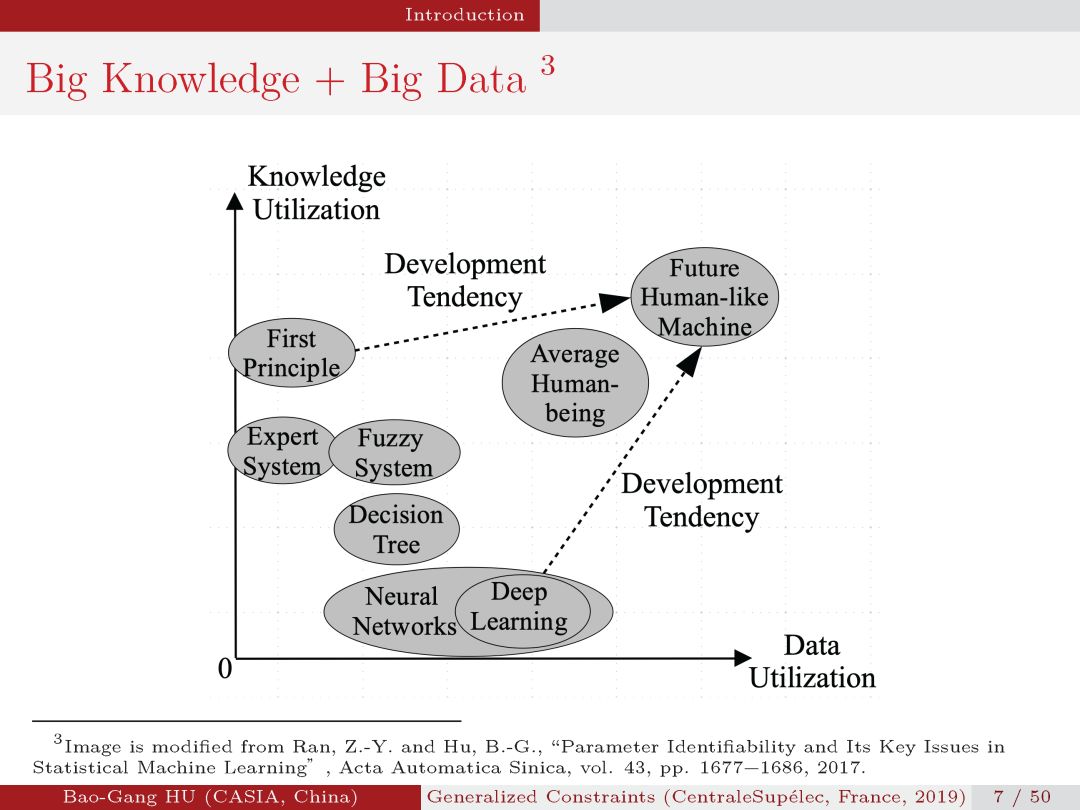

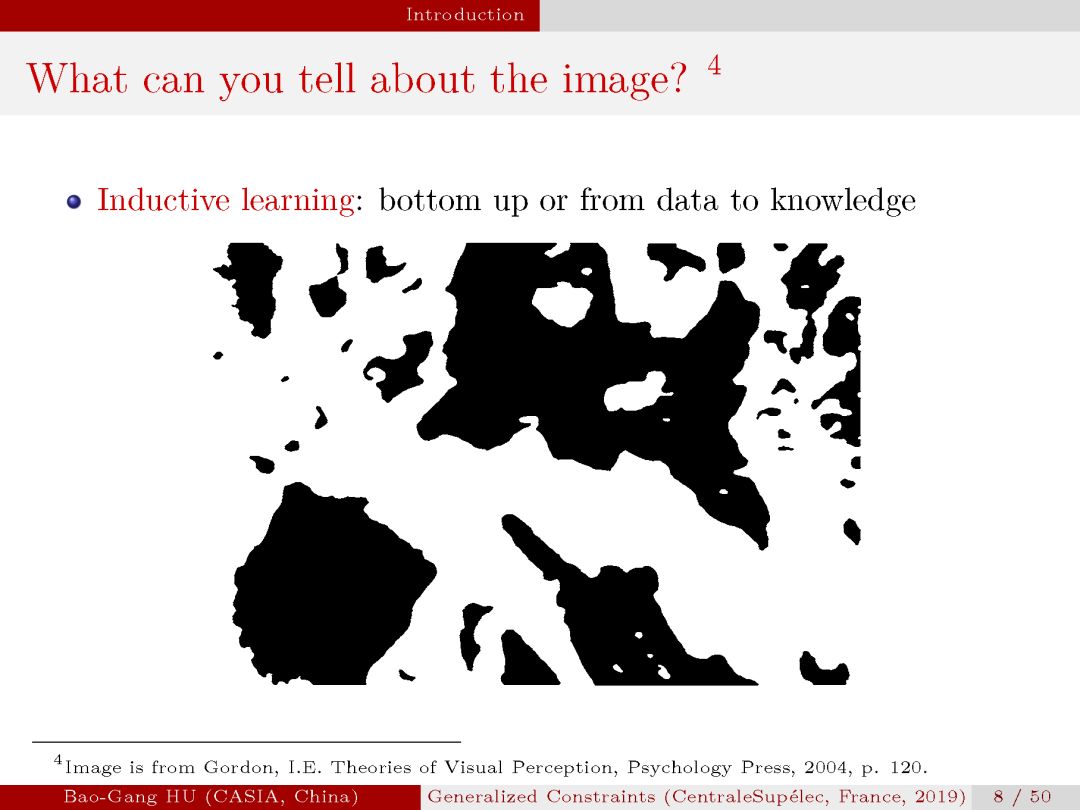

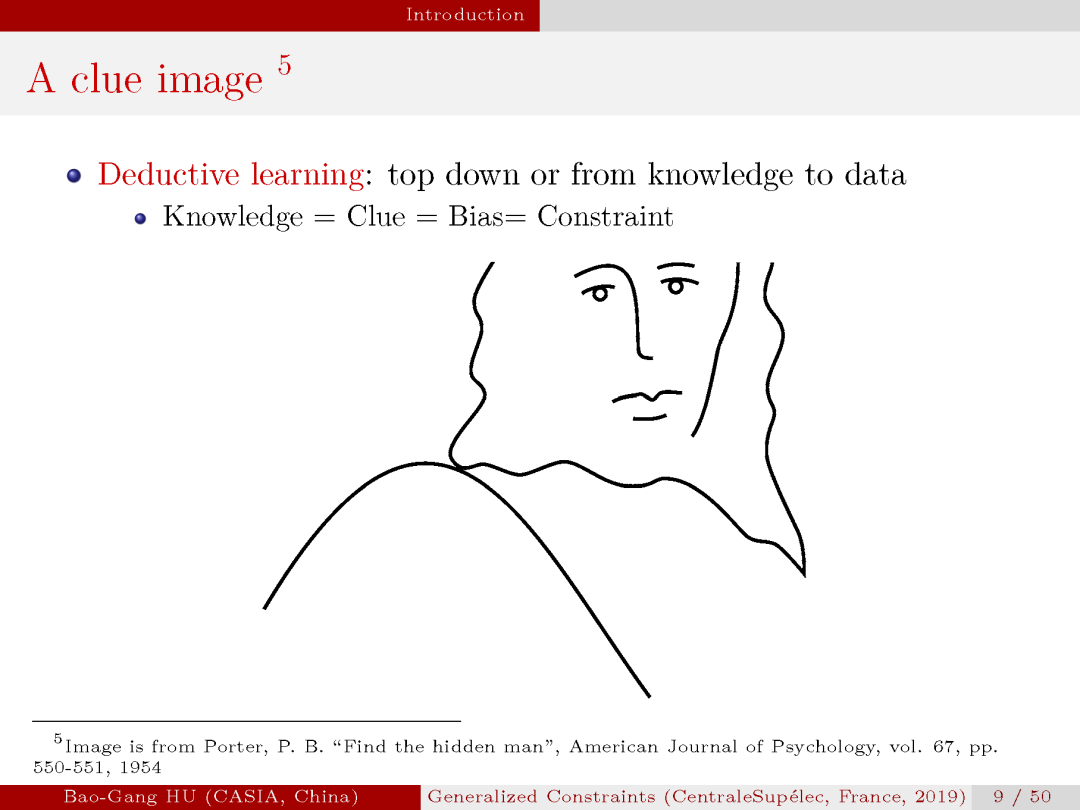

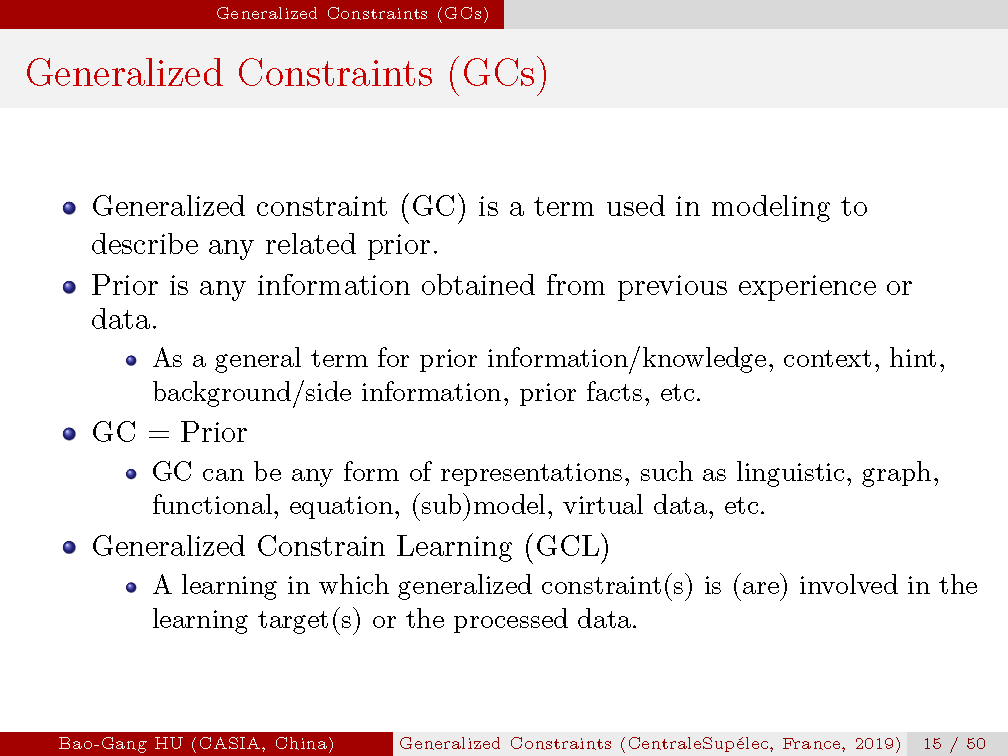

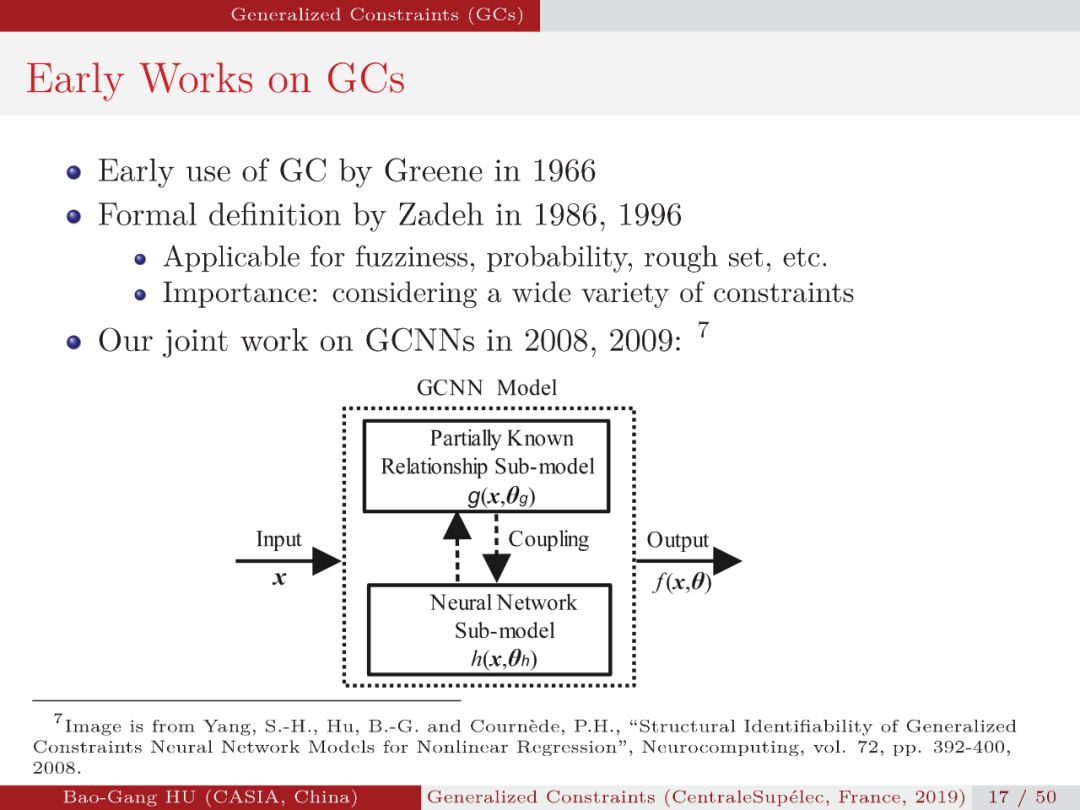

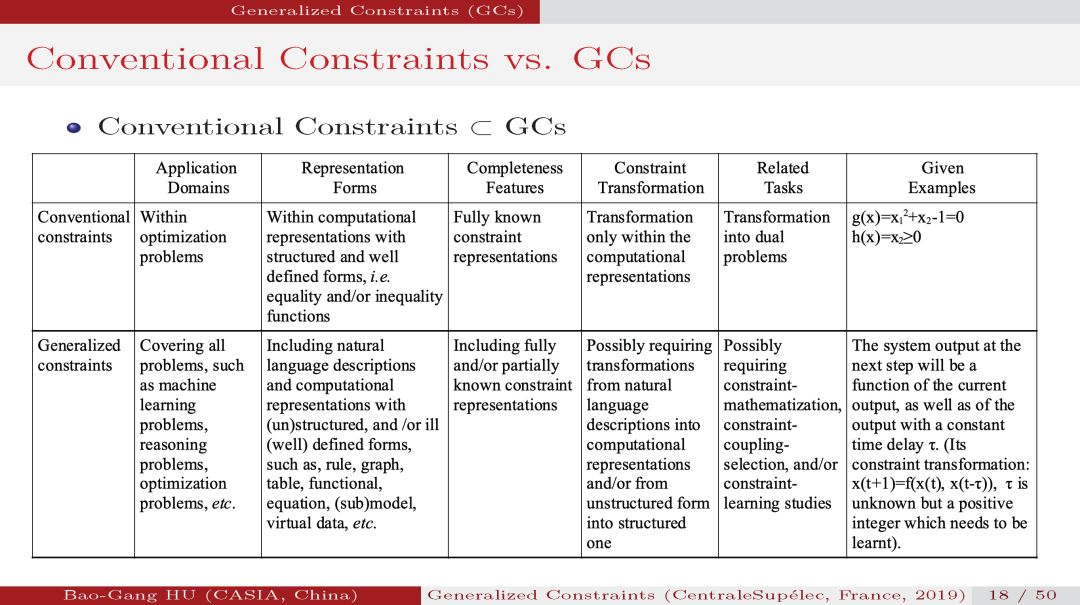

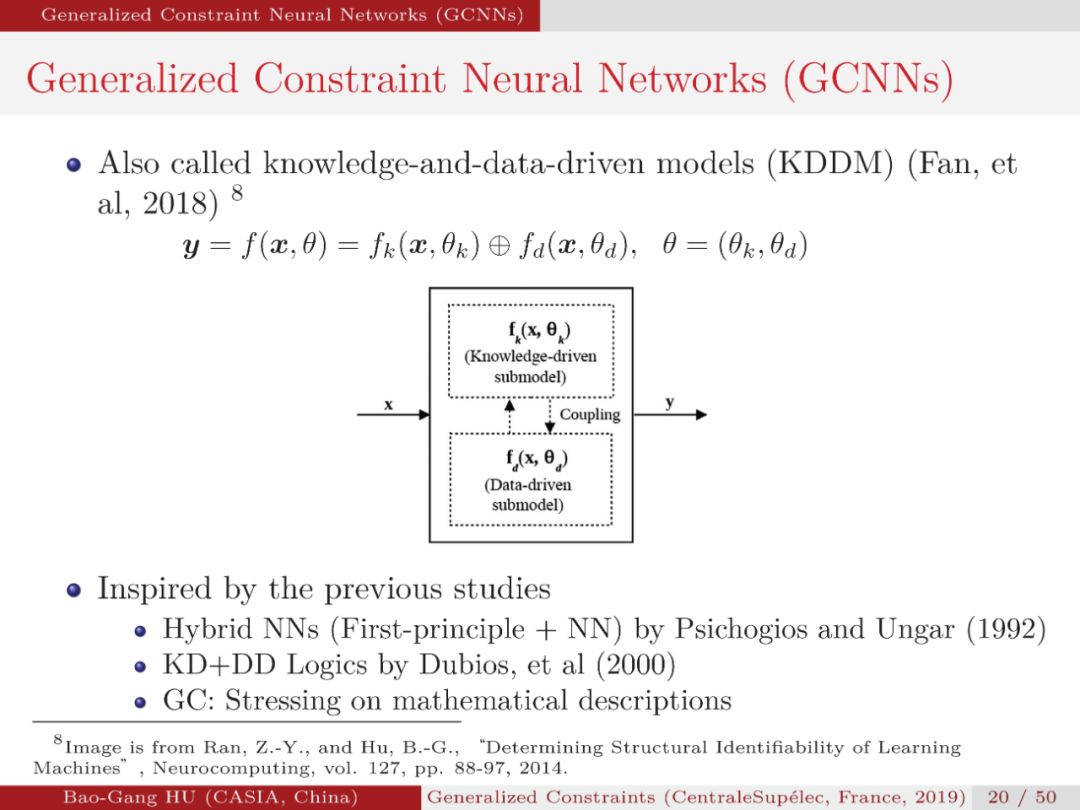

在应用机器学习结局特定问题时,不论是知识驱动的建模方法还是数据驱动的建模方法,为了使模型能够有更好的泛化性能,先验知识的引入总是必不可少的因素。然而,对不同的模型,如何有效地引入先验以及引入何种先验,在使用不同模型解决不同问题时都是不同的。本次报告题目是《Generalized Constraints for Knowledge-Driven-and-Data-Driven Modeling Approaches》。作者讨论了使用广义约束作为针对不同知识驱动与数据驱动模型引入先验的通用方法,希望从这个角度的研究增加对深度学习模型的可解释性,给读者带来启发。文章末尾附有胡老师的的教程报告PDF下载。

▌概述

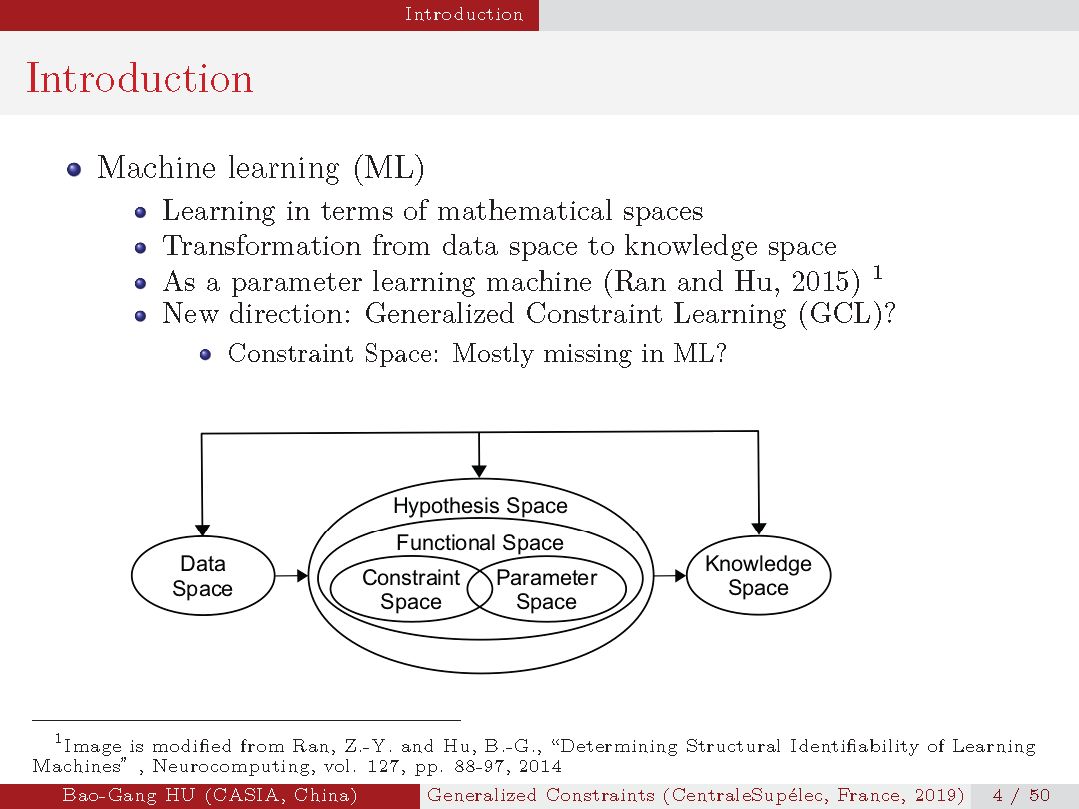

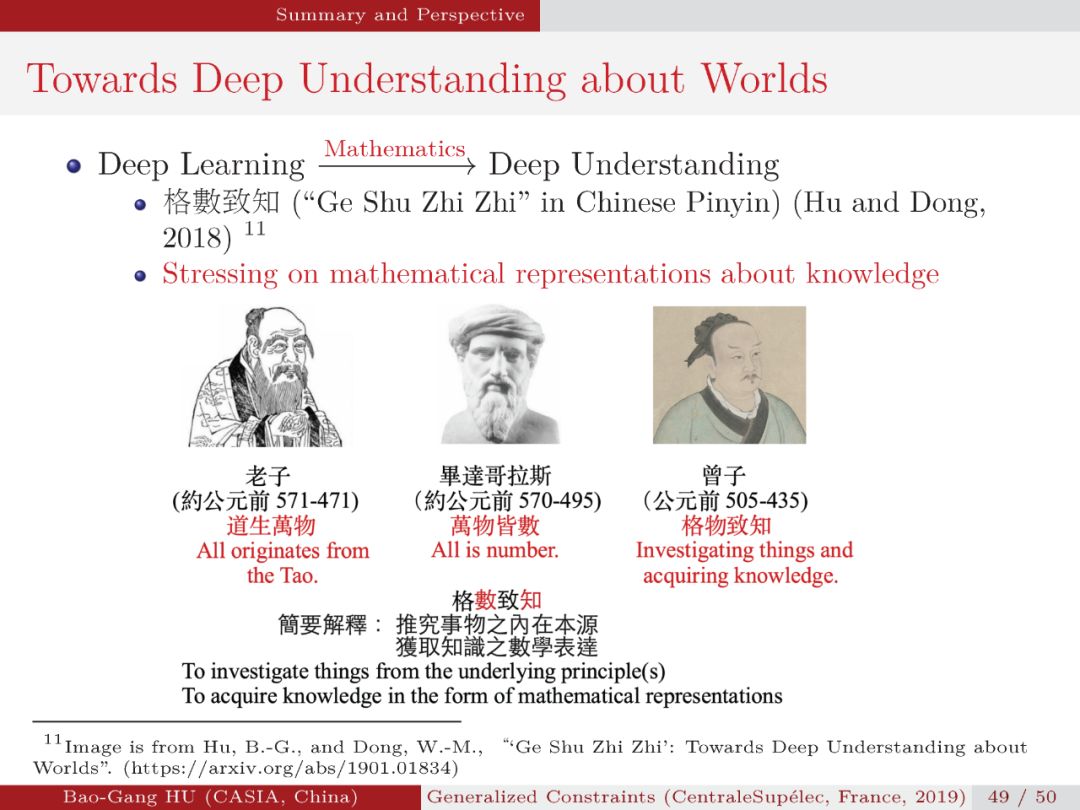

该学术交流报告介绍了我对人工智能发展在思想与数学问题层面上的思考。我们知道人工智能思想与应用问题都要转换到数学层面,这时就将仅是数学问题了。

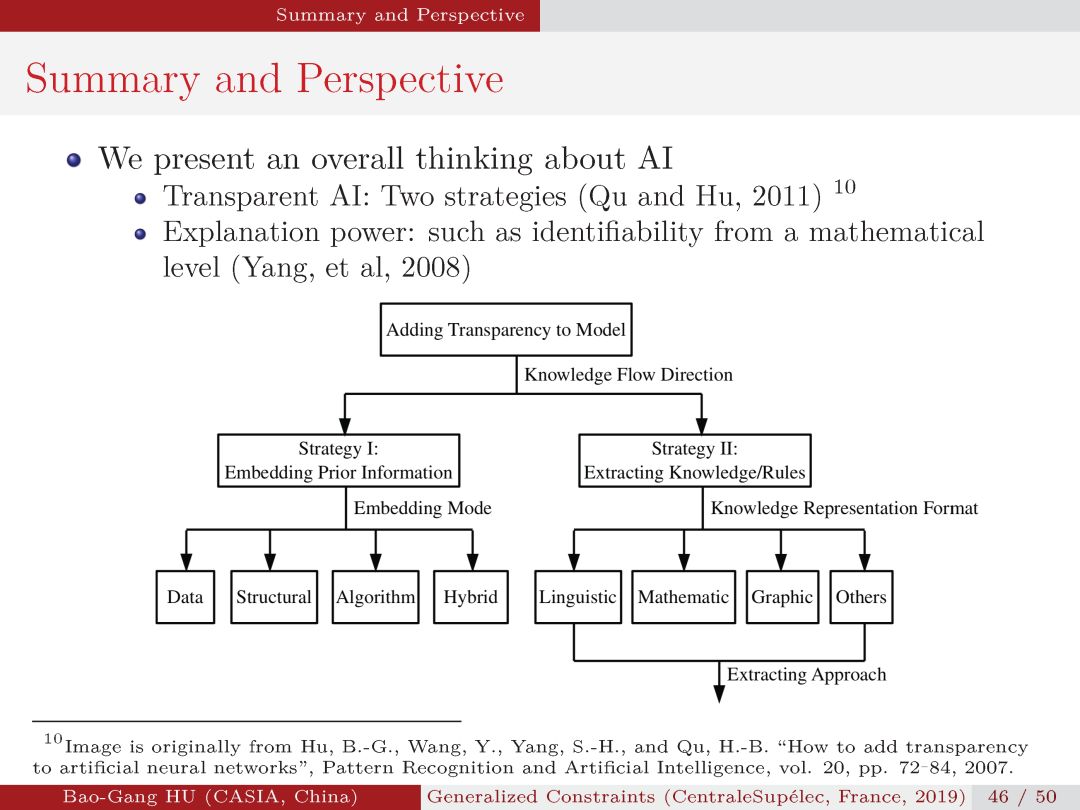

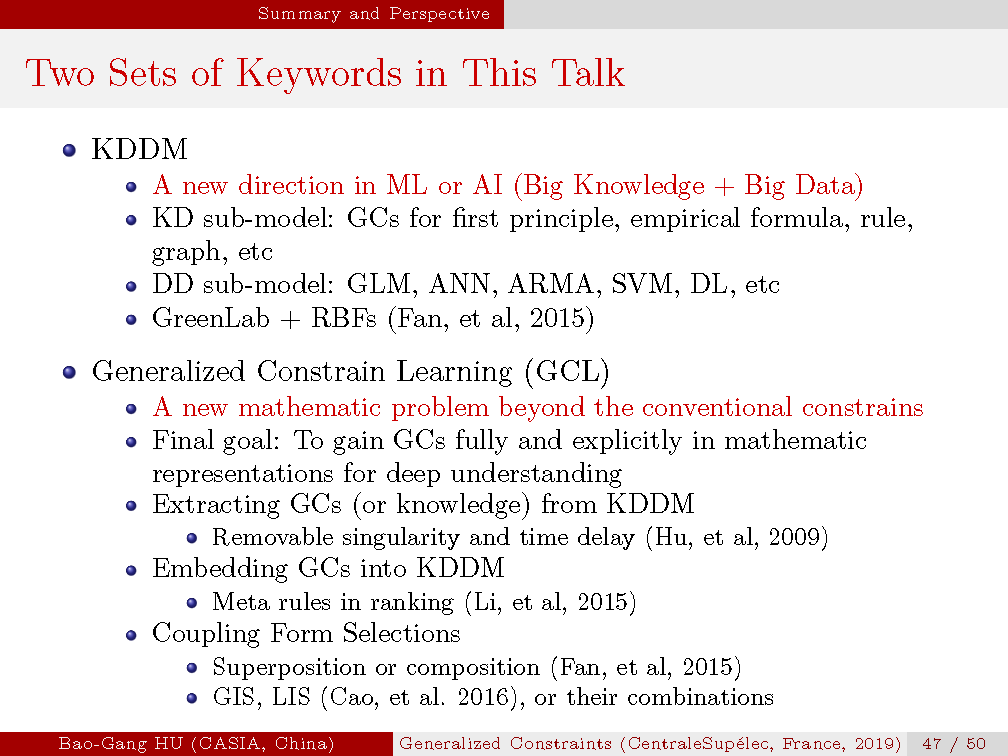

报告第47页总结了本讲座的两组关键词。第一组关键词是知识与数据共同驱动模型方法,这对应了人工智能研究中的一种学术思想。第二组关键词是广义约束学习,将上述思想转化为一种新的数学问题。讲座内容中都有提到两组关键词中相关术语的起源,并给出我们新的见解。希望在介绍森林与树叶,以及源与流之后,讲清我们学术贡献的起点与不同。

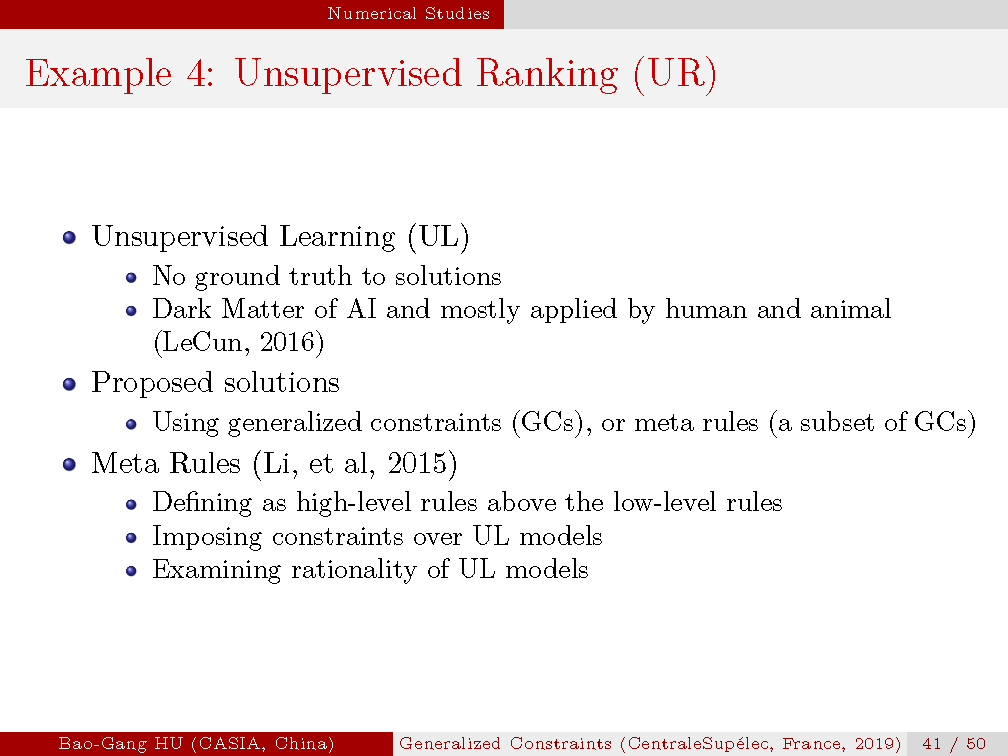

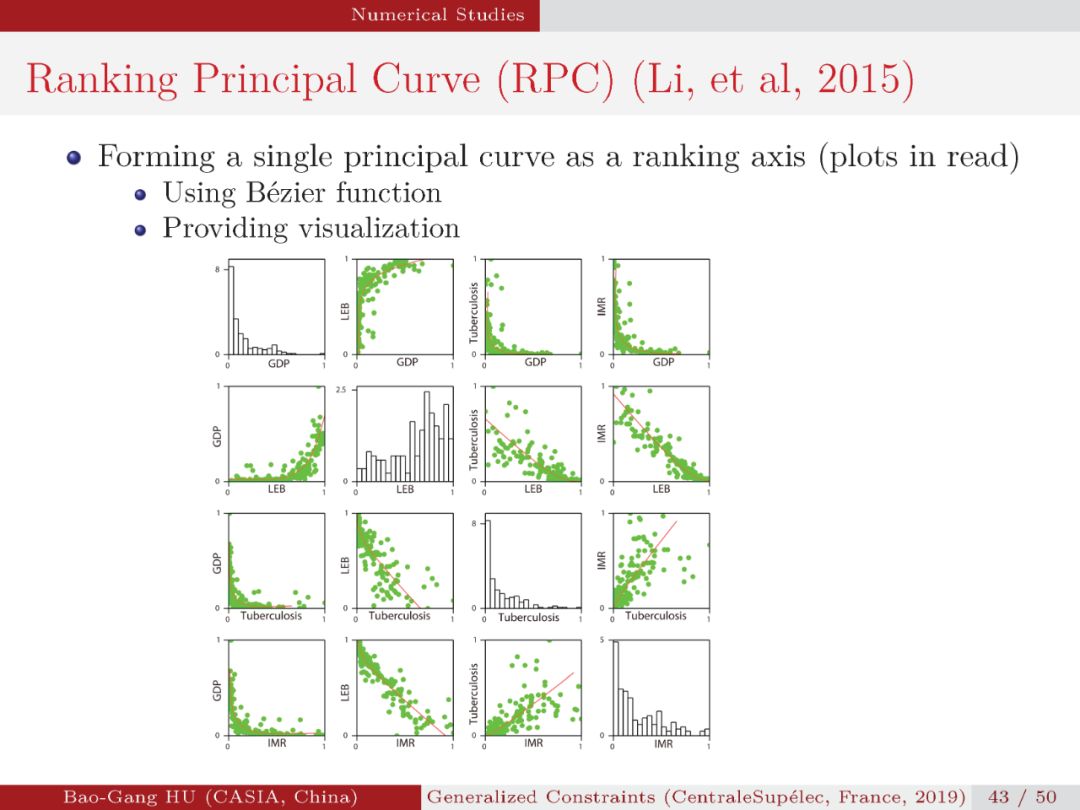

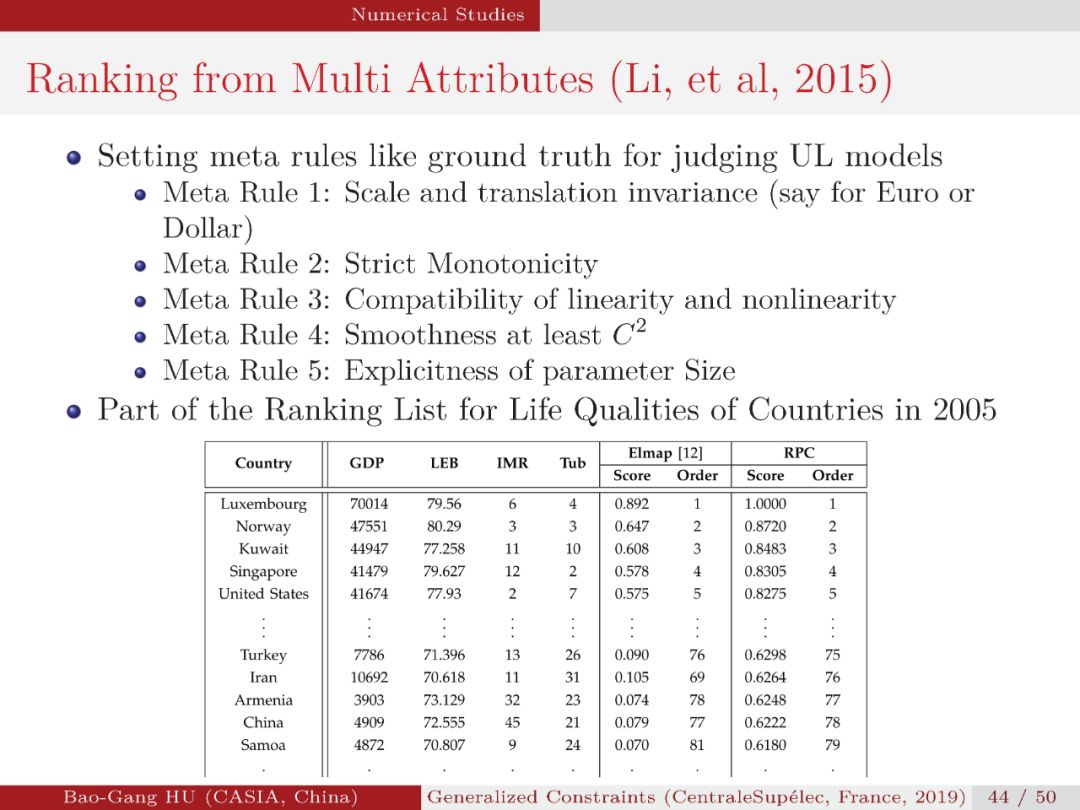

报告给出若干实例,如多属性中的无监督排序。第41页我们试图回答杨乐昆(Yann LeCun) 关于无监督学习为代表的黑物质中可能解决路径,即应用元准则或广义约束来跨越无标准答案的难点问题。要明白无监督学习更需要施加隐藏的知识于模型中,故难于有监督学习。

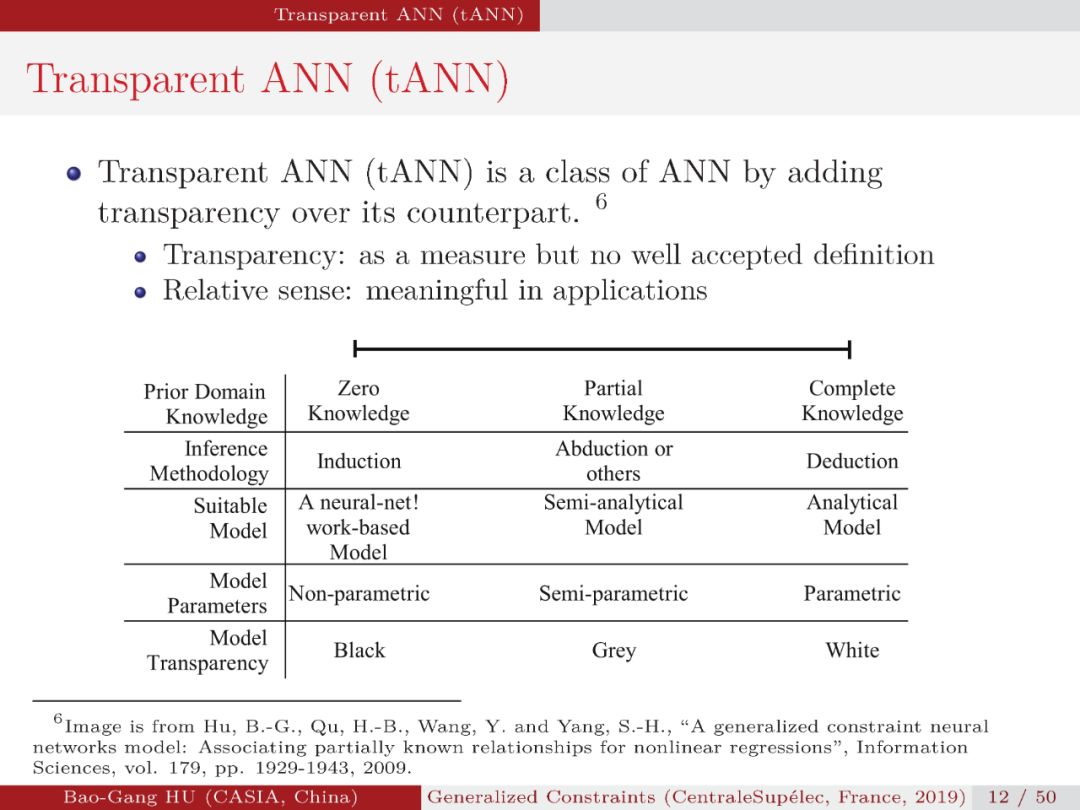

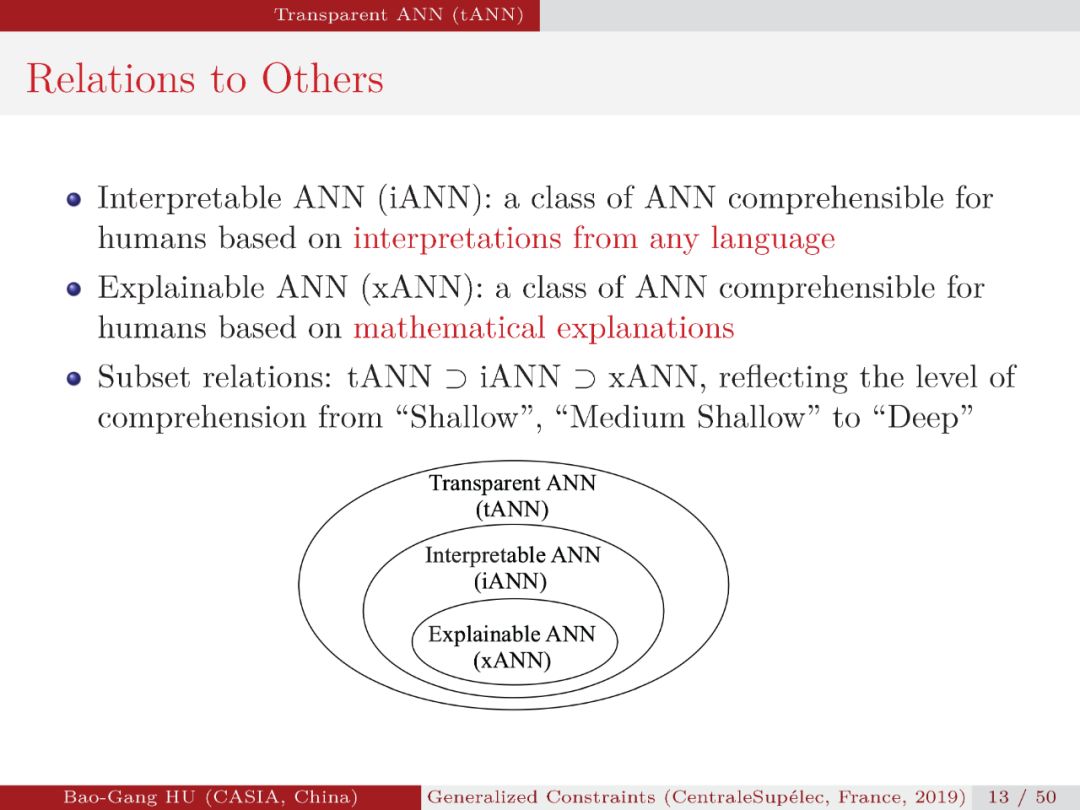

针对目前英文“Interpretable”与“Explainable”对应中文都是“可解释性”,文献中也出现混用情况,我建议将iANN与xANN分别称为“语义可解释神经元网络”与“数学可解释神经元网络”。它们分别对应了“可理解性”中本质上的不同程度。该说法也可以推广到人工智能方法上。这里也可以先想想它们与“透明度”的关联?

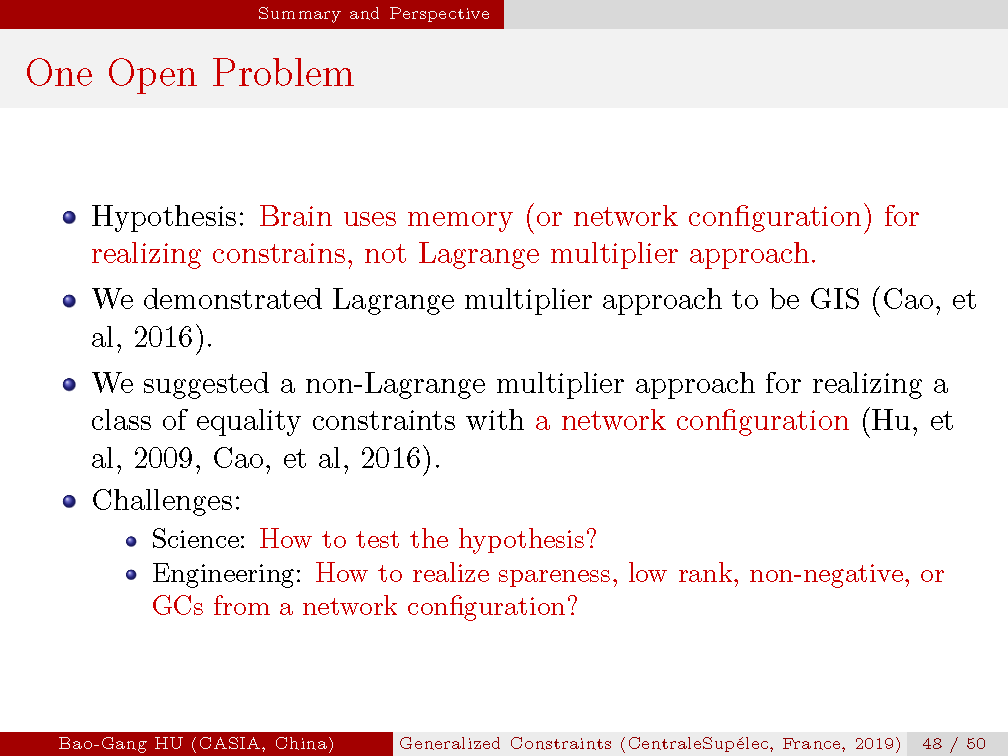

给出未来挑战的具体例子。第48页中内容即是科学问题,又有数学方面问题。如若应用网络结构方式,而非拉氏算子方式实现低秩,稀疏,非负等均束优化学习将是机器学习或类脑研究中的一大突破。

本报告有些内容是首次提出,目标是促进同行更深质疑,交流讨论,与具体突破,比如第4条中的内容。

胡包钢研究员个人主页:

http://www.escience.cn/people/hubaogang/index.html

胡包钢老师简介:

胡包钢研究员是机器学习与模式识别领域的知名学者,1993年在加拿大McMaster大学获哲学博士学位。1997年9月回国前在加拿大MemorialUniversity of Newfoundland, C-CORE研究中心担任高级研究工程师。目前为中国科学院自动化研究所研究员。2000-2005年任中法信息、自动化、应用数学联合实验室(LIAMA)中方主任。

附胡老师以前在专知上发布的精彩文章:

深度学习"理论在哪里"?再思考- 中科院自动化所胡包钢研究员参加2017年NIPS会议感想

请关注专知公众号(点击上方蓝色专知关注)

后台回复“KDDDM” 就可以获取《最新报告》的下载链接~

▌PPT

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!550+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程