【NAACL2018最佳论文】忘掉Word2vec吧!艾伦人工智能研究院新词向量学习方法,一文了解各大奖项论文

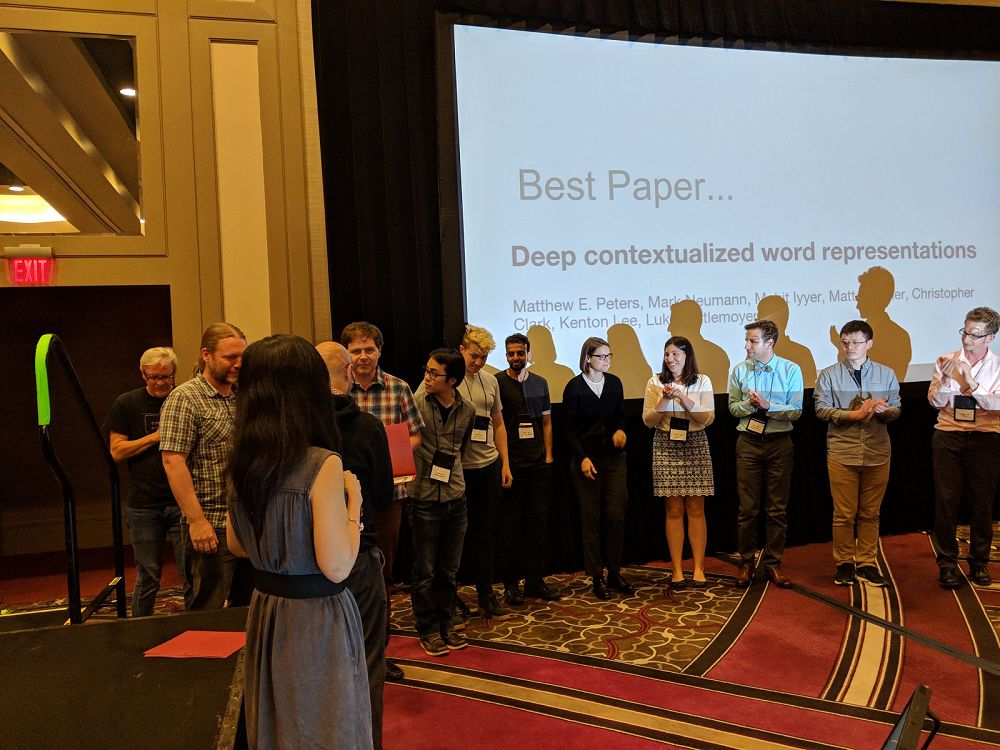

【导读】当地时间6月1日到6月6日,第十六届自然语言处理顶级会议NAACL - HLT(Annual Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies,简称 NAACL)在新奥尔良市举行,来自世界各地的NLP专家聚集在一起介绍NLP和相关领域的最新进展。大会公布了各奖项包括最佳论文奖、4 篇杰出论文(Outstanding Papers)和 3 篇时间检验奖获奖论文(Test-of-Time Award Papers),其中艾伦人工智能研究院Matthew E. Peters获得最佳论文奖。

据统计,今年共收到长论文投稿 647 篇,其中接受 207 篇,接受率 32%;短论文投稿 425 篇,接受 125 篇,接受率 29%。

NAACL 2018 各大奖项

最佳论文奖

论文:《Deep contextualized word representations》

作者:Matthew E. Peters, Mark Neumann, Mohit Iyyer, Matt Gardner, Christopher Clark, Kenton Lee, Luke Zettlemoyer

Arxiv:https://arxiv.org/abs/1802.05365

Code: https://allennlp.org/elmo

这篇论文介绍了一种新的深度上下文单词表征,它可以建模(1)单词用法中的复杂特性(比如句法和语义),和(2)这些用法在不同的语言上下文中如何变化(比如可以建模词的多义性)。这篇论文在一个大的文本语料库上预训练了一个深度双向语言模型(biLM),然后把根据它的内部状态学到的函数作为词向量。文章表明,这些学到的词表示可以很容易地加入到现有模型中,并在问答、文本蕴含、情感分析等 6 个不同的有难度的 NLP 问题中大幅提高现有的方法。文章在最后也进行了分析,表明显露出预训练模型的深度内部状态这一方法非常重要,使得后续模型可以混合不同类型的半监督信号。

作者所在机构是艾伦人工智能研究所(Allen Institute for AI),其在2013年成立于西雅图,是一家非营利组织,由微软联合创始人保罗·艾伦(Paul Allen)支持,通常被人称作AI2。

值得一提的是,ELMo已经加入到TensorFlow Hub中,方便大家调用。

https://www.tensorflow.org/hub/modules/google/elmo/1

TensorFlow Hub是TensorFlow中可重用机器学习模块的库。 机器学习模型变得越来越复杂,为了帮助开发者更好地分享和重用模型,TensorFlow 团队推出了 TensoFlow Hub,用于发布和查找可重用的模块(TensorFlow 图的独立片段)。这些模块已经包含了权重信息,而且可能已经在大数据集上预训练过,可以直接用在开发者的应用程序中。通过重用这些模块,开发者只需要在更小的数据集上训练模型,从而加快了训练速度。

Outstanding Papers

论文:《Learning to Map Context-Dependent Sentences to Executable Formal Queries》

作者:Alane Suhr, Srinivasan Iyer, Yoav Artzi

Arxiv:https://arxiv.org/abs/1804.06868

这篇论提出了一种基于上下文的模型,能够把一组交互对话中的语句映射为可执行的正式查询语句。为了把交互过程的历史也包含在内,模型中维持着一个交互对话级别的编码器,它会在每轮对话结束后更新,也能够在生成过程中拷贝之前曾经预测过的查询语句中的子序列。提出的方法结合了语句之间的显示和隐式参照。论文在 ATIS 航班规划交互上评估了模型,并取得了很好的结果。

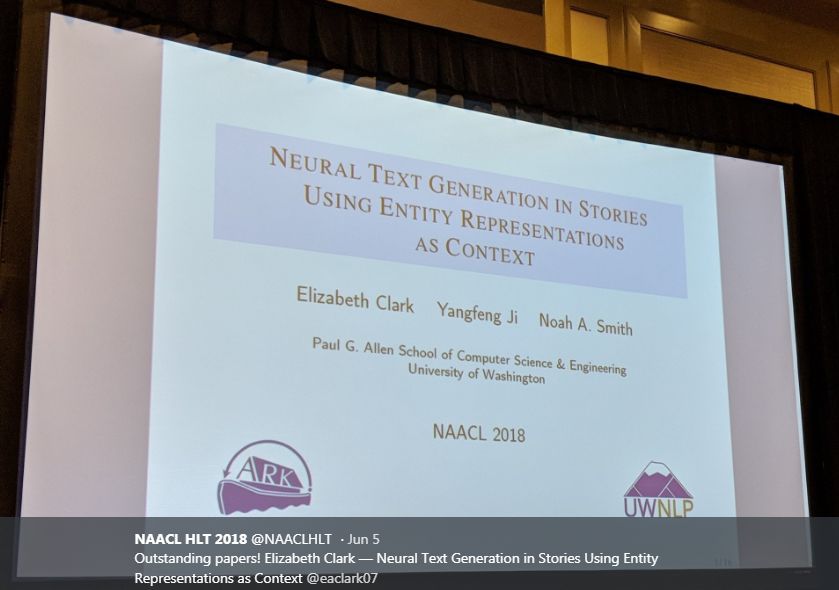

论文:《Neural Text Generation in Stories using Entity Representations as Contex》

作者:Elizabeth Clark,,Yangfeng Ji, Noah A. Smith

Arxiv:https://homes.cs.washington.edu/~eaclark7/www/naacl2018.pdf

这篇论文提出了一种神经文本生成方法,可以显式地表示文本中提到的实体。实体表征是向量的形式,它们可以随着文本处理过程更新,这些是专门为小说或者新闻故事这样的叙述性文本设计的。实验表明,建模实体的做法可以在以下两个自动化评价中取得不错的效果:提及生成(mention generation ),即模型需要选择下一个要提及的实体是什么,提及时又需要用哪个词;和在正确的下一句和来自同一个故事的更靠后的一句之间进行选择。论文也人工评估了在故事上下文中自动生成的文本,研究结果也进一步证明了想法的有效性,并为未来研究指出了方向。

论文:《Recurrent Neural Networks as Weighted Language Recognizers》

作者:Yining Chen, Sorcha Gilroy, Andreas Maletti, Jonathan May, Kevin Knight

Arxiv:https://arxiv.org/abs/1711.05408

这篇论文探究了简单的循环神经网络(RNNs)作为正式模型识别加权语言时的不同问题的计算复杂度。文章重点关注的模型是单层、ReLU 激活函数、带 softmax 的 RNN 网络,这种网络在自然语言处理应用中非常常见。实验表明对于这样的 RNN 来说,多数的问题都是不可判定的,比如一致性、等价性、最小化以及权重最高的字符串的确定性。然而,对于一致性 RNN 来说,这最后一个问题是可以判定的,虽然解决方案的长度会超出所有计算范围。如果附加条件限定字符串为多项式长度,这个问题变为 NP-complete 和 APX-hard。总结来说,这表明这种 RNN 的实际应用中近似和启发性算法是必须的。

最佳论文也是杰出论文,这里就不介绍了。

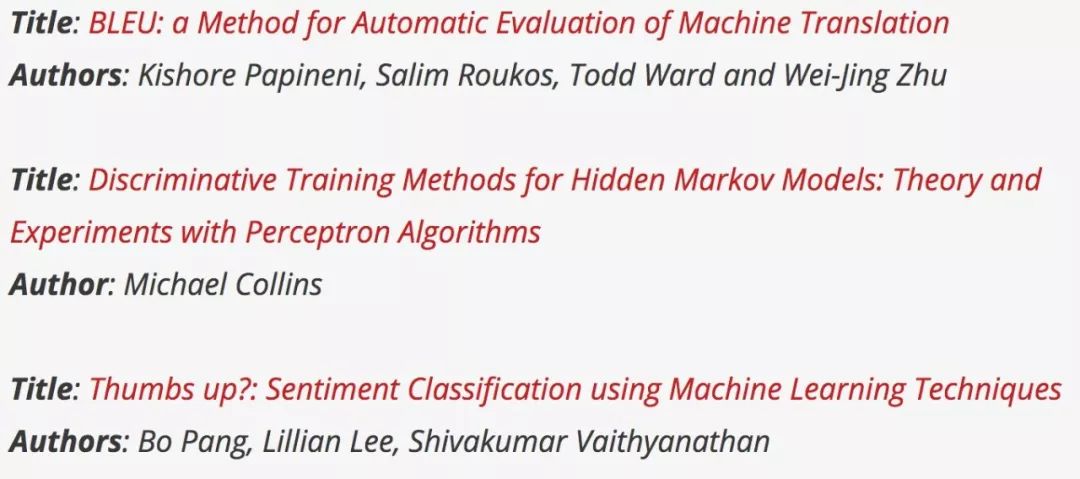

Test-of-Time Award Papers

今年NAACL 会议首次设立时间检验奖,选择范围为 2002-2012 年 ACL 的各个会议(包括 ACL, NAACL, EACL, EMNLP 和 CONLL)、workshop 以及期刊(TACL 和 CL journal)中的关于计算语言学(Computational Linguistics)的论文,意在表彰直到今天都对计算语言学领域有显著、长期影响的论文。在 NAACL 2018 区域主席提名的 19 篇无利益冲突的论文中,最终选出了如下三篇论文,这些经典值得大家仔细研读。

https://naacl2018.wordpress.com/2018/03/22/test-of-time-award-papers/

-END-

专 · 知

人工智能领域主题知识资料查看与加入专知人工智能知识星球服务群:

【专知AI服务计划】专知AI知识技术服务会员群加入与人工智能领域26个主题知识资料全集获取。欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知