【2017NIPS报告】Hinton高徒 Yee Whye Teh 《贝叶斯深度学习与深度贝叶斯学习》

点击上方“专知”关注获取专业AI知识!

【导读】12月7日,第31届神经信息处理系统大会(Neural Information Processing Systems,NIPS)邀请牛津大学统计学教授、Deepmind 研究科学家,同时也是和Hinton一起发明深度信念网络(Deep Belief Network,DBN)的Hinton高徒 Yee Whye Teh(郑宇怀)发表了题为《Bayesian Deep Learning and Deep Bayesian Learning》(贝叶斯深度学习与深度贝叶斯学习)的报告。

▌演讲人介绍

http://www.stats.ox.ac.uk/~teh/

Yee Whye Teh是牛津大学统计学教授,他于2003年获得多伦多大学计算机博士学位,师从Geroffery Hinton。获得多伦多大学的博士学位,郑怀宇在美国加州大学伯克利分校和新加坡国立大学从事博士后工作,研究方向是机器学习和计算统计学,特别是图形模型、贝叶斯非参数和表征学习。他还多次担任NIPS、ICML和AISTATS的领域主席(area chair)。

Yee Whye Teh 于2016年加入Deepmind 任研究科学家。DemisHassabis当时宣布“很高兴 Yee Whye Teh 和 Simon Osindero 加入团队,他们两人在 2006 年与 Hinton 合著论文,引发了深度学习革命!”

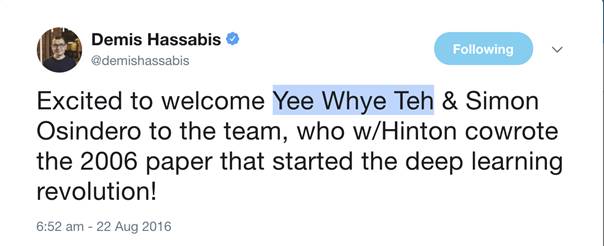

2006 年那篇论文,题目叫做 “A fast learning algorithm for deep belief nets”,《深度信念网络的一种快速学习算法》,刊于 Neural Computation,目前被引用了 7000 多次。这篇文章解决了什么问题呢?

我们知道,在一定程度内,中间隐藏层越多,网络能解决的问题就越复杂。然而,没有人知道怎么训练多层的神经网络(也即深度神经网络),因此深度神经网络一直无人问津。

直到 Hinton、Yee Whye Teh 和 Osindero 2006 年发表上述论文,提出了一个训练深度网络的方法——对每一层网络都进行预训练,然后再微调,这样学习速度就会大幅提高——终于初步解决了这一长期困扰人们的问题。

深度置信网络(DBN)在著名的手写字数据集MNIST中达到错误率1.25%的惊人成绩(SVM:1.4%,ANN:2.95%)。至此,深度学习开始登上舞台。这篇文章让人们开始注意深度网络,进而注意到深度学习,开启了新的时代,所以 Hassabis 将其称为“革命”。

▌摘要

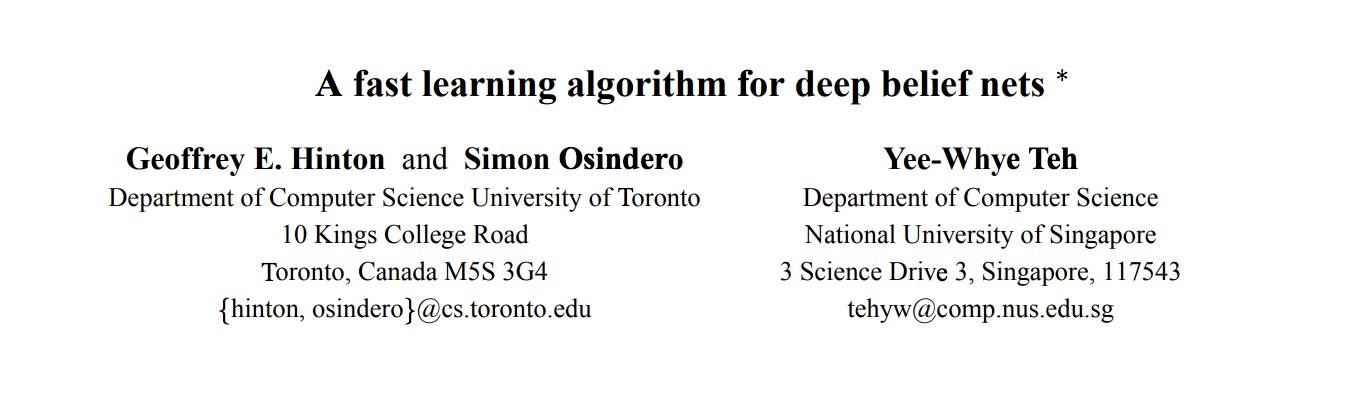

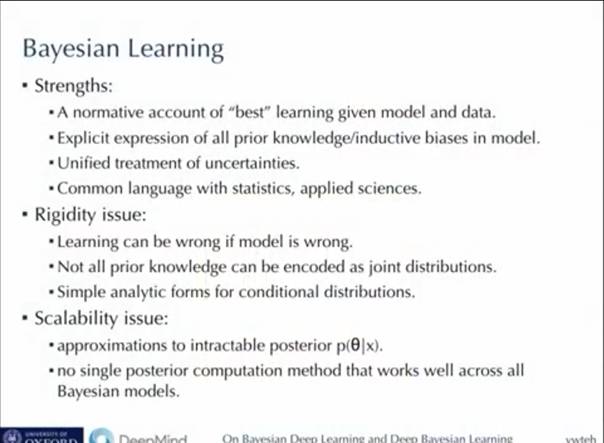

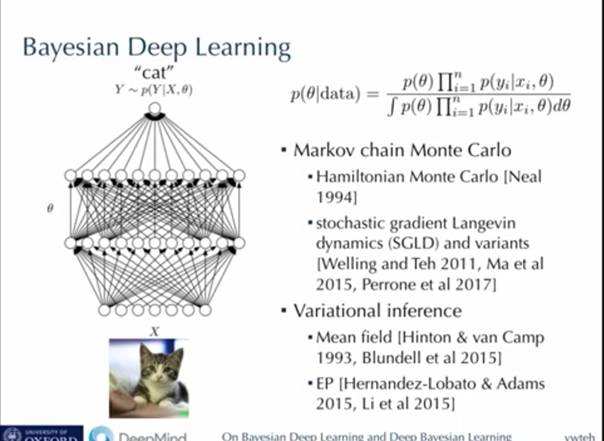

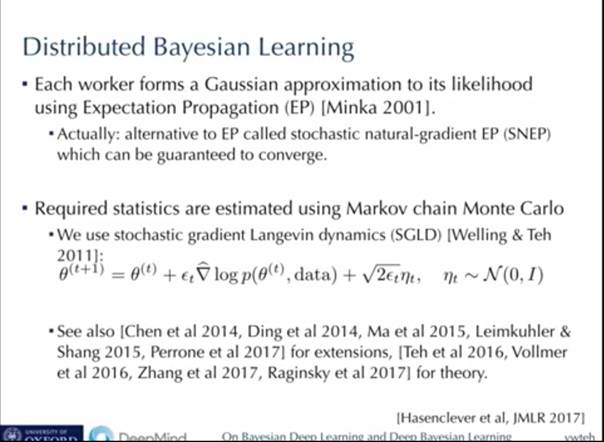

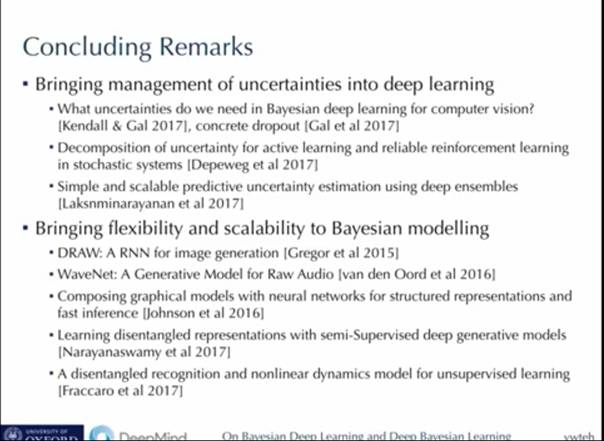

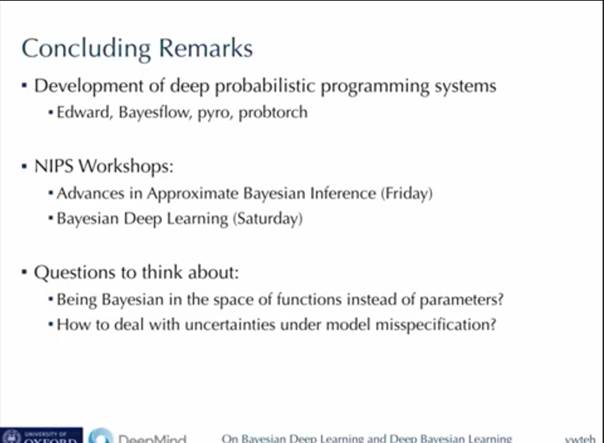

概率论和贝叶斯推理可以说是我们理解机器学习的主要理论支柱之一。 受它的影响,在过去的二十年形成了一系列成功的机器学习方法,并影响了许多这个领域研究人员的思维。 另一方面,在过去的几年里,深度学习的兴起彻底改变了这个领域,并导致了一系列现象级,具有划时代意义的成功。 在这次演讲中,我将探讨机器学习这两个观点之间的交叉,通过我参与的一些项目演示,来探索如下问题:概率统计思维如何帮助我们理解深度学习方法,或者引导我们开发出有趣的新方法? 或者相反,深度学习技术如何帮助我们开发先进的概率统计方法?

Bayesian Deep Learning and Deep Bayesian Learning

贝叶斯深度学习与深度贝叶斯学习

▌视频

附上本次报告视频

▌ppt

Yee Whye Teh 个人主页:

http://www.stats.ox.ac.uk/~teh/

-END-

专 · 知

人工智能领域主题知识资料查看获取:【专知荟萃】人工智能领域25个主题知识资料全集(入门/进阶/论文/综述/视频/专家等)

同时欢迎各位用户进行专知投稿,详情请点击:

【诚邀】专知诚挚邀请各位专业者加入AI创作者计划!了解使用专知!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请扫一扫如下二维码关注我们的公众号,获取人工智能的专业知识!

请加专知小助手微信(Rancho_Fang),加入专知主题人工智能群交流!

点击“阅读原文”,使用专知!