大规模语言模型(LLM)实际学习和使用什么算法来解决问题?

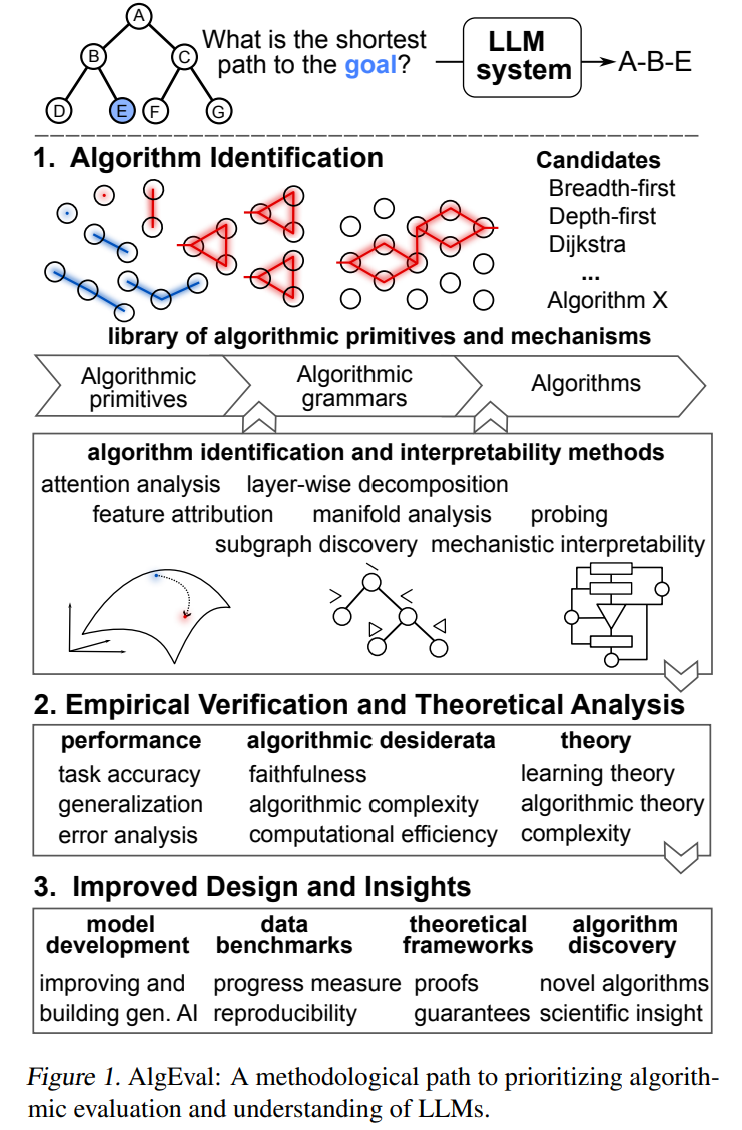

关于这个问题的研究较少,因为目前的研究重点主要集中在通过扩大规模来提高性能,从而留下了在理解新兴算法方面的理论和经验空白。本文提出了AlgEval:一个用于系统性研究LLM学习和使用的算法框架。AlgEval旨在揭示反映在潜在表示、注意力机制和推理时计算中的算法原语,以及它们的算法组合,来解决特定任务问题。

我们强调了实现这一目标的潜在方法路径,并以一个关于新兴搜索算法的案例研究为重点。我们的案例研究展示了关于候选算法的自上而下假设的形成,以及通过对注意力模式和隐藏状态的电路级分析进行这些假设的自下而上的验证。对LLM如何实际解决任务的严格系统评估为资源密集型的扩展提供了替代方案,并将研究方向重新引导向对底层计算的原则性理解。这种算法解释为人类可理解的可解释性提供了一条路径,使得对模型内部推理过程和性能衡量的理解成为可能。反过来,这也可以导致更高效的样本训练方法,提高性能,并为端到端和多智能体系统提供新的架构。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

81+阅读 · 2023年4月4日

Arxiv

145+阅读 · 2023年3月29日