摘要—近年来,视觉识别方法取得了显著进展,广泛应用于各个领域。在研究者们探索这些模型成功背后的机制时,越来越多的动力推动着它们在关键领域,如自动驾驶和医疗诊断中的应用,以便更好地诊断故障,这促进了可解释性研究的发展。本文系统回顾了现有的视觉识别模型可解释性研究,并从以人为中心的视角提出了一种方法分类法。该分类法基于意图、对象、展示和方法学,将可解释的识别方法进行分类,从而为这些XAI方法建立了一套系统且连贯的分组标准。此外,我们总结了评估指标的需求,并探讨了近期技术(如大规模多模态模型)带来的新机遇。我们旨在组织现有领域的研究,并激发未来对视觉识别模型可解释性进行的深入探索。

关键词—XAI,解释性人工智能,可解释性,视觉识别。

1 引言

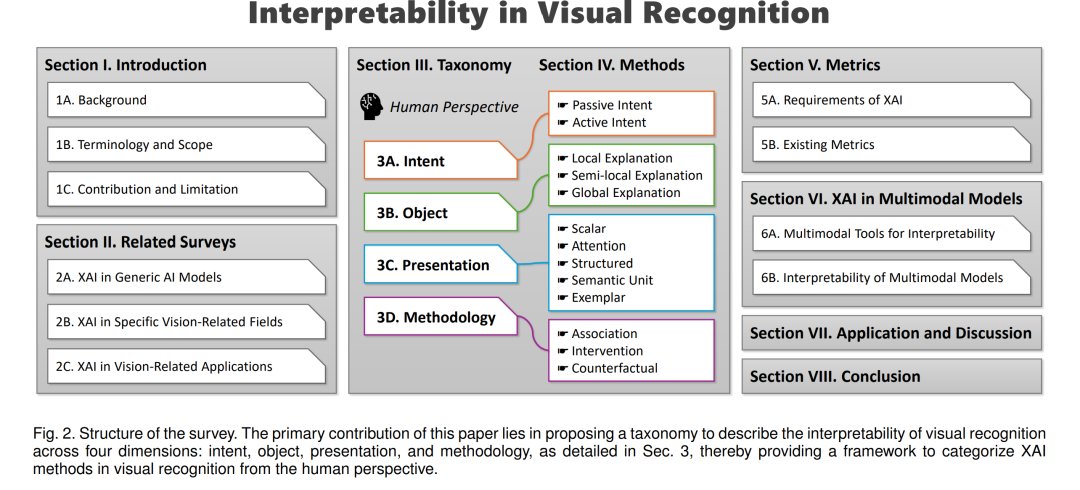

视觉识别方法经历了广泛的发展,并已成功应用于多个领域。此外,研究人员越来越多地探讨这些系统有效性的潜在机制,这一领域被称为可解释性研究。本文系统回顾了可解释视觉识别方法,旨在帮助研究人员和开发者,甚至是那些没有可解释性领域背景的人,直观地理解各种可解释视觉识别方法的特点。

1.1 背景

视觉识别模型的快速发展和应用彻底改变了多个领域,如医疗诊断、自动驾驶和监控系统。然而,尽管这些模型在实践中取得了成功,它们通常作为“黑箱”运行,几乎没有提供任何关于如何从输入推导出具体输出的洞察。随着这些模型在决策过程中扮演着越来越重要的角色,理解它们预测背后机制的需求变得至关重要。 这一需求促使了解释性人工智能(XAI)这一领域的兴起,XAI致力于解释和阐明AI算法的内部工作机制,特别是那些驱动视觉识别技术的复杂深度学习模型。XAI通过揭示模型行为和决策边界的可视化方法,旨在减少这些模型的“黑箱”效应。以往的研究表明,除了直接帮助诊断模型故障外,可解释性显著增强了终端用户对AI模型的信任,并促进了更有效的人机交互。

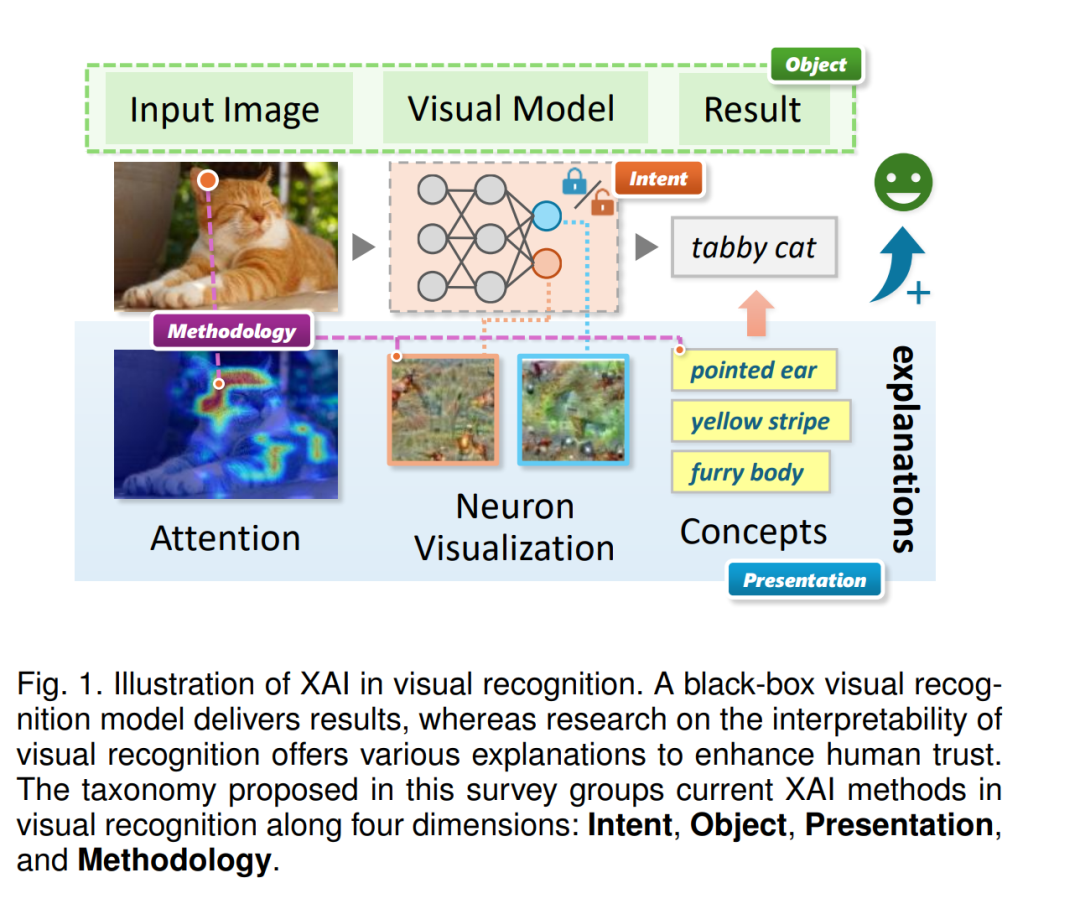

具体而言,视觉识别是多模态系统中视觉组件的基础任务,其准确性和鲁棒性对于后续更高层任务的性能至关重要。如图1所示,视觉识别模型采用相对标准化的处理流程,这使得它们与其他AI模型有所区别:它们接受视觉信号作为输入,并生成概念或类别标签作为输出。在当今的应用中,开放词汇识别已成为主流需求,这突显了视觉识别与文本模态的结合,后者是主流人机交互的主要模态。输入和输出的多样性显著增加了视觉识别领域中XAI研究的复杂性。

例如,在图1中,现有技术如激活映射、神经元可视化和概念瓶颈分别提供了区域、特征和语义重要性的分析,从而为用户提供了一个可以理解的预测依据。然而,以前的研究指出,无论是提供解释,还是提供何种解释,都可能对人类信任产生正面或负面的影响。视觉识别模型中的可解释性复杂性给研究人员带来了巨大的挑战,使他们难以全面理解这一领域的发展,这促使本文系统回顾了视觉识别的XAI的最新进展和持续研究。

1.2 术语和范围

XAI是“解释性人工智能”(eXplainable Artificial Intelligence)的常用缩写,指的是一组用于使AI模型的输出和操作对人类可理解的过程和方法。目前,研究XAI的动机在于,大多数未专门设计为具备可解释性的AI模型都是黑箱模型;这些模型的结构过于复杂,使得人类难以理解它们的工作机制。因此,可解释性研究可以分为两种方法:一种是通过可视化、探测和扰动等技术,理解已训练的黑箱模型的工作细节,而不对其进行修改;另一种是在模型架构设计中引入可解释模块,从而实现内在可解释性。在一些研究中,前者被称为“可解释性”,后者被称为“可解释性”。然而,大多数XAI研究并未区分这两个术语;因此,本文也将它们视为等同的。在强调它们的差异时,会使用更明确的术语,如前者的后验方法和后者的自解释模型。 本文主要研究视觉识别模型,特别是那些用于识别或理解图像中的物体的AI模型。通常,这些模型接受图像 x 作为输入,通过骨干特征提取器 f 提取图像特征 z,并使用分类器头 g 生成识别结果 yˆ。目前,主流的视觉识别模型可解释性研究主要集中在图像特征 z 和分类器 g 上,而关于骨干 f 的研究仍处于早期阶段,主要聚焦于其顶层,因为这些层更可能包含语义信息。对于后验方法和自解释模型,提供给研究人员、开发者或用户的解释通常呈现在识别流程之外,并且种类繁多。由于视觉任务之间的耦合性,基于定位的可解释性研究经常扩展到检测和分割领域,而面向语义和自然语言交互的目标本质上与多模态技术紧密相关。因此,本文也将简要讨论这些领域中的少数相关工作。

1.3 贡献与局限性

本文与以往的工作相比,有两个主要的不同点:它专注于针对视觉识别模型的XAI研究,并从多维、以人为中心的视角系统地组织相关的XAI方法。由于XAI是一个广泛的研究领域,过于宽泛的综述可能缺乏聚焦性和实际应用性。通过集中于视觉识别任务,本文以更详细且面向任务的方式对相关方法进行分类,从而增加了综述的实用性。此外,由于可解释性本质上是为了服务于人类用户,因此从人的角度组织方法既自然又合适。 本文提出的多维框架使得用户能够高效理解视觉识别XAI的最新进展,并能迅速定位适合特定应用的方法。然而,将这一分类法扩展到涵盖更广泛的视觉任务仍面临若干挑战,包括需要适应不同模态和多变的背景。解决这些复杂性需要进一步的研究,以有效地调整和扩展所提出的分类法。