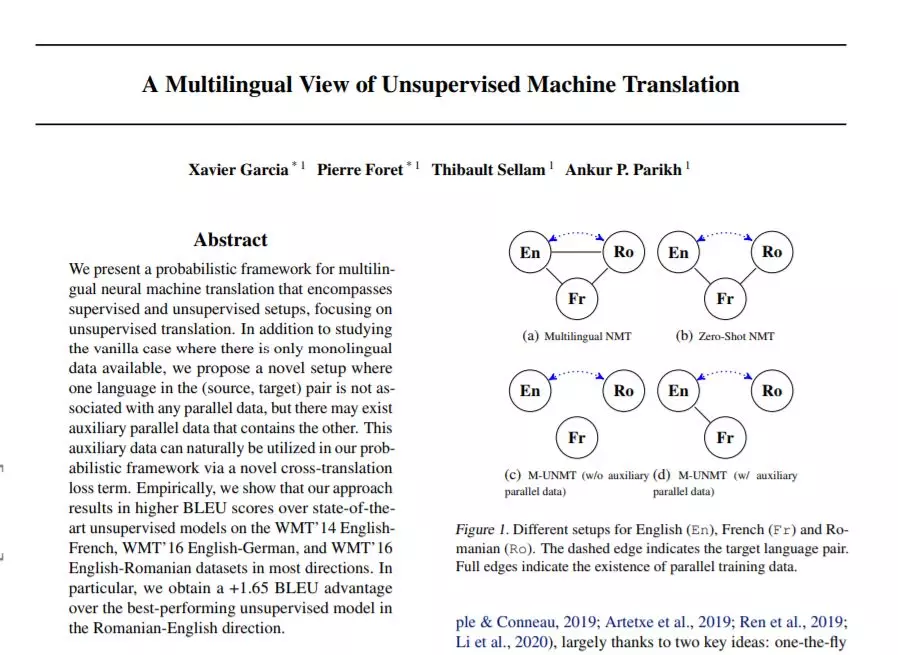

我们提出了一个多语言神经机器翻译的概率框架,它包括监督和非监督设置,重点是无监督翻译。除了研究只有单语数据可用的基本情况外,我们还提出了一种新的设置,即(源、目标)对中的一种语言不与任何并行数据相关联,但可能存在包含另一种语言的辅助并行数据。通过一个新的交叉翻译损失项,这些辅助数据可以很自然地用在我们的概率框架中。经验表明,我们的方法在大多数方向的WMT'14英-法、WMT'16英-德、WMT'16英-罗数据集上,比最先进的无监督模型获得更高的BLEU分数。特别是,我们获得了+1.65 BLEU的优势,在罗马尼亚-英国方向的最佳表现的无监督模式。

成为VIP会员查看完整内容

相关内容

专知会员服务

19+阅读 · 2020年4月25日

专知会员服务

20+阅读 · 2020年2月12日

专知会员服务

11+阅读 · 2019年12月28日