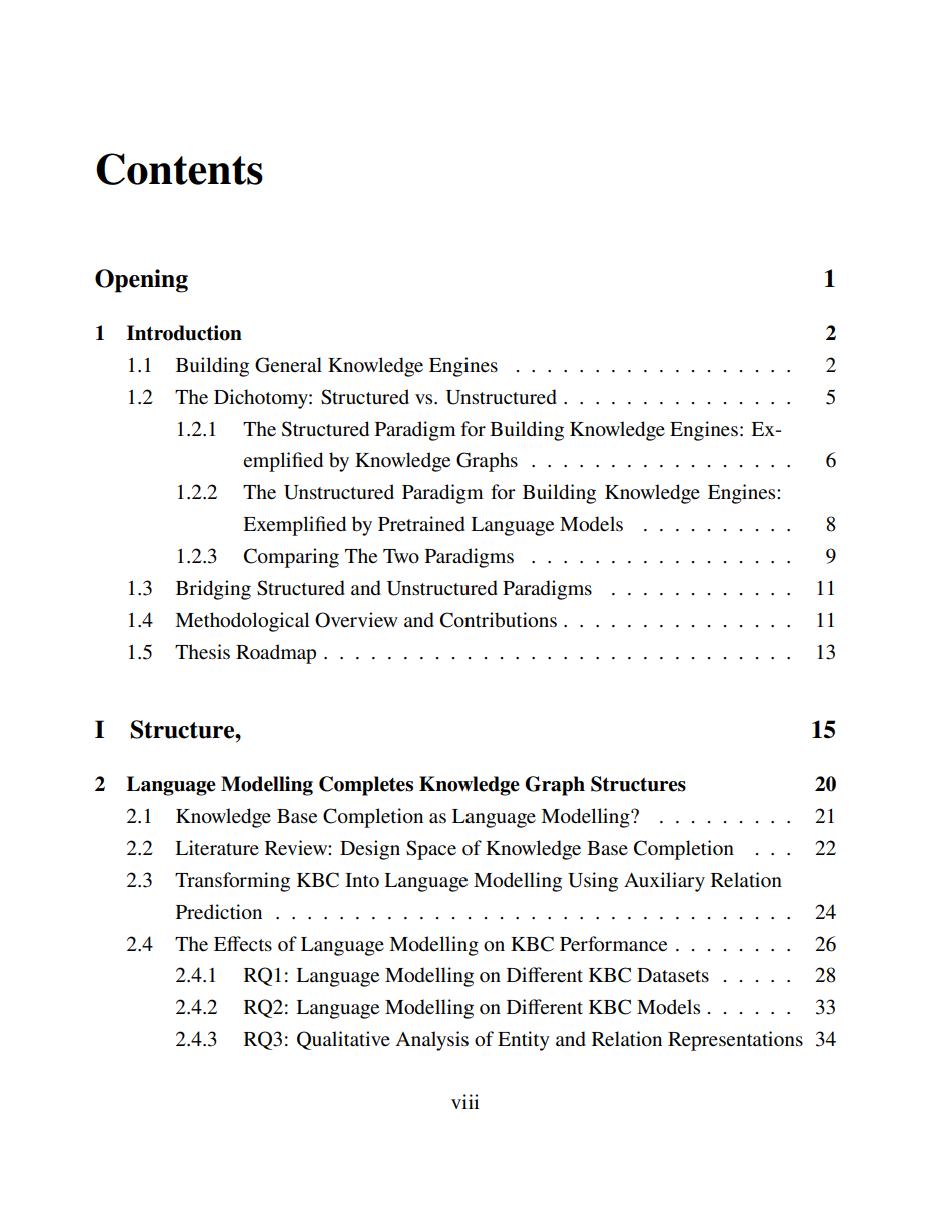

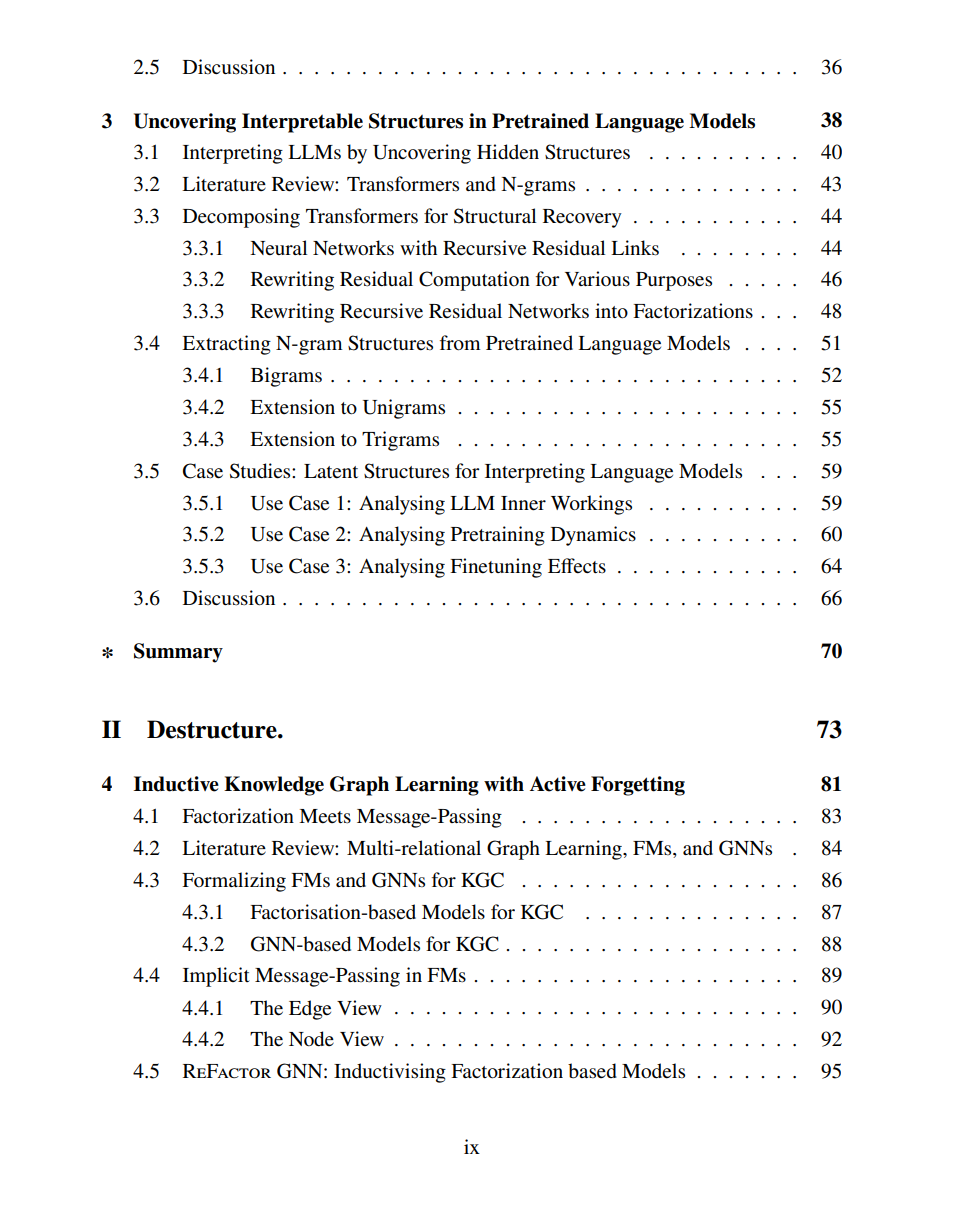

自然语言处理中的知识引擎构建长期受到两种看似迥异的范式塑造:一种以结构为基础,另一种依赖大规模的非结构化数据。结构化范式利用预定义的符号交互(如知识图谱)作为先验,并设计模型以捕捉这些先验;而非结构化范式则聚焦于通过不断扩展数据规模和模型规模来扩展 Transformer 架构,如当今的大型语言模型所展现的趋势。尽管二者路径分歧明显,本文旨在建立概念上的联系,以弥合这两类范式之间的鸿沟。 本文识别出两条关键联系: * 结构的形成(Structure Formation):自监督目标(如语言建模)在模型计算中诱导出结构化模式,这一现象贯穿于两类范式。此类目标支持数据图的重建,在结构化范式中有助于链路预测,在非结构化范式中则通过提取 n-gram 模式提升可解释性。 * 为可塑性而解构(Destructure for Plasticity):嵌入(embeddings)是两类范式中一个关键但常被忽视的组成部分。嵌入在训练过程中缓存了符号上的消息传递计算。然而,过度缓存可能阻碍模型的泛化能力。通过“嵌入遗忘”(embedding forgetting)——即周期性地重置嵌入权重,可以提升模型的可塑性,使其能够泛化至此前未见的场景,如新谓词或新语言。

这两种联系构成了发展通用知识引擎的新“配方”:其指导原则不仅包括对已见符号交互的建模,也涵盖对未见符号交互的建模,而后者在现有研究中相对欠缺。高效建模已见部分需要结构的形成,无论数据本身是否具备结构性;而建模未见部分则受益于对已学缓存的主动解构,从而提升鲁棒性与适应性。 通过架起这两类范式之间的桥梁,本文确立了结构与解构作为设计知识引擎的互补力量,使其能够支撑透明、可控且具有适应性的智能系统。

成为VIP会员查看完整内容

相关内容

Arxiv

217+阅读 · 2023年4月7日