理解大模型中的“幻觉”,这篇论文及时解读。

虽然大型语言模型(LLMs)在各种下游任务中展示出了卓越的能力,但一个重要的关注点是它们表现出幻觉的倾向:LLMs偶尔会生成与用户输入不符、与先前生成的上下文相矛盾或与已建立的世界知识不一致的内容。这种现象对LLMs在现实世界场景中的可靠性构成了重大挑战。在本文中,我们对最近关于检测、解释和减轻幻觉的努力进行了调研,重点关注LLMs所带来的独特挑战。我们提出了LLM幻觉现象和评估基准的分类,分析了现有的旨在减轻LLM幻觉的方法,并讨论了未来研究的潜在方向。

https://www.zhuanzhi.ai/paper/61ebe9c5007cf1373b900452ad52f0ae

1. 引言

大型语言模型(LLMs),特别以其庞大的参数数量为特点,已经成为自然语言处理(NLP)和人工智能发展的有前途的基石。通过适当的对齐技术,如监督微调(SFT;Zhang等,2023b)和强化学习来自人类反馈(RLHF;Ouyang等,2022;Fernandes等,2023),最近的LLMs(OpenAI,2023a;Touvron等,2023b;OpenAI,2023b等等)展现出了在解决各种下游任务中的强大能力。

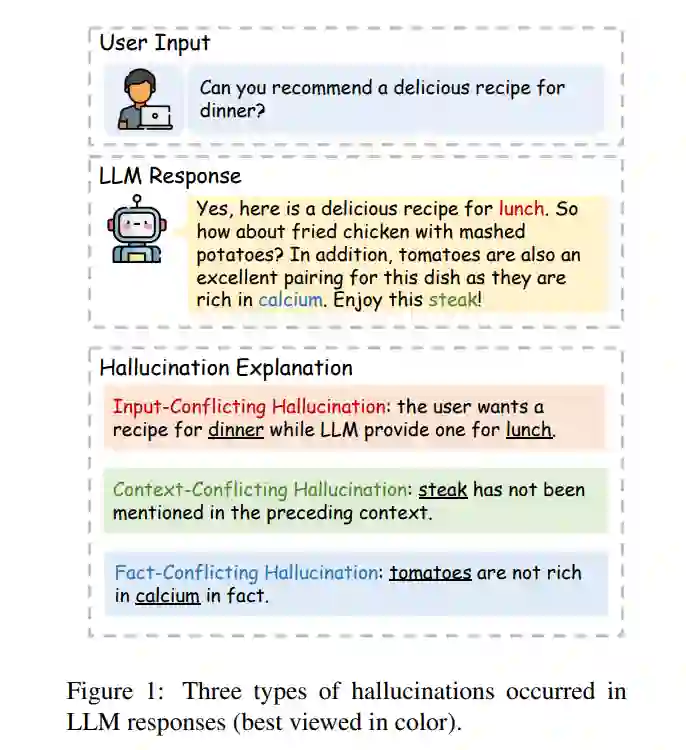

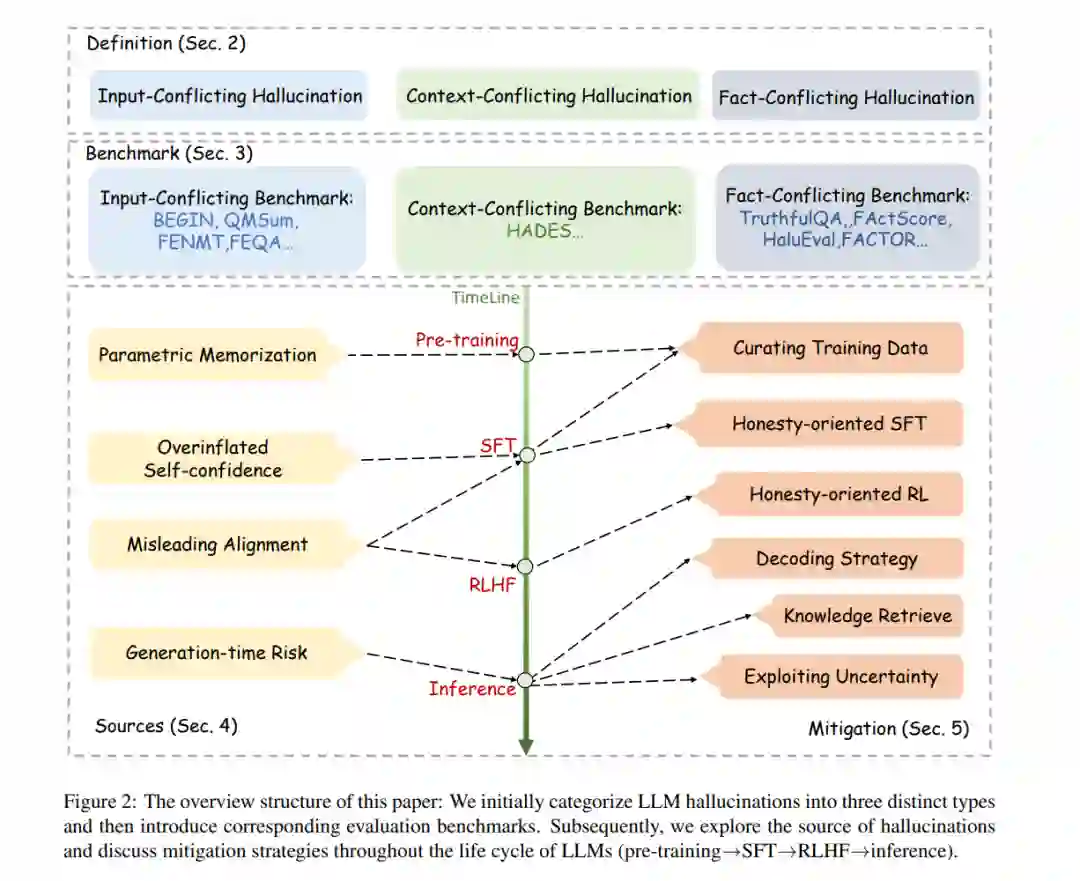

然而,正如图1所示,LLMs尽管取得了显著的成功,但偶尔会产生看似合理但与用户输入(Adlakha等,2023)、先前生成的上下文(Liu等,2022)或事实知识(Min等,2023;Muhlgay等,2023;Li等,2023a)偏离的输出,这种现象通常被称为幻觉,严重损害了LLMs在现实世界场景中的可靠性。例如,LLMs有可能制造出错误的医学诊断或导致实际生活风险的治疗计划(Umapathi等,2023)。 虽然在传统的自然语言生成(NLG)环境中的幻觉问题已经得到广泛研究(Ji等,2023),但在LLMs领域理解和解决幻觉问题面临着独特的挑战,这些挑战包括: 1. 巨大的训练数据:与为特定任务精心策划数据不同,LLM的预训练使用来自网络的数万亿令牌,难以消除虚构、过时或有偏见的信息; 2. LLM的多功能性:通用型LLM应该在跨任务、跨语言和跨领域设置中表现出色,这对于全面评估和减轻幻觉问题构成了挑战。 3. 错误的难以察觉性:作为其强大能力的副产品,LLMs可能生成最初看似高度合理的虚假信息,这使得模型甚至人类难以检测幻觉。 此外,RLHF过程(Ouyang等,2022),模糊的知识边界(Ren等,2023)以及LLMs的黑盒属性(Sun等,2022)也增加了在LLMs中检测、解释和减轻幻觉的复杂性。针对上述挑战,最近涌现出了大量前沿研究,这极大地激发了我们编写这份综述的动力。我们按照以下方式组织本文,如图2所示。首先,我们介绍LLMs的背景,并提供我们对LLMs中幻觉的定义(§2)。接下来,我们介绍相关的基准和度量标准(§3)。随后,我们讨论LLMs幻觉的潜在来源(§4),并深入审查最近解决这个问题的工作(§5)。最后,我们提供展望未来的观点(§6)。我们将持续更新相关的开源材料,可以在https://github.com/HillZhang1999/llm-hallucination-survey 上访问。

2 LLM时代的幻觉

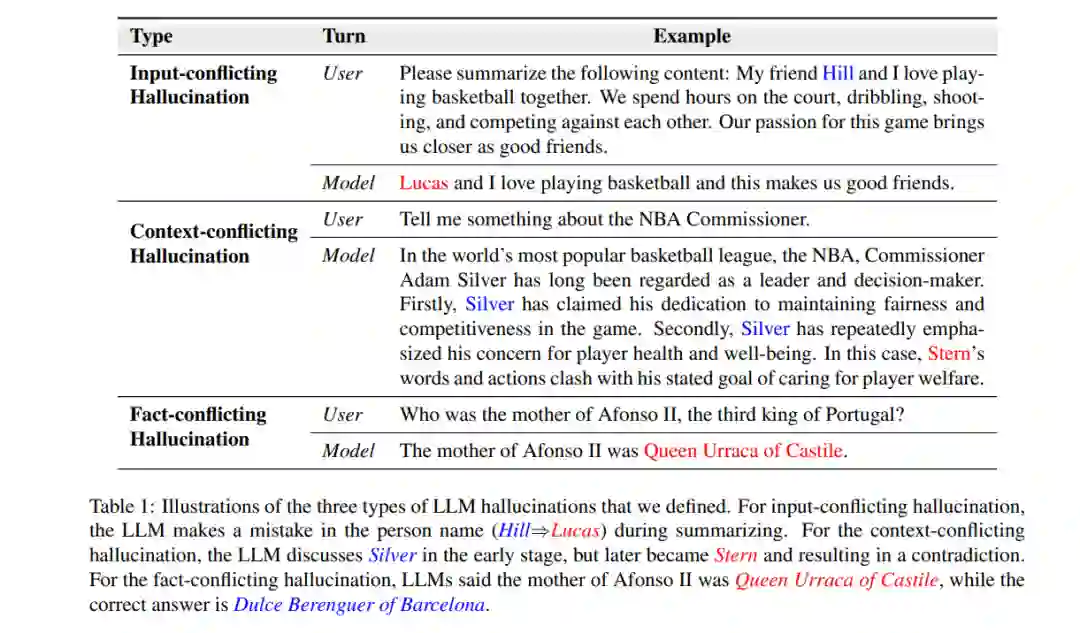

在这一部分,我们首先回顾LLMs的历史(§2.1)。接下来,我们通过将其分为三个子类别来提出我们对LLM幻觉的定义(§2.2)。此外,我们讨论LLMs中幻觉的独特挑战(§2.3),并将幻觉与LLMs领域经常遇到的其他普遍问题进行比较(§2.4)。 虽然LLMs已经展示出了卓越的性能,但它们在实际应用中仍然不可避免地遇到不同的问题,其中幻觉是其中最重要的问题之一。在LLM出现之前,幻觉这个术语已经在NLP社区广泛采用,通常指的是生成与提供的源内容毫无意义或不忠实的内容(Ji等,2023)。 我们认为,由于LLMs的多功能性,这个定义似乎已经大大扩展。为此,我们将LLMs的背景下的幻觉分类如下:- 输入冲突幻觉,即LLMs生成与用户提供的源输入不符的内容;- 上下文冲突幻觉,即LLMs生成与其自身先前生成的信息冲突的内容;- 事实冲突幻觉,即LLMs生成不忠实于已建立的世界知识的内容。我们在表1中为每种类型的幻觉提供了示例,并在下面详细讨论它们。

3 评估LLM幻觉

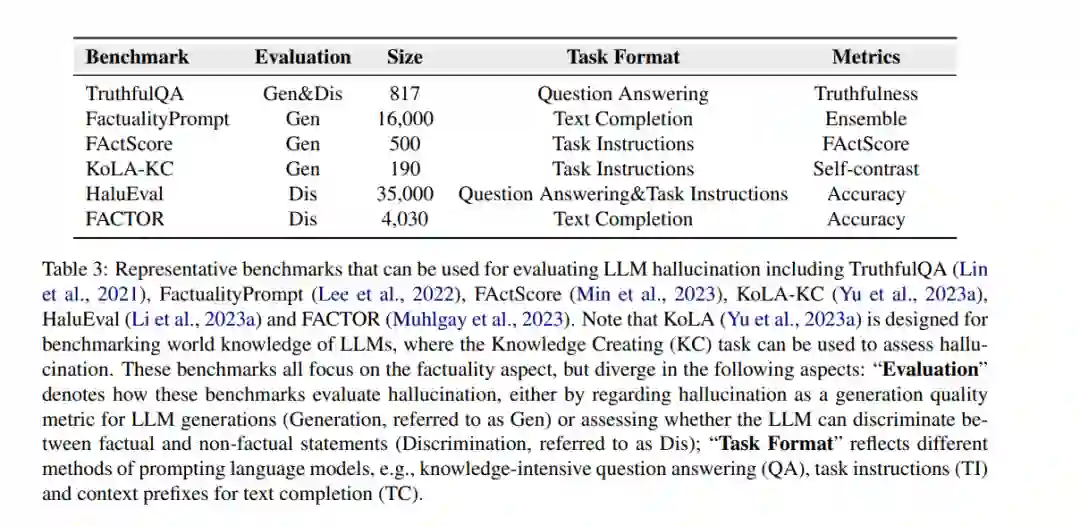

先前的研究主要集中在评估特定的自然语言生成任务中的幻觉,如机器翻译、对话生成、问答和文本摘要。这些工作主要关注输入冲突幻觉,由于给定源文本,相对容易让人类用户识别,如表1所示。最近,在传统的NLG任务中研究这种类型的幻觉取得了显著的进展。然而,在LLMs设置中评估它们变得更加具有挑战性,因为LLM生成通常是自由形式和常常是长篇的。 至于上下文冲突幻觉,Cui等人(2021)和Liu等人(2022)评估了模型在BERT(Devlin等人,2019)进行空白填充时引入的上下文冲突的识别能力。今天,大多数基准评估LLMs的事实冲突幻觉,即它们生成事实错误的倾向(Lin等,2021;Lee等,2022;Min等,2023;Yu等,2023a;Li等,2023a;Muhlgay等,2023)。这被认为是LLMs中的一个关键问题,因为用户很难识别,并带来了现实生活中的风险。在接下来的章节中,我们将分别回顾现有的基准数据集和常用的评估指标。

LLM 幻觉来源

在本节中,我们旨在探讨可以在LLMs内部引发幻觉的各种因素。我们确定了跨足LLMs生命周期不同阶段的四个主要来源。

-

LLMs缺乏相关知识或内化了错误的知识。在预训练阶段,LLMs从大量的训练数据中积累了大量知识,这些知识存储在它们的模型参数中。当要求回答问题或完成任务时,如果LLMs缺乏相关知识或已经内化了来自训练语料库的错误知识,它们通常会表现出幻觉。例如,一些研究发现,LLMs有时会误解偶然的相关性,比如位置接近或高度共现的关联,将其视为事实知识。此外,人类生成的语料库中也存在幻觉(如过时、有偏见或虚构的表达),LLMs容易复制或甚至放大这种幻觉行为。

-

LLMs有时会高估自己的能力。一些研究旨在了解语言模型是否能够评估其响应的准确性并识别其知识边界。但对于非常大的LLMs,正确和错误答案的分布熵可能相似,这表明LLMs在生成不正确的答案时与生成正确答案一样自信。这种过度自信可能导致LLMs以不必要的确定性制造答案。

-

问题对齐过程可能误导LLMs进入幻觉。LLMs通常在预训练后经历对齐过程,在这个过程中,它们接受了进一步的培训,以使其响应与人类偏好一致。然而,当LLMs在对齐过程中接受针对它们在预训练阶段尚未获得的知识的指示时,实际上是一种不对齐过程,鼓励LLMs产生幻觉。此外,有时LLMs可能生成有利于用户观点而不是提供正确或真实答案的响应,这也可能导致幻觉。

-

LLMs采用的生成策略存在潜在风险。今天最先进的LLMs以顺序方式生成响应,一次输出一个令牌。有研究发现,LLMs有时会过分坚持早期的错误,即使它们意识到这是不正确的。换句话说,LLMs可能更喜欢为了自身一致性而堆积幻觉,而不是从错误中恢复。这被称为幻觉堆积现象。此外,一些研究强调,基于采样的生成策略,如top-p和top-k,引入的随机性也可能是幻觉的潜在来源。

减轻LLM幻觉

在这一部分,我们对近期关于减轻LLM幻觉的研究进行了广泛的回顾。为了使结构清晰,我们根据这些减轻工作在LLM生命周期内的应用时间对其进行分类。

在预训练期间减轻幻觉主要集中在预训练语料库的策划上。鉴于现有预训练语料库的庞大规模,当前的研究主要采用简单的启发式规则来进行数据选择和过滤。一个潜在的探索方向可能是制定更有效的选择或过滤策略。

在SFT(自监督微调)阶段,构建训练数据是减轻幻觉的一种方法。由于SFT数据的数量是可接受的,它们可以由人类专家进行手动策划。最近,我们进行了初步的人工检查,观察到一些广泛使用的合成SFT数据,如Alpaca(Taori等,2023年),由于缺乏人工检查,包含了相当数量的幻觉答案。这在研究人员试图基于自我指导(Wang等,2023c年)构建SFT数据集时需要特别注意。先前的工作还指出,SFT过程可能会无意中引入幻觉,因为它迫使LLMs回答超越其知识界限的问题。一些研究人员提出了以诚实为导向的SFT作为解决方案。然而,我们认为这种方法存在两个主要问题。首先,它在面对分布之外(OOD)案例时展现出有限的泛化能力。其次,诚实样本的注释只反映了注释者的不胜任和不确定性,而不反映LLMs的真实知识界限,因为注释者不知道LLMs的真实知识界限。这些挑战使得在SFT阶段解决这个问题不够理想。

强化学习可以引导LLMs探索其知识边界,使其能够拒绝回答超出其能力范围的问题,而不是编造不真实的回答。然而,我们注意到这种方法也存在独特的挑战。例如,由于有益与诚实之间的权衡失衡,经过RL调整的LLMs可能表现出过于保守的特点(Ouyang等,2022年)。表9中的例子说明了这一点。正如在这种情况下所观察到的,ChatGPT倾向于过于谨慎,不提供已经知道的明确答案,正如在另一个对话转折中所证实的那样。这可能归因于奖励函数的不合理设计或奖励模型的培训数据质量不佳。我们希望未来的研究可以考虑解决这些问题。

在推理期间,设计解码策略以减轻LLMs中的幻觉通常是以插拔方式进行的。因此,这种方法易于部署,对于实际应用非常有前景。然而,对于这种方法,大多数现有研究需要访问标记级输出概率,而当前LLMs的相当数量只能通过有限的API(例如ChatGPT)返回生成的内容。因此,我们鼓励未来研究在这个方向上探索更严格的黑盒设置内进行研究。

利用外部知识来减轻LLMs中的幻觉具有几个优点。首先,这种方法避免了修改LLMs的需要,使其成为一种即插即用且高效的解决方案。其次,它便于将专有知识(例如公司的内部数据)和实时更新的信息传递给LLMs。最后,这种方法通过允许将生成结果追溯到来源证据来增强了LLMs生成的信息的可解释性(Gao等,2023b年;Yue等,2023年)。然而,这个方向也存在一些仍未解决的挑战。

利用不确定性来识别和减轻LLMs中的幻觉是当今一个有前景的研究方向。目前有三种主要方法用于估计LLMs的不确定性,每种方法都提出了其独特的挑战。首先,基于logit的方法在现代商业LLMs中越来越不适用,因为它们通常是封闭源和黑盒,导致其输出logit无法访问。其次,关于基于口头表达的方法,研究人员观察到LLMs在表达他们的自信时往往表现出过高的自信度(Xiong等,2023年)。第三,不同回应一致性的有效测量仍然是一项未解决的问题(Manakul等,2023年)。我们认为利用不确定性在开发值得信赖的LLMs方面至关重要,并鼓励未来的研究解决上述领域的挑战。

结论

由于在开放领域拥有强大的理解和生成能力,LLMs已经引起了学术界和工业界的广泛关注。然而,幻觉仍然是阻碍LLMs实际应用的一个关键挑战。在本调查中,我们全面回顾了最近的一些进展,主要是在ChatGPT发布后,旨在评估、追踪和消除LLMs中的幻觉。我们还深入探讨了现有的挑战,并讨论了潜在的未来方向。我们希望这份调查可以成为一个有价值的资源,供对LLM幻觉之谜感兴趣的研究人员使用,从而促进LLMs的实际应用。