图终身学习(continual graph learning,LGL)是一个新兴领域,旨在实现对图结构数据的持续学习,以解决现有任务上的灾难性遗忘问题,并使得顺序更新的模型能够适应新出现的图任务. 尽管LGL展现出良好的学习能力,但如何持续提高其性能仍然是一个至关重要的问题. 为填补现有研究对这一方面的空白,本文对最近在LGL领域的研究进行了全面调查和总结. 首先,重新分类了LGL的现有方法,重点关注克服灾难性遗忘的方法. 随后,系统地分析了这些方法的优缺点,并探讨了实现持续性能提升的潜在解决方案. 我们的研究着重于如何在持续学习的过程中避免对旧任务的遗忘,同时快速适应新任务的挑战. 最后,还就LGL的未来发展方向进行了讨论,涵盖了其在应用领域、开放性问题等方面的潜在影响,并具体分析了这些方向对持续性能改进的潜在影响. 这些讨论将有助于指导未来LGL研究的方向,推动这一领域的进一步发展与应用.

图终身学习(continual graph learning,LGL)是一个旨在实现图结构数据终身学习的新兴领域,可以在连续学习的同时保留以前学到的知识. 尽管LGL在研究界受到广泛关注,大多研究仅仅局限于解决灾难性遗忘问题,而忽视持续性能改进的问题. 为此,本文将全面概述LGL的最新进展,包括现有最先进的分类法、潜在应用以及开放研究问题的讨论等,以应对LGL面临的独特挑战[1]. 此外,分析了如何应用现有各种方法实现LGL的性能提升. 最后,讨论了目前仍然亟待解决的问题,并提出了未来的发展方向.

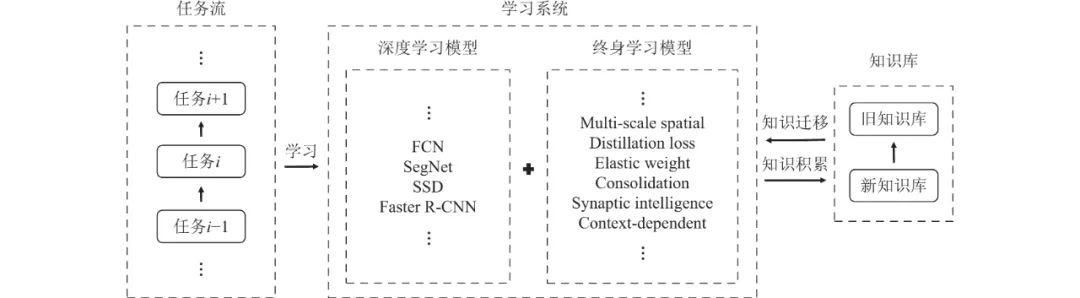

随着深度学习在生活各领域的成功应用,人们开始渴望更强大的通用人工智能. 尽管具有很好的发展前景,基于神经网络的终身学习还是面临着一个严重的遗忘问题:在新任务上的学习通常会导致旧任务上性能的急剧下降,这被称为灾难性遗忘(catastrophic forgetting,CF)[2]. 将终身学习(lifelong learning,LL)与图学习(graph learning,GL)结合起来显然是减轻灾难性遗忘的普遍解决方案,二者的结合巩固也被称为LGL. 尽管LGL具有潜力,但由于欧几里得数据和图之间的结构差异,一般LL和LGL之间存在显著或复杂的差异,包括模型、任务设置和方法[3]. 此外,LL和LGL都主要关注于克服灾难性遗忘,而忽略了终身的性能改进. 尽管关于LGL的研究越来越多,但关于LGL的调查却很少. 为了弥补这一差距,本文旨在对LGL的研究工作进行一个全面的调查.