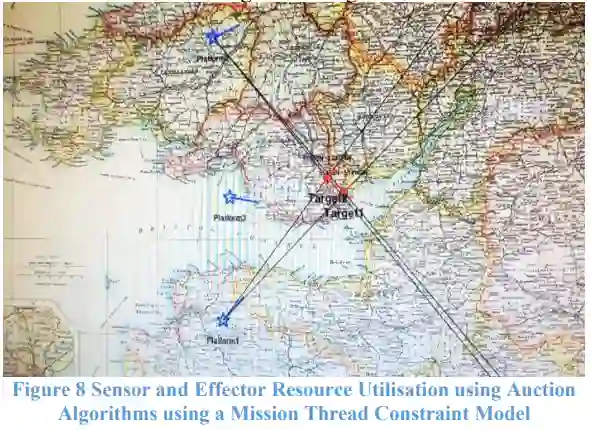

适应性或预测性技术的应用在动态环境中是复杂的,尤其当存在安全责任问题或对所将经历且可能无法测试的情况存在不确定性时。随着自动化使用的增加,确实需要就基本概念达成共识,以允许生态系统使用开放架构并成功整合。此外,许多攻击者,特别是非对称对手或恐怖组织,并不具备与正规部队相同的风险责任观念,而人工智能在战场上的应用正日益增多。这可能涉及那些对旁观者和预期中不受影响的民众尊重程度较低的参与者。尽管如此,并非所有人工智能方法都相同,其中一些具有或多或少的创造性潜力且更难测试。有些人工智能方法具备机器学习能力,而另一些则没有;同时,有些方法具有更高的认证潜力,有些则较低。此外,某些方法在针对机器而非人类的攻击中也具有更大的蓄意欺骗潜力。有人可能会争辩,人工智能并不如其名称所暗示的那样“智能”,或许在某些方法中被视为一种多维优化过程,只是表面上具有人工智能;而在另一些方法中,则被视为对人类经验和知识的替代性捕获,然后在不确定领域不加理解地复现以操控之。尽管人工智能已取得重要进展,但通用智能的目标仍遥不可及。本文旨在建立相关概念,为开放架构的理解奠定基础,从而使应用、服务和智能体组成的生态系统能够填充这些架构。为此,条件约束模型可以帮助应对环境的复杂性。本文提出了类似OODA循环和杀伤链阶段的结构作为应用方式,即任务线程,其结合不同的人工智能方法,在约束条件下实现有用的适应性或预测性运用,作为一个严格的控制框架,以负责任的方式在正确的意图下应用正确的方法,而这些任务线程为战役目标的不同人工智能应用方法提供结果约束。这有助于将结果限制在相称的响应范围内,并使其可在可靠的系统中受到约束,力求实现战役目标,同时也促进了共识的形成。

成为VIP会员查看完整内容