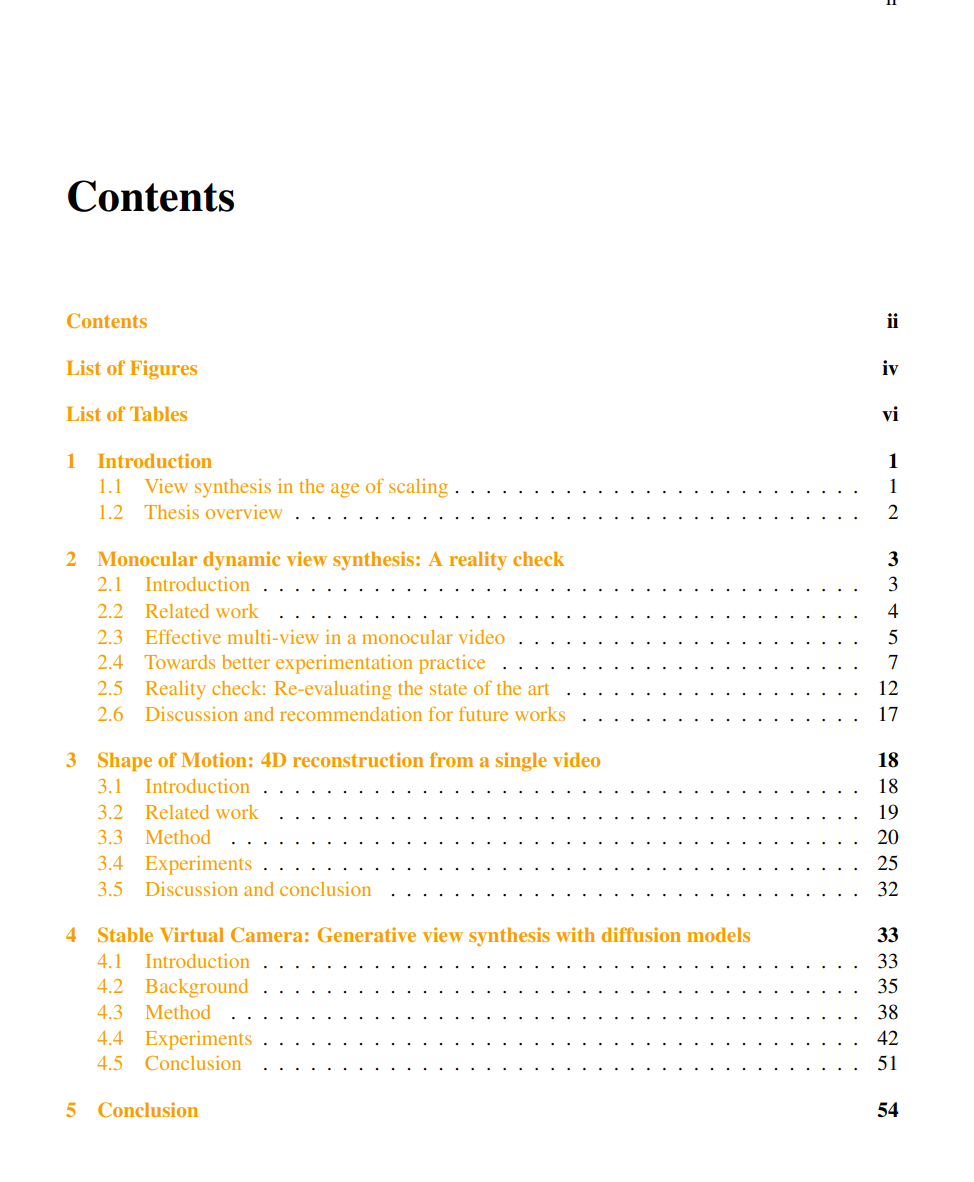

视图合成——即从新颖相机视角生成场景的逼真图像——是计算机视觉的基石,支撑着计算机图形学、沉浸式现实以及具身智能体(embodied AI)等应用。尽管其重要性不言而喻,但即使投入了更多数据与算力,视图合成的扩展性依然未能展现出与语言或二维生成相媲美的能力:基于重建的方法在稀疏视角或场景运动的情况下容易崩溃,而生成模型则难以保证三维一致性与精确的相机控制。 本论文表明,深度生成先验——具体实现为基于相机位姿条件的扩散模型——能够弥合这一差距。研究依次推进三个阶段。首先,我们揭示了现有动态视图合成基准在暗中依赖多视角线索;一旦去除这些线索,性能便急剧下降,从而暴露出基于重建方法的脆弱性。其次,我们提出了一种可行的解决方案,将学习得到的单目深度与长程跟踪先验注入动态三维高斯场景表示中,从单个视频中恢复出全局一致的几何与运动。最后,我们彻底放弃显式重建,将相机条件扩散与双通道采样策略相结合,仅凭一张输入图像即可合成时长达数分钟、可控相机运动的视频。

从诊断重建方法的局限,到引入数据驱动的正则先验对其进行增强,再到用全生成式管线完全取而代之,我们的研究描绘了一条清晰的技术演进路径,最终实现了最先进的保真度、时间一致性和相机控制精度,同时显著减少了所需输入信号的规模。最后,我们总结了当前尚未解决的挑战,并展望了将视图合成扩展至真正世界级三维环境的未来方向。

成为VIP会员查看完整内容

相关内容

Arxiv

217+阅读 · 2023年4月7日

Arxiv

84+阅读 · 2023年3月21日

Arxiv

20+阅读 · 2023年3月21日