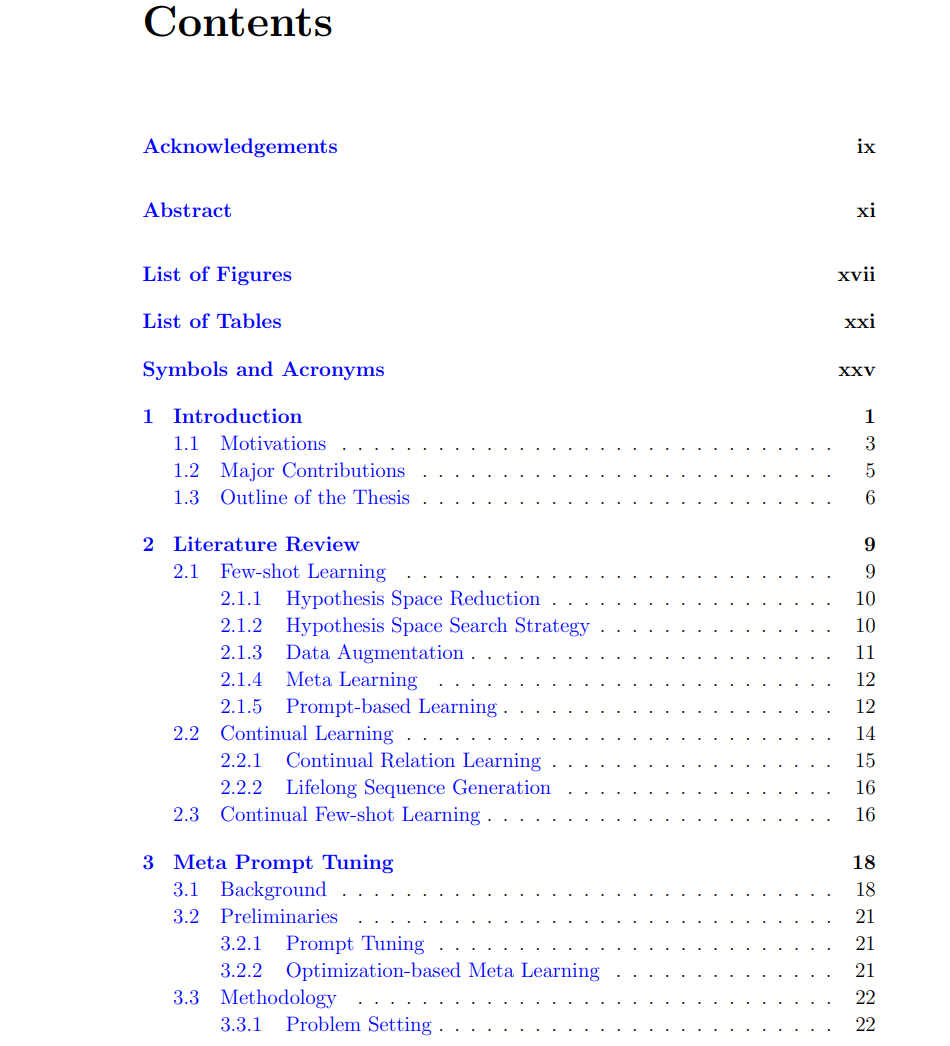

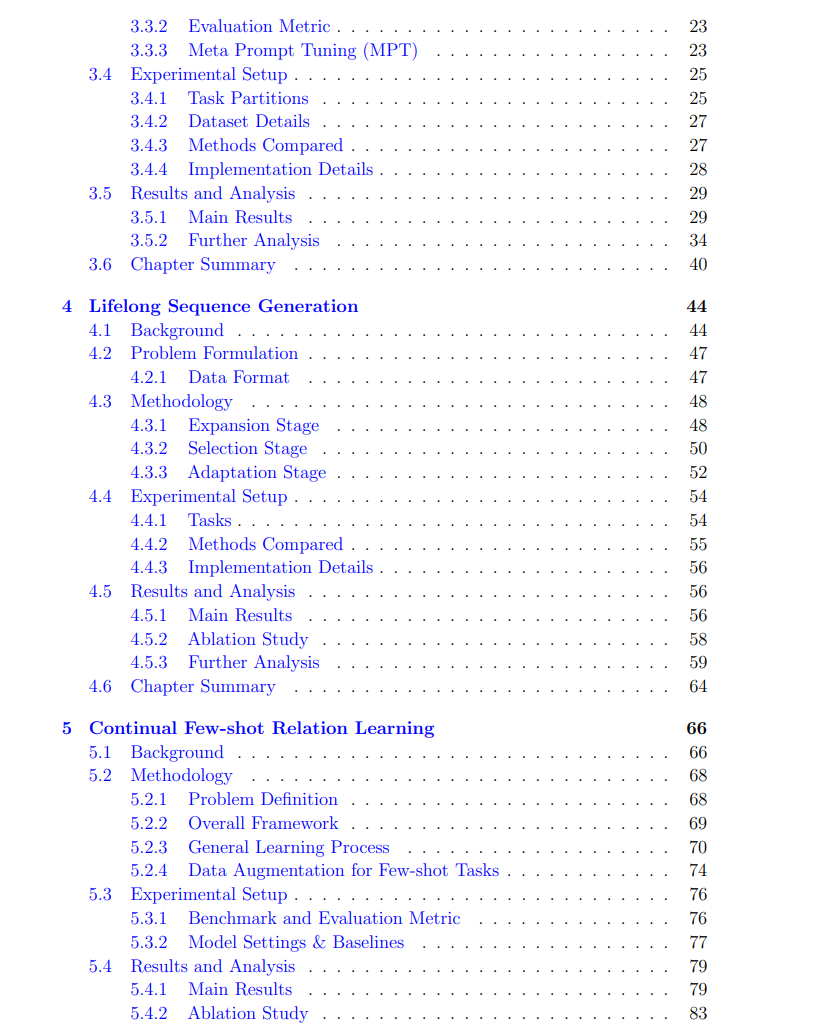

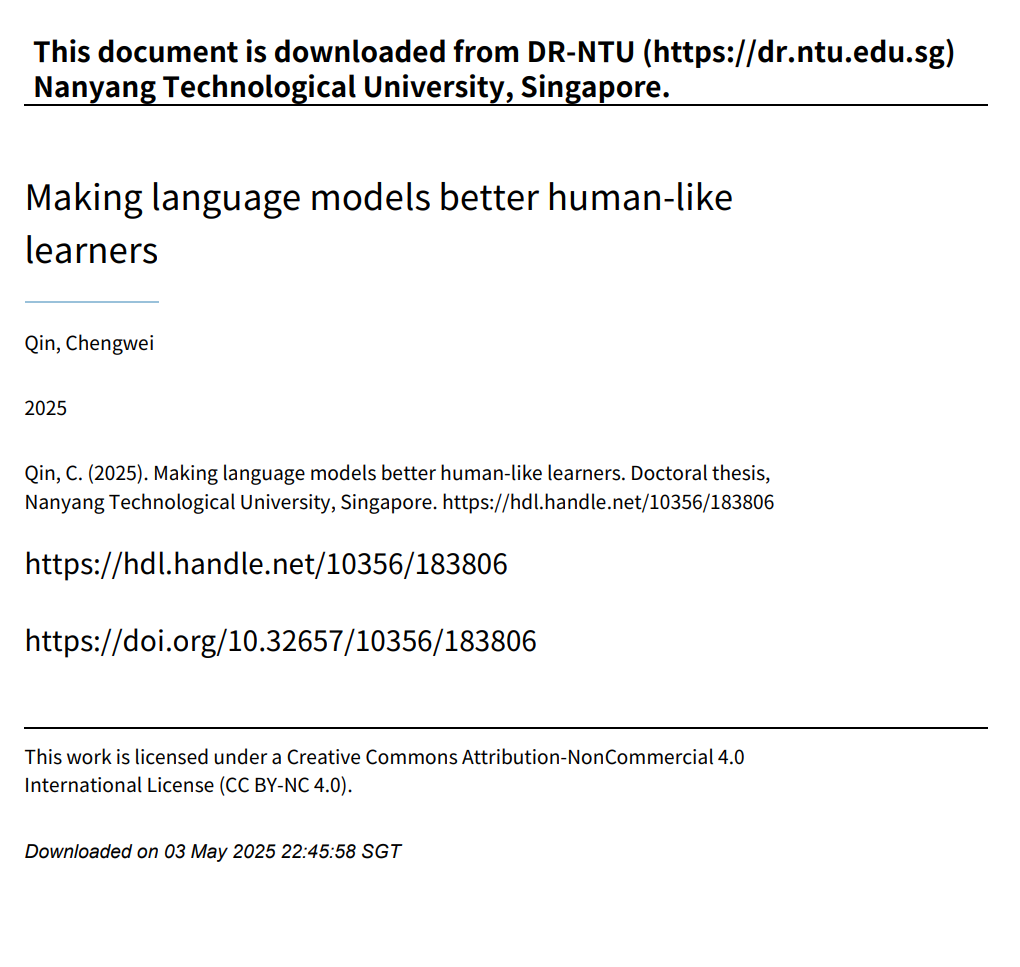

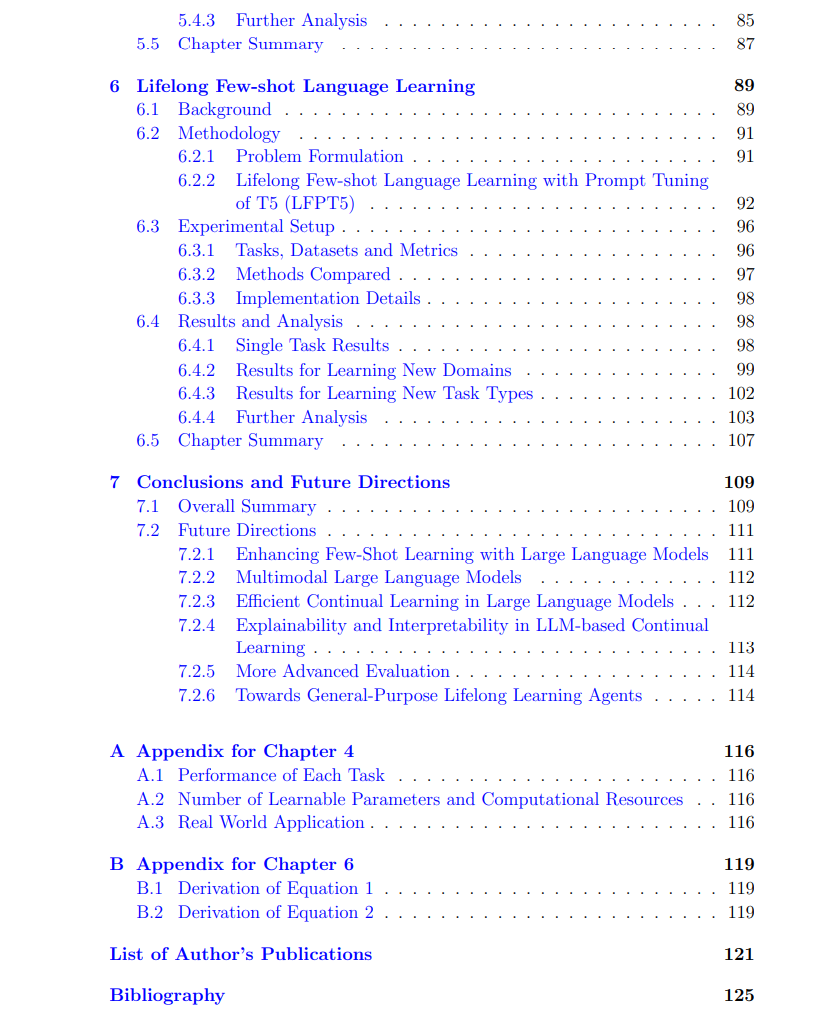

近年来,语言模型(Language Models, LMs)在多种自然语言处理(NLP)任务中取得了显著进展。然而,这些模型的学习能力与人类之间仍存在明显差距。其中一个主要区别在于学习的效率与灵活性。人类可以通过少量带标签的样本迅速掌握新概念,并能在一生中持续学习新任务而不会遗忘先前获得的知识。相比之下,语言模型通常需要大量数据才能实现有效泛化,并在适应新任务或不同数据分布时容易出现灾难性遗忘(catastrophic forgetting)的问题,即忘记之前已学到的知识。

本论文聚焦于解决这些挑战,围绕人类类学习(human-like learning)的两个核心方面展开研究:(1) 小样本学习(few-shot learning),即语言模型需能从有限的标签数据中有效泛化;(2) 持续(终身)学习(continual/lifelong learning),即模型在连续任务中学习时能够保留并积累知识。围绕这两个目标,我们提出了一系列新颖的框架与学习算法,旨在使语言模型成为更高效、类人化的学习者,能够从少量样本中学习并适应不断变化的数据分布,同时避免灾难性遗忘。

首先,我们提出了**元提示调优(Meta Prompt Tuning, MPT)**方法,该方法通过从相关任务中学习提示向量的初始化,系统探索了元学习(meta-learning)在提升跨任务小样本泛化中的潜力。通过大量实验与分析,我们验证了MPT在多种源任务/目标任务配置下的有效性与局限性。

接下来,我们研究了**终身序列生成(Lifelong Sequence Generation, LSG)问题,即在一系列生成任务中持续训练模型,使其能够不断学习新模式的同时保留先前任务中的知识。受人类学习过程启发,我们提出了动态模块扩展与自适应(Dynamic Module Expansion and Adaptation, DMEA)**框架,使模型能够根据任务间相关性动态调整结构,并选择最相关的先前任务以辅助新任务的适应。

在此基础上,我们进一步挑战更复杂且更现实的学习场景:持续小样本学习(Continual Few-Shot Learning)。在该场景下,模型不仅需从少量样本中学习新任务,还需适应任务序列的不断演化,贴近人类增量式学习过程。鉴于关系抽取(relation extraction)是众多NLP下游任务的基础,我们提出了**持续小样本关系学习(Continual Few-shot Relation Learning, CFRL)问题,并通过嵌入空间正则化与数据增强(Embedding space Regularization and Data Augmentation, ERDA)**方法进行解决。

最后,考虑到当前语言模型在处理多种任务方面已具备强大能力,我们提出了一种新的学习范式:终身小样本语言学习(Lifelong Few-shot Language Learning, LFLL),并构建了统一框架LFPT5,该框架基于提示调优(prompt tuning),能够灵活适应新类型任务或新领域,同时保留已学知识。

本论文在提升语言模型学习效率、灵活性与适应性方面做出重要贡献,使其更适用于数据稀缺、不断演化的现实应用环境。通过融合小样本学习与持续学习的研究进展,我们朝着构建不仅性能优异且认知能力更接近人类的语言模型迈出了坚实一步。最终,本研究表明,语言模型可以成为更稳健、多能、适应性更强的学习体,不再依赖大规模标注数据,而是迈向一种更类人、更智能的学习范式。