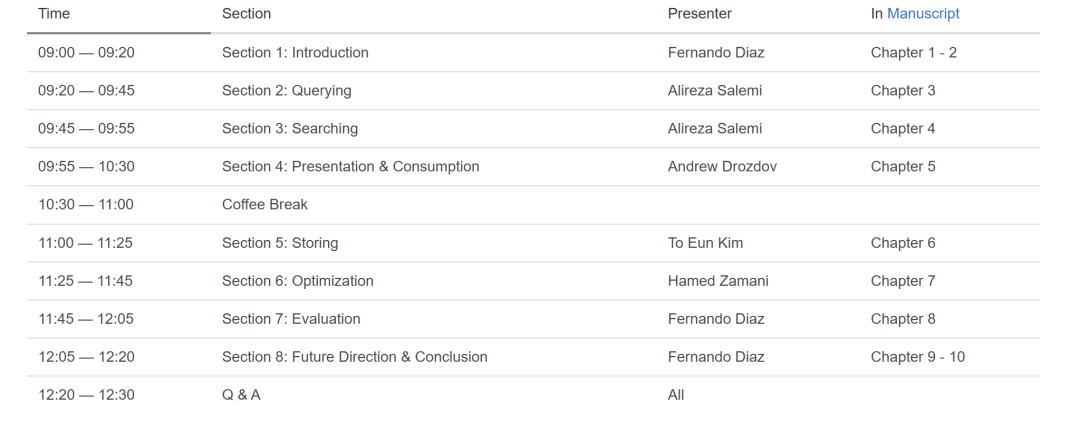

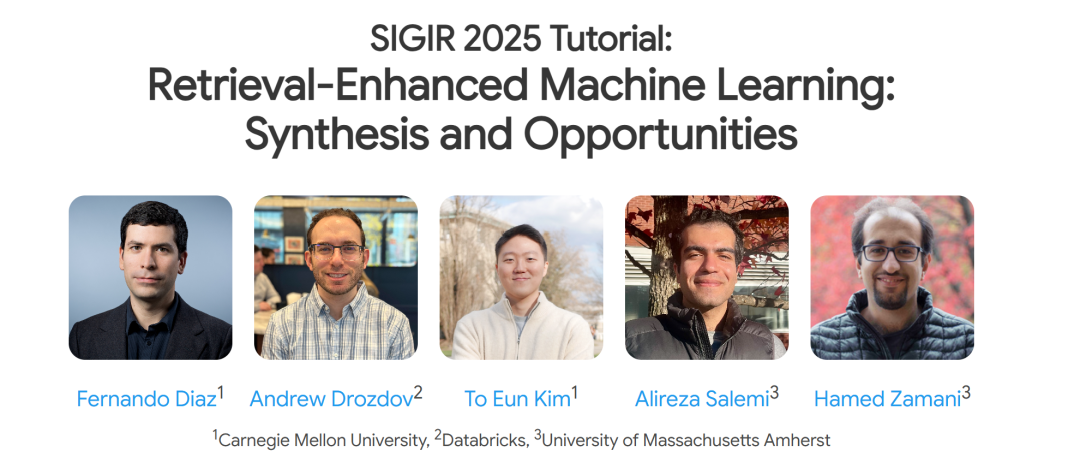

检索增强型机器学习(REML)指的是利用信息检索方法来支持机器学习任务中的推理和推断。尽管这一方法相对较新,但这些方法能够显著提高模型的性能,包括改善泛化能力、知识基准、可扩展性、新鲜度、归因性、可解释性以及设备端学习。迄今为止,尽管受到信息检索领域研究的影响,REML 研究主要集中在自然语言处理(NLP)领域的会议上。 我们的教程通过引入核心 REML 概念,并综合来自机器学习(ML)各个领域的文献(不仅限于NLP),来解决这一脱节问题。我们方法的独特之处在于,采用了一致的符号体系,为研究人员提供了一个统一且可扩展的框架。本教程将以讲座形式呈现,基于现有的手稿《检索增强型机器学习:综合与机会》。

https://retrieval-enhanced-ml.github.io/sigir-2025.html

1 引言

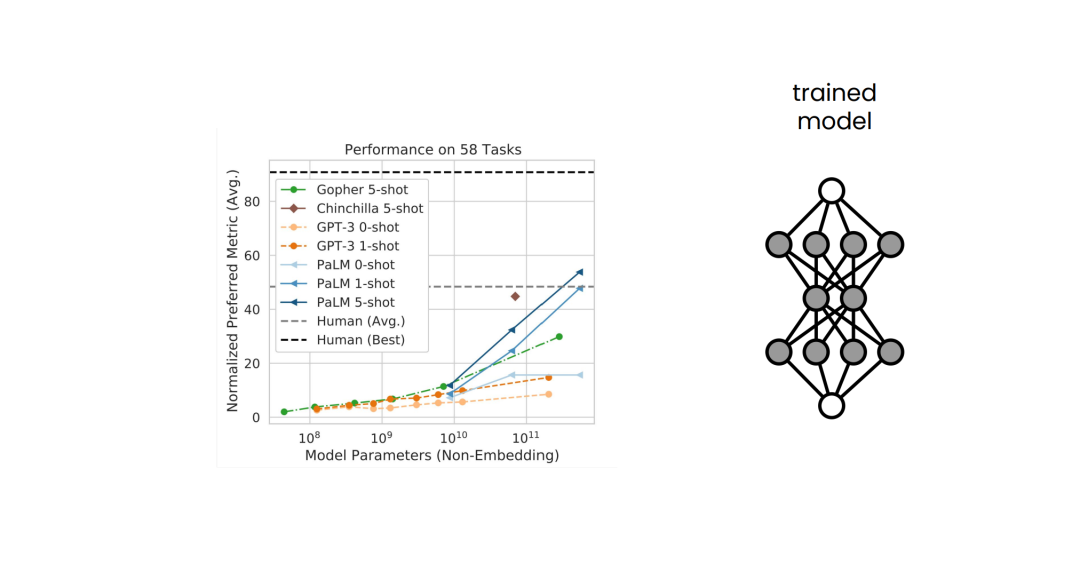

背景。近年来,围绕大型语言模型(LLM)的研究领域取得了显著增长,这些模型在各种自然语言处理(NLP)任务中展现出巨大的潜力。其中一个推动这一领域前进的重要进展是LLM参数数量的扩展,这使得训练具有前所未有的规模和复杂性的模型成为可能【267】。我们在机器学习相关的其他领域也看到类似的趋势,例如,大型视觉基础模型用于图像和视频表示【5,40】。与此同时,语境学习(ICL)【39】作为一种变革性的能力应运而生,它使得LLM在推理过程中能够动态适应并融入新的信息。与此同时,信息检索(IR)社区也在积极探索旨在提高从大规模信息集合中获取信息的效率、有效性和鲁棒性的技术。这两个领域的交汇催生了一种新的研究趋势,在这一趋势下,模型具备检索能力,可以在训练和推理阶段访问外部知识【148,257】。这种检索机制的集成开始获得显著关注,因为它使得模型能够将预测基于外部知识,而无需增加模型容量。Hashemi等人【68】和Lewis等人【123】提出的方法是这一领域的早期工作之一;前者通过扩展变换器网络专注于检索增强表示学习,后者研究了用于知识密集型语言任务的检索增强生成(RAG)范式。尽管如此,使用检索结果来改进机器学习系统并非新鲜事物。伪相关反馈方法——通过使用检索到的文档来表示搜索查询——或许是这一类别中最早的一批方法【10,30】。LLM中固有的ICL能力在促进这些检索增强方法的传播和采用方面发挥了关键作用。通过将检索到的文档集成到LLM的提示中,研究人员能够在不根本改变底层模型架构的情况下,利用外部知识源。

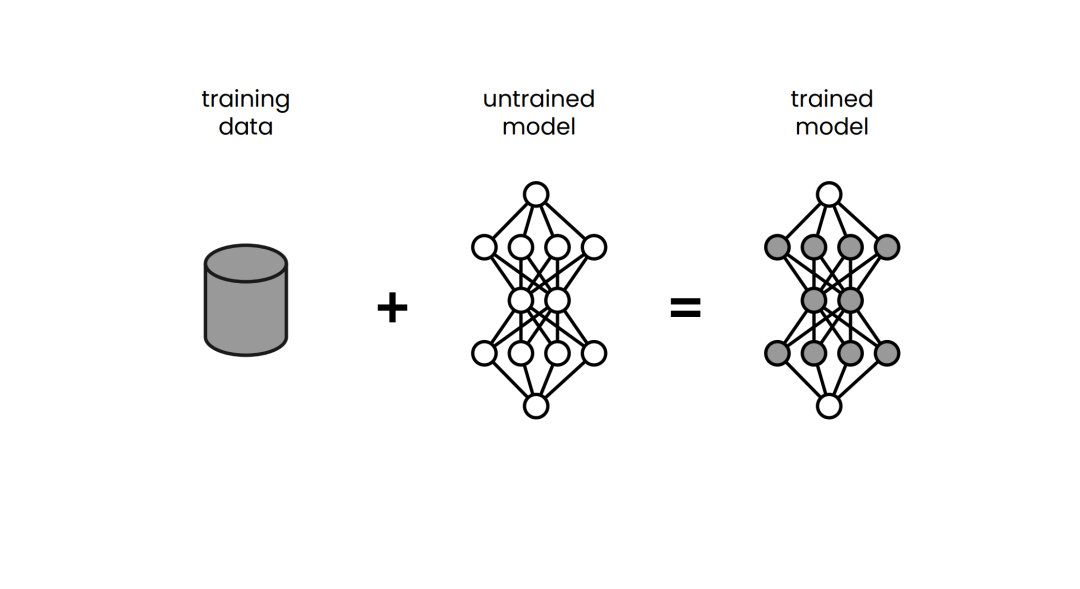

动机。由于通过增加参数数量来提高模型性能并不可持续,基于检索的模型的动机之一源自一个发现:虽然大型模型倾向于记忆训练数据【17】,但通过引入基于检索的方法,可以有效地将记忆负担转移到外部存储系统【14,198】。我们主张通过信息检索技术提升机器学习(ML)模型的能力(即,超越生成任务),使其能够利用存储信息。信息检索(IR)已经在帮助人类与庞大的文本数据库互动方面展示了其优势。我们认为,IR的实用性可以扩展,不仅使机器能够访问庞大的文本数据库,还能访问以更抽象形式表示的知识。通过将机器学习架构与能够直接访问IR系统的能力集成,我们旨在分离推理和记忆的过程。Zamani等人【257】将这种方法称为检索增强型机器学习(REML),它作为一种扩展机器学习的更广泛概念应运而生。我们在他们的基础上,进一步综述了REML在机器学习领域(包括NLP)中的最新进展,并使用一致的数学符号表示。通过这样做,我们旨在为研究人员提供一个全面且结构化的REML方法论概述,使他们能够迅速在这一领域开展研究。

REML的应用。REML范式的应用涵盖了多种子领域,每个子领域都有其独特的挑战和应用。这些应用包括语言建模的开创性工作【14,66,83,84,100,123,125,176,199,223,270】、机器翻译【99】、问答系统【18,22,106,119,120,154,236,252,265】、事实验证【20,123,164】、开放领域【111,202,211】和任务导向【45,155,175,213】对话系统、槽填充【56】、状态跟踪【109】、强化学习【26,49,57,79】、计算机视觉【21,177,201,249】、多模态机器学习【47,81】、常识推理【254】、证据归因【53,54,80,146】、知识图谱增强【11,77,94,228,252,263】、个性化推荐【185,186】、数学问题求解【244】、代码生成【226,261,273】、音频与语音表示学习【128,192,272】、时间序列预测【90,240,246】、机器人导航与体现【3,237】、芯片设计【26】、医学推理【85】、药物发现【132】和蛋白质结构预测【29,95】等。工业界和开源社区迅速接受了基于检索的模型,认识到其加速适应和提升性能的潜力。像LangChain、LlamaIndex和DSPy【102】等框架相继出现,简化了实现检索基模型的过程。这个广泛的领域(虽然不是详尽无遗的清单)突显了REML范式在不同应用中的多样性和影响力。 本工作主要贡献。尽管许多当前应用集中在自然语言处理领域,我们认为,利用检索组件的机器学习模型不仅限于语言模型,还可以扩展到任何机器学习模型。为了解决这一更广泛的适用性,我们将这一框架正式化为检索增强型机器学习(REML),并以一致的数学符号体系综合了现有的研究,这在当前文献中是缺乏的。在本论文中,我们始终使用表1中描述的符号。此外,尽管REML模型已经取得了进展,但信息检索领域丰富而广泛的研究成果仍然被严重低估,这些成果能够提供大量的方法论和洞见,极大地促进REML模型的改进。本工作旨在通过将IR研究与REML模型设计相结合,弥合这一鸿沟。最终,我们希望本工作能够帮助各个领域的研究人员轻松理解REML框架及其扩展性。