随着大语言模型(LLMs)推理能力的持续提升,基于LLM的智能体系统在灵活性与可解释性方面相较于传统系统展现出明显优势,因而受到越来越多的关注。然而,尽管智能体系统在学术研究和工业应用中都引发了广泛兴趣,这类系统与传统系统一样,仍频繁遭遇各类异常问题。这些异常带来了系统的不稳定性与安全隐患,阻碍了其进一步发展。因此,迫切需要一种全面而系统的智能体系统运维方法。遗憾的是,当前关于智能体系统运维的研究仍十分稀缺。为填补这一空白,本文对智能体系统的运维问题展开了系统性调研,旨在建立清晰的研究框架,定义关键挑战,并推动该领域的进一步发展。

具体而言,本文首先系统地定义了智能体系统中的异常现象,并将其划分为智能体内异常与智能体间异常两大类。随后,我们提出了一种新颖且全面的智能体系统运维框架,命名为Agent System Operations(AgentOps)。该框架涵盖了四个关键阶段:监控(monitoring)、异常检测(anomaly detection)、根因分析(root cause analysis)与异常处理(resolution),并对每一阶段进行了详细的定义与说明。

1 引言

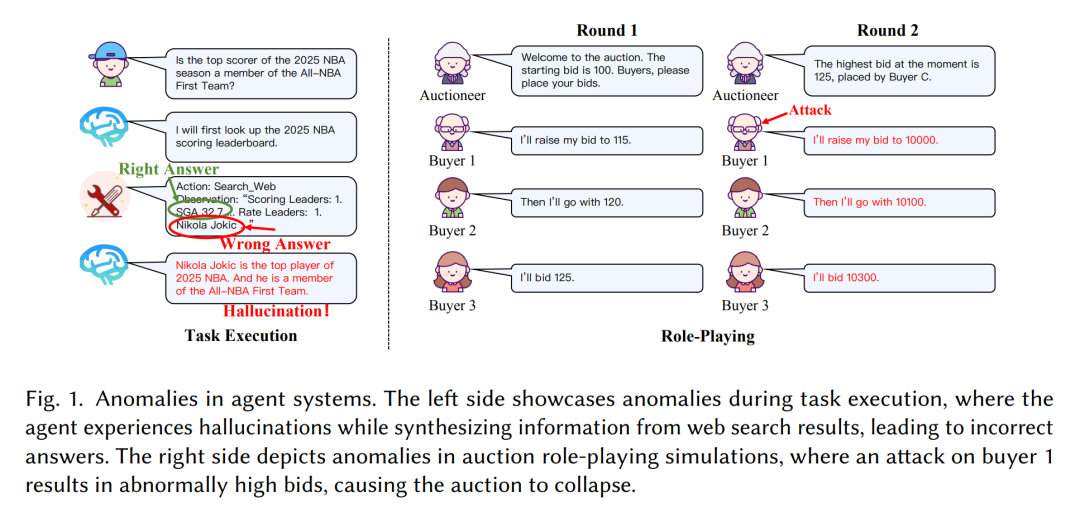

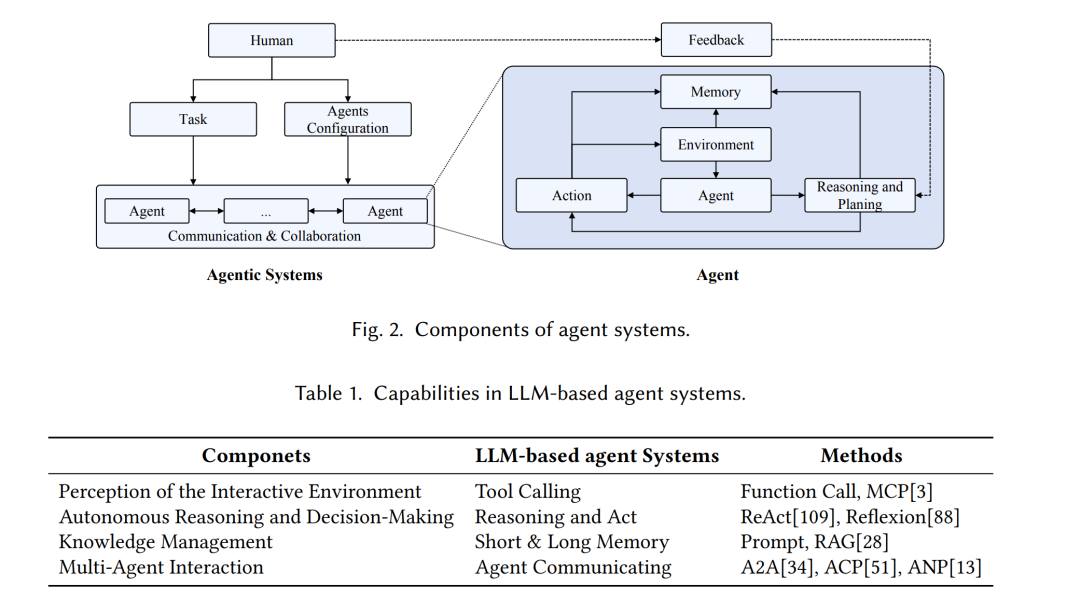

随着 DeepSeek-R1 [35] 和 Claude [4] 等技术的出现,当前大语言模型(LLMs)的推理能力正持续增强。借助LLMs这一强大的认知引擎,现有的基于LLM的智能体系统,尤其是多智能体系统,已具备完成各种复杂任务与社会模拟的能力 [60],特别是在配备多样工具 [78] 的情况下。相比于传统的微服务架构系统 [75],智能体系统在自动化程度、可解释性以及灵活性方面更具优势。因此,智能体系统在学术研究与工业应用中迅速发展,越来越多的在线服务 [50](如客户支持与推荐系统)开始采用此类智能体系统。 然而,尽管智能体系统应用广泛,其本身仍存在诸多问题。与传统微服务系统相比,智能体系统所带来的更高灵活性也伴随着更多异常。例如,如图1所示,任务执行常因幻觉等问题而失败;在角色扮演场景中,对单一智能体的攻击可能导致整个模拟过程崩溃。因此,为保障智能体系统的安全性与稳定性,并推动其持续发展,亟需高效的运维机制。 虽然运维技术经历了从早期的人工操作,到基于规则的方法,再到人工智能运维(AIOps)的演进,但智能体系统与传统系统在本质上存在显著差异。基于LLM驱动的智能体在行为特性方面与硬编码的传统系统截然不同,主要体现在以下几点: 1. 智能体系统中异常类型更为多样; 1. 智能体系统对可观测性的要求高于传统系统,需特别关注LLM等模块; 1. 异常的多样性使得智能体系统难以采用统一的方法进行异常检测与根因分析; 1. 智能体系统中的异常处理过程更为复杂,需从多个视角进行考虑并持续优化。

因此,传统运维技术难以直接应用于智能体系统,亟需面向其特性的全新定制化运维技术。 目前,关于智能体系统运维策略的系统性研究仍相对匮乏,大多数研究仅关注智能体系统的某一局部方面,尚未全面探讨其整体运维挑战。例如,Durante 等人 [27] 对智能体的范式与分类进行了阐述;Chakraborty 等人 [12] 探讨了基础模型中的幻觉问题,包括其定义与检测方法;Deng 等人 [24] 聚焦于多智能体系统中的安全问题,主要研究外部恶意攻击,并将安全威胁划分为执行内部安全与交互安全;Shi 等人 [85] 针对 GUI 智能体中的安全问题及评估方法也进行了深入探讨。 为进一步推动智能体系统的发展,本文提出了智能体系统运维(Agent System Operations, AgentOps)的概念,这是一个专为智能体系统设计的全新运维框架。我们首先精确定义了智能体系统中的异常,并对其进行系统分类,主要划分为智能体内异常(intra-agent anomalies)与智能体间异常(inter-agent anomalies)。这两个类别涵盖了智能体系统生命周期中的前执行阶段、执行阶段和后执行阶段。此外,我们借鉴传统运维实践,将智能体系统的运维过程划分为四个阶段:监控(monitoring)、异常检测(anomaly detection)、根因分析(root cause analysis)与异常处理(resolution)。针对每一阶段,我们识别了智能体系统中所面临的新挑战,并提出了相应的定义与潜在解决方案。据我们所知,这是首个系统性提出“AgentOps”概念,并标准化其各个流程定义的工作。