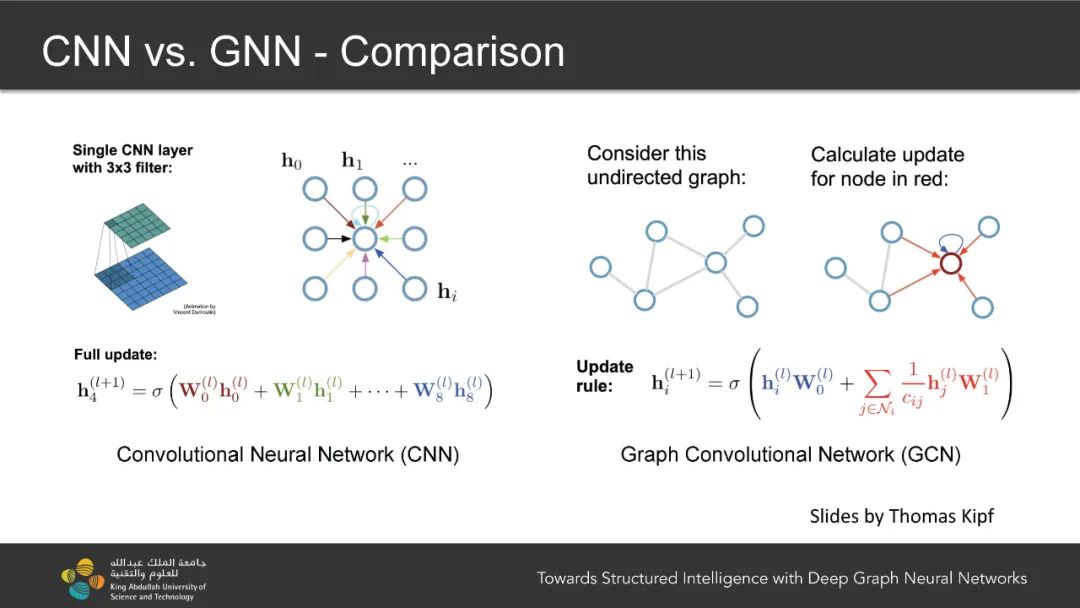

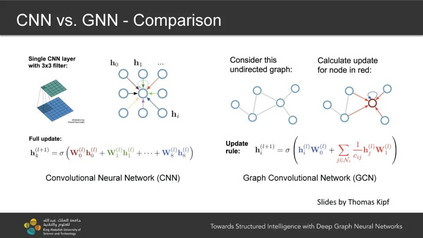

卷积神经网络和循环神经网络的进步导致了对图像和文本等规则网格数据域的学习的显著改进。然而,许多现实世界的数据集,例如社会网络、引文网络、分子、点云和3D网格,并不位于这样一个简单的网格中。此类数据结构不规则或非欧氏,关系信息复杂。图机器学习特别是图神经网络(Graph Neural Networks, GNNs)为处理此类不规则数据和建模实体之间的关系提供了潜力,正引领机器学习领域进入一个新时代。然而,由于梯度消失、过拟合和过平滑等挑战性问题,之前最先进的(SOTA) GNN限于浅层架构。大多数SOTA GNN深度不超过3或4层,限制了GNN的表达性,使其在大规模图上的学习效果不佳。为了解决这一挑战,本文讨论了构建大规模高效图机器学习模型的方法,以学习结构化表示,并将其应用于工程和科学。本文将介绍如何通过引入架构设计使GNN深入,以及如何通过新的神经架构搜索算法自动搜索GNN架构。

卷积神经网络(CNN)[102]已经非常成功地解决了各种计算机视觉任务,如目标分类和检测、语义分割、活动理解等。它们出色性能的一个关键促成因素是训练非常深的网络的能力。尽管在许多任务中取得了巨大的成功,但CNN不能直接应用于非网格数据和关系数据,而这在许多现实世界的应用中普遍存在。图神经网络(GNNs)[169]提供了一种替代方案,允许将非网格数据或关系数据作为神经网络的输入。最近的工作表明,由于GNN在图上学习表示的能力,它可以在跨领域的各种任务上取得优异的结果。具体来说,GNNs可以在引文网络中的学术论文分类[95]、量子化学中的分子性质预测[60]、生物图中的蛋白质相互作用预测[68]和计算机视觉中的点云学习[201]等任务中取得令人印象深刻的结果。虽然GNN已经取得了令人鼓舞的结果,但它们仅限于层数相对较少的架构,主要是由于训练[109]期间梯度消失[77]、小数据集上的过拟合[189]和堆叠过多层时的过平滑[114]。然而,这一限制使得GNN难以在大规模图上学习有代表性的特征,从而限制了深度GNN的代表性能力。为了构建大规模、高效的图神经网络,本文研究了以下几个重要方面: (1) 如何使训练非常深的图神经网络成为可能; (2) 在设计GNN模型时如何减少架构工程。

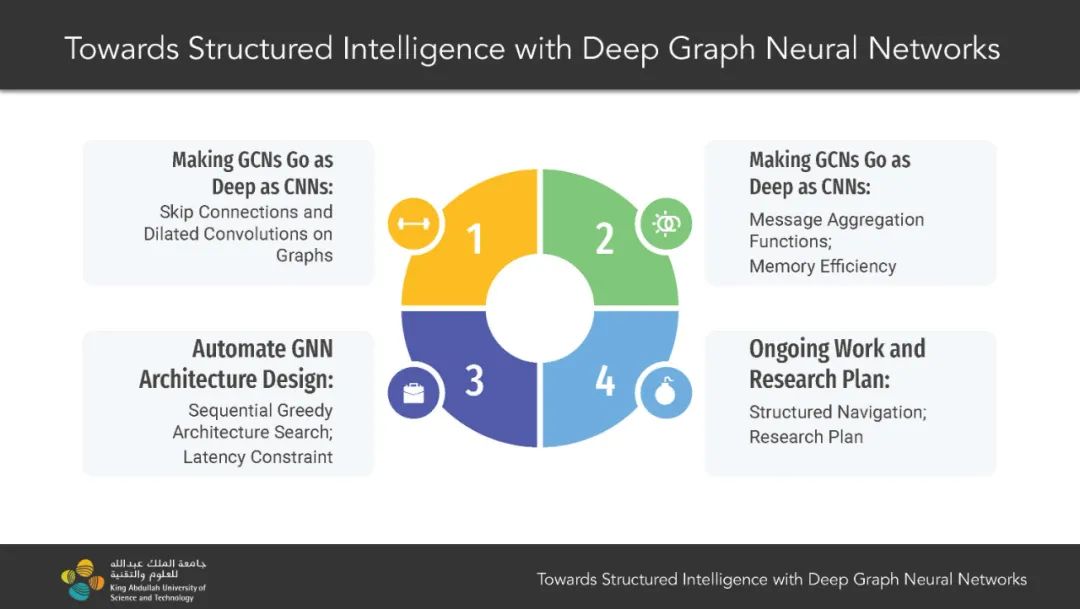

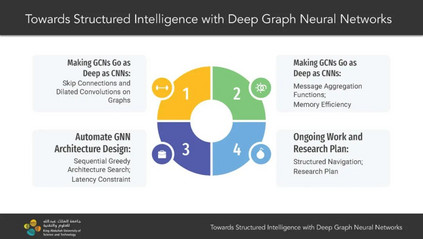

本论文旨在解决图神经网络(GNN)架构中的核心问题之一。具体来说,论文研究了训练和设计非常深层次的GNN模型的技术,并将这些深层GNN模型应用于跨领域的各种大规模应用。我们首先提出了用于训练深层GNN的跳跃连接和扩张卷积。然后,我们讨论了消息聚合函数在训练深层GNN时的影响,并提出了可微分的消息聚合函数。为了使训练更深层次的GNN成为可能,我们研究了可逆连接、组卷积、权重绑定和平衡模型等技术,这些技术使得可以训练具有1000多层的GNN。最后,我们开发了一种新颖的神经架构搜索算法,以实现自动设计有效和高效的GNN架构。

在第2章中,我们研究了如何将跳跃连接和扩张卷积等概念从卷积神经网络(CNNs)应用到GNNs,以成功训练非常深层的GNNs。我们通过实验在各种数据集和任务上展示了使用深层GNNs(最多112层)的好处。具体而言,我们在点云的部分分割和语义分割以及生物蛋白质-蛋白质相互作用图中的蛋白质功能节点分类方面取得了非常有希望的性能。通过彻底的消融研究和分析,我们证明了跳跃连接和扩张卷积对于减轻训练深层GNN的困难是有效的。本章内容基于我们的研究成果[109, 107]。

在第3章中,我们研究了适当选择聚合函数对深层模型的影响。我们发现,当应用于不同数据集时,GNN对于聚合函数的选择(例如均值、最大值和总和)非常敏感。我们系统地研究并提出通过引入一种名为广义聚合函数的新类聚合函数来缓解这个问题。所提出的函数超出了常用的聚合函数,可以适用于各种新的排列不变函数。广义聚合函数是完全可微分的,其参数可以端到端地学习,以产生适合每个任务的合适聚合函数。我们展示,配备了所提出的聚合函数的深层残差GNN在Open Graph Benchmark(OGB)[84]上的多个任务和领域的基准测试中优于现有技术。本章内容基于我们的研究成果[111]。

在第4章中,我们研究了可逆连接、组卷积、权重绑定和平衡模型,以提高GNN的内存和参数效率。我们发现,可逆连接与深度网络架构相结合,使得能够训练过度参数化的GNN,这些GNN在多个数据集上显著优于现有方法。我们的模型RevGNN-Deep(每层1001层,每个通道80个)和RevGNN-Wide(每层448层,每个通道224个)都是在一台普通GPU上训练的,它们在ogbn-proteins数据集上实现了ROC-AUC为87.74±0.13和88.24±0.15的性能。据我们所知,RevGNN-Deep是文献中最深的GNN,层次数相差一个数量级。本章内容基于我们的研究成果[108]。

在第5章中,我们旨在实现GNN架构的自动设计。最近在自动神经架构搜索(NAS)方面的进展显示出很大的潜力。然而,我们发现在最终评估中,发现的架构经常无法泛化。为了缓解这个常见问题,我们引入了顺序贪婪架构搜索(SGAS),一种新颖的神经架构搜索算法。通过将搜索过程分为子问题,SGAS以贪婪方式选择和修剪候选操作。我们首先在CNN搜索空间上研究SGAS,然后应用到GNN搜索空间。广泛的实验证明,SGAS能够以最小的计算成本找到用于图像分类、点云分类和生物蛋白质-蛋白质相互作用图中节点分类等任务的最先进架构。本章内容基于我们的研究成果[110]。

在第6章中,我们引入了LC-NAS,以进一步自动化SGAS的延迟优化,并将其应用于GNN搜索空间,以搜索在点云任务上的架构,并限制目标延迟。我们提出了一种用于在架构搜索中准确性和延迟之间权衡的新型延迟约束形式。我们的流水线使我们能够找到延迟接近特定目标值的最佳架构,这在最终任务需要部署在有限硬件设置中时非常关键。广泛的实验表明,LC-NAS能够以最小的计算成本找到点云分类和部分分割的最先进架构。本章内容基于我们的研究成果[112]。

在第7章中,我们总结了本论文的重要发现,并讨论了深度图神经网络的未来方向。