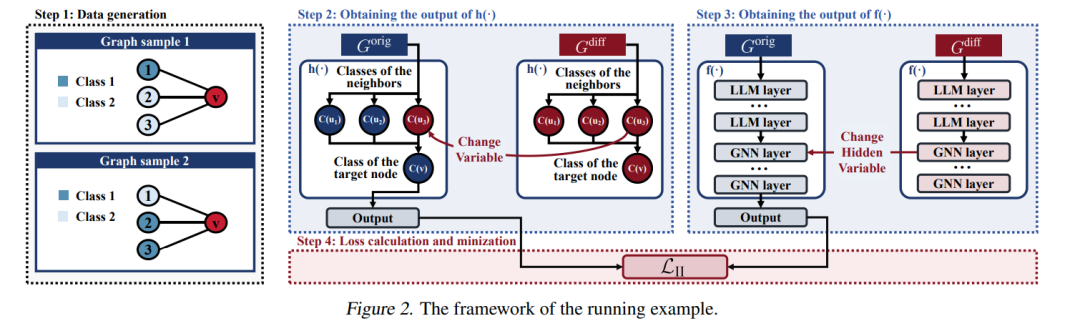

将大型语言模型(LLMs)用作特征增强器,以优化节点表示后再输入图神经网络(GNNs),这一方法在图表示学习中展现出显著潜力。然而,这一策略的基本属性仍缺乏深入探讨。为了解决这一问题,我们提出基于“互换干预法”(interchange intervention method)对该方法进行更深入的分析。 首先,我们构建了一个具备可控因果关系的合成图数据集,能够精确操控语义关系与因果结构,为分析提供数据支持。在此数据集上,我们实施互换干预操作,深入剖析LLM增强器与GNN的内在属性,揭示其底层逻辑与内部机制。

基于分析结果,我们进一步设计了一个即插即用的优化模块,用于提升LLM增强器与GNN之间的信息传递效率。在多个数据集和模型上的实验结果验证了该模块的有效性。项目代码可在以下地址获取: https://github.com/WX4code/LLMEnhCausalMechanism

成为VIP会员查看完整内容

相关内容

Arxiv

39+阅读 · 2023年4月19日

Arxiv

209+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日

Arxiv

17+阅读 · 2017年12月12日