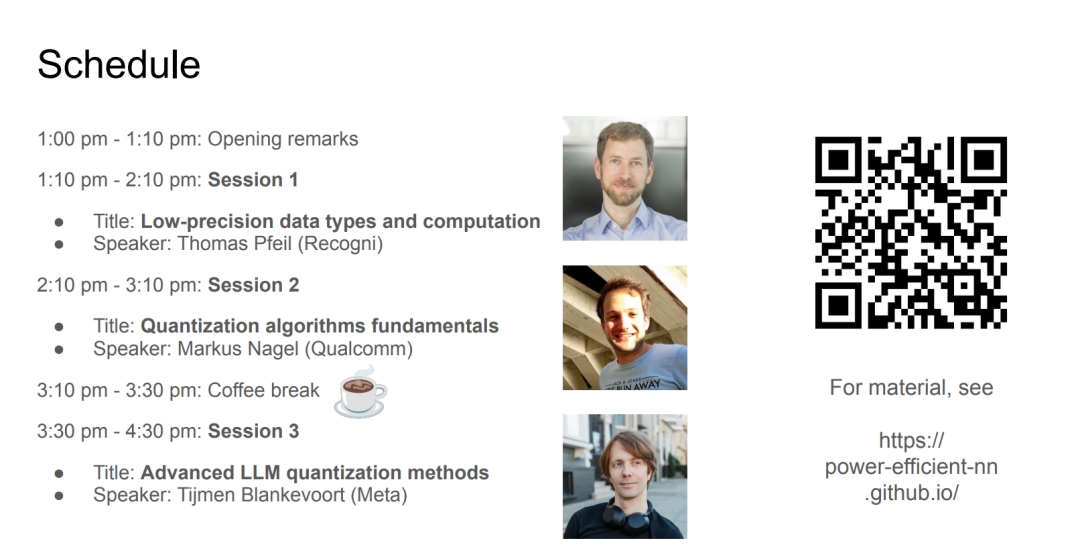

神经网络(尤其是在生成式人工智能中的)规模日益庞大,在可持续性、时间与成本等方面带来了重大挑战,限制了其研究与实际应用。低精度数据类型与计算,尤其是在硬件原生支持的情况下,为此提供了一种高效的解决方案,不仅拓宽了研究的可及性,也使得在边缘设备上的部署成为可能。然而,为了实现这一目标,通常使用高精度数据类型训练的神经网络需要针对低精度推理进行适配。 在本教程中,我们将回顾不同类型的低精度数据格式,并通过简明的实践示例展示其应用中常见的挑战,例如离群值处理等。为了保持神经网络在原始任务中的性能,需要采用复杂的量化方法,以补偿低精度数据类型所引入的量化误差。我们将介绍并对比当前最常见且高效的神经网络量化方法,并为实践者提供相应的应用指导。

讲者:https://power-efficient-nn.github.io/

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日