深度研究系统,即通过协调推理、在开放网络和用户文件中进行搜索、并结合工具使用来解决复杂多步任务的智能体 AI,正在向层次化部署方向发展,包含规划器(Planner)、协调器(Coordinator)和执行器(Executors)。在实践中,端到端训练整个堆栈仍不切实际,因此大多数工作仅训练一个连接核心工具(如搜索、浏览与代码)的单一规划器。尽管监督微调(SFT)能够赋予协议一致性,但其受到模仿偏差与暴露偏差的影响,并且未能充分利用环境反馈。偏好对齐方法(如 DPO)依赖于模式(schema)和代理(proxy),属于离策略(off-policy),在长时程信用分配与多目标权衡方面能力较弱。SFT 与 DPO 的另一局限在于,它们依赖于人工通过模式设计与标注比较来定义决策点与子技能。相比之下,强化学习(RL)与闭环、工具交互式研究天然契合,它通过优化轨迹级策略支持探索、恢复行为与原则性信用分配,同时减少对人工先验和标注者偏差的依赖。

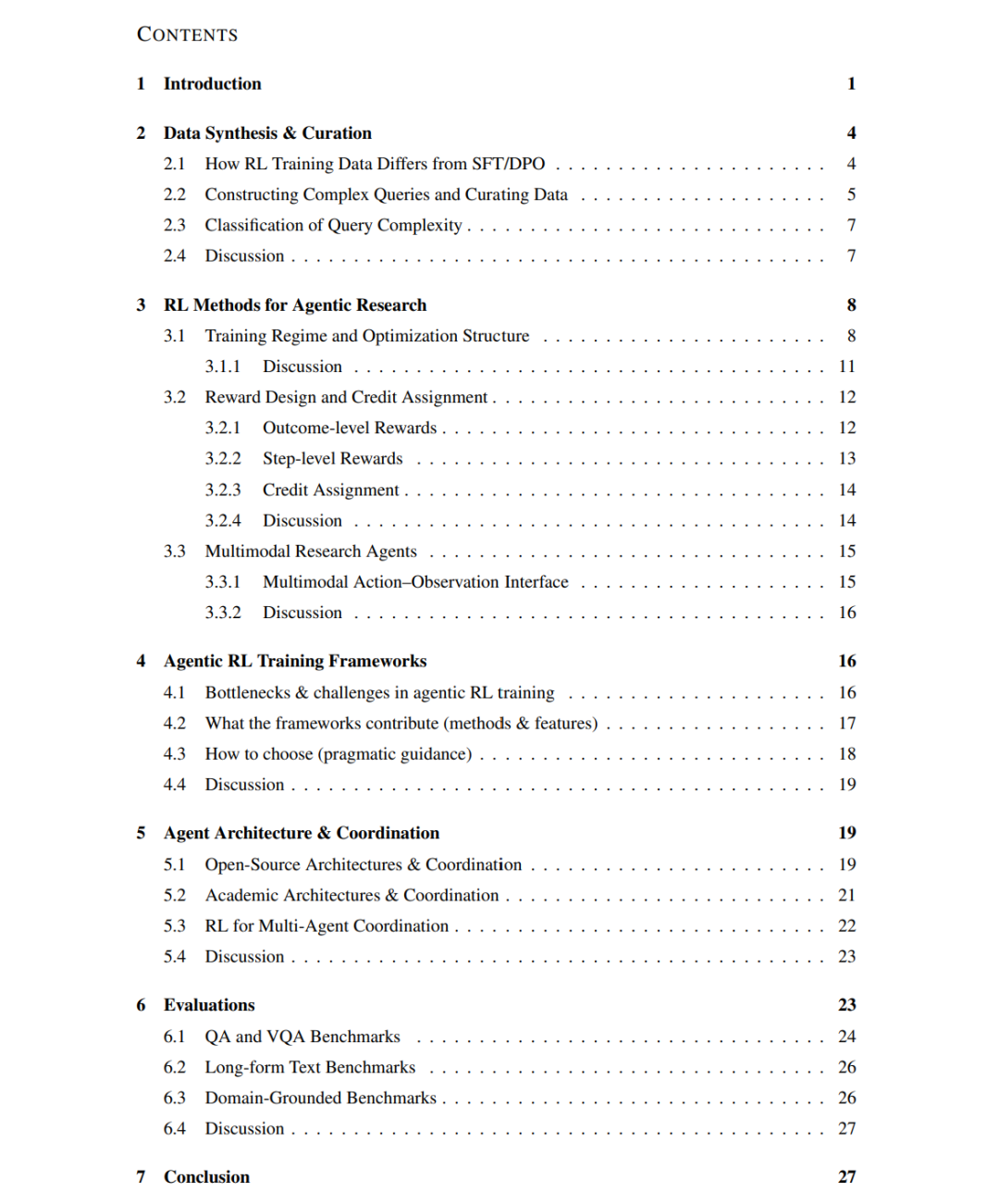

据我们所知,本综述是首个专门聚焦深度研究系统强化学习基础的工作。本文沿三个维度系统化了 DeepSeek-R1 之后的研究:(i) 数据合成与数据整理;(ii) 面向智能体研究的 RL 方法,涵盖稳定性、样本效率、长上下文处理、奖励与信用设计、多目标优化与多模态集成;(iii) 智能体式 RL 训练系统与框架。我们同时讨论了智能体架构与协调机制,以及评测与基准,包括近期的问答(QA)、视觉问答(VQA)、长篇综合生成、以及具备领域约束的工具交互任务。我们总结了反复出现的模式,揭示了基础设施瓶颈,并提供了关于如何利用 RL 训练鲁棒、透明的深度研究智能体的实践指南。 一份精选论文列表可在 github.com/wenjunli-0/deepresearch-survey 获取。

1 引言

深度研究系统(deep research systems)的快速涌现(例如 OpenAI (2025)、Google (2025)、Perplexity Team (2025)),即能够处理复杂多步信息检索任务的智能体 AI 模型,标志着人工智能在推理、执行与综合方面方法的重大转变。在本综述中,我们聚焦于信息检索类用例,因为现有的大多数研究与产品均集中于这一应用。我们将深度研究系统定义为智能体研究者(agentic AI researchers),它们能够自主规划并执行跨开放网络与用户提供文件的多步研究任务,在新证据出现时迭代搜索、阅读与推理,最终要么为客观问题给出简洁答案,要么为主观开放性问题生成结构化、带引用的综合性报告。

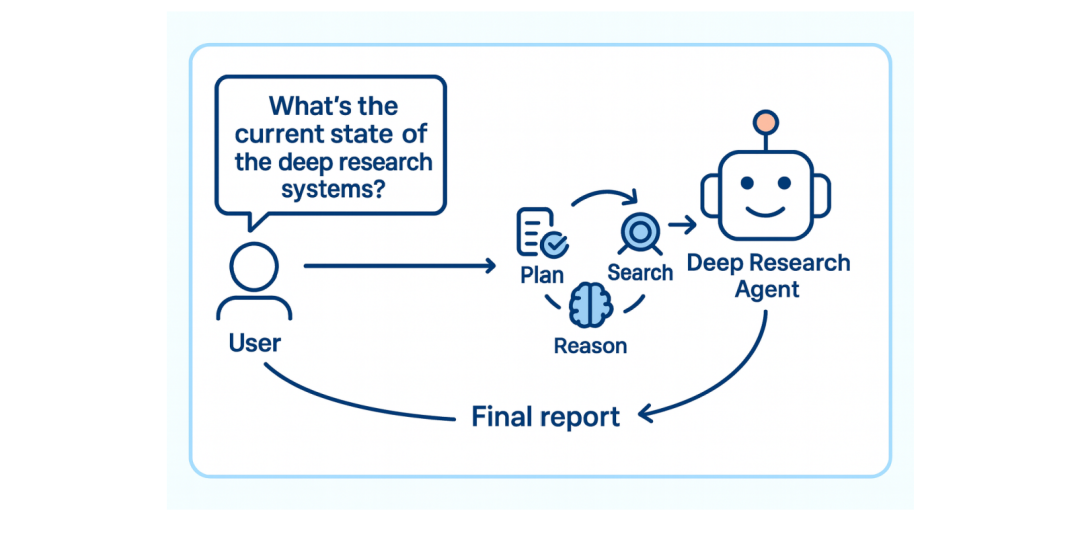

学术界(Li et al., 2025f; Jin et al., 2025b; Wan et al., 2025)与工业界(ByteDance & contributors, 2025; LangChain & contributors, 2025; MiroMindAI & contributors, 2025)的一个共同趋势是:从单一体式智能体转向层次化智能体架构用于深度研究。图 1 展示了这一架构:规划器(Planner) 负责逐步分解与反思;协调器(Coordinator) 负责任务分配、委派、聚合与验证;而执行器(Executors)(即专门化的智能体与工具池)则在网络与文件上执行具体操作。这种关注点分离将战略规划与执行细节解耦,既支持并行化与“即插即用”的专业能力(例如替换更好的搜索器或代码执行器,并扩展至更多工具),又提供更细致的过程记录、信用分配与可审计性。同时,它还保持了规划器在长时程中的全局状态简洁且一致,而协调器与执行器则负责委派与落地执行。 尽管层次化架构在部署中颇具吸引力,但目前尚难以实现端到端训练整个工作流。因此,大多数研究集中于训练单一模型(通常是规划器),该模型直接连接少量基础工具(搜索/浏览/代码)。这种方式缩短了展开长度并降低方差,适配现有的 RL/SFT/DPO 基础设施,并能获得更干净的训练信号。训练目标是端到端强化单点(即推理、分解、工具使用、反思与综合)的长时程能力,从而使最终的规划器能够作为更强大的“大脑”嵌入完整层次结构中,而协调与执行部分则保持模块化与可替换。因此,本综述主要关注规划器模型的训练,并将在第 5 节讨论智能体架构与协调设计。

监督微调(SFT; Ouyang et al., 2022; Wei et al., 2022) 是初始化深度研究智能体的有效手段:它稳定、数据高效,并擅长教授协议一致性(例如工具调用模式、响应格式)和基本的逐步推理模式。由于 SFT 优化的是金标准 (x, y) 对,它在教授局部行为(如查询重写模板、引用风格、论证包装)和早期降低方差方面表现优异。然而,这些特性也限制了其在多轮研究任务中的表现。参考轨迹通常冗长、复合且由人工撰写;模仿学习带来模仿偏差(复制特定分解方式)和暴露偏差(教师强制步骤掩盖推理时累积的误差)。此外,SFT 也未能充分利用环境反馈:它无法直接从工具失败、随机检索或非平稳状态(如价格、可用性变化)中学习。简而言之,SFT 是培养能力与接口的宝贵支架,但并不是优化端到端决策质量的最终途径。

基于偏好的方法(如 DPO; Rafailov et al., 2023)可扩展至超越单轮输出,通过将智能体工作流分解为带标签的步骤(如查询生成、检索选择、综合),并在每个阶段学习局部偏好。然而,尽管已有研究探索了利用 DPO 训练深度研究智能体(Zhang et al., 2025c; Zhao et al., 2025a; Asai et al., 2023),我们认为这些方法仍存在若干结构性不匹配。其一,DPO 优化的是文本替代,而非状态-动作回报:成对损失作用于文本字符串,而非环境状态(工具结果、缓存、预算)或动作语义。这使得信用分配先天短视——它只能判断当前片段孰优,却无法将最终成败归因于早期检索或工具使用决策,也无法在部分可观测环境下权衡搜索深度与成本/延迟。其二,逐步 DPO 依赖于模式与代理:必须人工设计过程分解并生成偏好(通常基于启发式或另一个 LLM),这引入了标注噪声,并在遇到需要不同分解的任务时表现脆弱。其三,DPO 基本上是离策略、离线的:它改进的是固定比较,而非在闭环动作-工具空间中探索,因此难以学习恢复行为(如查询返回垃圾结果、网站阻止访问或价格波动时的应对)并适应非平稳环境。最后,多目标需求(准确性、校准、成本、安全性)仅通过标注者偏好隐式进入;DPO 没有提供在长时程上聚合向量奖励的原则性机制。

鉴于 SFT/DPO 方法的局限,我们认为强化学习(RL)是端到端训练深度研究智能体的有前途途径。深度研究最终需要在闭环、工具丰富的环境中进行轨迹级学习:决定如何分解问题、何时及如何调用工具、信任哪些证据、何时停止,以及如何在状态演化中权衡准确性、成本与延迟。RL 将系统建模为状态-动作上的策略,从而能够基于环境信号进行端到端改进,实现跨多步轨迹的信用分配,并探索搜索、工具编排、恢复与综合的替代策略。 基于这种向 RL 转变的趋势,我们提出了据我们所知首个专门聚焦深度研究系统的 RL 基础的综述。本文研究范围聚焦于训练:我们分析构建深度研究智能体的 RL 方法,而非具体应用任务。我们沿三个主轴组织文献: * 数据合成与整理:创建和整理复杂、高质量训练数据的方法,通常通过合成生成,支持多步推理、检索与工具使用; * 面向智能体研究的 RL 方法:包括 (i) 扩展基线流程(如 DeepSeek-R1 风格,Guo et al., 2025)以改进稳定性、样本效率和长上下文处理;(ii) 设计奖励与信用分配机制,在多步轨迹中传播信用(基于结果 vs. 基于步骤、复合评判、回报分解);(iii) 融合多模态,通过多模态大模型 (VLM) 实现迭代感知—推理循环; * 智能体式 RL 训练框架:将训练深度研究智能体视为一个系统性问题,梳理开源基础设施,揭示瓶颈,总结可复现的设计模式,并提供可扩展、可重现的训练堆栈实践指南。

除了训练基础,我们还强调两个跨领域的战略性方向: * 智能体架构与协调:层次化、模块化与多智能体设计,增强组合推理与任务分工; * 评测与基准:评估深度研究系统的框架与数据集,尤其是在任务丰富、工具交互的环境中。

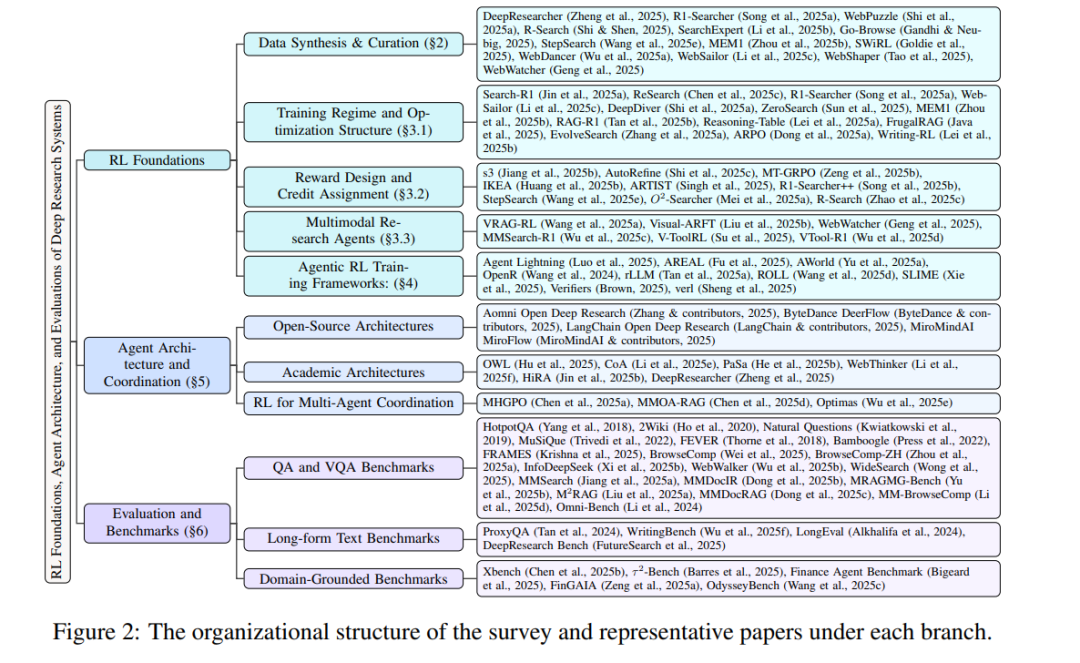

综上,这些研究主轴为 RL 增强的深度研究生态系统提供了统一视角。通过梳理各主轴的进展,本综述为初学者提供概念路线图,并为研究者提供推动智能体 AI 向鲁棒、真实问题求解迈进的技术参考。图 2 展示了本文的分类体系与所综述的关键论文。 定位与贡献。 与同期综述(Huang et al., 2025a; Li et al., 2025a; Xi et al., 2025a; Xu & Peng, 2025; Li et al., 2025g; Zhang et al., 2025d;b)主要罗列系统或泛论 RAG–推理不同,我们采取了“以训练为先、以 RL 为中心”的视角。(i) 解释为何 SFT/DPO 与闭环、工具交互式研究不匹配,并强调在规划器中引入端到端 RL 的必要性;(ii) 首次提出专门针对深度研究 RL 基础的分类体系,涵盖数据合成与整理、面向智能体研究的 RL 方法(稳定性、样本效率、长上下文处理、奖励/信用设计、多目标权衡、多模态)与训练框架;(iii) 将智能体式 RL 训练视为系统问题,揭示基础设施瓶颈并总结可复现的模式以支持大规模展开;(iv) 通过“规划器中心训练 vs. 层次化执行解耦”将训练与部署衔接,并对评测与基准进行了深入综合。相比于同期综述,本文更聚焦于 RL,提供了更深入的数据、算法与基础设施洞见。综上,我们为利用 RL 训练鲁棒的深度研究智能体提供了一份统一蓝图与可操作指南。 时间范围与纳入标准。 我们综述了 2025 年 2 月(DeepSeek-R1 之后)至 2025 年 9 月(截稿前)发表的基于 RL 的深度研究智能体训练研究,涵盖第 3 节的四个训练支柱以及第 5 节的智能体架构与协调设计,用于解释训练后的规划器如何在层次化堆栈中部署。基准与评测亦在范围内:我们引用了近年来开发的经典 QA/VQA 与长文本(报告式、带引用的综合生成)基准,而领域约束的工具交互型基准仅限于 2025 年的工作。我们仅纳入那些在开放网络或类网络工具环境(搜索、浏览、代码执行)中通过 RL 学习策略的研究,排除仅使用 SFT/DPO 而不涉及 RL 的研究。