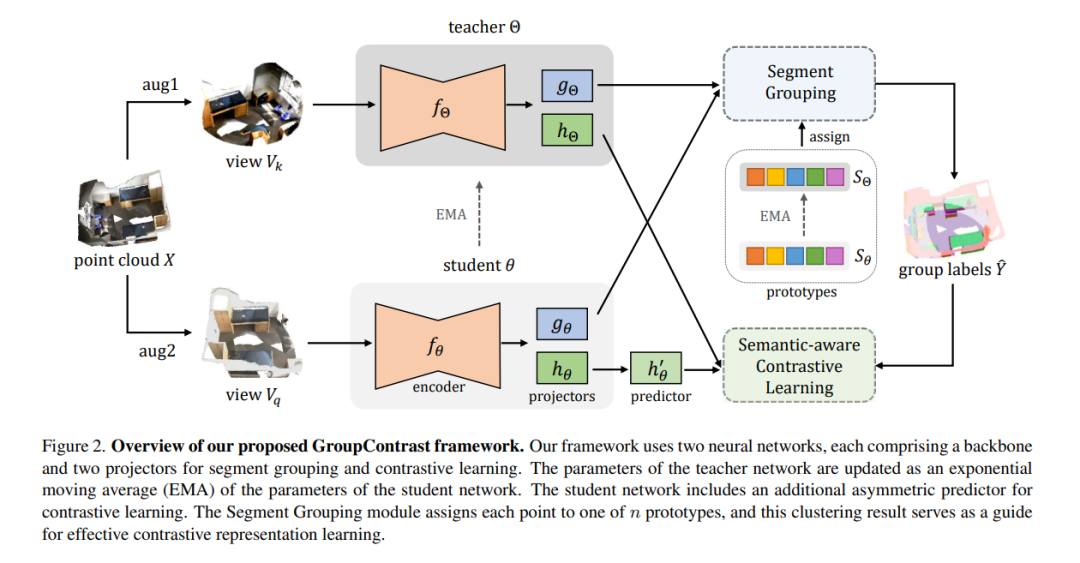

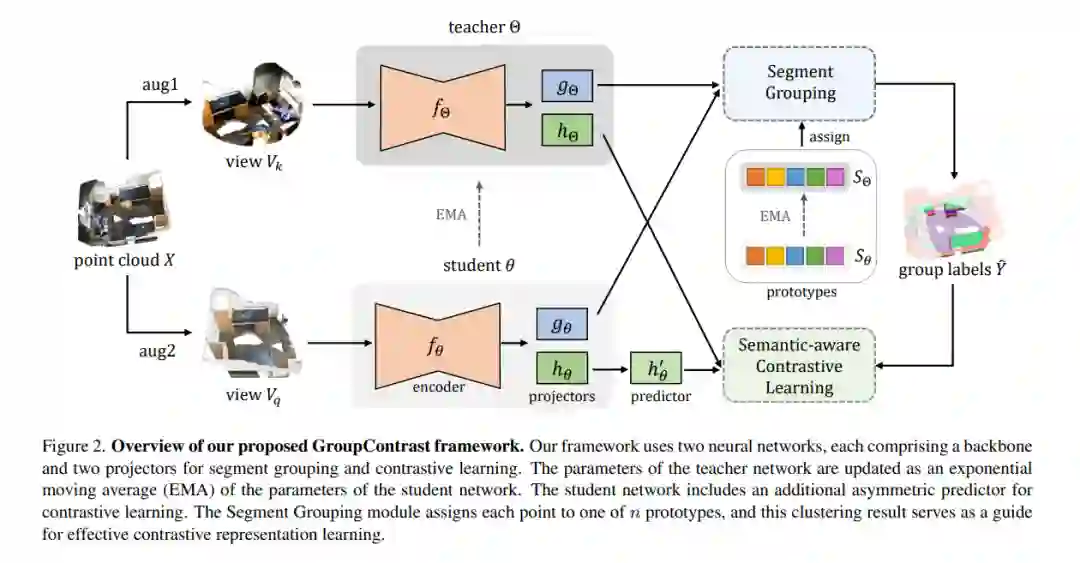

自监督三维表示学习旨在从大规模未标记点云中学习有效的表示。大多数现有方法采用点区分作为预文任务,将两个不同视图中匹配的点作为正对,不匹配的点作为负对。然而,这种方法经常导致语义上相同的点具有不相似的表示,从而产生大量的假负例并引入“语义冲突”问题。为了解决这个问题,我们提出了GroupContrast,一种结合段落分组和语义感知对比学习的新方法。段落分组将点划分为语义上有意义的区域,这增强了语义连贯性并为随后的对比表示学习提供了语义指导。语义感知对比学习增强了从段落分组中提取的语义信息,并有助于缓解“语义冲突”的问题。我们在多个三维场景理解任务上进行了广泛的实验。结果表明,GroupContrast学习到了语义上有意义的表示,并实现了有希望的迁移学习性能。

成为VIP会员查看完整内容