【导读】作为计算机视觉领域的三大国际顶会之一,ICCV 每年都会吸引全球领域众多专业人士参与。不久前,ICCV2021接收结果已经公布,本次ICCV共计 6236 篇有效提交论文,其中有 1617 篇论文被接收,接收率为25.9%。

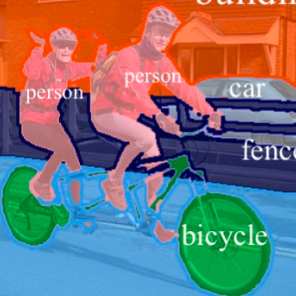

为此,专知小编为大家整理了五篇 ICCV 2021 语义分割(Semantic Segmentation)相关研究和应用,这块这几年一直比较受关注——弱监督语义分割、半监督语义分割、无监督语义分割、少样本语义分割、实例分割

CVPR2021CL、CVPR2021DA、CVPR2021IVC、CVPR2021PID、CVPR2021IC、CVPR2021VU、CVPR2021OD、CVPR2021OT、CVPR2021AR

1. Leveraging Auxiliary Tasks with Affinity Learning for Weakly Supervised Semantic Segmentation

作者:Lian Xu, Wanli Ouyang, Mohammed Bennamoun, Farid Boussaid, Ferdous Sohel, Dan Xu

摘要:在缺乏大量标记数据的情况下,语义分割是一项具有挑战性的任务。仅依靠具有图像级标签的类激活图 (CAM) 作为语义分割的监督信息是远远不够的。因此,先前的工作用预训练的模型来生成粗粒度的显著图(Saliency Map),以指导伪分割标签的生成。然而,常用的离线启发式生成过程不能充分利用这些粗显著图的优点。受显著的任务间相关性的启发,本文提出了一种新的弱监督多任务框架,称为AuxSegNet,利用显著性检测和多标签图像分类作为辅助任务,仅使用图像级真实标签来改进语义分割的主要任务。受它们相似的结构化语义的启发,本文还提出从显著性和分割表示中学习跨任务全局像素级亲和图。学习到的跨任务亲和性可用于改进显著性预测,并传播 CAM 映射,从而为这两个任务提供改进的伪标签。伪标签更新和跨任务亲和学习之间的相互促进,使得分割性能得到迭代改进。大量实验证明了本文所提出的辅助学习网络结构和跨任务亲和学习方法的有效性。该方法在具有挑战性的PASCAL VOC 2012和MS COCO基准测试中达到了最先进的弱监督分割性能。

论文: https://arxiv.org/abs/2107.11787

代码: https://github.com/xulianuwa/AuxSegNet

2. Re-distributing Biased Pseudo Labels for Semi-supervised Semantic Segmentation: A Baseline Investigation

作者:Ruifei He, Jihan Yang, Xiaojuan Qi

摘要:虽然自训练具有先进的半监督语义分割,但它严重受到现实世界语义分割数据集上的长尾类分布的影响,导致伪标记数据偏向于多数类。本文提出了一种简单而有效的分布对齐和随机采样 (DARS) 方法,来生成无偏伪标签,来与标记数据中估计的真实类别分布匹配。此外,本文还提供了渐进式数据增强和标记策略,以促进使用伪标记数据进行模型训练。Cityscapes 和 PASCAL VOC 2012 数据集的实验证明了本文方法的有效性。尽管很简单,但与最先进的方法相比,本文的方法表现不错。

论文: https://arxiv.org/abs/2107.11279

代码: https://github.com/CVMI-Lab/DARS

3. Labels4Free: Unsupervised Segmentation using StyleGAN

作者:Rameen Abdal, Peihao Zhu, Niloy Mitra, Peter Wonka

摘要:

本文为StyleGAN生成的目标对象提出了一个无监督的分割框架。本文基于两个主要观察结果。首先,StyleGAN生成的特征包含有价值的信息,可用于训练分割网络。其次,前景和背景通常可以被视为在很大程度上是独立的,并以不同的方式合成。对于本文的解决方案,本文提出使用分割分支来增强StyleGAN2生成器架构,并将生成器拆分为前景和背景网络。这使本文能够以无监督的方式为前景对象生成软分割掩码。在多个对象类别上,本文报告了与最先进的监督分割网络的可比结果,而与最佳的无监督分割方法相比,本文在定性和定量指标上都表现出了明显的改进。

论文: https://arxiv.org/abs/2103.14968

4. Mining Latent Classes for Few-shot Segmentation

作者:Lihe Yang, Wei Zhuo, Lei Qi, Yinghuan Shi, Yang Gao

摘要:少样本分割(FSS)旨在仅在给定几个带注释的样本的情况下分割不可见的类。现有方法存在特征破坏的问题,即在训练阶段将潜在的新类作为背景。本文的方法旨在缓解这个问题并增强潜在新类的特征嵌入。在本文的工作中,本文提出了一种新颖的联合训练框架。基于对支持-查询对的常规情景训练,本文添加了一个额外的挖掘分支,该分支通过可转移的子集群利用潜在的新类,并在背景和前景类别上采用新校正技术,以得到更稳定的原型。除此之外,本文的可转移子集群能够利用额外的未标记数据来进一步增强特征。在两个 FSS 基准测试中的大量实验表明,本文的方法在PASCAL-5i上mIOU提升3.7%,在COCO-20i上的mIOU提升7.0%,大幅优于以前的最先进技术,参数减少了74%,推理速度提升2.5 倍。

论文: https://arxiv.org/abs/2103.15402

5. Rank & Sort Loss for Object Detection and Instance Segmentation

作者:Kemal Oksuz, Baris Can Cam, Emre Akbas, Sinan Kalkan

摘要:本文提出Rank & Sort (RS) Loss,作为基于排序的损失函数来训练深度目标检测和实例分割方法(即视觉检测器)。RS Loss监督分类器,分类器是这些方法的一个子网络,来将每个正例排在所有负例之上,并根据(wrt.)它们的连续定位质量(例如 Intersection-over-Union - IoU)在它们之间对正例进行排序。为了解决排序和排序的不可区分性,本文将错误驱动更新与反向传播的结合重新制定为Identity Update,这使本文能够对正样本中的新排序错误进行建模。使用 RS Loss,本文显著地简化了训练:(i)由于本文的排序目标,分类器优先考虑正例,而无需额外的辅助头(例如,centerness、IoU、mask-IoU),(ii)由于基于排序的性质,RS Loss对类不平衡具有鲁棒性,因此,不需要采样启发式(iii)本文使用无微调任务平衡系数来解决视觉检测器的多任务性质。使用 RS Loss,本文仅通过调整学习率来训练七个不同的视觉检测器,并表明它始终优于基线:例如本文的 RS Loss将 (i) 在 COCO 数据集上,Faster R-CNN 上box AP提高了3,而 aLRP Loss(基于排名的基线)提高了2,(ii)LVIS 数据集上,具有重复因子采样(RFS)的 Mask R-CNN 上mask AP提高了 3.5(稀有类约为 7);并且也优于所有同行。