【CMU-TACL2020】低资源跨语言实体链接,Low-resource Crosslingual EntityLinking

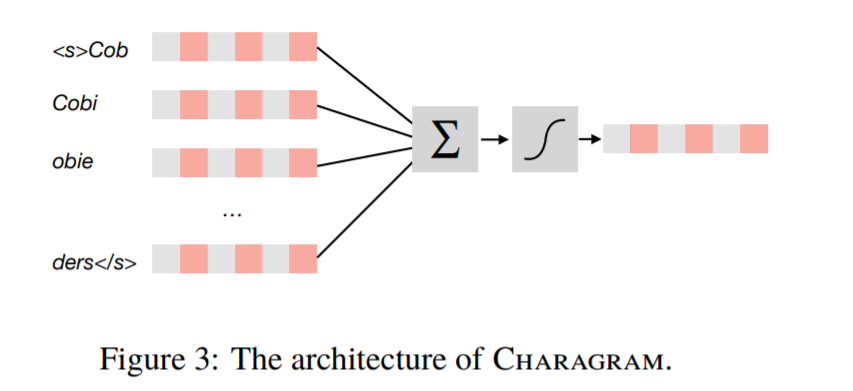

跨语言实体链接(Cross-lingual entity linking, XEL)的任务是在目标语言知识库(target-language知识库,KB)中查找从源语言文本中提取的提及内容。(X)EL的第一步是生成候选实体,它从目标语言知识库中为每个提到的候选实体检索貌似合理的候选实体列表。基于Wikipedia资源的方法已经在资源相对较多的语言(HRL)领域被证明是成功的,但是这些方法不能很好地扩展到资源较少的语言(LRL),即使有,也只有很少的Wikipedia页面。近年来,迁移学习方法已被证明可以利用相近语言的资源来降低语言学习对资源的需求,但其性能仍远远落后于资源丰富的语言学习。在本文中,我们首先评估了当前低资源XEL的实体候选生成方法所面临的问题,然后提出了三个改进:(1)减少实体提及和知识库条目之间的脱节,(2)提高模型对低资源场景的鲁棒性。这些方法很简单,但是很有效:我们在7个XEL数据集上对我们的方法进行了实验,发现与最先进的基线相比,它们在前30名标准候选召回中平均产生16.9%的收益。我们改进的模型还使端到端XEL的in-KB精度平均提高了7.9%。

https://www.zhuanzhi.ai/paper/e8972843597f44adc664c0abc282c3ee

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CEL” 就可以获取《低资源跨语言实体链接,Low-resource Crosslingual EntityLinking》专知下载链接

登录查看更多

相关内容

专知会员服务

36+阅读 · 2020年5月4日

专知会员服务

22+阅读 · 2020年4月22日

专知会员服务

35+阅读 · 2020年4月14日

专知会员服务

25+阅读 · 2020年4月5日

专知会员服务

26+阅读 · 2020年3月26日

Arxiv

13+阅读 · 2019年11月14日

Arxiv

9+阅读 · 2018年5月11日