名校CS硕士申机器学习PhD三波“全拒得”,这么多人和他同病相怜?

铜灵 发自 凹非寺

量子位 出品 | 公众号 QbitAI

我也不差,可为什么就是申不到博士?

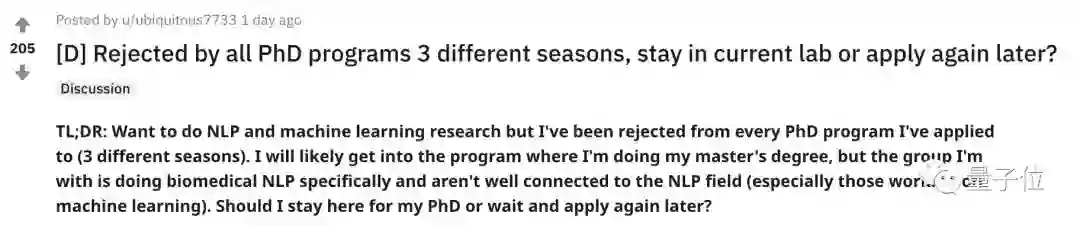

昨天,网友ubiquitous7733在Reddit论坛吐槽,自己想申请NLP和机器系学习方向的博士生,尝试过纽约大学、哥伦比亚大学, 斯坦福、MIT, CMU等8所学校,申请了三波至今未果,现在开始不断怀疑自己。

可能是戳中了很多AI er的心声,这篇帖子热度迅速飙升,引来多方网友激烈探讨。

一作3篇,学校排名前15,申不到的为啥是我

ubiquitous7733觉得,自身的条件并不差,NLP与机器学习科班出身,还能说是小有成果。

他表示,自己目前在一所排名前15的高校读计算机硕士学位,过去一年研究NLP在生物医学方面的应用,硕士期间作为一作发表论文两篇。

在读本科时,小哥也读的是相关专业,有过两年的机器学习研究经验,发表了6篇论文,其中一作一篇。要说小哥除了学术界,在工业界也积累了经验。本科毕业后,当了两年的软件工程师。

小哥表示,如论是本科还是研究生,GPA分数都还比较理想,本科4.0分,研究生3.92分,怎么看怎么没毛病。

这样的条件,为什么连续申博都失败了?

他推测,最可能的原因,是自己就错在了研究方向上。

自己虽然是计算机科班出身,但小哥目前的实验室与NLP关系不大,所研究的领域也多是在生物信息学期刊和会议上发表。虽然中途也尝试与一位NLP教授合作,但由于沟通风格的原因不久后也分道扬镳。

连续申请了3个学期的NLP/机器学习博士被拒后,困境来了。

是追逐自己的本心,进一步申请?还是就在现在的实验室里先读上博士,慢慢与NLP领域建立联系曲线救国?

网友听闻ubiquitous7733的求学经历后,也各抒已见。

有人对楼主的经历表示不理解,认为GRE和GPA的成绩在申博期间并不值得炫耀,成绩只是最低门槛罢了,申请人在某一领域足够优秀,学校也不会太在意成绩如何,顶会论文才是第一位。

网友soulslicer0也有相同的困惑,他已经发表了5篇论文,其中三篇为一作,甚至又一篇还发表在了机器学习顶会上,但仍然申请不到好学校的硕士,因为自己的本科成绩太差了。

还有在“深水区”的申请者给楼主鼓励,他共申请了3年半的时间,拒绝信都收了15封了,但终于苦尽甘来现在成为一名机器学习博士生。

AI领域博士生的门槛怎么这么高了?

申博难

申请AI相关专业博士难于登天,是这几年研究人员的普遍遭遇。

在知乎问题《如何看待AI方向PhD申请过于激烈的竞争》问题下,知乎大神周博磊表示,MIT AI方向的录取情况极为严峻的,共收到2000份申请材料,最终只有十几二十几个能通过筛选。

也不是MIT才出现过这种盛景。

据匿名知乎网友爆料,Berkeley去年PhD AI Track申请的也有两三千学生,很多几篇顶会一作的同学也都被拒之门外。

申请博士屡次被拒,真的是因为自身条件太差吗?在知乎上,多位已经过来的大神提出了自己的看法。

AI话题优秀回答者周博磊表示,推荐信非常重要,一篇大佬的推荐强推可能比一两篇顶会管用,甚至1篇CVPR+1篇北美圈内认识的老板推荐信 > 4篇CVPR。

深度学习编译器TVM的提出者陈天奇认为,推荐信一定需要牛人强推,否则会有负面影响。

陈天奇建议,写推荐信一定要找很了解你的人,可能的话直接问你的推荐人对你的评价。

除了推荐信,还有其他一些潜在的加分因素。

机器学习话题优秀回答者豆豆豆豆豆豆豆叶认为,如何体现自己独立思考问题的能力、英语好甚至年龄小都是你的隐形加分项。

出名还是得趁早啊。

路子多

条条大路通罗马,除了千军万马过名校的博士,还有很多其他的路子可以让自己更好。

周博磊认为,如果本科尽早去国内几家大的计算机视觉公司实习攒顶会论文,也是曲线救国的一种方式。在知名实验室积累一年半载的实习经验再重返学术界也未尝不可。AI产学研联合这么紧密,对自己的帮助也会不小。

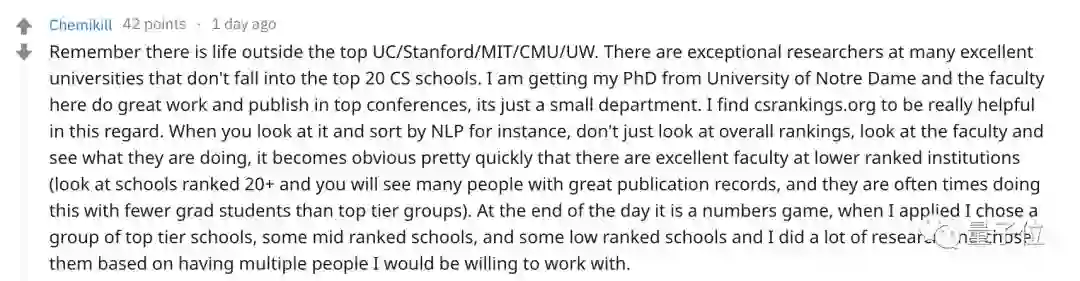

知乎网友Xinru Yang的回答也获得了不少好评,他觉得非计算机专业四大名校(CMU、MIT、斯坦福和UC Berkeley)的博士外,其他学校也未尝不可,排名30~50的学校考虑一下?

Reddit网友Chemikill也持类似的观点,不要看整体排名,多关注下具体领域的老师们都在研究什么,对整个求学生涯的帮助更大。

量子位在这里也祝各位AI er,今年诸事顺利,学有所成。

— 完 —

加入社群

量子位现开放「AI+行业」社群,面向AI行业相关从业者,技术、产品等人员,根据所在行业可选择相应行业社群,在量子位公众号(QbitAI)对话界面回复关键词“行业群”,获取入群方式。行业群会有审核,敬请谅解。

此外,量子位AI社群正在招募,欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“交流群”,获取入群方式。

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

喜欢就点「好看」吧 !