大规模、高性能,清华、聆心智能推出中文开放域对话预训练开源模型OPD

机器之心专栏

本文将介绍清华大学 CoAI 小组与北京聆心智能科技有限公司联合在中文对话预训练基座模型取得的最新阶段性进展:OPD。

自从二十世纪五十年代著名的图灵测试提出将人机对话能力作为衡量机器智能的重要指标后,对话系统便成为自然语言处理领域的重要研究方向,受到学术界和工业界的广泛关注。随着近期预训练技术的发展,对话系统的能力得到了显著提升,众多开源开放、性能优异的英文对话预训练基座模型也成为了对话系统相关研究和应用的基石。

为了推动中文对话系统领域的发展,清华大学交互式人工智能课题组(CoAI)长期以来一直致力于构建开源的中文开放领域对话预训练基座模型。从 CDial-GPT 到 EVA1.0,再到 EVA2.0,我们不断努力,持续提升中文对话基座模型的性能。然而需要承认的是,相比于英文开源对话模型(如 Meta 的 BlenderBot),中文对话预训练模型的对话能力仍存在诸多不足。因此,我们期望进一步突破中文对话预训练模型性能的边界。

本文将介绍清华大学 CoAI 小组与北京聆心智能科技有限公司联合在中文对话预训练基座模型取得的最新阶段性进展:OPD,Open-Domain Pre-trained Dialogue Model。

它具有如下优势:

大规模:OPD 的模型参数量为 6.3B,是目前世界上规模最大的开源中文对话预训练模型

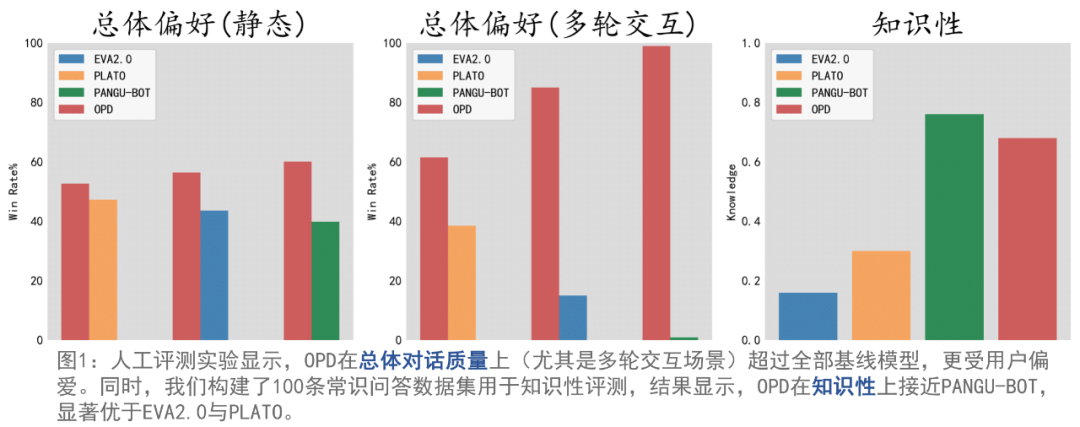

高性能:我们通过自动评测和人工评测来全面评估 OPD 的性能。评测结果显示,OPD 兼顾出色的闲聊能力与知识问答能力。得益于此,OPD 的多轮交互能力尤其突出,能够与用户进行多轮、深入的对话交互,性能显著优于 EVA2.0, PLATO 和 PANGU-BOT,更受用户偏爱。

开源开放:我们后续计划逐步开源一系列中文对话模型相关生态,推动中文对话领域发展。具体包括:

中文对话生成模型:OPD

多维度中文对话评价模型:对话信息量、相关性、一致性、安全性等多个维度各自的评价模型。

性能

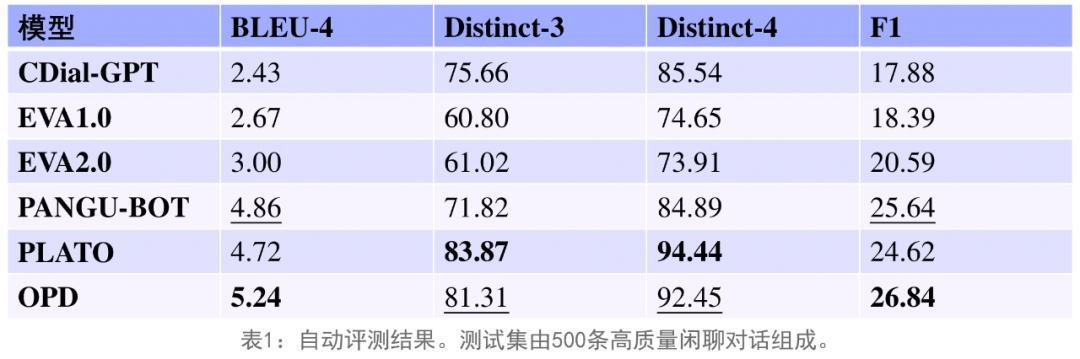

自动评测

我们构建了包含 500 条对话数据的高质量评测集,并首先在该评测集上进行了自动评测。OPD 在 BLEU-4 和 F1 等自动指标上均能达到现有中文对话模型的最优性能,同时在多样性指标 Distinct-3/4 上也能达到与 PLATO 相近的性能。

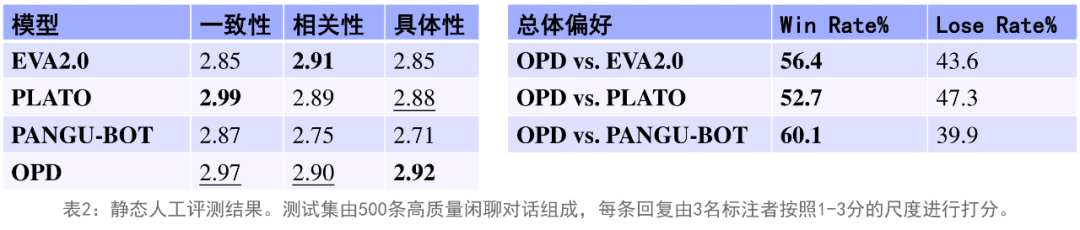

人工评测(静态)

我们进一步在包含 500 条对话数据的评测集上进行了静态人工评测。针对每条对话数据的输入信息,使所有模型都生成回复,每条回复由 3 位标注者在一致性、相关性、具体性上按照 1-3 分的尺度来进行打分。OPD 在具体性上能够超过所有基线模型达到最优性能,在一致性和相关性上也能和最优的基线模型达到相似的性能。

然后我们进行了配对的静态人工评测,具体做法是针对每条对话数据的输入信息,由 OPD 和基线模型分别生成回复,然后由标注者挑选其中总体质量更高的回复。OPD 在配对人工评测中能够优于所有基线模型,达到目前中文对话模型的最优性能。

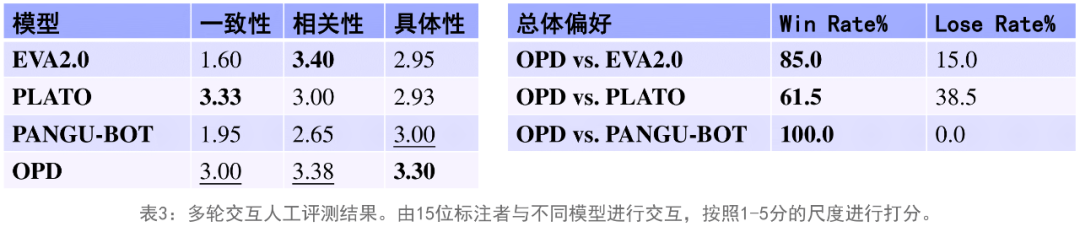

人工评测(多轮交互)

我们还招募了 15 位标注者进行了多轮交互式人工评测。每位标注者需预先选定 3 个话题及对话开头,分别和各个中文对话模型进行对话,我们要求每次对话的轮数至少为 16。标注者在交互后根据一致性、相关性和具体性三个维度按照 1-5 分的尺度进行打分,并按照总体质量对不同对话模型在同一个对话开头的表现进行偏好选择。交互式评测的结果和静态评测相似,OPD 在具体性和总体质量上显著超过了所有基线模型,而在一致性和相关性上与最优基线模型表现相近。

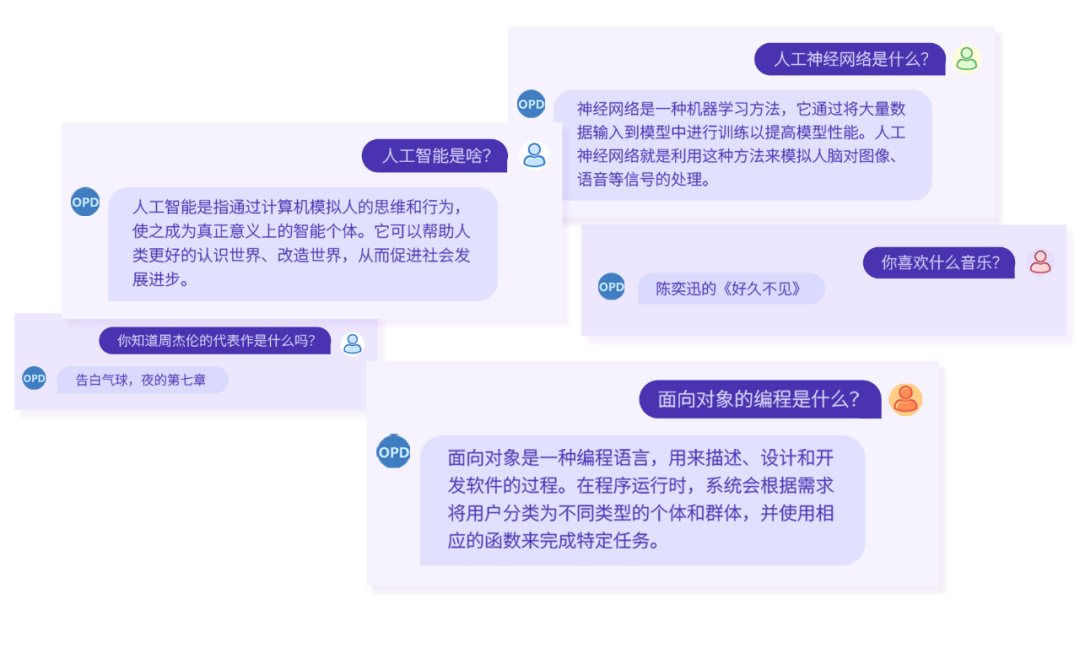

交互样例

预训练

预训练数据集

OPD 使用的数据均来自公开可爬取、可访问的数据源。我们在实验中发现,相比于通用预训练语言模型,对话预训练模型对于数据的质量更加敏感。因此,我们设计了严格、全面的数据清洗流程,最终筛选出 70GB 高质量对话数据用于 OPD 的预训练,清洗前后的数据留存比约 10%。

模型架构

OPD 采用 UniLM 架构,共包含 6.3B 参数,采用语言模型作为预训练任务。为保证 OPD 的多轮对话能力,我们将模型最大截断长度设为 512。OPD 在预训练阶段引入了 soft prompt,以促进下游任务上参数高效的微调。更多细节将在后续发布的技术报告中说明。

未来工作

OPD 目前仍处于 “初生” 状态,我们欢迎广大用户和研究人员加入 OPD 的社区,共同推进中文对话的发展。CoAI 小组也将继续扎根中文对话领域,持续优化 OPD。未来的发展方向如下:

从人类反馈中学习:与人类交互是对话模型最自然的应用方式,我们也在交互实验中发现了当前版本 OPD 存在的一些缺陷。在部署 OPD 后,我们将根据 human-bot 的交互反馈,持续改进 OPD 的性能,并定期发布版本迭代,与中文对话社区分享我们最新的成果。

OPD 的持续微调:我们将通过持续微调的方式,赋予 OPD 新的下游技能(例如:情感安抚、知识检索),进一步提升 OPD 的表现。

参考文献:

1.Wang Y, Ke P, Zheng Y, et al. A large-scale chinese short-text conversation dataset[C]//CCF International Conference on Natural Language Processing and Chinese Computing. Springer, Cham, 2020: 91-103.

2.Zhou H, Ke P, Zhang Z, et al. Eva: An open-domain chinese dialogue system with large-scale generative pre-training[J]. arXiv preprint arXiv:2108.01547, 2021.

3.Gu Y, Wen J, Sun H, et al. Eva2. 0: Investigating open-domain chinese dialogue systems with large-scale pre-training[J]. arXiv preprint arXiv:2203.09313, 2022.

4.Roller S, Dinan E, Goyal N, et al. Recipes for Building an Open-Domain Chatbot[C]//Proceedings of the 16th Conference of the European Chapter of the Association for Computational Linguistics: Main Volume. 2021: 300-325.

5.Shuster K, Xu J, Komeili M, et al. BlenderBot 3: a deployed conversational agent that continually learns to responsibly engage[J]. arXiv preprint arXiv:2208.03188, 2022.

6.Bao S, He H, Wang F, et al. PLATO-2: Towards Building an Open-Domain Chatbot via Curriculum Learning[C]//Findings of the Association for Computational Linguistics: ACL-IJCNLP 2021. 2021: 2513-2525.

7.Mi F, Li Y, Zeng Y, et al. PANGUBOT: Efficient Generative Dialogue Pre-training from Pre-trained Language Model[J]. arXiv preprint arXiv:2203.17090, 2022.

8.Dong L, Yang N, Wang W, et al. Unified language model pre-training for natural language understanding and generation[J]. Advances in Neural Information Processing Systems, 2019, 32.

9.Gu Y, Han X, Liu Z, et al. PPT: Pre-trained Prompt Tuning for Few-shot Learning[C]//Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2022: 8410-8423.

10.Lester B, Al-Rfou R, Constant N. The Power of Scale for Parameter-Efficient Prompt Tuning[C]//Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing. 2021: 3045-3059.

11.Ju D, Xu J, Boureau Y L, et al. Learning from data in the mixed adversarial non-adversarial case: Finding the helpers and ignoring the trolls[J]. arXiv preprint arXiv:2208.03295, 2022.

12.Bai Y, Jones A, Ndousse K, et al. Training a Helpful and Harmless Assistant with Reinforcement Learning from Human Feedback[J]. arXiv preprint arXiv:2204.05862, 2022.

13.Liu S, Zheng C, Demasi O, et al. Towards Emotional Support Dialog Systems[C]//Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers). 2021: 3469-3483.

14.Thoppilan R, De Freitas D, Hall J, et al. Lamda: Language models for dialog applications[J]. arXiv preprint arXiv:2201.08239, 2022.

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com