OpenAI击败Dota 2世界冠军后记:如何训练你的AI

大数据文摘出品

来源:OpenAI

编译:张强

本周末OpenAI Five与世界冠军Dota 2团队OG的总决赛中,它2比0大败对手。

这意味着OpenAI Five是第一个在电竞游戏中击败世界冠军的AI。

OpenAI Five和DeepMind的AlphaStar之前曾私下击败过优秀的职业选手,但却输掉了职业比赛。这次在直播中的表现可以说出乎了大多数人的意料。

在比赛后,OpenAI也发博文总结了这次比赛的经验以及在也公布了他们在训练OpenAI Five过程中的经验教训。一起来看!

在OpenAI Five 的总决赛中,还有两个惊喜:

1.尽管训练过程专注于击败其他机器人,但OpenAI Five具有了如何成为人类队友的初级能力。这很容易将竞争性AI转变为合作型AI,通过积极的开发工作,未来的AI系统会对人类非常有益。

2。最后的测试将让我们回答一个重要的研究问题:在多大程度上OpenAI Five可以被利用或以其他方式被确定地击败。这可能是有史以来最大规模的高强度深度强化学习智能体的部署,人们可以有意识地与之交互。

为什么是Dota?

启动OpenAI Five是为了解决现有深度强化学习算法无法实现的问题。希望通过解决当前方法无法解决的问题,这需要大幅增加我们工具的功能。我们需要复杂的算法思想,例如分层强化学习,但我们对所发现的东西感到惊讶:我们对这个问题所需的基本改进是规模。实现和利用这种规模并不容易,这正是我们研究工作的主要内容!

为了构建OpenAI Five,我们创建了一个名为Rapid的系统,让我们以前所未有的规模运行PPO。结果超出了我们最大的期望,我们生产了世界级的Dota机器人,没有受到任何基本的性能限制。

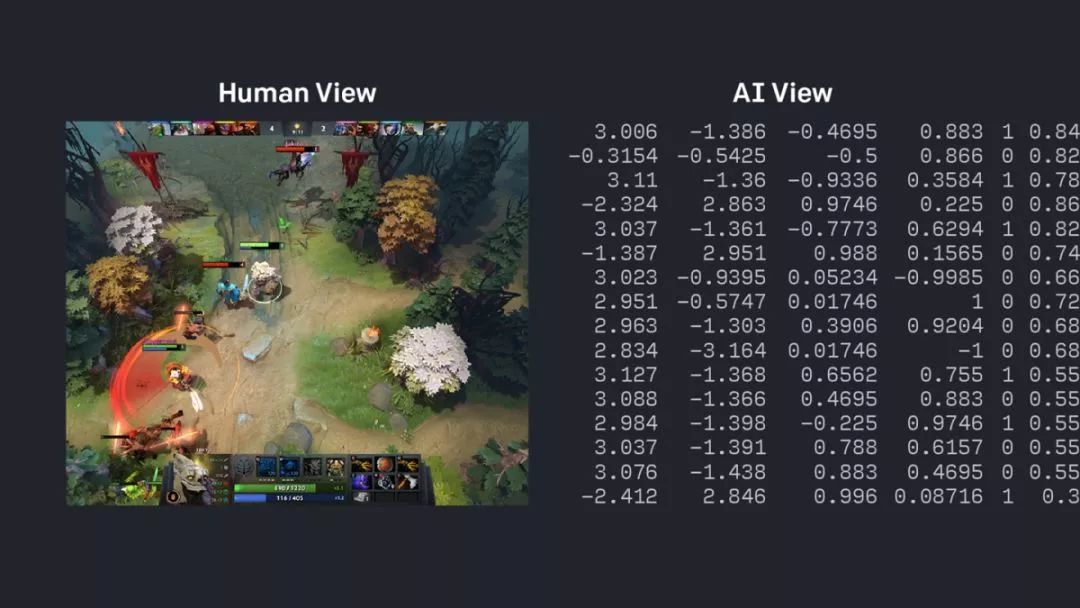

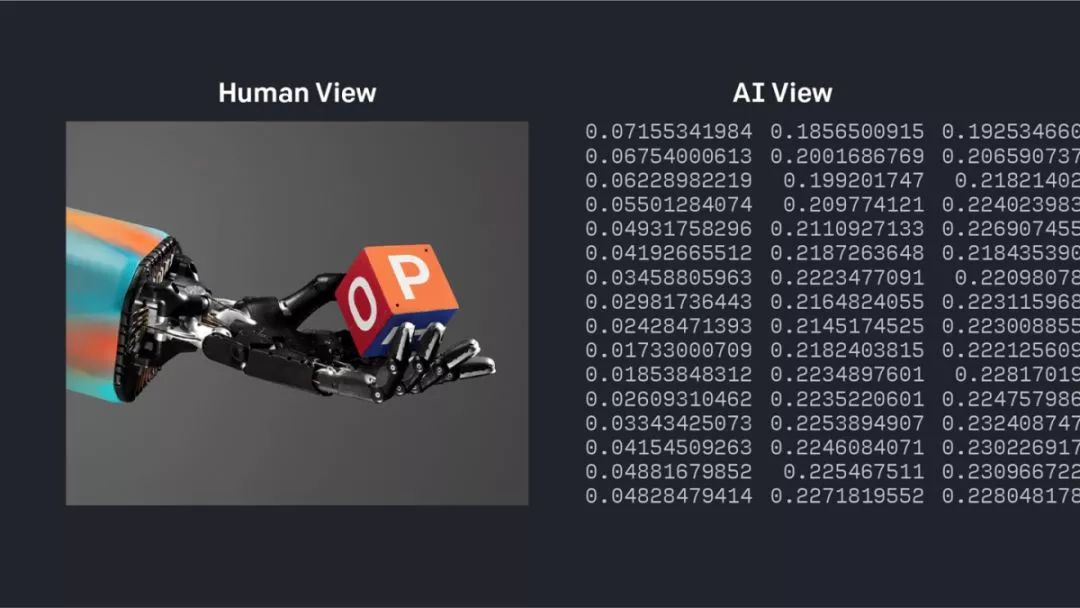

当今RL算法令人惊讶的强大功能是以大量经验为代价,这在游戏或模拟环境之外是不切实际的。这种限制可能没有声称的那么糟糕,例如,我们使用Rapid来控制机器手以灵巧地重新定位块,这完全是在模拟中训练并在物理机器人上执行。但我们认为减少经验量是RL的下一个挑战。

今天,OpenAI Five作为竞争者将要退休,但取得的进步和发展的技术将继续驱动我们未来的工作。这不是我们Dota工作的结束——我们认为Dota对于RL开发来说比现在使用的标准环境更具有内在的趣味和困难(现在这已经很好理解!)。

算力

周六OpenAI Five的胜利与2018年国际赛的失败相比,是由于一次重大变化:训练计算量增加了8倍。在项目的许多前期阶段,我们通过提高训练规模来推动进一步的发展。但是在国际赛之后,我们已经将我们项目计算量的绝大部分用于训练单一的OpenAI Five模型。所以,我们以唯一可用的方式增加了计算规模:更长久的训练。

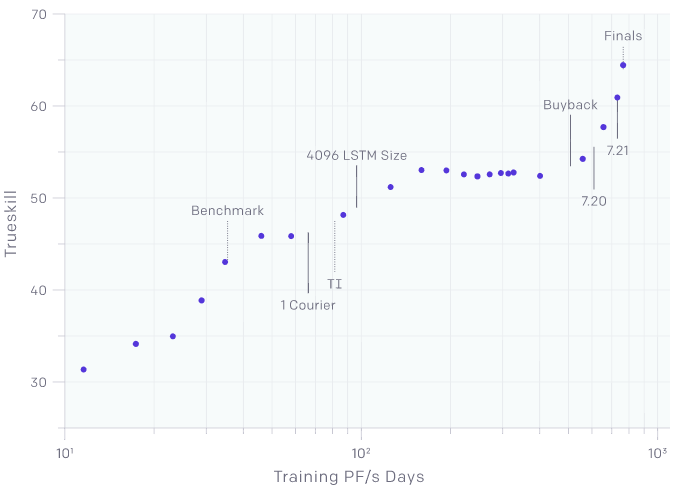

OpenAI Five的TrueSkill。因为我们已经应用了额外的训练计算,其中线条划分了主要的系统变化(转向单一通道;将LSTM大小增加到4096单位;升级到补丁版本7.20和7.21)。该图大致是线性的,这意味着OpenAI Five从额外的计算中不断受益(注意这是一个双对数图,因为x轴是计算量的对数,而TrueSkill大致对应于指数进展)。这个图表评估了最终游戏规则(1个通道,补丁7.21等)上的所有机器人——甚至那些在旧游戏规则上训练过的机器人。任何这些之后的陡坡表明OpenAI Five适应了这种变化; 根据变化,评估可能对之前的版本不公平。

总的来说,当前版本的OpenAI Five已经消耗了800 petaflop / s-days,并且在10个实时月内经历了大约45,000年的Dota自我游戏(从国际赛上的1.5个实时月份开始,大约10,000年),平均每天250年的模拟经验。OpenAI Five的总决赛版本与TI版本相比,胜率为99.9%。

迁移学习

尽管模型大小和游戏规则发生了变化(包括一些相当大的游戏补丁更新和新实现的功能),但目前版本的OpenAI Five自2018年6月以来一直在不断训练。在每种情况下,我们都能够将模型转移并继续训练,这对于其他领域的RL来说是一个开放的挑战。据我们所知,这是RL智能体第一次使用如此长期的训练课程进行训练。

为了完成这项工作,我们继续充实我们的诊断工具,以便我们可以从训练有素的参数开始,甚至跨越实质性的架构变化。

更多英雄

我们看到从5个到18个英雄的训练速度并没有明显减弱。我们假设对更多英雄来说也是如此,在国际赛之后,我们投入了大量精力来整合新的英雄。

我们花了几个星期的时间训练英雄池至25个英雄,将这些英雄训练到大约5k MMR(大约95%的Dota玩家)。尽管他们还在进步,但他们的学习速度还不够快,无法在总决赛之前达到职业水平。我们尚未有时间调查原因,但我们的怀疑包括模型容量不足,以及需要更好的匹配扩展的英雄池去要求更多的训练时间来让新英雄赶上老英雄。想象一下,当你习惯了某个英雄之后,学习新英雄是多么难!

我们相信这些问题从根本上是可以解决的,解决它们本身就很有趣。在总决赛中的可选英雄中删除了巫妖,可选英雄数量变为17位因为巫妖的能力在Dota7.20版本中发生了显著变化。

协同模式

它实际上感觉很好;我的冥界亚龙在某些时候为我献出了生命。他试图帮助我,想着“我确定她知道她在做什么”然后显然我没有。但是,你知道,他相信我。和[人类]一起时,我并没有获得这些。

——Sheever

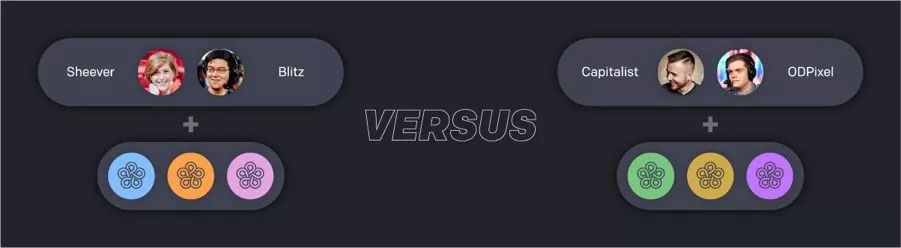

在总决赛期间,我们展示了OpenAI Five与人类一起在团队中的表现。这场比赛的特色是一队有Blitz和Sheever以及由Five控制的3个智能体,面对ODPixel、Capitalist和3个由Five的独立副本控制的智能体。

OpenAI Five与人类玩耍的能力为人类与AI互动的未来提供了一个很好的愿景,即AI系统协作并增强人类体验。我们的测试人员报告说,他们感觉得到了机器队友的支持,他们从这些先进的系统中学到了很多东西,而且整体来说这通常是一种有趣的体验。

请注意,OpenAI Five展示了零样本迁移学习:训练它让所有英雄都受到自身副本的控制,但是可以推广到控制一部分英雄,与人类协作或对抗。我们非常惊讶于这工作得很有效。事实上,我们考虑在国际赛上进行合作比赛,但认为需要专门的训练。

竞技场

我们正在推出OpenAI Five 竞技场,这是一项公共实验,我们将让任何人在竞争和合作模式下玩OpenAI Five。我们知道我们的1v1机器人可以通过更聪明的策略来利用; 我们不知道OpenAI Five在多大程度上也是如此,但我们很高兴邀请社区帮助我们找到答案!

竞技场于4月18日星期四太平洋标准时间下午6点开放,并于4月21日星期日太平洋标准时间晚上11:59关闭。

下一步是什么

一旦我们审查了OpenAI Five 竞技场的结果,我们将发布对OpenAI Five的更多技术分析。

之后,我们将继续使用OpenAI中的Dota 2环境。我们已经看到过去两年RL性能取得了快速进展,我们认为Dota 2将继续帮助我们推进可行的方案——无论是通过较少的数据还是真正的AI合作实现得力的表现。

相关报道:

https://openai.com/blog/how-to-train-your-openai-five/

实习/全职编辑记者招聘ing

加入我们,亲身体验一家专业科技媒体采写的每个细节,在最有前景的行业,和一群遍布全球最优秀的人一起成长。坐标北京·清华东门,在大数据文摘主页对话页回复“招聘”了解详情。简历请直接发送至zz@bigdatadigest.cn

志愿者介绍

后台回复“志愿者”加入我们