CVPR 2020 | MS COCO上达SOTA,目标检测实用trick:ATSS

加入极市专业CV交流群,与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度 等名校名企视觉开发者互动交流!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

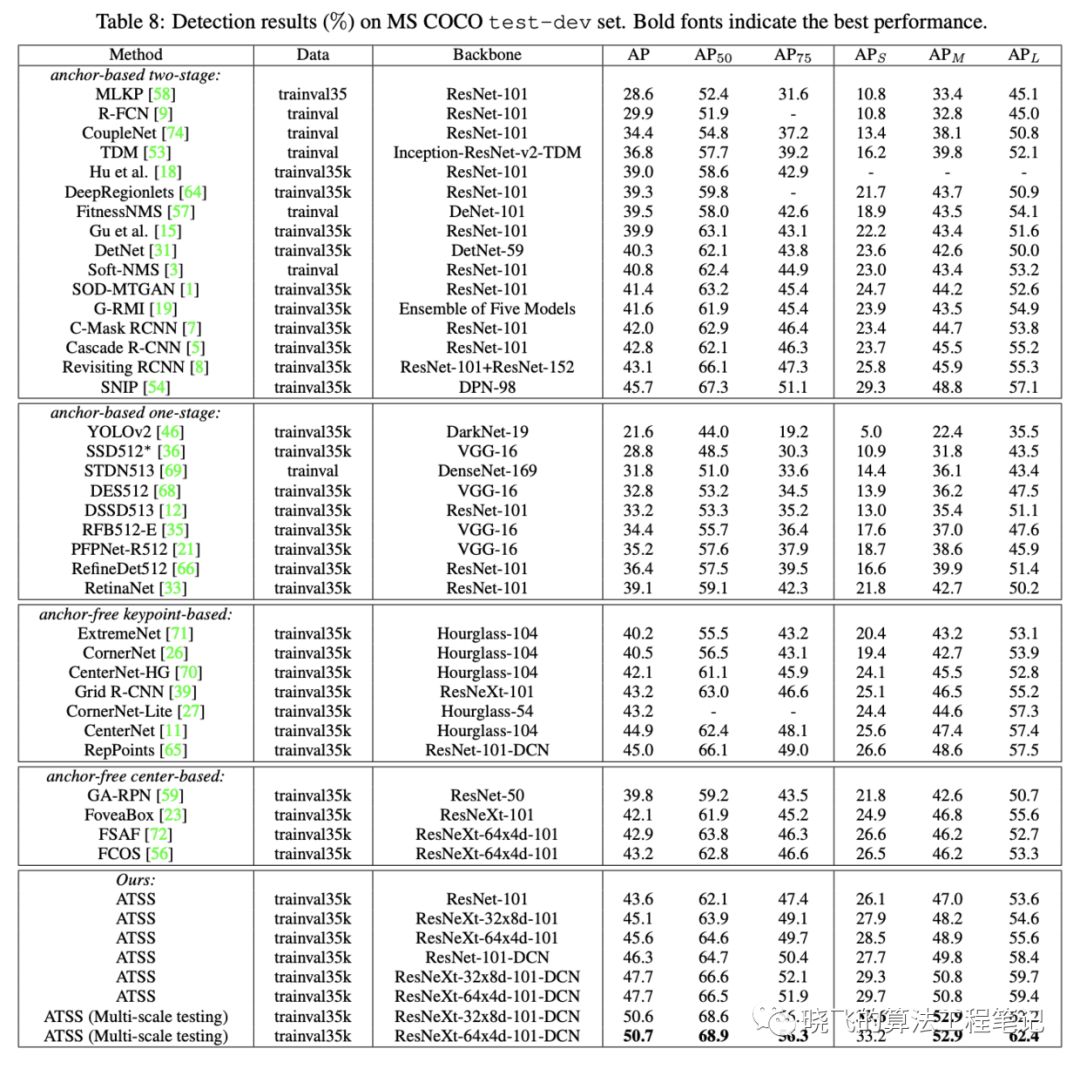

导读:论文指出one-stage anchor-based和center-based anchor-free检测算法间的差异主要来自于正负样本的选择,基于此提出ATSS(Adaptive Training Sample Selection)方法,该方法能够自动根据GT的相关统计特征选择合适的anchor box作为正样本,在不带来额外计算量和参数的情况下,能够大幅提升模型的性能。

-

论文地址:https://arxiv.org/abs/1912.02424 -

代码地址:https://github.com/sfzhang15/ATSS

Introduction

-

指出anchor-free和anchor-based方法的根本差异主要来源于正负样本的选择 -

提出ATSS( Adaptive Training Sample Selection)方法来根据对象的统计特征自动选择正负样本 -

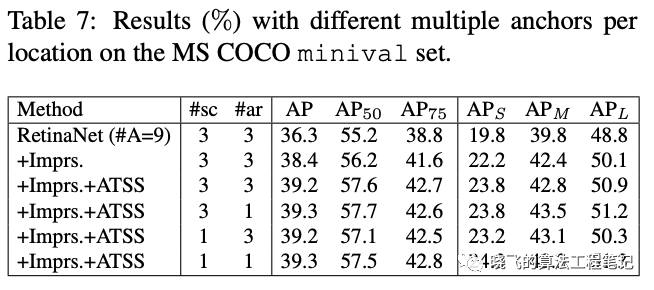

证明每个位置设定多个anchor是无用的操作 -

不引入其它额外的开销,在MS COCO上达到SOTA

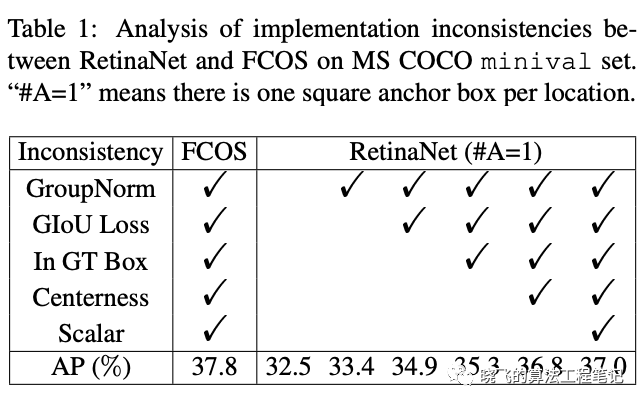

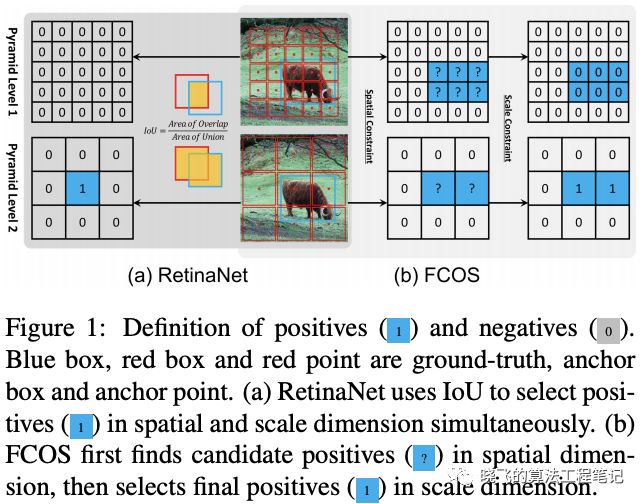

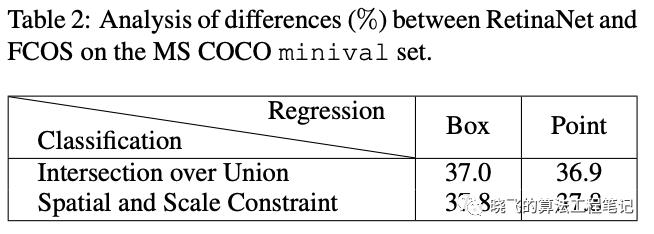

Difference Analysis of Anchor-based and Anchor-free Detection

Inconsistency Removal

Essential Difference

-

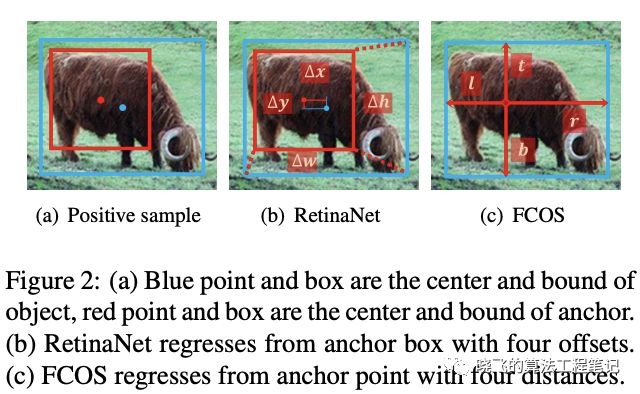

Classification

-

Regression

-

Conclusion

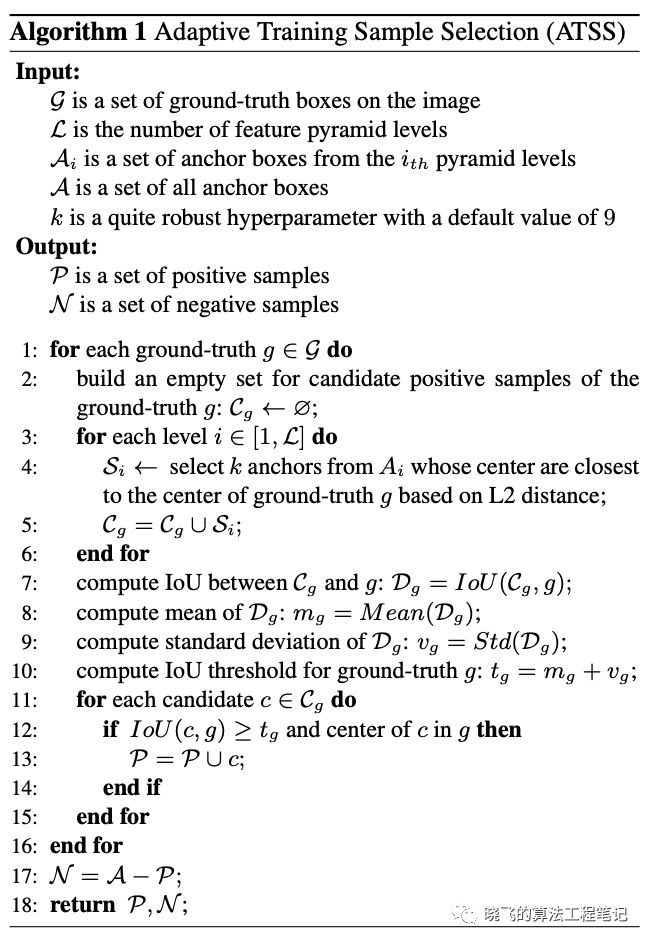

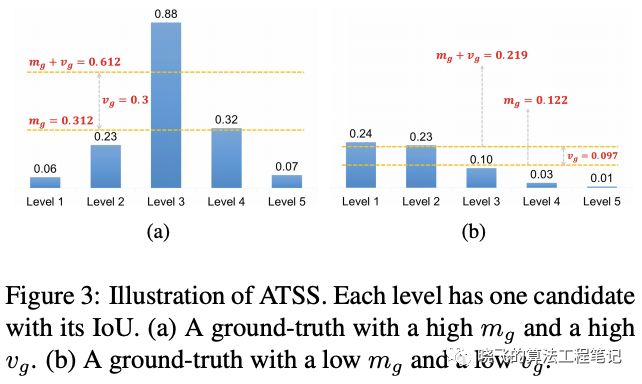

Adaptive Training Sample Selection

Description

-

Selecting candidates based on the center distance between anchor box and object

-

Using the sum of mean and standard deviation as the IoU threshold

-

Limiting the positive samples’ center to object

-

Maintaining fairness between different objects

-

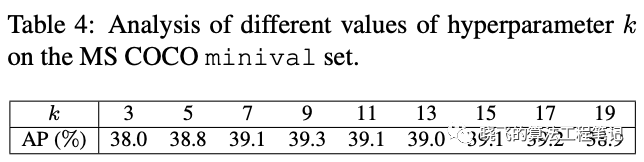

Keeping almost hyperparameter-free

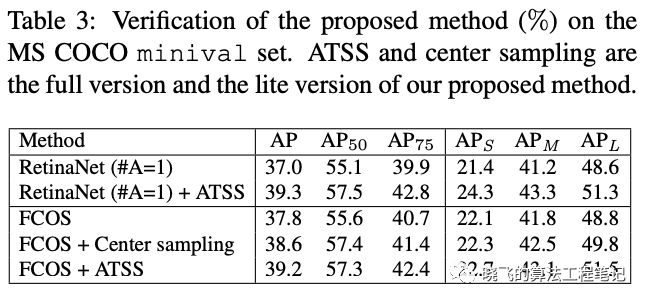

Verification

-

将RetinaNet中的正负样本替换为ATSS,AP提升了2.9%,这样的性能提升几乎是没有任何额外消耗的 -

在FCOS上的应用主要用两种:lite版本采用ATSS的思想,从选取GT内的anchor point改为选取每层离GT最近的top 个候选anchor point,提升了0.8%AP;full版本将FCOS的anchor point改为长宽为 的anchor box来根据ATSS选择正负样本,但仍然使用原始的回归方法,提升了1.4%AP。两种方法找到的anchor point在空间位置上大致相同,但是在FPN层上的选择不太一样。从结果来看,自适应的选择方法比固定的方法更有效

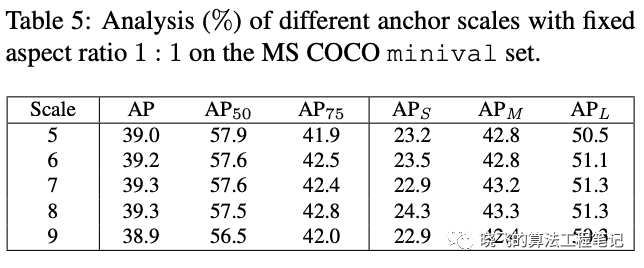

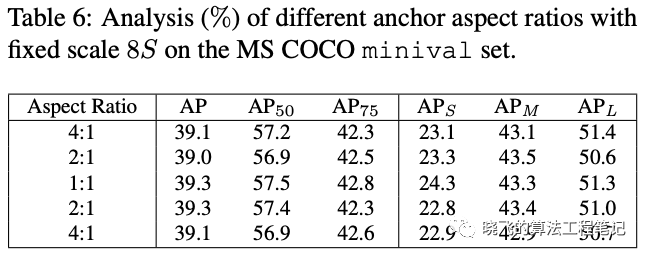

Analysis

Discussion

Comparison

Conclusion

极市平台视觉算法季度赛,提供真实应用场景数据和免费算力,特殊时期,一起在家打比赛吧!

添加极市小助手微信(ID : cv-mart),备注:研究方向-姓名-学校/公司-城市(如:目标检测-小极-北大-深圳),即可申请加入目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、图像分割等极市技术交流群,更有每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、行业技术交流,一起来让思想之光照的更远吧~

△长按添加极市小助手

△长按关注极市平台,获取最新CV干货

觉得有用麻烦给个在看啦~

登录查看更多

相关内容

专知会员服务

32+阅读 · 2020年2月1日

Arxiv

4+阅读 · 2018年9月23日

Arxiv

6+阅读 · 2018年7月19日

Arxiv

4+阅读 · 2018年7月4日