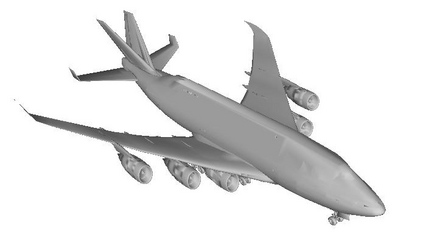

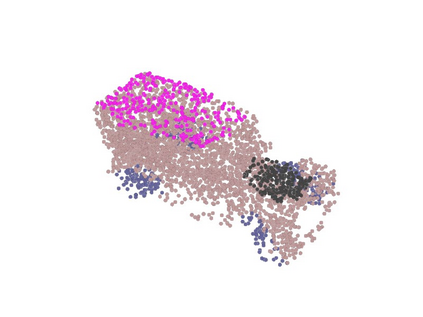

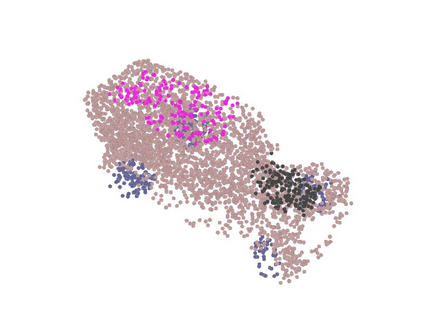

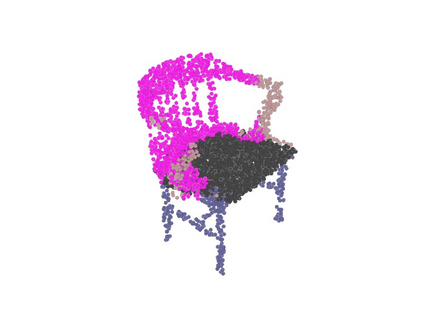

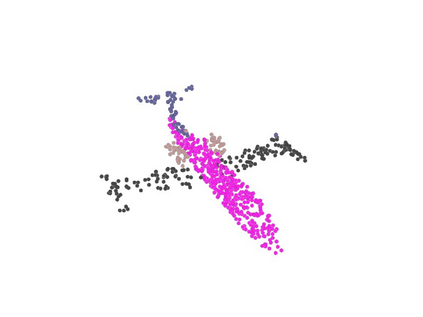

Neural implicit representations have shown substantial improvements in efficiently storing 3D data, when compared to conventional formats. However, the focus of existing work has mainly been on storage and subsequent reconstruction. In this work, we argue that training neural representations for both reconstruction tasks, alongside conventional tasks, can produce more general encodings that admit equal quality reconstructions to single task training, whilst providing improved results on conventional tasks when compared to single task encodings. Through multi-task experiments on reconstruction, classification, and segmentation our approach learns feature rich encodings that produce high quality results for each task. We also reformulate the segmentation task, creating a more representative challenge for implicit representation contexts.

翻译:与常规格式相比,在有效储存3D数据方面,神经隐含的表示方式已显示出显著改进;然而,现有工作的重点主要是储存和随后的重建;在这项工作中,我们认为,对两个重建任务的神经表示方式进行培训,加上常规任务,可以产生更普遍的编码,允许将同等质量的重建纳入单一任务培训,同时与单一任务编码相比,在常规任务方面提供更好的结果;通过关于重建、分类和分解的多任务试验,我们的方法学会了为每项任务产生高质量结果的丰富编码。我们还重新配置了分部分任务,为隐含的代表性环境提出了更具有代表性的挑战。