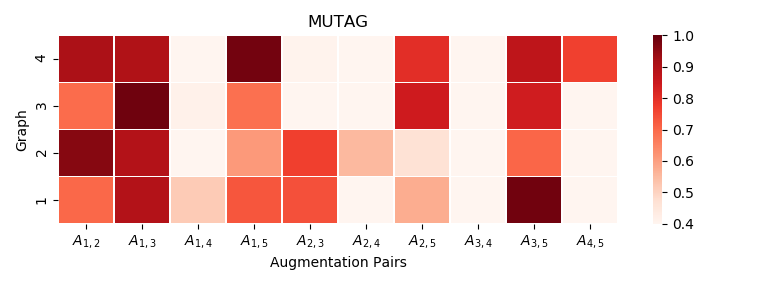

Graph contrastive learning (GCL) has emerged as an effective tool for learning unsupervised representations of graphs. The key idea is to maximize the agreement between two augmented views of each graph via data augmentation. Existing GCL models mainly focus on applying \textit{identical augmentation strategies} for all graphs within a given scenario. However, real-world graphs are often not monomorphic but abstractions of diverse natures. Even within the same scenario (e.g., macromolecules and online communities), different graphs might need diverse augmentations to perform effective GCL. Thus, blindly augmenting all graphs without considering their individual characteristics may undermine the performance of GCL arts.To deal with this, we propose the first principled framework, termed as \textit{G}raph contrastive learning with \textit{P}ersonalized \textit{A}ugmentation (GPA), to advance conventional GCL by allowing each graph to choose its own suitable augmentation operations.In essence, GPA infers tailored augmentation strategies for each graph based on its topology and node attributes via a learnable augmentation selector, which is a plug-and-play module and can be effectively trained with downstream GCL models end-to-end. Extensive experiments across 11 benchmark graphs from different types and domains demonstrate the superiority of GPA against state-of-the-art competitors.Moreover, by visualizing the learned augmentation distributions across different types of datasets, we show that GPA can effectively identify the most suitable augmentations for each graph based on its characteristics.

翻译:对比图形学习( GCL ) 已经成为学习不受监督的图形表达方式的有效工具。 关键的想法是通过数据增强使每个图形的两种扩大视图之间的协议最大化。 现有的 GCL 模型主要侧重于在给定的假想中对所有图形应用\ textit{ 均匀增强战略} 。 然而, 真实世界图形往往不是单一的,而是不同性质的抽象。 即使在同一个假想中( 例如, 宏观分子和在线社区), 不同的图形可能需要不同的增强功能来实施有效的 GCL 。 因此, 盲目地增加所有图形可能会损害GCL 艺术的单个特性。 处理此事宜, 我们提出第一个原则框架, 被称为\ textitit{ G} 匹配的对比学习。 即使在不同的假想中, 允许每个图表选择适合的增强功能。 GPOP 可以根据每个图表的上层和节点特性增加所有图表的扩展战略, 并且通过一个经过训练的直观的直观的直观的直径的直径分布模型, 将显示每个不同的直径的直径的直径的直径的直径的GL 模模型。 。 选择和直径的直径的直径的直径的直径的直径的直径方向的直径的直径的直方向模型, 可以展示显示每个方向的直径的直径向方向的直径向方向的直向方向的直径向方向的直径向方向模型显示每个方向的路径显示每个方向的路径式的直径方向的路径式的显示。