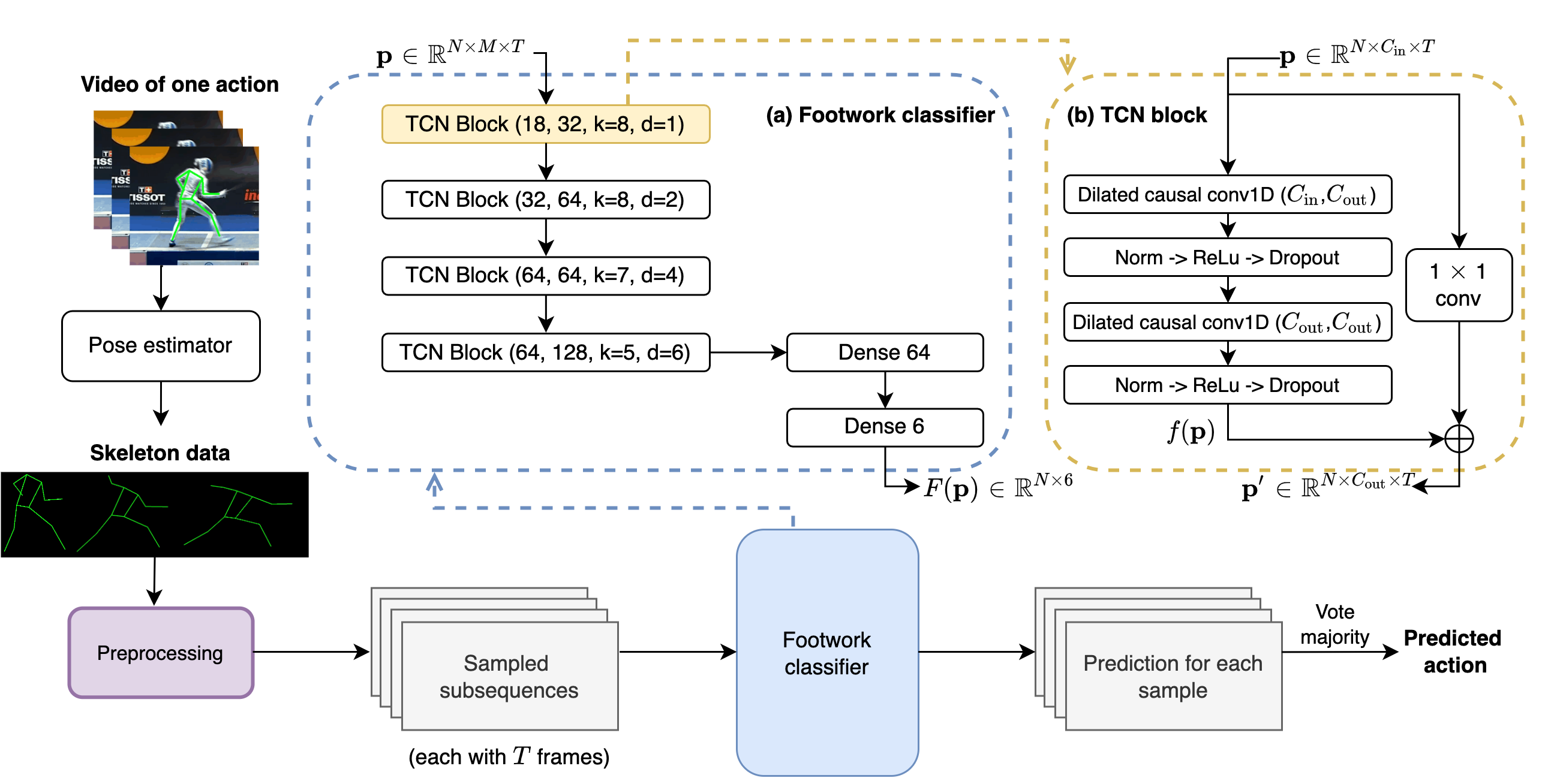

Current data analysis for the Canadian Olympic fencing team is primarily done manually by coaches and analysts. Due to the highly repetitive, yet dynamic and subtle movements in fencing, manual data analysis can be inefficient and inaccurate. We propose FenceNet as a novel architecture to automate the classification of fine-grained footwork techniques in fencing. FenceNet takes 2D pose data as input and classifies actions using a skeleton-based action recognition approach that incorporates temporal convolutional networks to capture temporal information. We train and evaluate FenceNet on the Fencing Footwork Dataset (FFD), which contains 10 fencers performing 6 different footwork actions for 10-11 repetitions each (652 total videos). FenceNet achieves 85.4% accuracy under 10-fold cross-validation, where each fencer is left out as the test set. This accuracy is within 1% of the current state-of-the-art method, JLJA (86.3%), which selects and fuses features engineered from skeleton data, depth videos, and inertial measurement units. BiFenceNet, a variant of FenceNet that captures the "bidirectionality" of human movement through two separate networks, achieves 87.6% accuracy, outperforming JLJA. Since neither FenceNet nor BiFenceNet requires data from wearable sensors, unlike JLJA, they could be directly applied to most fencing videos, using 2D pose data as input extracted from off-the-shelf 2D human pose estimators. In comparison to JLJA, our methods are also simpler as they do not require manual feature engineering, selection, or fusion.

翻译:加拿大奥林匹克围栏小组目前的数据分析主要由教练和分析员手工进行。由于围栏高度重复,但动态和微妙的动作,人工数据分析可能是低效和不准确的。我们提议将FenceNet作为一种新型结构,将精细雕刻的脚法分类。FenceNet采用基于骨架的行动识别方法,将数据作为输入并分类,该方法包括时间变幻网络,以捕捉时间信息。我们训练和评价FenceNet上的FenceNet, 其中包括10个栅栏,执行6种不同的脚步动作,每10至11次重复(652个总视频)。FenceNet在10倍交叉校对JNet下实现85.4%的精度,每个栅栏都作为测试设置。这个精确度在基于骨架的行动识别方法的1%之内,JLJA(86.3%),从骨架数据、深度视频、深度视频和惯性测量设备中选择和引信。 BienceNet(10个栅网的变式),从“BibirdalityDality A”到“2Frefriendal A”,它们从“Blicaldealalal A”到“Breflistrealdealde A”,它们从87 a be she be she be dre drefridudududududududustralde fre frealde frealde she be she be she be shealblectionalblectional fiversalction A