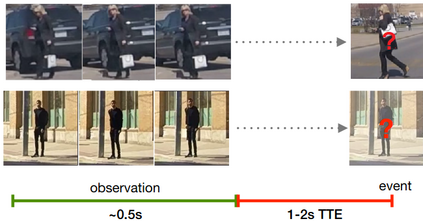

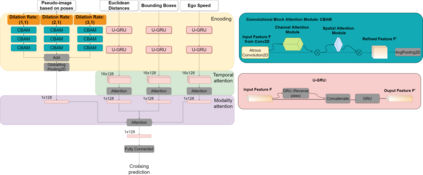

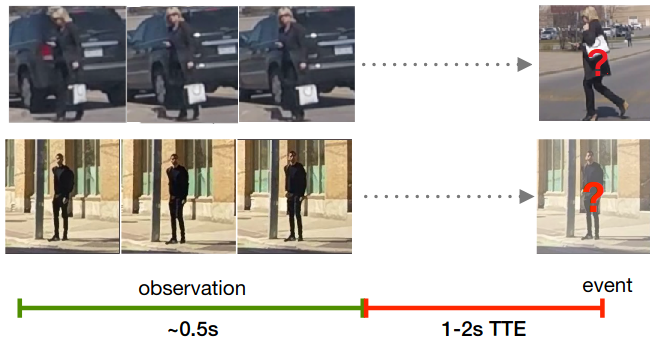

Understanding the behaviors and intentions of pedestrians is still one of the main challenges for vehicle autonomy, as accurate predictions of their intentions can guarantee their safety and driving comfort of vehicles. In this paper, we address pedestrian crossing prediction in urban traffic environments by linking the dynamics of a pedestrian's skeleton to a binary crossing intention. We introduce TrouSPI-Net: a context-free, lightweight, multi-branch predictor. TrouSPI-Net extracts spatio-temporal features for different time resolutions by encoding pseudo-images sequences of skeletal joints' positions and processes them with parallel attention modules and atrous convolutions. The proposed approach is then enhanced by processing features such as relative distances of skeletal joints, bounding box positions, or ego-vehicle speed with U-GRUs. Using the newly proposed evaluation procedures for two large public naturalistic data sets for studying pedestrian behavior in traffic: JAAD and PIE, we evaluate TrouSPI-Net and analyze its performance. Experimental results show that TrouSPI-Net achieved 0.76 F1 score on JAAD and 0.80 F1 score on PIE, therefore outperforming current state-of-the-art while being lightweight and context-free.

翻译:理解行人的行为和意图仍然是车辆自主的主要挑战之一,因为准确预测行人的意图可以保证其安全和驾驶车辆的舒适度。在本文件中,我们通过将行人的骨骼的动态与二进制跨越的意图联系起来,处理城市交通环境中行人跨行的预测。我们引入了TrouSPI-Net:一个无背景、轻量、多部门预测器。TrouSPI-Net提取的时空特征,用于不同时间分辨率,办法是对骨骼连接的位置和过程的假图像序列进行编码,并同时使用平行的注意模块和疯狂的聚合进行处理。然后,通过将行人的骨骼连接的相对距离、捆绑的箱位置或与U-GRU的自驾驶速度等处理特征,改进了拟议方法。我们利用两个大型公共自然数据组的新拟议评价程序来研究行人交通行为:JAAAD和PIE,我们评估TrousSPI-Net,并分析其性能。实验结果显示,TroSPI-Net在JAAAD和0.81 FIAREl-Sprival Stal Stal Stat 和0.80 FIE-Systeal Stal Stat-Systeal Stat-Systel-Systel-Card-Systemal-fal-Syalmental-fl) 和0.80 F1 F1 F1 F1 F1 F1 F1 Fat-stemal-stement上,我们算。