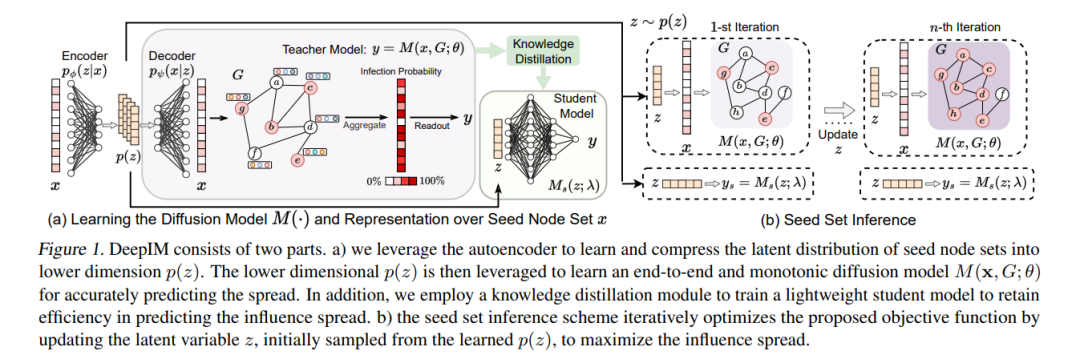

影响力最大化(IM)被定义为从社交网络中选择一组初始用户,以最大化受影响用户的预期数量。研究人员在设计各种传统方法方面取得了很大进展,它们的理论设计和性能提升接近极限。在过去的几年里,基于学习的IM方法应运而生,比传统方法在未知图上具有更强的泛化能力。然而,基于学习的IM方法的发展仍受到一些基本障碍的限制,包括:1)有效解决目标函数的难题;2)表征多样化潜在扩散模式的难题;以及3)在各种以节点中心性为约束的IM变体下调整解决方案的难题。为应对上述挑战,我们设计了一个名为DeepIM的新颖框架,以生成性地表征种子集的潜在表示,并提议以数据驱动和端到端的方式学习多样化的信息扩散模式。最后,我们设计了一个新颖的目标函数,以推断在灵活的基于节点中心性的预算约束下的最优种子集。在合成和真实世界数据集上进行了大量分析,以展示DeepIM的整体性能。代码和数据可在以下地址获取:https://github.com/triplej0079/DeepIM。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年6月16日

Arxiv

0+阅读 · 2023年6月16日

Arxiv

0+阅读 · 2023年6月16日

Arxiv

0+阅读 · 2023年6月16日

Arxiv

17+阅读 · 2021年6月18日