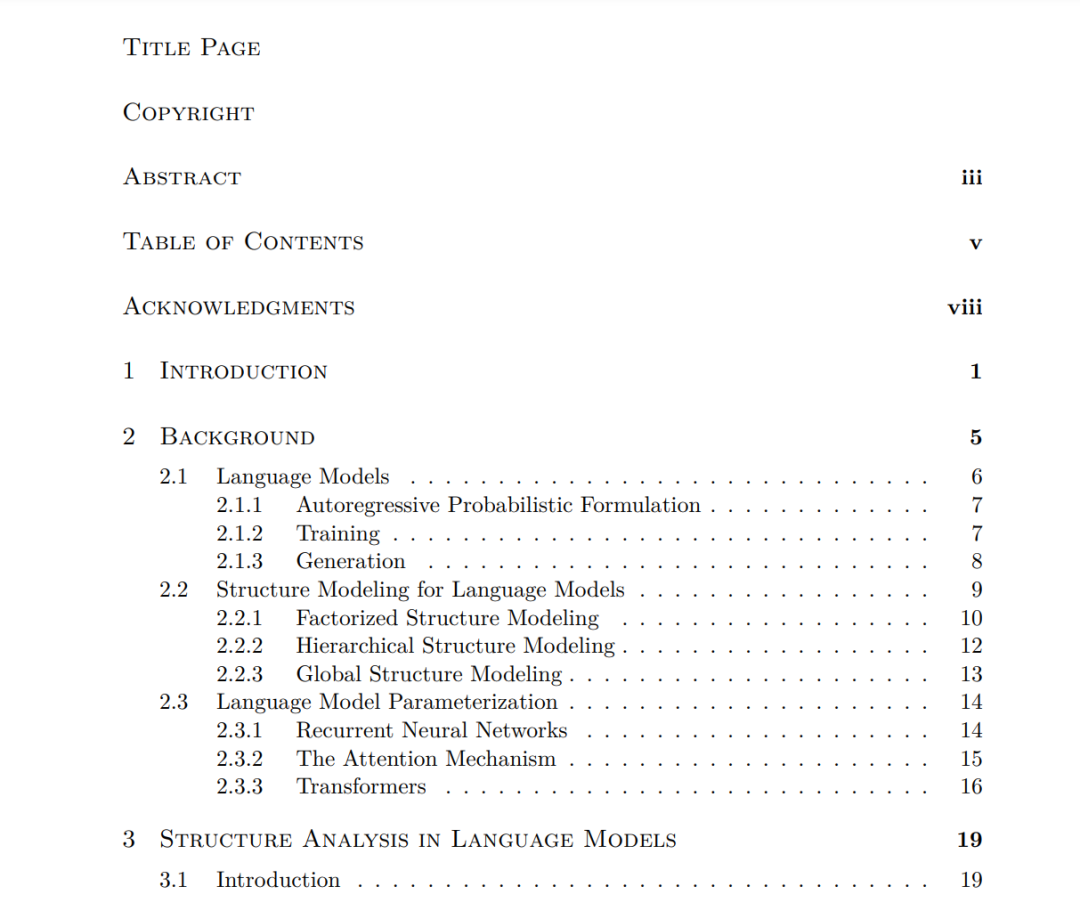

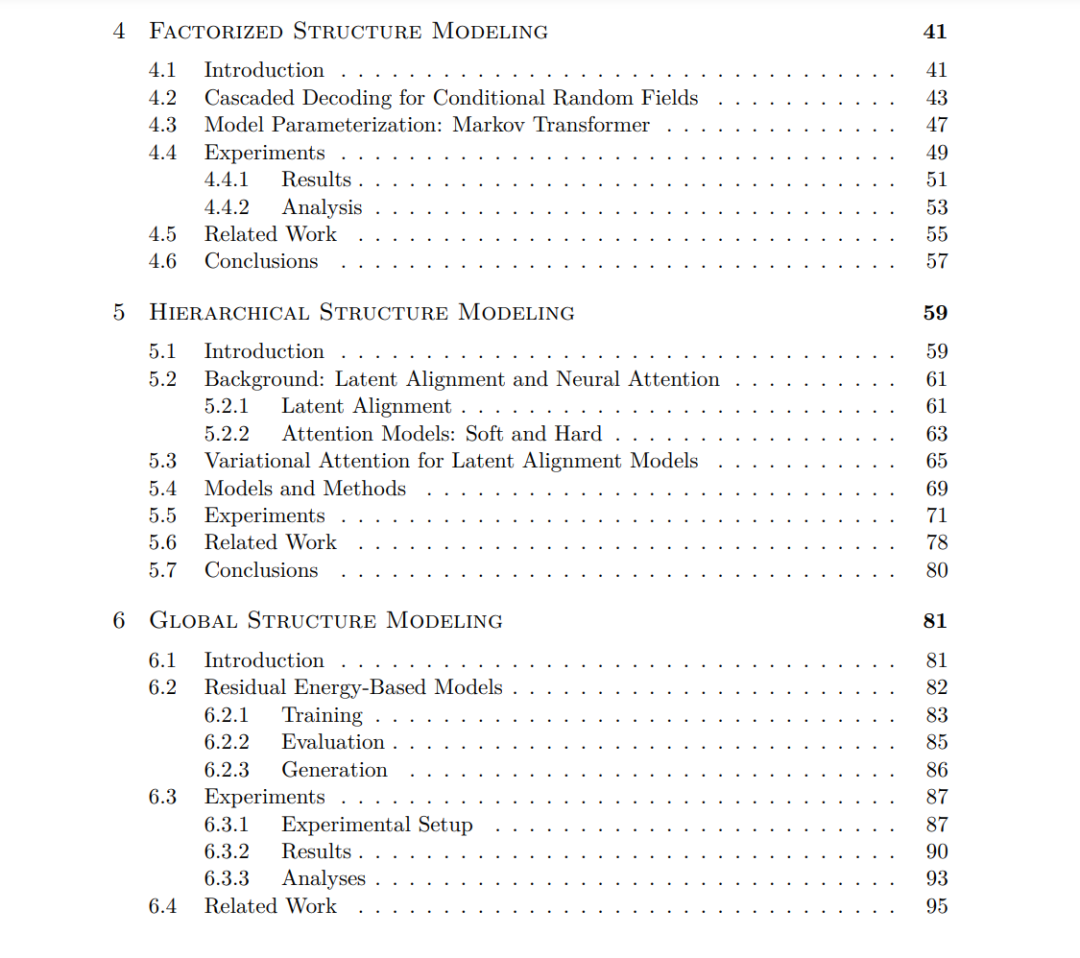

神经语言模型是由神经网络参数化的文本的概率模型。它们广泛适用于输出由离散序列组成的应用程序,例如文档摘要、问答和图像字幕生成。关于数据的最小假设使得语言建模的进步可以推动在各种各样的应用中的改进。在自然语言中,结构既普遍又重要。例如,一本书被组织成章节,它们之间有逻辑的联系;没有这种结构,书就会失去连贯性。因此,有效地理解和建模文本序列需要理解和表示其中的内在结构。这篇论文侧重于语言模型的结构建模。论文分为两个主要部分:语言模型的结构分析和结构建模技术。第一部分研究了语言模型生成中各种结构方面的建模,包括节段转换结构、共指结构和主题相关性结构。强调了对这些组成部分的全面理解的必要性,论文在结构水平评估语言模型的性能。通过采用一个评估机器生成文本中高级连贯性的统计框架,研究揭示了即使是大型语言模型在捕捉话语连贯性和共指方面也存在局限性。此外,研究还表明,表面级别建模的改进并不一定保证更好的结构建模。论文的第二部分介绍了各种旨在改进或定制语言模型的结构建模技术。这些技术分为三类:分解结构建模、分层结构建模和全局结构建模。它们可以提高语言模型的结构连贯性、透明度、计算效率和数据效率。总之,这项研究深入探讨了语言模型的结构分析和建模技术。通过开发各种结构分析方法和建模方法,论文旨在加深对语言模型在表示结构方面的能力的理解和改进。所提出的技术有潜力在广泛的应用领域提高语言模型的性能,最终推动不仅自然语言生成,还包括输出空间包含离散序列的其他领域,如计算机视觉、机器人技术和基因组学。https://dash.harvard.edu/handle/1/37375813

成为VIP会员查看完整内容

相关内容

大语言模型是基于海量文本数据训练的深度学习模型。它不仅能够生成自然语言文本,还能够深入理解文本含义,处理各种自然语言任务,如文本摘要、问答、翻译等。2023年,大语言模型及其在人工智能领域的应用已成为全球科技研究的热点,其在规模上的增长尤为引人注目,参数量已从最初的十几亿跃升到如今的一万亿。参数量的提升使得模型能够更加精细地捕捉人类语言微妙之处,更加深入地理解人类语言的复杂性。在过去的一年里,大语言模型在吸纳新知识、分解复杂任务以及图文对齐等多方面都有显著提升。随着技术的不断成熟,它将不断拓展其应用范围,为人类提供更加智能化和个性化的服务,进一步改善人们的生活和生产方式。

Arxiv

138+阅读 · 2023年4月7日