论文题目: Pruning a BERT-based Question Answering Model

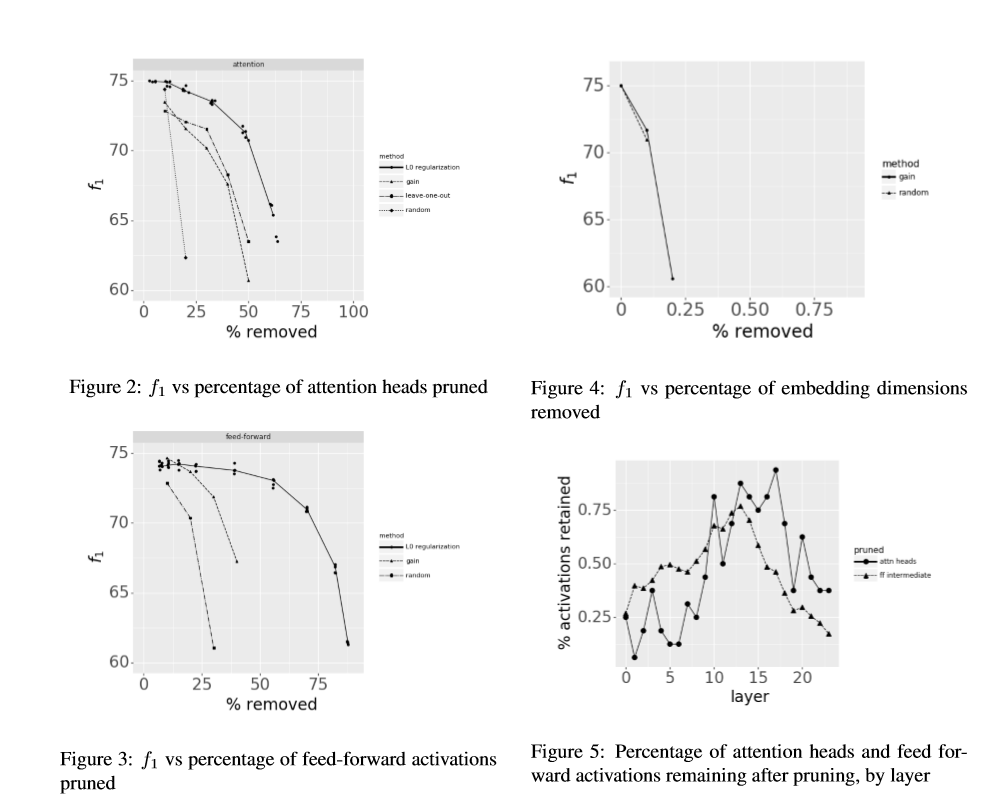

论文摘要: 我们研究了通过从基本的BERT模型中剪除参数来压缩基于BERT的问答系统。我们从为2.0小队训练的模型开始,引入允许变压器的选定部分被单独消除的门。具体来说,我们研究:(1)减少每个变压器中的注意头数目,(2)减少每个变压器的前向子层的中间宽度,以及(3)减少嵌入尺寸。我们比较了几种确定这些阈值的方法。我们发现剪枝注意头和前馈层的结合几乎使解码速度加倍,只有1.5f点的精度损失。

作者介绍: Jeffrey McCarley,IBM T.J.沃森研究中心

成为VIP会员查看完整内容

相关内容

专知会员服务

29+阅读 · 2020年5月20日

专知会员服务

20+阅读 · 2020年4月30日

Arxiv

7+阅读 · 2019年9月17日

Arxiv

14+阅读 · 2018年10月11日

Arxiv

15+阅读 · 2018年1月5日