如何在人类-人工智能混合环境中实现人机智能的有效融合, 将人的意向性与机的形式化有机结合进而提升决策水平, 是作战决策智能化发展最为迫切的问题之一. 对当前人机智能融合主要解决思路“可解释性”方法的有关研究进行梳理, 从基本概 念发展、主要研究方向、关键基础技术 3 个方面总结了最新的研究进展, 分析了作战决策背景下该原则的局限性以及实际运用中 出现的问题. 在此基础上提出“可接受性”概念并从“决策者需求”、“智能方法优化方向”出发明确其具体能力要求, 以提供一种新 的指导原则促进人工智能应用于实际作战决策.

智能作战决策是一种基于人工智能方法展开作 战决策作业的新型作战决策样式. 其目的在于通过 引入强化学习等人工智能方法, 在作战决策领域实 现更为快速、稳定、有效的决策响应. 通过发展智能 作战决策构建对敌优势, 已成为军事斗争的重要发 展趋势. 但作战决策问题有其特殊性和复杂性, 当前基 于人工智能的决策支持系统, 往往并不能很好地满 足其实际需要. 例如针对作战决策中常见的兵力规 模计算、敌我态势对比等问题, 智能系统通常只给出 其结论性判断, 但从指挥员视角出发, 更重要的是如 何说明其推理过程以作为参考. 再如, 作战决策结论 充满了不确定性, 人工智能即使能够预测出判断敌 主攻方向(领域)或确定我主攻方向(领域), 预测战 争持续时间, 但这只是一种基于有限条件的预判. 指 挥员该如何认识并信任这个结果, 如何对其发生的 概率进行理解和决策, 人工智能的判断又该如何与 指挥员的矛盾判断进行融合?这些在人类分工协作中 也会遇到的具体问题[1-5] , 已经成为智能技术应用于作 战决策的巨大障碍。

深入分析这些现象的本质, 没有正确处理好作战 决策中人与机器智能间的关系, 正是问题的根本原因之一. 如果不能对人与机器智能之间的关系给出一个可 行的指导原则, 我们就很难展开: 所作出的决定是否 明智?决策输出是否合理?什么时候需要调整智能方 法?是否符合战争法规和立法[1]?等问题的具体讨论. 以“可解释性”作为指导原则, 开发可解释的机 器学习方法, 是当前针对这一问题的主要研究方向[6-7] . 该原则相信决策者可以通过深入了解结果的过程机 制来对模型的正确性建立起信心[7-8] . 可解释的机器 学习方法为了帮助人们更好地理解模型过程和输出, 将特定方法纳入传统模型, 例如: 原因研究[9-10]、相关 性分析[11]、模型约简[12-13]、必然性解释[14-15]等, 以试图 使决策者信赖。

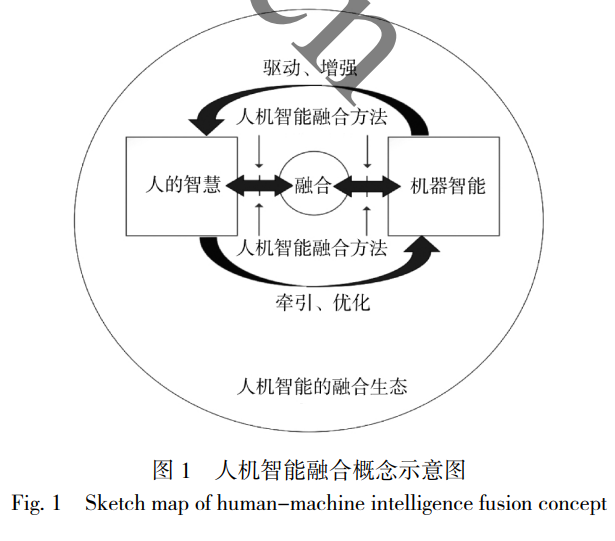

然而, 尽管该领域已经取得了一些进展, 但说服 决策者将这些智能方法部署到作战决策系统中仍然 是一个巨大的挑战.“可解释性”原则的本身是一 个相对泛化的概念, 清晰界定区分具有一定难度[16] . 同时,“可解释性”尽管在学术研究中经常被提及, 但 对其定义仍不存在一个共识. 实际上,“可解释性”并 不是一个整体的概念, 不同的研究对于“可解释性” 和可解释方法通常有不同的初衷和技术描述. 基于 “可解释性”原则优化后的方法尽管相较原始方法更 简单、更清晰, 但其复杂性仍然难以满足一般性的 认知要求, 普遍存在指挥员依然很难理解的现象[17] . 智能方法本身的可解释性与可信任的决策判断没 有必然联系, 前者并不一定能够带来后者. 可解释性 仅要求智能方法的底层机制透明可见, 然而达到作战 决策中的可信任水平, 除底层理解外, 更强调对方法 的运用过程有较高的整体理解. 事实上, 作战决策包括方案构想、计划制定等活 动, 本身是一个结构不良的复杂过程. 决策者既要根 据各种事实, 更要根据自己的经验对局势进行决策. 在决策过程中, 决策者既有对大概率选项作出选择 的理性思维, 也有不清楚概率分布的情况下对选项 作出选择的感性思维, 更有将传统意义上的小概率 选项经过概念类比、问题转换、方案构造变成大概 率选项的感性、理性混合思维, 本质上是一种艺术和 科学相结合的过程. 作战决策背景下人机智能融合 的有效实现, 必须充分考虑这些基本特点。

因此, 为了有效地解决上述问题, 更好地将人 工智能运用于作战决策系统, 本文的创新工作主要 包括: 1)对可解释性的基本概念发展、主要研究方 向、关键基础技术进行了综述, 对其在作战决策中应 用存在的问题进行了分析. 2)从智能作战决策需求与人机智能融合基本概 念的辨析出发, 提出“可接受性”原则并对其基本内 涵进行了具体定义.3)对“可接受性”的关键能力要求进行分析, 聚 焦决策者需求、智能方法优化方向, 具体讨论了 “如何营造智能输出更易于被接受的决策环境”、以 及“如何优化智能方法输出更易于被接受的决策” 等问题。