摘要

Transformer体系结构在自然语言处理和计算机视觉领域有着广泛的应用。近年来,Transformer已被应用于时间序列分析的各个方面。本教程概述了Transformer架构及其应用程序,并收集了来自时间序列分析方面的最新研究论文的示例。我们深入地解释了Transformer的核心组件,包括自注意力机制、位置编码、多头和编码器/解码器。Transformer体系结构处理时间序列任务。本教程还提供了最佳实践和技术,以克服有效训练transformer进行时间序列分析的挑战。

引言

Transformers 属于一类以自注意力或缩放点积运算为主要学习机制的机器学习模型。Transformers最初被提出用于神经机器翻译——最具挑战性的自然语言处理(NLP)任务之一[64]。最近,Transformers 已经成功地用于解决机器学习中的各种问题,并取得了最先进的性能。除了经典的NLP任务,其他领域的例子包括图像分类、目标检测和分割、图像和语言生成、强化学习中的顺序决策、多模态(文本、语音和图像)数据处理,以及表格和时间序列数据的分析。本教程重点介绍使用Transformers进行时间序列分析。时间序列数据由有序的样本、观测数据或随时间顺序记录的特征组成。时间序列数据集通常在许多实际应用程序中自然产生,这些应用程序在固定的采样间隔内记录数据。示例包括股票价格、数字化语音信号、交通测量、天气模式的传感器数据、生物医学测量以及随时间记录的各种人口数据。时间序列分析可以包括处理多个任务的数字数据,包括预测、预测或分类。统计方法包括使用各种类型的模型,如自回归(AR)、移动平均(MA)、自回归移动平均(ARMA)、AR综合移动平均(ARIMA)和频谱分析技术。

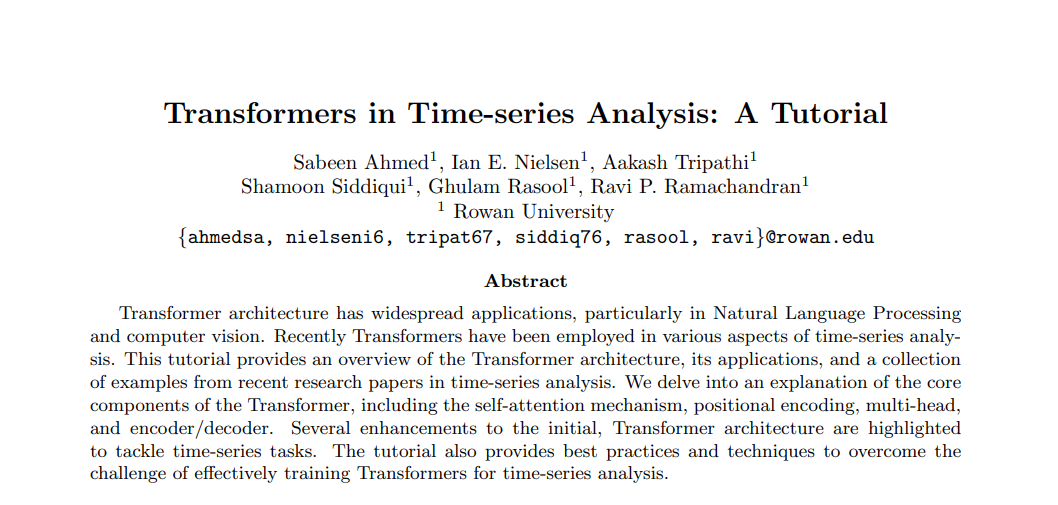

具有专门组件和架构的机器学习模型,用于处理数据的顺序性质,已经在文献中被广泛提出,并被社区使用。这些机器学习模型中最著名的是循环神经网络(RNN)及其流行的变体,包括长-短期记忆(LSTM)和门控循环单元(GRU)[35],[23],[13]。这些模型按顺序处理一批数据,每次处理一个样本,并使用著名的梯度下降算法优化未知模型参数。利用时间反向传播(backpropagation through time, BPTT)[10]计算模型参数更新的梯度信息。LSTM和GRU已成功地应用于许多领域。然而,由于输入数据的顺序处理和与BPTT相关的挑战,特别是在处理具有长依赖关系的数据集时,它们受到了一些限制。LSTM和GRU模型的训练过程中也存在梯度消失和梯度爆炸问题。在处理长序列时,梯度下降算法(使用BPTT)可能不会更新模型参数,因为梯度信息丢失了(要么接近零,要么接近无穷)。此外,这些模型通常不能从图形处理单元(GPU)、张量处理单元(TPU)和其他硬件提供的并行计算中获益。某些架构修改和训练技巧可以帮助LSTM和GRU在一定程度上减轻梯度相关的问题。然而,在现代硬件提供的有限的并行使用下,从长数据序列中学习的挑战影响了基于RNN模型[55]的有效性和效率。

在本教程中,我们首先概述基于第2节中的自注意力、缩放点积、多头和位置编码的transformer 体系结构。第3节介绍了时间序列应用中transformer的进步。然后,我们将在第4节中讨论一些最近最流行的时间序列Transformer架构。最后,在结束教程论文之前,我们在第5节中提供了训练transformer 的“最佳实践”。

Transformer 技术概述

在本教程中,我们首先概述基于第2节中的自注意力、缩放点积、多头和位置编码的transformer 体系结构。第3节介绍了时间序列应用中transformer的进步。然后,我们将在第4节中讨论一些最近最流行的时间序列Transformer架构。最后,在结束教程论文之前,我们在第5节中提供了训练transformer 的“最佳实践”。

原始的Transformer是一个序列到序列的模型,采用编码器-解码器类型的配置,它接受源语言的单词序列作为输入,然后生成目标语言的译文[58,64]。考虑到两个序列的长度和词汇量不一定相同,模型必须学会将源序列编码为固定长度的表示,然后对其进行解码,以自回归方式[8]生成目标序列。这种自回归特性具有一个约束条件,即在生成已翻译序列期间,要求信息传播回序列的开头。时间序列分析也存在同样的约束。机器学习模型一直受到学习过程中可以考虑的特定数据样本的影响的限制。在某些情况下,机器学习模型训练的自回归性质会导致记忆过去的观察结果,而不是将训练示例泛化到新数据[36,30]。Transformer在分析序列中的当前数据样本时,通过使用自注意力和位置编码技术共同关注和编码顺序信息,解决了这些挑战。这些技术保持序列信息完整的学习,同时摆脱了经典的递归概念[21]。这些技术进一步允许Transformer利用GPU和TPU提供的并行性。

Transformer时间序列分析

自2017年《Transformers 》问世以来[64],这些时间序列分析网络取得了许多进展。最初的模型主要关注于NLP任务,但现在的架构已经扩展到分类[76]、时间序列分析[57]、语义分割[79]等。时间序列数据并不是Transformer最初概念的一部分,但现在许多研究人员已经定制并改进了这种数据类型的架构性能。为了说明这项研究是如何展开的,我们将提供一个时间序列任务的路线图,以及技术是如何进步的。这些改进的一个共同点是修改输入层以适应时间序列数据。使用Transformers进行时间序列分析、预测和分类完成了两个主要任务。在每一项任务中,我们都提供了有用的信息和最新方法中使用的数据集的链接。本节的路线图全面列出了过去几年取得的进展,以及它们之间的关系**。在每一小节的末尾都列出了该类别中所包含的模型(和引用)。

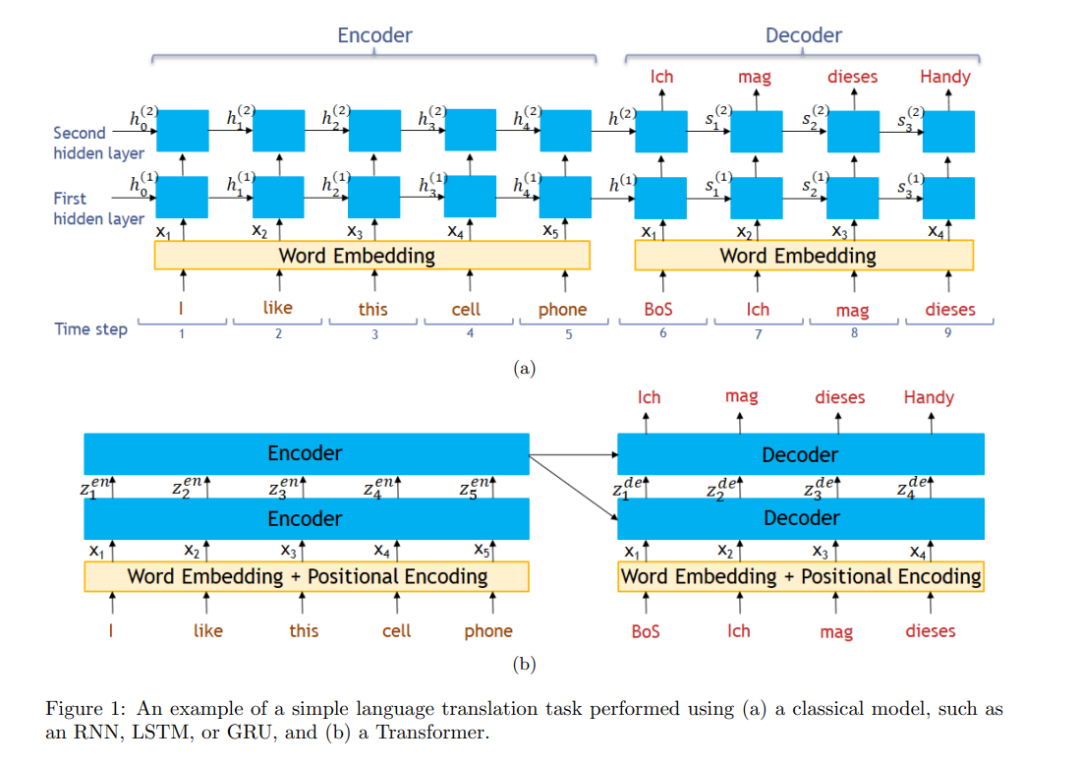

时间序列Transformers改进方法概述。左边是原始Transformer架构的重建[64]。右侧显示了第3.1小节中相对于原始Transformer模型的每个改进路径在原始体系结构中的位置。

Transformer时间序列架构

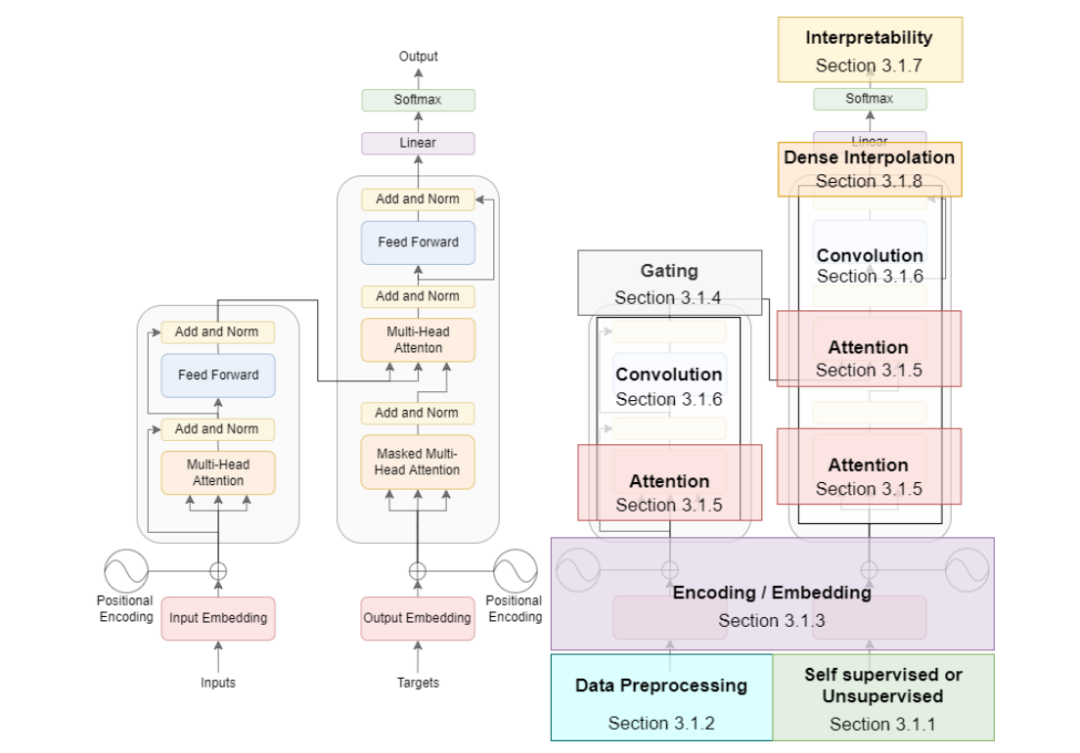

最近,Zhou等人提出了Informer,它使用ProbSparse自注意力机制来优化标准Transformer架构的计算复杂度和内存使用[80]。作者还引入了自注意力蒸馏操作,这大大降低了模型的总空间复杂度。[80]中提出的Informer体系结构。Informer 由堆叠的编码器和解码器组成。该编码器由多头ProbSparse自注意力和自注意力提取操作组成。堆叠副本的输入长度为前一层的一半。编码器输出是主栈和复制栈输出的串联。该译码器具有两个堆叠的多头注意力层,并在一次向前传递中同时预测整个输出序列。

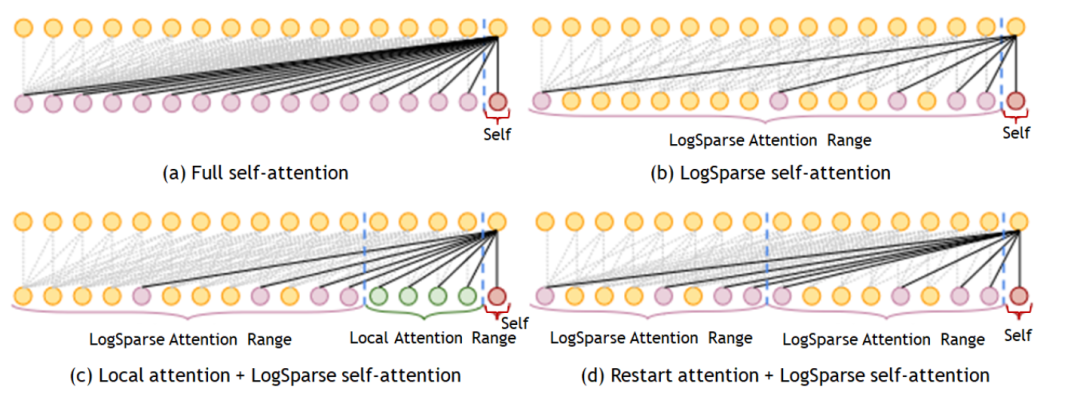

Li等人提出了LogSparse transformer来克服内存挑战,从而使transformer对于长期依赖[32]的时间序列更加可行。LogSparse transformer允许每个时间步长关注之前的时间步长,使用指数步长进行选择,将每个自关注层的内存利用率从O(l2)降低到O(llog2l)。图13显示了LogSparse自注意用于时间序列分析的各种方式。在特定范围内,用于相邻时间步长的规范的自注意力机制允许收集更多的信息。除此之外,还应用了LogSparse自注意力机制。另一种方法是在特定的时间步长范围后重新启动LogSparse步长。

Transformer时间序列训练最佳实践

Transformer架构变得越来越流行,这导致许多研究人员寻求针对各种应用程序优化这些网络的方法。是否在调整架构以用于特定的问题领域、训练技术、超参数优化、推理方法、硬件适应等方面。在本节中,我们将讨论用于时间序列分析的transformers时的最佳实践。**

训练Transformers

对于初学者来说,从头开始训练Transformers 并不容易。原始的Transformers 体系结构[64]利用许多不同的策略在更深的网络训练期间稳定梯度。作者的残差连接允许训练一个更深的网络。随后,层归一化操作与自适应优化器(Adam)一起添加,为不同参数提供不同的学习速率。像大多数其他深度学习模型一样,Transformers对学习速率也很敏感。给定最优的学习速率,Transformers 可以比传统序列模型更快地收敛。在最初的几个时期,通常会观察到性能下降。然而,经过几个时期后,该模型通常会开始收敛到更好的值。在最初的实现中,作者使用了一种热身学习率策略,该策略在前N个训练步骤中线性增加,然后与步骤数的平方根√1n成比例下降。

在Transformer架构中已经提出了许多改进,以解决与使用更深入的架构实现稳定训练相关的一些问题。主要是通过重新定位层归一化操作和寻找更好的权值初始化技术来平衡残差依赖关系。这些改进导致了更稳定的训练,在某些情况下,消除了使用原始架构中提出的一些策略的需要。图16提供了一些训练transformer的最佳实践的概述,以及它们各自的原因。