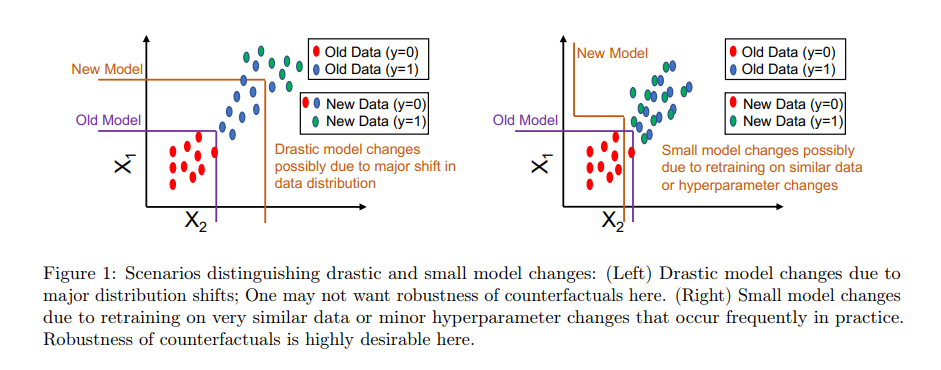

反事实的解释提供了从机器学习模型中获得预期结果的方法。然而,这样的解释对于基础模型中的某些真实世界的变化(例如,重新训练模型,改变超参数,等等)并不是鲁棒的,在几个应用中质疑它们的可靠性,例如,信贷。在这项工作中,我们提出了一种新的策略——我们称之为RobX——来为基于树的集成生成鲁棒的反事实,例如XGBoost。基于树的集成在鲁棒的反事实生成中带来了额外的挑战,例如,它们具有非光滑和不可微的目标函数,并且在非常相似的数据上进行再训练时,它们可以在参数空间中发生很大的变化。我们首先引入了一种新的度量——我们称之为反事实稳定性——它试图量化反事实对再训练下的模型变化的稳健性,并带来理想的理论属性。我们提出的策略RobX适用于任何反事实生成方法(基础方法),并通过使用我们的度量反事实稳定性迭代改进基础方法生成的反事实来搜索鲁棒的反事实。我们在基准数据集上比较了RobX与流行的反事实生成方法(基于树的集成)的性能。结果表明,我们的策略生成的反事实比现有的最先进的方法更鲁棒(在实际模型更改后,其有效性接近100%),而且也更现实(就局部异常因素而言)。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年8月29日

Arxiv

0+阅读 · 2022年8月26日

Arxiv

0+阅读 · 2022年8月25日

Arxiv

17+阅读 · 2021年6月18日