大型基础模型,包括大型语言模型(LLMs)、视觉转换器(ViTs)、扩散以及基于LLM的多模态模型,正在彻底改变整个机器学习生命周期,从训练到部署。然而,这些模型在多功能性和性能上的显著进步,却以硬件资源的巨大成本为代价。为了以可扩展且环境可持续的方式支持这些大型模型的发展,开发资源高效的策略已成为重点。本综述深入探讨了此类研究的关键重要性,考察了算法和系统层面的方面。它提供了对现有文献的全面分析和宝贵见解,涵盖了从前沿模型架构和训练/服务算法到实际系统设计和实现的广泛主题。此综述的目标是提供对当前方法如何应对大型基础模型所带来的资源挑战的全面理解,并可能激发此领域未来的突破。

https://www.zhuanzhi.ai/paper/92a73bb1c3daa8cff7f79eaa9c9c5053

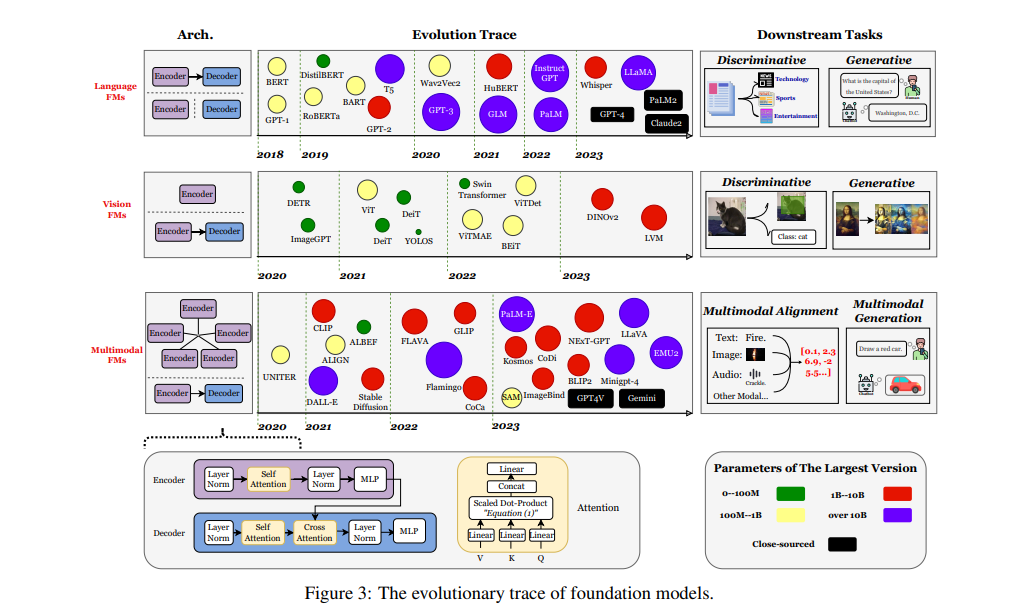

在人工智能(AI)这一快速发展的领域中,一场范式转变正在进行中。我们正在见证从专门化、碎片化的深度学习模型向通用、一体适用的基础模型的过渡。这些先进的AI系统能够在开放世界的背景下操作,与开放词汇和图像像素进行交互,应对未见的AI任务,即零样本能力。这些模型的例子包括:(1)大型语言模型(LLMs),如GPTs [39],能够以提示的形式处理几乎所有NLP任务;(2)视觉变换器模型(ViTs),如掩蔽自编码器 [133],能够处理各种下游视觉任务;(3)潜在扩散模型(LDMs),如稳定扩散 [310],能够用任意基于文本的提示生成高质量图像;(4)多模态模型,如CLIP [296]和ImageBind [116],将不同模态数据映射到同一潜在空间,并广泛用作跨模态任务(如图像检索/搜索和视觉问题回答)的支撑。这种灵活性和通用性标志着AI早期时代的显著转变,为AI与世界交互设定了新的标准。 这些基础模型的成功深深植根于它们的可扩展性:与前代模型不同,这些模型的准确性和泛化能力可以随着更多数据或参数的增加而持续扩展,而无需改变底层简单的算法和架构。一个令人印象深刻的证据是扩展定律 [166]:它描述了基于变换器的模型性能如何可以预测地随模型规模和数据量的增加而改善;直到今天,这一定律依然成立。这种可扩展性不仅是模型大小的问题;它还扩展到它们处理日益复杂任务的能力,使它们成为走向人工通用智能(AGI)之路的基石。

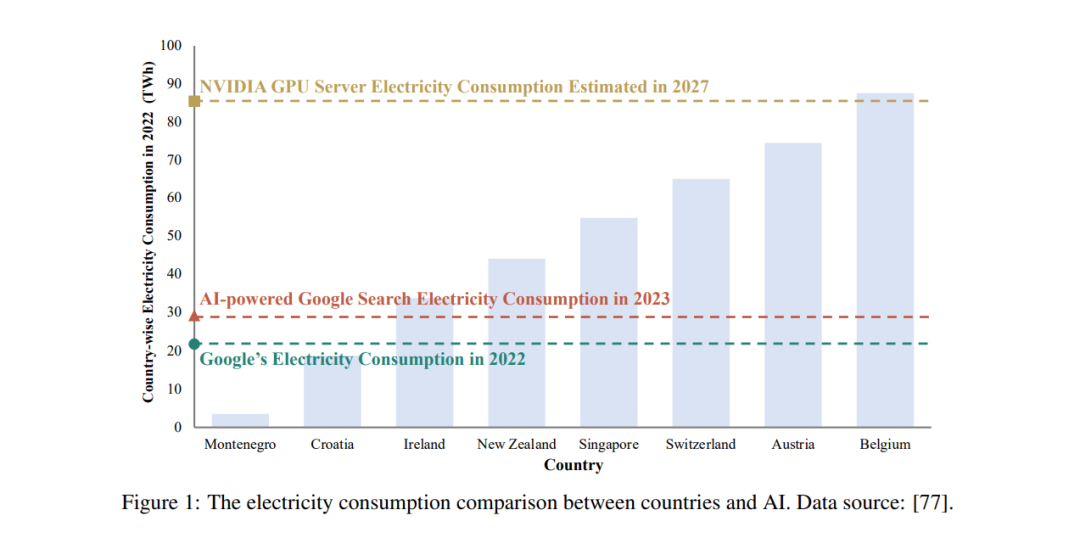

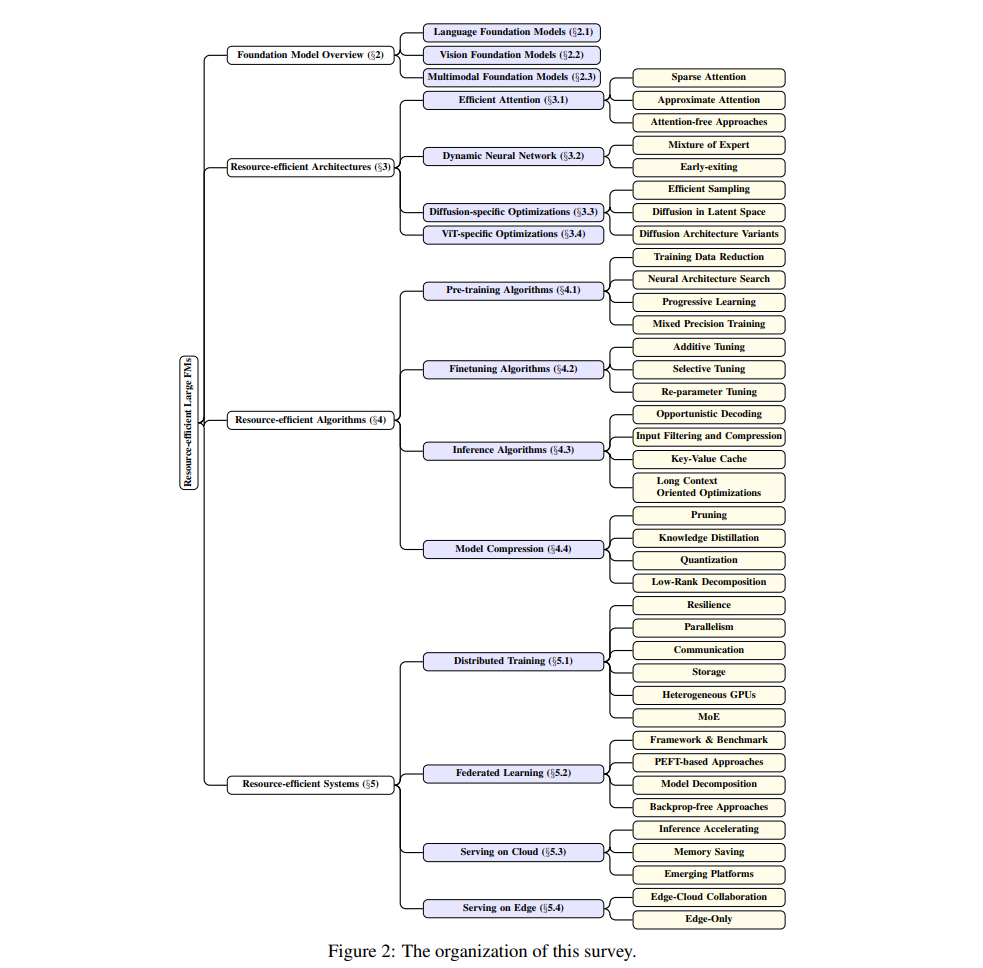

然而,可扩展性的代价是巨大的资源需求。基础模型的本质是对训练和部署的资源极度饥渴。这些资源不仅包括计算处理器,如GPU和TPU,还包括内存、能源和网络带宽。例如,LLaMa-2-70B的预训练需要1.7×百万GPU小时,并消耗2.5×1012焦耳的能量。估计的总排放量是291吨二氧化碳当量。超出训练阶段,数据处理、实验和推理阶段的电力消耗相当甚至更多,据Meta AI [388]称。最近的一项分析 [77]揭示,为了满足当前AI能力和采用的持续趋势,英伟达需要在2027年前每年交付150万AI服务器单元。这些服务器满负荷运行将至少消耗85.4太瓦时的电力——超过许多国家,如新西兰和奥地利,一整年的用电量,如图1所示。随着基础模型在规模和复杂性上的持续增长,它们的资源需求通常呈指数级增长,这在它们的发展和部署中构成了重大挑战。 大型基础模型巨大的资源足迹也阻碍了其民主化。截至2023年底,只有少数主要参与者有能力训练和部署最先进的基础模型,从而对公众拥有强大的控制权,有可能以他们偏好的方式操纵公众。与许多轻量级DNN不同,这些模型是在云端而非设备上提供服务的 [403, 440];这使得数据隐私保护几乎不可能。尽管最近,智能手机厂商一直在吹嘘在本地运行大型基础模型,一些先驱引擎也被开发出来用于设备上的LLMs [114, 11, 10],但展示的模型限于相对较小的规模(例如<10B),且尚未在现实世界中部署。 因此,大量研究致力于提高这些基础模型的效率。这些努力涵盖了从优化算法到系统级创新的广泛方法,专注于在不损害性能的情况下减少这些模型的资源足迹。本综述旨在深入探讨这些研究工作,探索使基础模型更高效的多样化策略。我们将审视算法效率、系统优化、数据管理技术的进步,以及开发较少资源密集的新型架构。综述还涵盖了从云到边缘和设备的范围,大型基础模型在这些领域也获得了巨大关注。通过这一探索,我们旨在提供对基础模型领域中资源高效算法和系统的当前状态和未来方向的全面理解。 范围和理念。本综述的范围主要由以下几个方面定义。(i) 我们只调查算法和系统创新;我们排除了大量在硬件设计方面的工作,这同样重要,但已被很好地总结 [174]。(ii) 本综述中的资源定义主要限于物理资源,包括计算、内存、存储、带宽等;我们排除了可以被视为资源的训练数据(标签)和隐私。(iii) 我们主要调查在顶级计算机科学会议上发表的论文,即CSRankings包含的论文。我们还手动挑选了arXiv上相关且可能产生高影响的论文。(iv) 我们主要调查2020年之后发表的论文,因为AI的创新正在快速进行,旧知识和方法经常被推翻。 尽管如此,我们计划将来扩展本综述的范围;我们也将积极维护和更新它。 组织。图2展示了本综述的组织结构。 全开源。本综述的所有材料都可在以下网址免费获取: https:github.com/UbiquitousLearning/Efficient_Foundation_Model_Survey

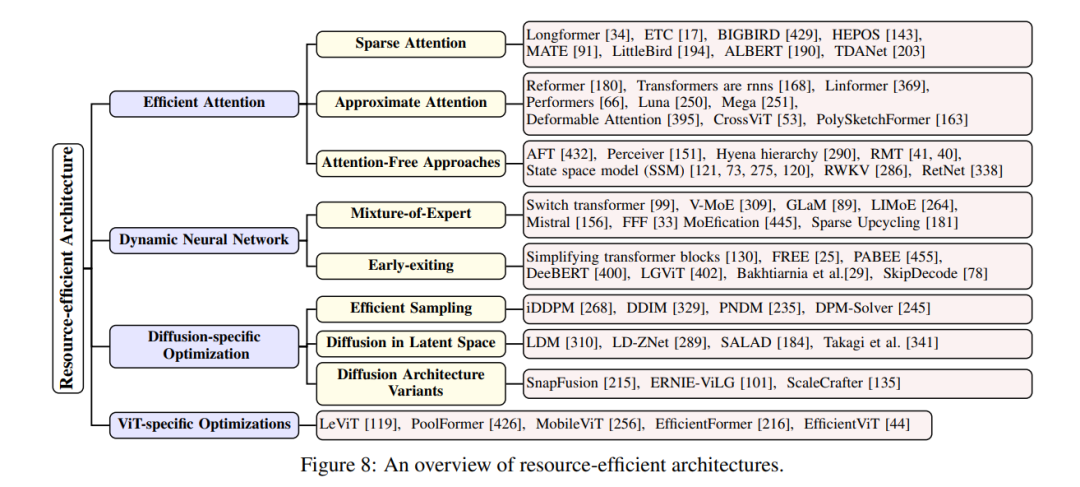

模型架构是资源高效的大型基础模型(FMs)的核心,包括注意力机制、解码器及其替代方案。主要目标是降低计算和内存开销。图8直观地展示了这种资源高效架构的分类,考虑到了大型基础模型的标准核心模块和传统分类。资源高效架构由高效注意力机制、动态神经网络、特定于扩散的优化和特定于视觉变换器(ViT)的优化构成。

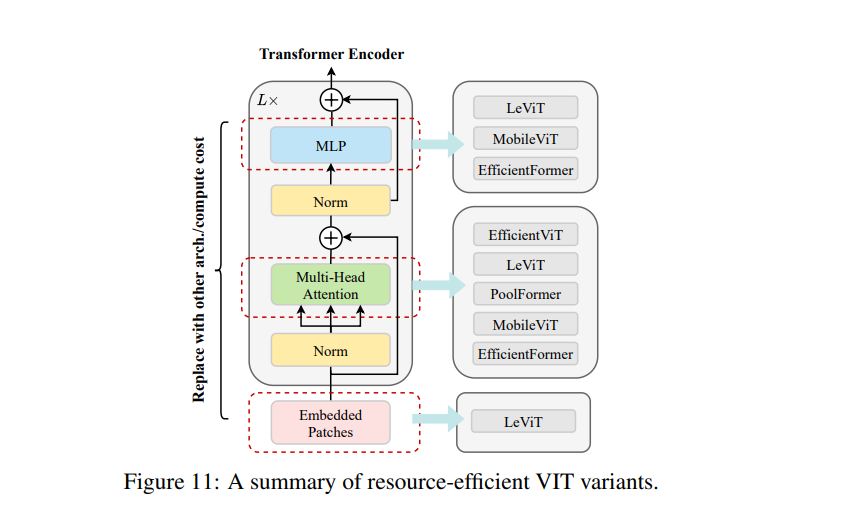

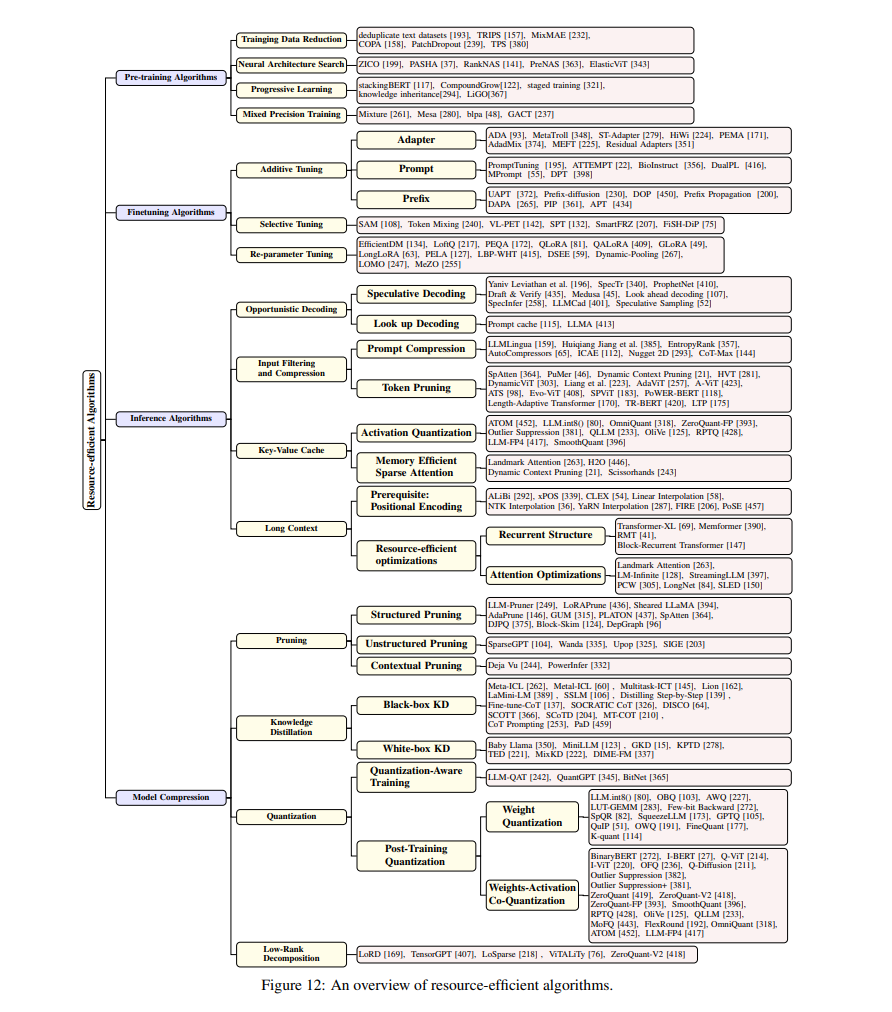

本节重点介绍在算法层面上的资源高效大型基础模型(FMs)技术。与传统的深度神经网络(DNNs)相比,大型基础模型表现出新的特征,如其庞大的参数集和自回归推理。这种差异导致了大量资源高效算法的出现,这些算法根据基础模型的生命周期进行分类:预训练、微调、服务算法以及模型压缩,如图11所示。

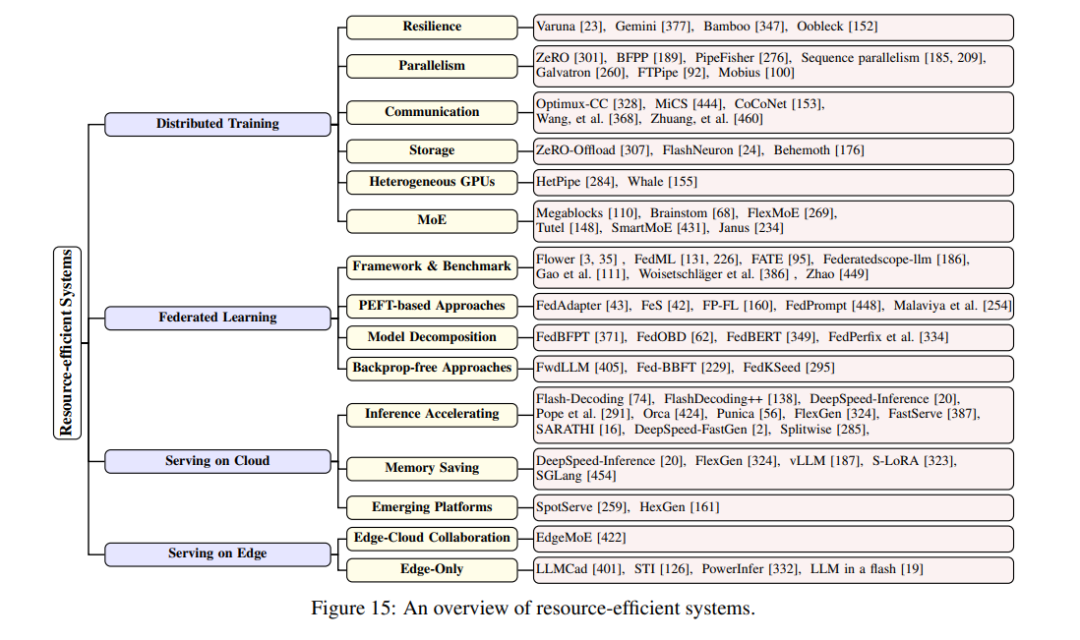

本综述为资源高效的大型基础模型的最新文献提供了全面、系统的概览。我们首先介绍了流行基础模型的初步背景和成本分析,包括大型、视觉和多模态模型。然后我们深入探讨了模型架构、算法和系统设计,以实现更高效的大型基础模型生命周期。未来,这一领域的研究将继续(甚至更加)重要,因为扩展定律保证了更强大的AI与越来越大的模型的光明未来。这种研究也高度跨学科,涉及多个计算机科学社区,如机器学习、NLP/CV/语音、网络、云计算、边缘计算等。

资源高效的大型基础模型研究机会极大,尤其值得关注的是: (1)云-边缘混合部署。为了实现无处不在、隐私保护、高可用性的通用智能,许多基础模型最终将沉入靠近用户的设备 [406, 403, 404, 441]。已经进行了初步努力,将LLaMA-7B带到智能手机和个人电脑上。关键应用包括个人助手/代理 [219, 383]、多模态信息检索 [198] 等。未来,基础模型在设备上运行的规模和速度将成为硬件供应商商业模式中的关键竞争力。 (2)利用模型稀疏性。随着模型变大,对于给定任务的模型激活比率会变小。最近的文献 [244] 发现,即使是密集训练的非MoE模型也表现出运行时激活稀疏性,可以利用这一点来减少推理时间和内存占用。我们认为,利用模型和激活稀疏性将是实现可持续模型规模扩展的有前景的方向。可能会出现比MoE更高效的稀疏架构。 (3)大型基础模型作为一种服务。在云端和设备上,大型基础模型正在统一DNN生态系统 [427]。最终,它将成为像今天的Web和数据库一样的通用服务。一方面,它为高度硬件-算法协同设计和优化提供了机会;同时,它也在系统和基础设施设计方面提出了新的挑战,如调度、负载均衡和安全性&隔离。 (4)作为整体系统优化的代理。未来,尤其是LLMs将作为建立代理的关键构建块 [219, 383]。其效率不应被视为独立的LLM服务;相反,算法和系统设计需要适应特定的代理工作流。例如,一个代理系统可能需要多个基础模型协同工作,在这个过程中存在内在的逻辑依赖性。在这个过程中,选择适合每个任务的适当基础模型,并在给定的硬件资源集上调度它们以最大化代理性能的设计空间是巨大的。 (5)实用的隐私保护FM。随着用户数据上传到云端进行FM处理的数量持续增加,隐私问题的严重性相应升级。现有方法包括联邦学习、同态加密和解纠缠学习。尽管在理论上是健全的,但这些方法仍然面临显著的性能挑战,阻碍了它们的大规模野外部署。一个有前景的方向涉及为大型FMs专门设计的创新隐私保护技术的开发,或现有方法的改进,以有效地平衡隐私与性能。 (6)理解扩展定律。扩展定律推动了大型FMs的成功,同时它似乎也是轻量级FMs的一个基本限制 - 小规模模型不太可能比更大的模型具有更高级别的智能。理解扩展定律背后的机制和理论将有助于解释(并希望打破)这一限制。同时,设计具有更好甚至最优扩展性能的新型模型架构将是一个值得广泛研究的方向。