机器学习(ML)的训练将继续增长,消耗更多的计算周期,其推断将在更多种类的设备上扩展,而且其功能将在更多的领域中得到应用。未来的一些核心目标是使ML模型高效,从而使其保持实用性并能够被训练和部署,并开启具有新功能的新应用领域。我们描述了一些针对硬件的算法的最新发展,以提高ML模型的效率与质量之间的权衡,并为它们装备长时间的上下文信息。

https://searchworks.stanford.edu/view/14784052

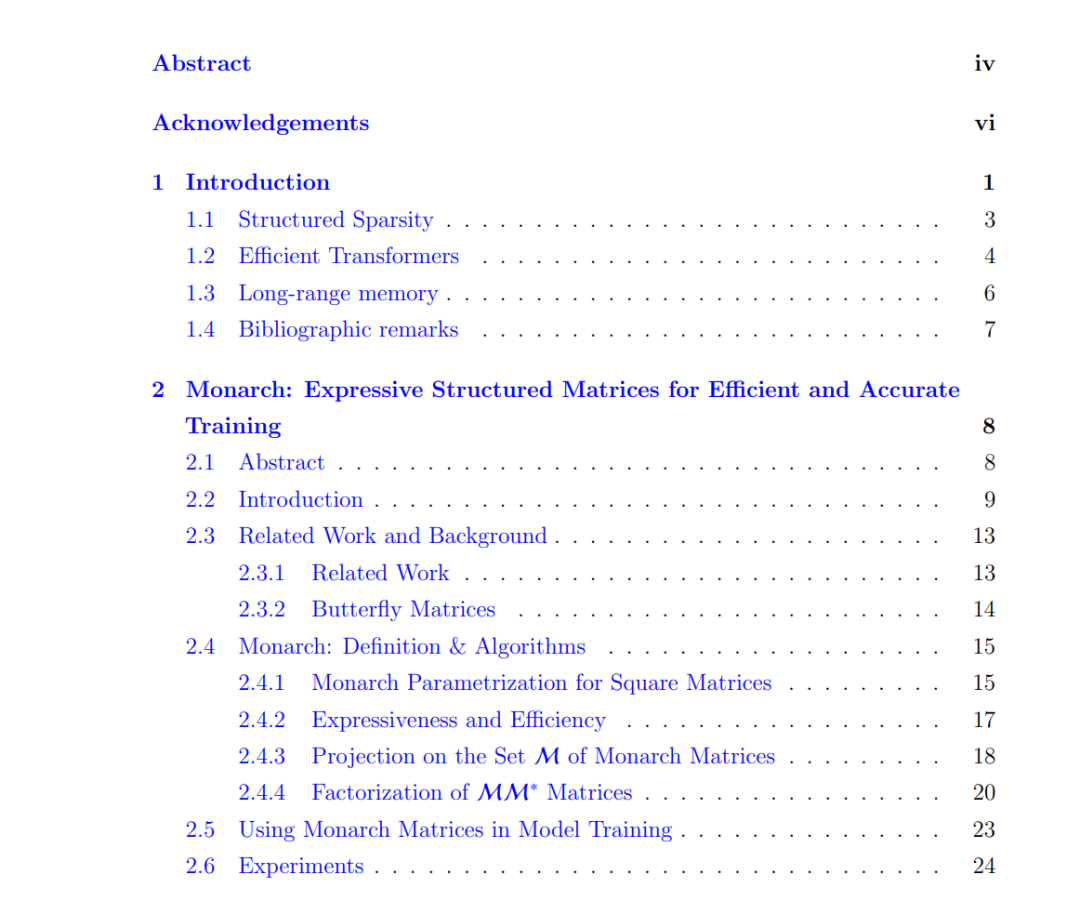

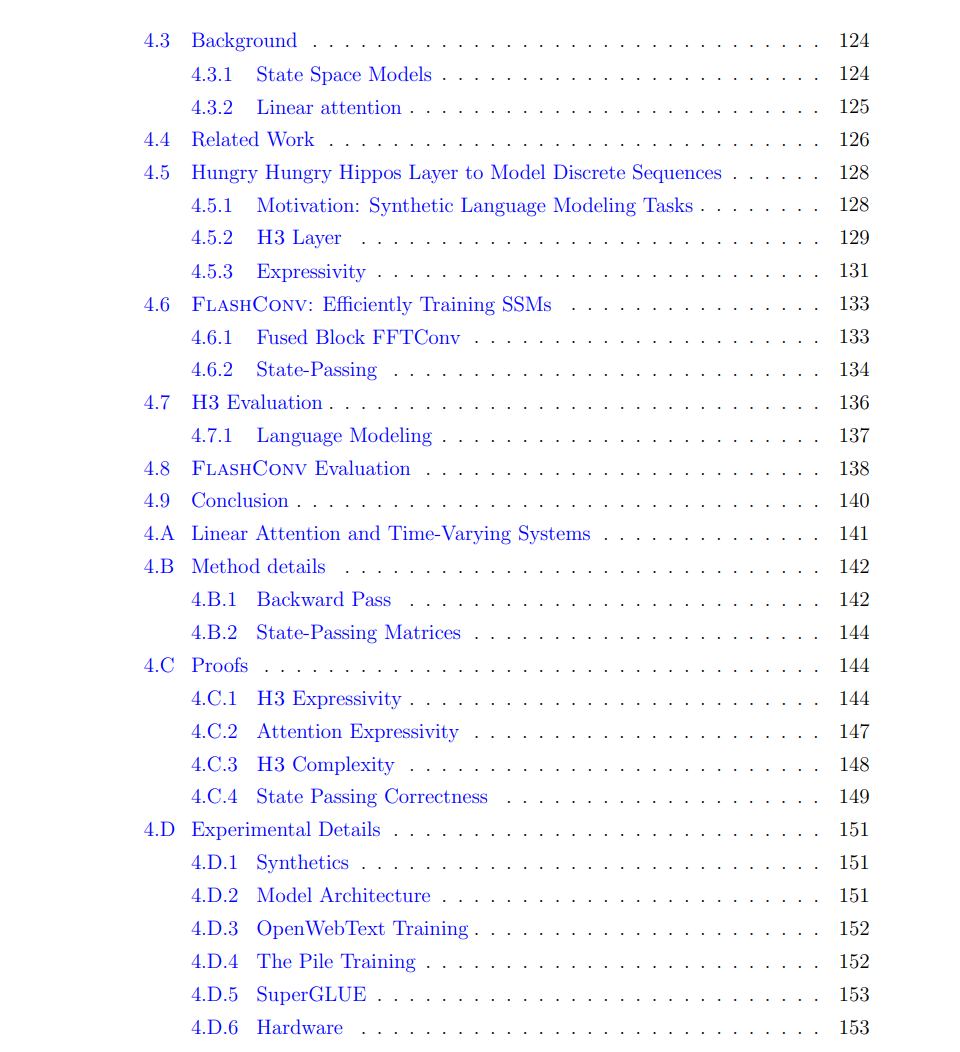

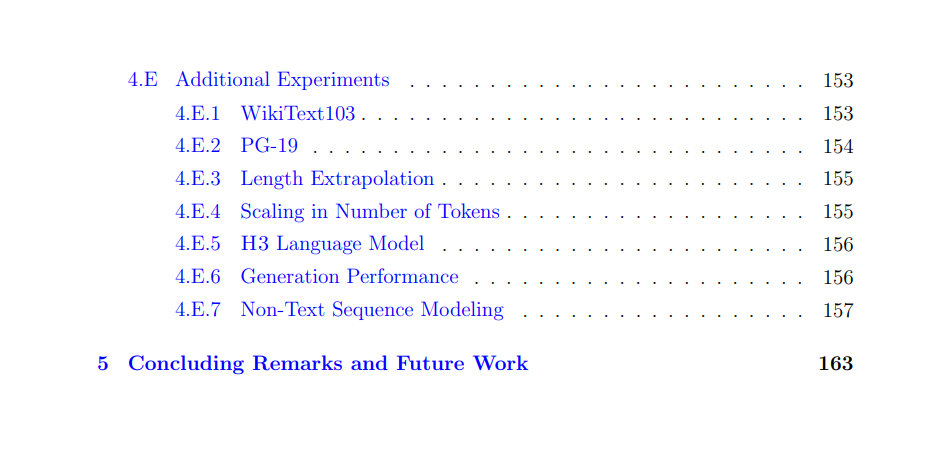

在第2章中,我们关注结构化稀疏性,这是一种自然的方法来减轻大型ML模型的计算和内存成本。我们描述了一种关于可学习的快速变换的工作,由于它们的表现能力和效率,产生了一些首批稀疏训练方法,可以在实际计时(2×)中加速大型模型而不影响其质量。

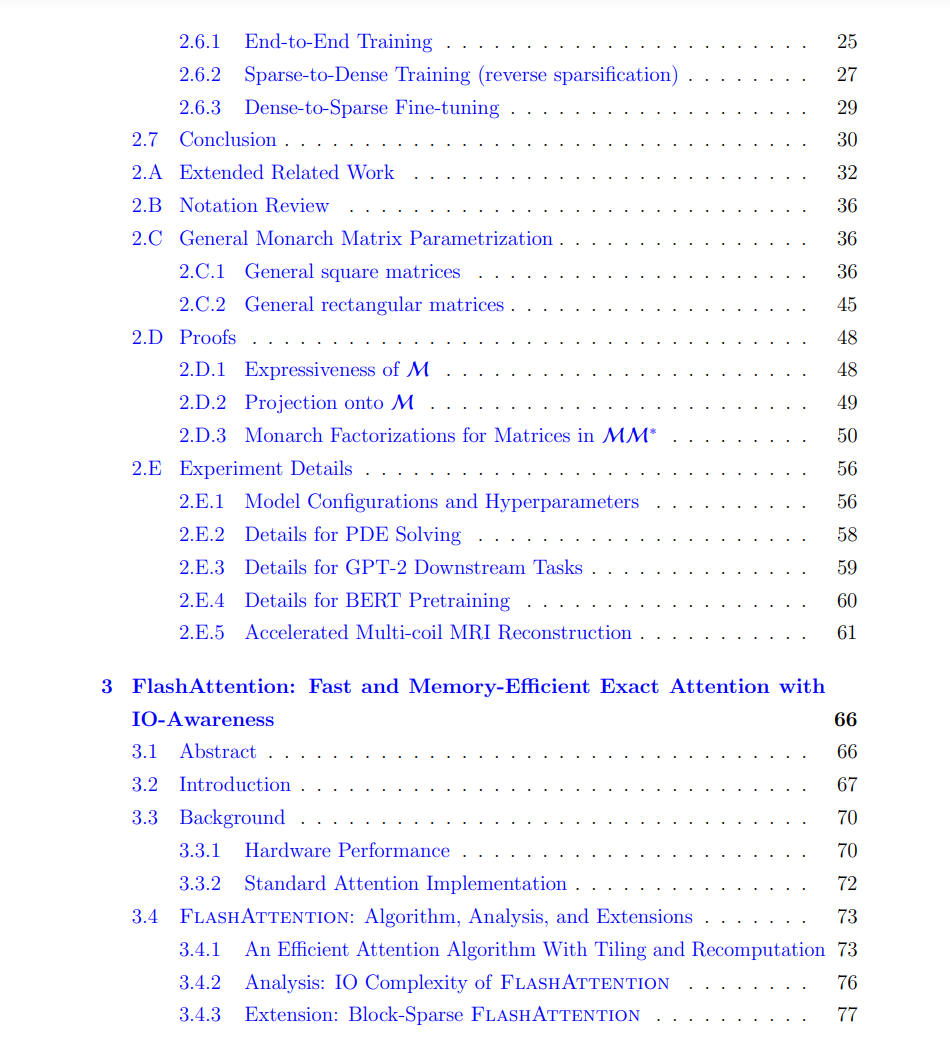

在第3章中,我们关注长序列的高效Transformer训练和推断。我们描述了FlashAttention,一种快速且内存高效的算法,用于计算注意力而无需近似。通过在不同层次的内存结构之间仔细地读/写计算,FlashAttention比现有最好的注意力实现快2-4倍,使用的内存少10-20倍,使我们能够训练具有8倍更长上下文的更高质量的Transformers。FlashAttention现在广泛用于一些最大的研究实验室和公司。

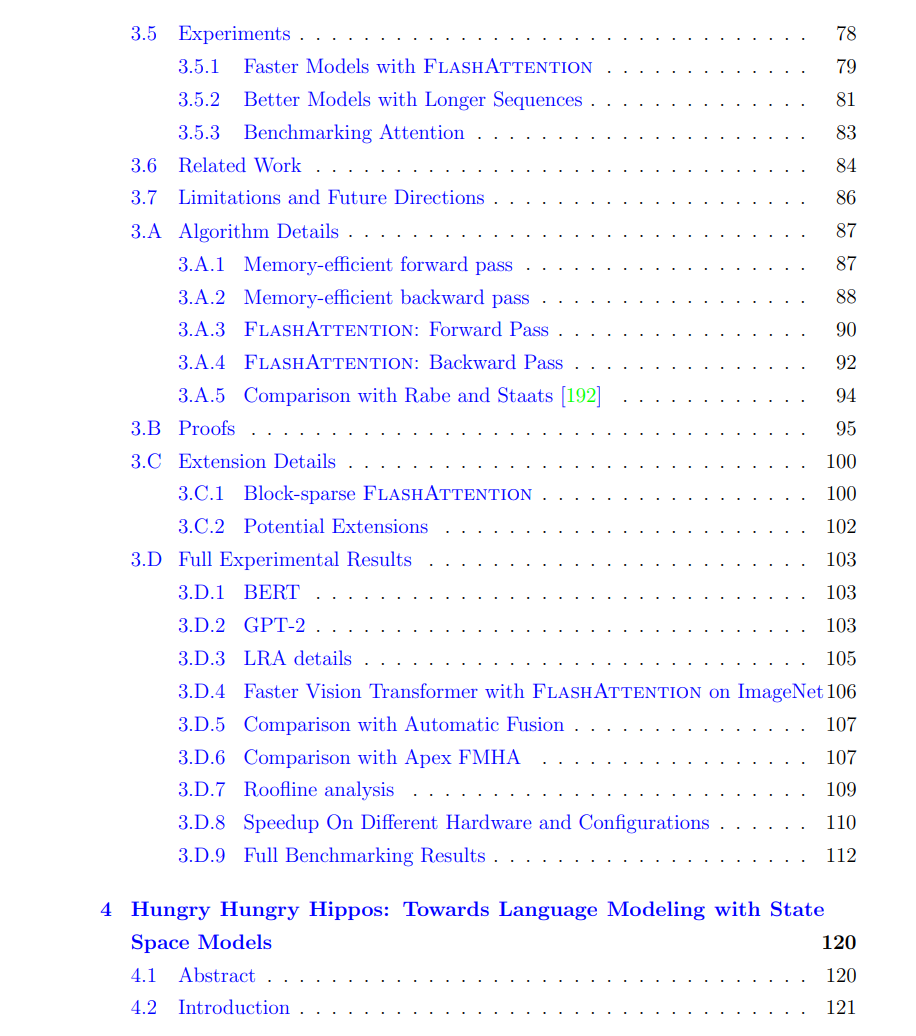

在第4章中,我们研究了状态空间模型,这是一种为长期记忆设计的有前途的架构。当我们试图理解为什么早期的状态空间模型在语言建模任务上表现不佳时,我们提出了简单的乘法交互来扩展它们的表现能力。我们还设计了对硬件友好的算法来训练它们。结果,我们能够训练达到千亿参数规模的状态空间模型,展示了一种与语言建模中占主导地位的Transformers竞争的新型模型。我们总结了ML和系统中的一些令人兴奋的方向,如软硬件协同设计、用于科学AI的结构化稀疏性以及用于新AI工作流程和模态的长上下文。