作者:北邮 GAMMA Lab 硕士生 公绪蒙

论文名称: MA-GCL: Model Augmentation Tricks for Graph Contrastive Learning 发表会议: AAAI2023 论文地址: https://arxiv.org/pdf/2212.07035.pdf

1 简介

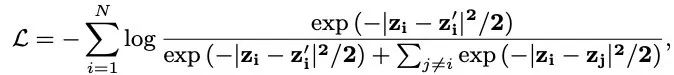

对比学习(Contrastive Learning)是一种无监督的表示学习方法,其通过数据增强和负采样获得正负样本,并使用目标函数增大正样本对之间的相似度,减小负样本对间的相似度,以获得具有判别性的表征。对比学习常用的损失函数InfoNCE如下: 对比学习最早在CV中取得了广泛应用,通过对目标样本(图像)进行数据增强(如,旋转,裁剪,加入噪声等)以获得样本的不同views,以该图像的不同views作为正样本,其依赖于一种先验知识,即数据增强不会影响图像的标签,举例来说,对于某个图像来说(比如一个狗狗的图片),无论对其进行旋转,裁剪,加入噪声等各种操作,该图像在人看来还是一只狗,而不会变成汽车,所以数据增强后的图像还可以作为原样本的正样本。然而,在Graph数据中,常见的数据增强方式(如:随机删除/添加边或节点)是否能保证该Graph的标签不变呢,举个简单的例子:化学中某些有机物分子可以由原子和化学键组成的Graph进行表示,而同分异构体之间具有相同的节点,不同的边,类似的结构,可以看做是对方进行删除/添加边得到的增强图,但同分异构体却通常有着不同的功能和性质(标签)。也就是说,在图对比学习(Graph Contrastive Learning)中,数据增强给原样本中带来的噪声很有可能改变图的标签,使得学到的图表征效果变差。在本篇工作中,我们认为,在GCL中传统的Graph Data Augmentation和固定的视图编码器架构不足以产生具有足够差异性的视图,所以我们提出了图模型增强的概念,图模型增强可以生成更加diverse的视图,并提出了三种不同的模型增强策略,分别是非对称,随机和洗牌策略,并基于这三种策略,提出了一种新的图对比学习模型MA-GCL(Model Augmentation Graph Contrastive Learning)。

2 方法介绍

2.1 预备知识

在本篇工作中,我们使用GNN作为view encoder,并且使用一种新的方式来形式化GNN,GNN可以由传播和转换两种算子组成,其中传播算子g是将图滤波器F和节点特征Z进行运算得到;而转换算子h则是将节点特征Z和参数矩阵W进行运算并通过非线性转换得到。以下公式则是利用h算子和g算子形式化了GCN和SGC两种常用的GNN encoders

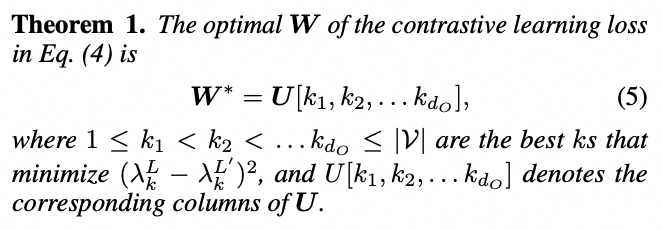

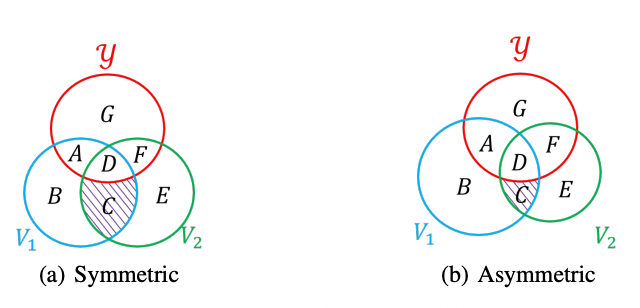

2.2 非对称策略

2.3 随机策略

在该策略中,我们在每个训练轮次中随机决定视图编码器中传播算子的数量,在图数据中,每一个样本通过一个有K个传播层数的GNN可以看做某个节点和他的K姐邻居组成的节点树,通过随机策略在每次训练过程中随机GNN的传播层数可以看做在每个轮次中随机选择不同高度的节点树作为样本,能够变相的丰富训练样本。

2.4 洗牌策略

洗牌策略则是在训练过程中,随机打乱传播算子和转换算子的排列。当采用的视图编码器中不含有非线性激活函数时,进行洗牌后的两个视图编码器不变,我们证明了洗牌是比传统的图数据增强更安全的增强方式。

2.5 MA-GCL

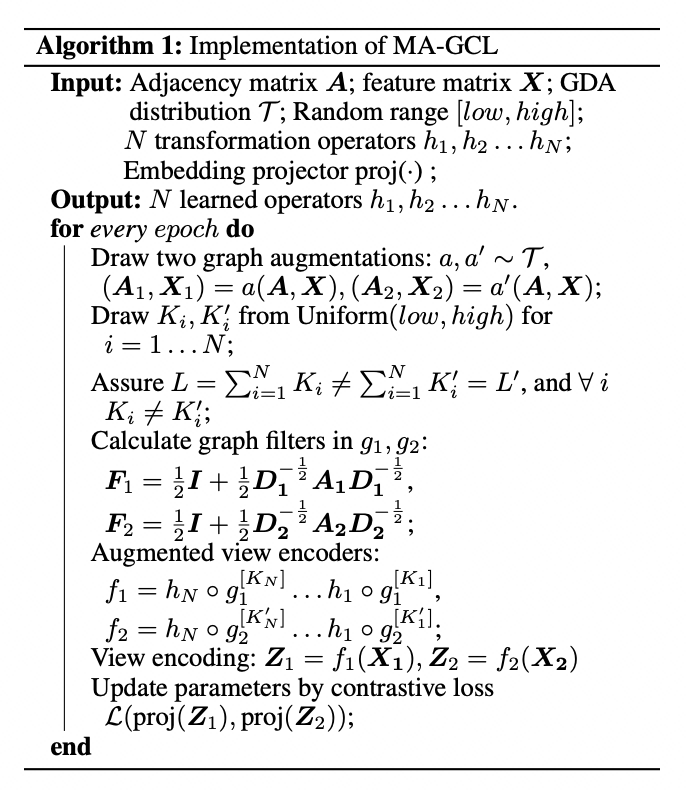

基于三种模型增强策略,我们提出了一种新的图对比学习模型MA-GCL,其伪代码如下:

3 实验

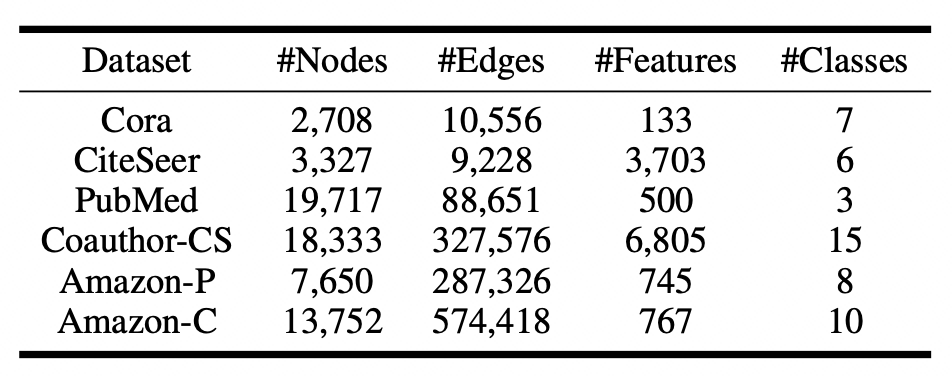

3.1 数据集

我们使用的数据集如表所示,在节点分类任务的六个数据集上进行试验:

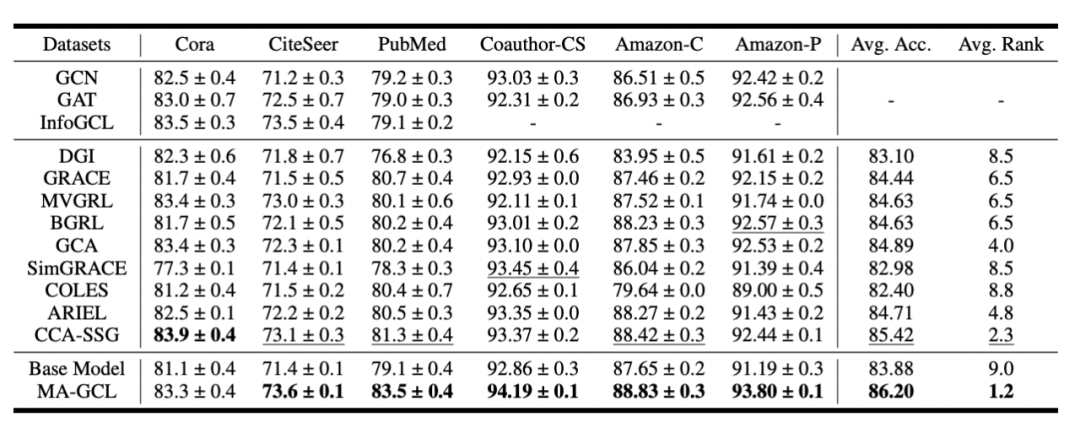

3.2 节点分类实验

MA-GCL在六个节点分类数据集上的五个都取得了SOTA的性能。

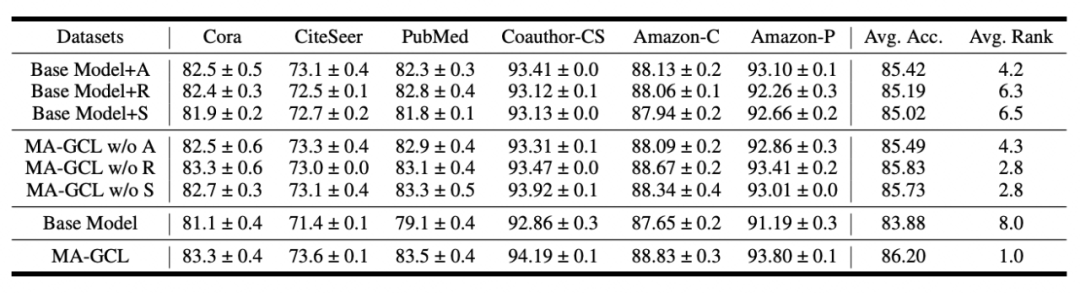

3.3 消融实验

由消融实验的结果可以看出,我们提出的三种模型增强策略都有效果,其中非对称策略提升效果最为明显。

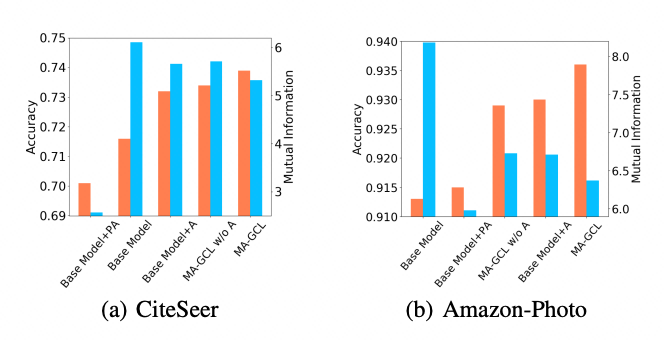

3.4 动机验证实验

本期责任编辑:杨成本期编辑:刘佳玮

北邮 GAMMA Lab 公众号

主编:石川责任编辑:王啸、杨成编辑:刘佳玮