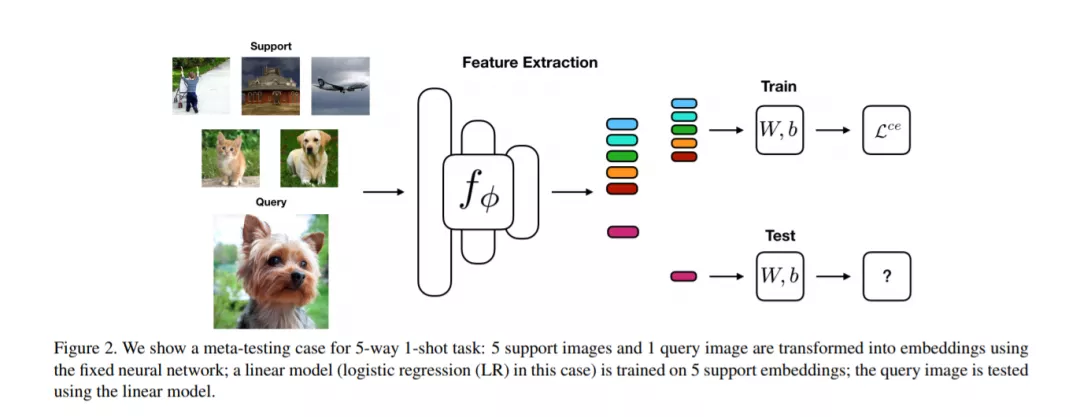

近年来元学习研究的重点是开发能够在有限的数据和较低的计算成本下快速适应测试时间任务的学习算法。小样本学习是元学习的标准基准之一。在这项工作中,我们证明了一个简单的基线:学习元训练集上的监督或自我监督表示,然后在这个表示上训练一个线性分类器,比目前最先进的小样本学习方法要好。通过使用自蒸馏可以获得额外的提升。这表明使用一个好的学习嵌入模型比复杂的元学习算法更有效。我们相信,我们的发现促使我们重新思考小样本图像分类基准和元学习算法的相关作用。

成为VIP会员查看完整内容

相关内容

专知会员服务

63+阅读 · 2019年12月12日

Arxiv

7+阅读 · 2019年2月8日