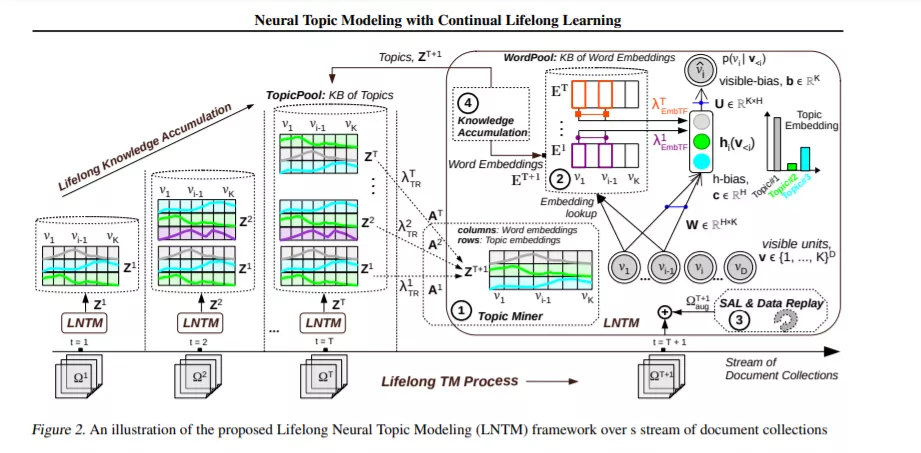

最近,终身学习在构建不断积累和转移知识以帮助未来学习的机器学习系统方面引起了关注。无监督主题建模广泛用于从文档集合中发现主题。然而,由于数据稀疏性,例如,在一个小的(短)文档集合中,会产生不连贯的主题和次优的文档表示,主题建模的应用具有挑战性。为了解决这个问题,我们提出了一个神经主题建模的终身学习框架,它可以连续处理文档集流,积累主题,并通过从多个来源的知识转移来指导未来的主题建模任务,以更好地处理稀疏的数据。在终身学习过程中,我们特别共同研究:(1)终生共享生成同源性(潜在话题)以转移先验知识,(2)通过新颖的选择性数据增强、联合训练和话题正则化方法最小化保留过去学习的灾难性遗忘。在给定一个文档集合流的情况下,我们应用所提出的终身神经主题建模(LNTM)框架,将三个稀疏文档集合建模为未来任务,并通过perplexity、Topic coherence和information retrieval task量化,证明了性能的提高。

成为VIP会员查看完整内容

相关内容

Arxiv

4+阅读 · 2020年2月13日

Arxiv

9+阅读 · 2018年1月27日