在医疗保健和军事等多个关键应用领域,人机协作决策工具正加速崛起。这类系统的用户往往很难理解人工智能的推理和输出,特别是当底层算法和逻辑被隐藏起来并作为黑箱处理时,商业敏感性和可解释性就会受到挑战。底层算法缺乏可解释性和不透明性,会使公正和偏见长期存在,降低用户的接受度和满意度。将可解释人工智能(XAI)整合到基于人工智能的决策工具中,已成为安全有效的人机协作环境的关键要求。

最近,可解释性对信任校准的影响已成为一个主要研究问题。可解释性指的是解释及其沟通方法如何帮助基于人工智能的工具形成正确的心智模型,从而让人类决策者更好地了解是信任还是不信任人工智能建议。虽然研究表明解释可以提高信任校准,但这些研究通常假定用户会通过认知解释来校准他们的信任。最近的研究表明,即使向人们传达了解释,信任校准也没有得到改善。XAI系统在提高信任校准方面的这种失败与认知偏差等因素有关,例如,人们会选择性地阅读和依赖什么。此外,其他研究表明,XAI未能提高校准信任度的原因是XAI方法的属性不一致,而这些属性在XAI接口设计中很少被考虑到。总体而言,XAI 系统的用户平均未能校准他们的信任度,与人工智能合作的人类决策者仍然可能明显地遵循错误的建议或拒绝正确的建议。

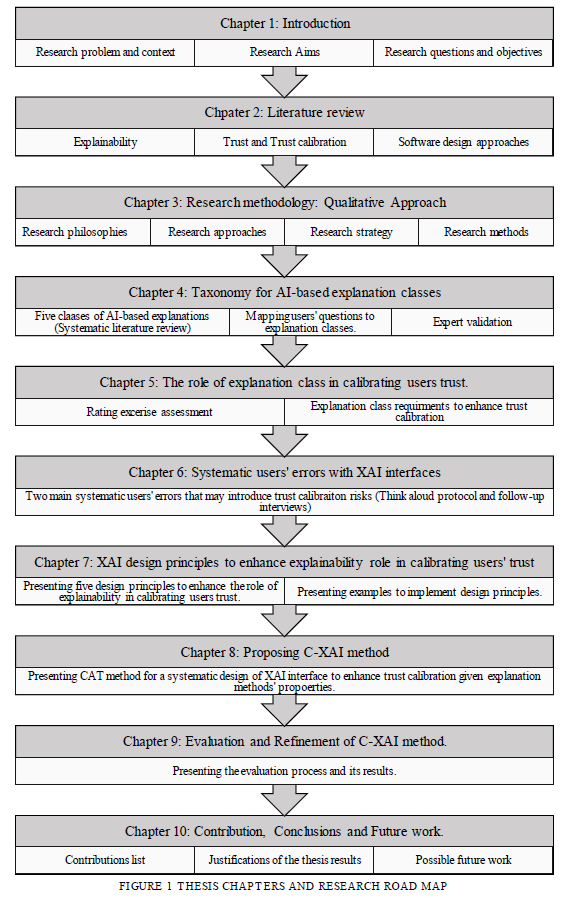

本文旨在提供 C-XAI,一种专门用于帮助 XAI 接口信任校准的设计方法。该方法可识别可能带来信任校准风险的 XAI 方法的属性,并帮助设计减轻这些风险。本论文将信任校准风险定义为接口设计中可能妨碍用户校准其信任能力的限制。本论文采用定性研究方法,与在工作环境中使用基于人工智能的决策工具的专家、从业人员和最终用户进行交流。数据收集方法包括文献综述、半结构化访谈、畅所欲言会议以及开发 C-XAI 的共同设计方法。这些数据收集方法有助于将信任校准和 XAI 的各个方面概念化,包括人机协作决策任务中的 XAI 要求、信任校准风险以及有助于信任校准的设计原则。这些研究成果被用于设计 C-XAI。随后,领域专家和最终用户对 C-XAI 进行了评估。评估旨在调查不同利益相关者之间的有效性、完整性、清晰度、参与度和沟通。评估结果表明,该方法有助于利益相关者理解设计问题并开发 XAI 设计,以帮助信任校准。

本文有四个主要贡献。首先,它将有关 XAI 接口设计的信任校准设计问题概念化。其次,它引出了支持信任校准的 XAI 接口设计的主要限制。第三,论文提出了支持 XAI 接口设计人员支持信任校准的关键设计原则。最后,论文提出并评估了 C-XAI 设计方法,以指导 XAI 接口设计,从而系统地实现信任校准。