今天给大家介绍的是来自百度的商业智能实验室团队和 麦吉尔大学 Can(Sam) Chen发表在arxiv的预印文章《Structure-aware Protein Self-supervised Learning》。这篇文章设计了针对蛋白质结构的预训练任务,并运用双层优化和互信息捕捉序列信息和结构信息的一致性,在下游任务上取得了当前最好的结果。

研究背景

蛋白质表征学习能提取蛋白质的有效特征,这些特征在许多下游生物学任务中显示出巨大的潜力。现有蛋白质表征学习的主要阻碍是有监督数据太少,而最近的一些研究已经证明了自监督学习有希望解决标签不足这个问题。然而,现有蛋白质自监督学习方法只作用在蛋白质序列层面,没有显式考虑蛋白质结构的信息。

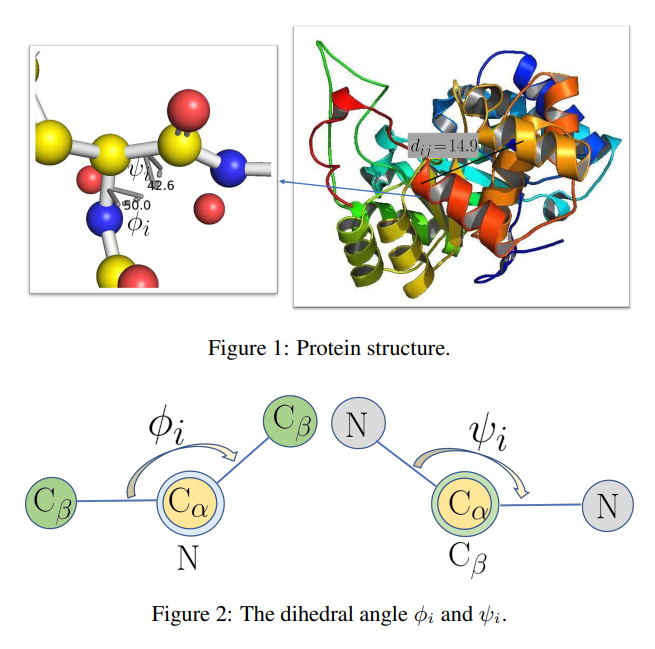

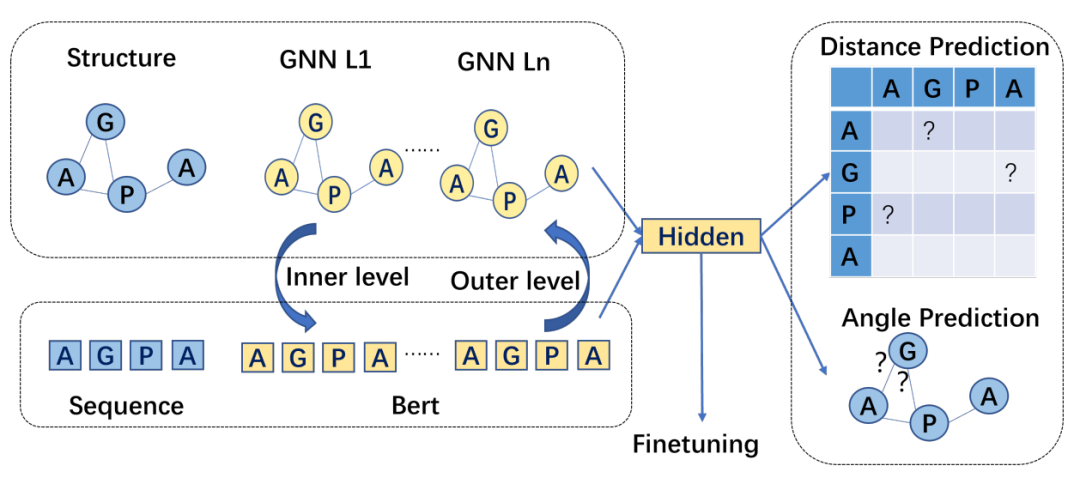

为此,作者提出了一种新的蛋白质自监督学习方法来有效地捕捉蛋白质的结构信息。具体来讲,基于残基间距离和二面角设计了两个自监督学习任务并使用图神经网络来捕捉这些信息。更进一步,作者利用预训练好的蛋白质语言模型增强蛋白质结构的自监督学习,并且提出一种伪双层优化方案去保证蛋白质序列信息和结构信息的一致性。下游任务的实验验证了作者提出的方法的有效性。

方法框架

如图所示,作者使用图神经网络和语言模型的隐层表示去预测残基-残基之间的距离以及二面角,并且提出一个伪双层优化策略捕捉蛋白质序列特征和结构特征的联系。

主要结果

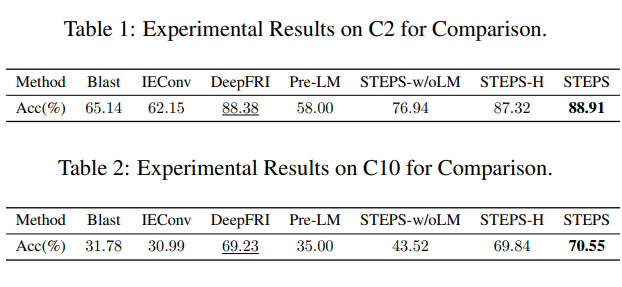

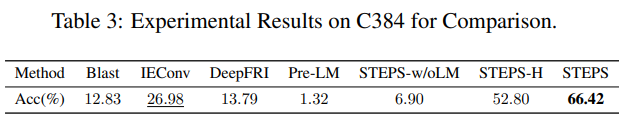

作者在膜蛋白分类任务(C2),细胞区室分类任务(C10),以及酶分类任务(C384)上验证了作者的方法STEPS的有效性。

总结

在这篇文章里, 作者提出基于蛋白质结构的预训练。基于图神经网络的两个自监督任务很好地捕捉蛋白质的结构信息,同时,伪双层优化保证了蛋白质序列信息和结构信息的一致性。下游任务C2, C10和C384的结果验证了方法的有效性。 参考资料 https://arxiv.org/abs/2204.04213 @article{chen2022structure, title={Structure-aware protein self-supervised learning}, author={Chen, Can and Zhou, Jingbo and Wang, Fan and Liu, Xue and Dou, Dejing}, journal={arXiv preprint arXiv:2204.04213}, year={2022} }