题目: Adversarial Training for Large Neural Language Models

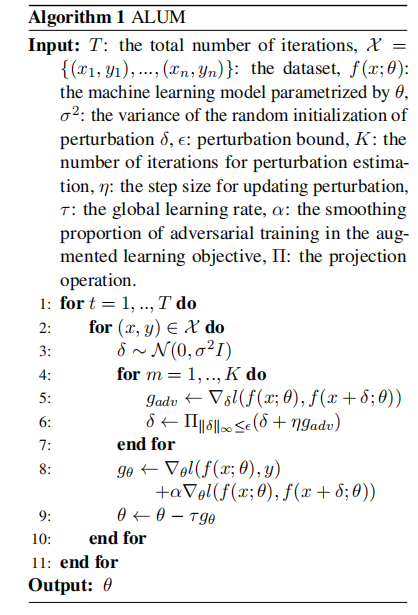

简介: 泛化性和鲁棒性都是设计机器学习方法的关键要求。对抗性训练可以增强鲁棒性,但是过去的工作常常发现它不利于推广。在自然语言处理(NLP)中,预训练大型神经语言模型(例如BERT)在针对各种任务的通用化方面显示出令人印象深刻的收益,而从对抗性微调中得到了进一步的改进。但是,这些模型仍然容易受到对抗性攻击。在本文中,我们表明对抗性预训练可以同时提高泛化性和鲁棒性。我们提出了一种通用算法ALUM(大型神经语言模型的专家训练),该算法通过在嵌入空间中应用扰动来最大化训练目标,从而使对抗性损失最大化。我们将对所有阶段的对抗训练进行全面的研究,包括从头开始进行预训练,在训练有素的模型上进行连续的预训练以及针对特定任务的微调。在常规和对抗性方案中,在各种NLP任务上,ALUM都比BERT获得了可观的收益。即使对于已经在超大型文本语料库上进行过良好训练的模型(例如RoBERTa),ALUM仍可以通过连续的预训练获得可观的收益,而传统的非对抗方法则不能。可以将ALUM与特定于任务的微调进一步结合以获取更多收益。

相关内容

微軟研究院(Microsoft Research,英文縮寫:MSR)是微軟在1991年創立硏究不同的電腦科學主題與問題的分部。微軟研究院其中一個固定的目標為「支持長期的電腦科學硏究而不受產品週期所限」。

微軟研究院是目前世界頂尖的研究中心之一,有很多在電腦科學、物理學、數學受到高度公認的專家及許多著名科學獎項得主在微軟研究院,包括圖靈獎得主東尼·霍爾、詹姆斯·尼古拉·格雷,菲爾茲獎得主Michael Freedman,沃爾夫獎得主Laszlo Lovasz,MacArthur Fellow獎金得主Jim Blinn與Dijkstra Prize獎得主Leslie Lamport。

微軟研究院於班加羅爾、北京、劍橋、矽谷、雷德蒙德與舊金山擁有實驗室。